OpenAI发布新安全框架,董事会有权否决CEO发布新模型

还记得 Sam Altman 回归 OpenAI 时提到的“三个当务之急”吗?首先就是险些将他踢出公司的安全问题。现在,OpenAI 正力图系统化公司内部的安全思维。

“我们的准备团队正在开展开创性工作,将安全发展成为一门定量科学。” OpenAI 总裁 Greg Brockman 在社交平台上表示。

本周一,公司在其网站上公布的一项计划,制定了一个框架来解决其最先进模型的安全性问题。公司表示,只有在网络安全和核威胁等特定领域被认为安全的情况下才会部署其最新技术。另外,他们还成立了一个咨询小组,负责审查安全报告,并将其发送给公司的高管和董事会。虽然高管会有权决策,但董事会可以推翻这些决定。

自一年前 ChatGPT 推出以来,AI 的潜在危险一直是 AI 研究人员和公众的头等大事。生成式 AI 让用户眼花缭乱的同时,也因其传播虚假信息等问题而引发安全担忧。今年 4 月,一群行业领袖和专家签署了一封公开信,呼吁暂停开发比 OpenAI 的 GPT-4 更强大的系统六个月,理由是对社会的潜在风险。路透社/益普索(Ipsos) 5 月的一项民意调查发现,超过三分之二的美国人担心 AI 可能产生的负面影响,61% 的人认为它可能威胁到文明。

5 月,包括 CEO Sam Altman、首席科学家 Ilya Sutskever 和 CTO Mira Murati 在内的 OpenAI 领导层与其他 AI 专家签署了一封信,优先考虑解决先进 AI 模型的风险。

7 月,OpenAI 成立 Superalignment 团队,为 “超级智能”模型提供理论指南。

9 月,OpenAI 宣布推出红队网络(Red Teaming Network),并邀请各领域专家加入,以提高其模型的安全性。一个月前,OpenAI 对外称计划成立一个叫 Prepareness 的团队,监督前沿技术的灾难性风险。该团队将由 MIT 可部署机器学习中心主任 Aleksander Madry 领导。

本周一,OpenAI 正式宣布 Preparedness 成立,并介绍了 Prepareness 团队的工作流程——第一代“准备框架”,旨在“为识别、分析和如何处理正在开发的模型固有的‘灾难性’风险提供一条清晰的路径。”

所谓“灾难性”风险,“是指任何可能导致数千亿美元经济损失或导致许多人严重伤害或死亡的风险——这包括但不限于生存风险。”根据框架设计,针对开发中的前沿模型,将由“准备(Prepareness)”团队负责模型发布之前识别和量化风险。准备团队也将与现有的安全系统团队、超级对齐团队以及其他安全政策团队密切合作。

其中,安全系统团队负责现有模型的安全问题。比如,针对 ChatGPT 的系统性滥用,可以通过 API 限制或调整来缓解。

“超级对齐”团队正在研究“超级智能”模型的理论指南。

在此之前,这三个部门的职能都统一交给信任和安全部门。不过,后者的主管 Dave Willner 已经于今年 7 月辞职。

针对既有的、更前沿的和未来的超级智能模型,分别有三个团队负责其安全风险的识别和报告。具体的评估方法将采用记分卡制度。准备团队会评估并不断更新模型的“记分卡”,出具详细报告。

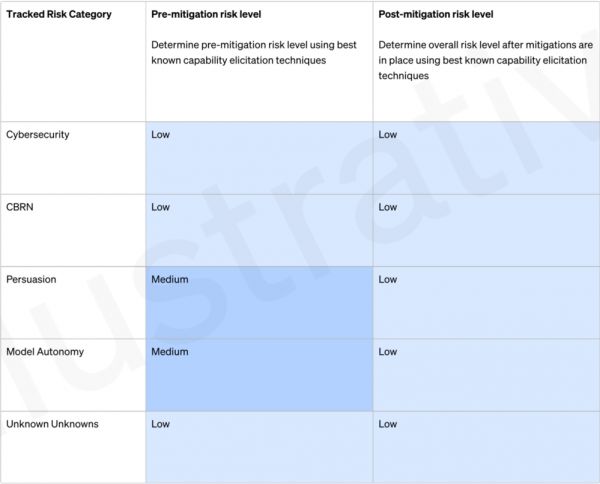

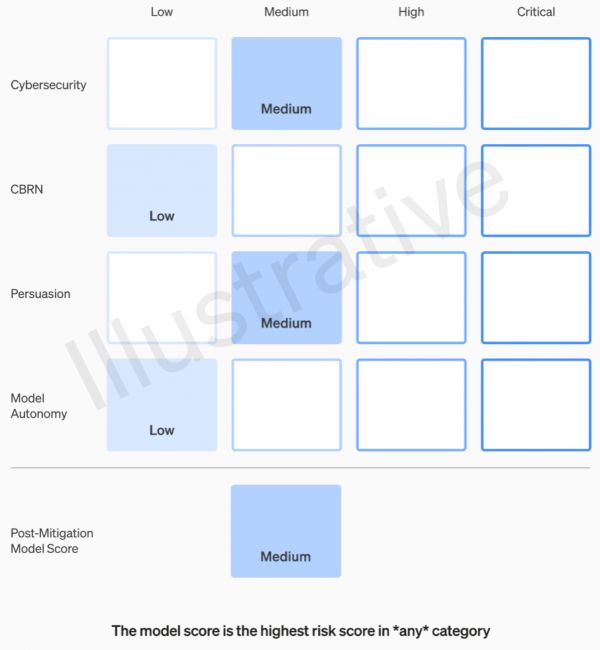

我们可以看到记分卡上,抽象的“灾难性风险”被进一步量化为四个类别的风险:网络安全、说服力(例如,虚假信息)、模型自主性和 CBRN(化学、生物、放射性和核威胁,比如,创造新的病原体)。针对每一类风险,记分卡设定了四个风险级别(低、中、高和关键),并记录采取应对措施前后的风险得分。

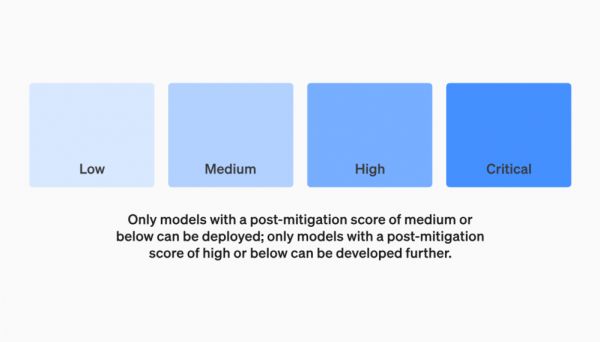

采取应对措施后(post-mitigation)得分为“中”或更低的模型才有资格部署。例如,会对制造毒品或炸弹的过程保持沉默。采取应对措施后,如果模型仍被评估为“高”风险,将不能得到部署,但还能进一步研发。

如果模型存在任何严重(“关键”)风险,公司不会进一步开发该模型。采取应对措施前,风险为严重(“关键”)的模型,会被量身定制额外的安全措施。为了探求极限情况下的风险边界,评估所有前沿模型时会包括在训练运行期间每增加 2 倍的有效计算量。

采取应对措施后得分为前两者的模型,才有部署的资格。在日常运营方面,准备小组负责技术工作,包括检查前沿模型能力的局限性、评估并撰写报告。

考虑到制作这些模型的人不一定是评估模型和提出建议的最佳人选,OpenAI 正在组建一个“跨职能的安全咨询小组( SAG ,设有主席一职)”。该小组将从技术层面审查研究人员的报告,并从更高的角度提出建议(比如,建议减轻风险的应对方法)。OpenAI 希望这一设置有助于发现一些“未知的未知”(尽管从本质上来说,这些是相当难以捕捉的)。

SAG 成员(包括负责人)将由 OpenAI 领导层任命。根据 Altman 回归公司时发布的公开信,“我会和 Mira 一起做这件事(指安全问题)。”我们推测这里的领导层应该是指 CEO Sam Altman 和 CTO Mira Murati 。同时,该安全咨询小组也会将这些(审查和建议)发送给领导层和董事会。虽然领导层是决策者,但董事会拥有推翻决策的权利。

不过,外界也不是没有疑问。

假如 OpenAI 真开发了一个模型且具有“关键”风险,过去那个非盈利组织 OpenAI 并不羞于对此类事情大肆宣扬——谈论他们的模型有多么强大,以至于他们拒绝发布它们,但今非昔比。姑且不论由管理层任命的安全咨询成员,在关键时刻有多大概率站在所谓的对立面,如果真有专家小组提出建议(就像之前直言不讳,然后被罢免的独立董事那样),而 CEO 依然决定部署模型,新的董事果真敢推翻领导层的决定、踩下刹车吗?

就算他们这样做了,外界会听到真实的声音吗?除非 OpenAI 征求独立第三方审计,否则外界很难认为 OpenAI 真正解决了透明度和安全问题。

参考链接:

https://cdn.openai.com/openai-preparedness-framework-beta.pdf

https://openai.com/safety/preparedness

本文来自微信公众号:机器之能(ID:almosthuman2017),作者:吴昕

相关推荐

OpenAI忙着“宫斗”时,竞争对手发布新款大模型

OpenAI“宫斗”后续:董事会骑虎难下,对手疯狂挖角

突发,OpenAI CEO被开除、退出董事会

OpenAI“宫斗”悬念:保守派留任新董事会,微软和奥特曼还没入席

消息称阿尔特曼回归 OpenAI 失败,董事会已任命新的临时 CEO

Altman大胜收局:重返OpenAI任CEO,董事会重组

OpenAI政变大戏还有悬念:保守派留任新董事会,微软和奥特曼还没入席

OpenAI六人董事会将就“何时实现AGI”展开讨论

奥特曼重掌OpenAI出任CEO:高管重排座次,微软进董事会

Gemini发布仅一天就遭质疑,谷歌追赶OpenAI太过心急?

网址: OpenAI发布新安全框架,董事会有权否决CEO发布新模型 http://www.xishuta.com/newsview102078.html

推荐科技快讯

- 1问界商标转让释放信号:赛力斯 95228

- 2人类唯一的出路:变成人工智能 21183

- 3报告:抖音海外版下载量突破1 21148

- 4移动办公如何高效?谷歌研究了 20339

- 5人类唯一的出路: 变成人工智 20338

- 62023年起,银行存取款迎来 10336

- 7五一来了,大数据杀熟又想来, 8596

- 8网传比亚迪一员工泄露华为机密 8505

- 9滴滴出行被投诉价格操纵,网约 8215

- 10顶风作案?金山WPS被指套娃 7230