国产手机大模型第一战:购买基座,拼硬件和生态

智能助理这一概念,从诞生之初就与人类对 AI 的想象密不可分,Siri 最初是作为一个独立的助手应用于 2010 年 2 月发布。后来,苹果公司于2011年4月收购了Siri,并将其集成到 iPhone 4S 中。

从那时起,Siri 成为了苹果设备的一个标准功能。语音助理也逐渐成为了智能手机的标配。

随着大模型成为时代主流,人类再次看到让手机聪慧如人的一缕曙光。2023年下半年开始,小米、OPPO、vivo等手机厂商纷纷宣布入场,组建团队,并在新系统中增加大模型能力:在连续数年的市场总量萎缩后,手机厂商寄希望于 AI 大模型,能成为未来五年乃至更久持续吸引用户更换手机的增长点。

出现在手机上的大模型,也确实成为了 2023 手机行业最炙手可热的话题:到了 2024 年一月,中国手机市场 Top5 之中,除了苹果之外,已经全数发布了自有端侧大模型产品。

从无人问津到赛道中挤满人,只用了半年的时间。伴随着手机厂商在发布会中演示的包括通话记录自动生成、AI 图像处理等常见应用场景的整合,如今已经没有人会怀疑大模型在手机上应用的前景。

但我们距离聪慧如人的端侧大模型手机,到底还有多远?

大模型真假自研之惑

团队创始规模往往能说明很多问题:小米组建了超过 3000 人的 AI 团队,vivo 也已经拥有上千人的团队在从事生成式 AI 领域的产品研发。

虽然建立了规模庞大的研发团队,但围绕 AI 大模型产品自研的争议却不曾消失:在发布端侧大模型产品时,手机厂商均会花费大量篇幅,去介绍其在 AI 领域长期以来的投入,但这实际上是在混淆语音助理背后大模型的本质。

大模型实际供应方毫无疑问是手机厂商的秘密,但从手机厂商在生成式 AI 领域的投资步伐中,还是能看出一些端倪。

据相关厂商的知情人士向记者透露:vivo 目前的大模型是在智谱 AI 的基座大模型的基础上改进而来,小米本身也是智谱 AI 的股东,在 2023 年 10 月参与了智谱 AI 的投资;在今年四月,阿里云峰会上,阿里云官方发布的“企业专属大模型”合作名单里,OPPO 位列第一。

这位行业人士同时还向记者透露:手机厂商在购买基座模型的投资均耗资数千万,以语音助理面貌呈现给普通用户的大模型产品最终能够适应硬件的结构,给出及格线以上的大模型体验。

对于这些厂商来讲,目前自研大模型暂时无法满足用户对大模型能力的需求,因此主要的选择是从市面上购买现成的预训练模型,在此基础上进行调整。加上发布时的营销手段,买来的预训练模型在不经意间变成了“自研”。

此外,由于现行《生成式大模型管理服务暂行办法》带来的监管白名单制的存在,手机厂商想要赶上这一波热潮,购买现有基座大模型并在其基础上进行微调而来的“自研”,对当下来讲是短平快的方案,也是“抢首发”时为数不多的选择。

但这种先发优势注定会让手机厂商陷入马拉松式的端侧大模型竞争中,能否后续得到保留,也未可知。

硬件天花板在哪?

目前在手机厂商公布的多模态大模型方案中,端侧大模型都属于多种体积中最低的一档,参数数量往往只有最顶级的百分之一。实际运行效果自然不可同日而语。

但端侧大模型的存在价值毋庸置疑,它是为了解决云端大模型诞生以来就有的种种问题,用户每次对云端服务器的请求都会产生一定的成本,同时也是解决用户数据隐私问题的根本办法。

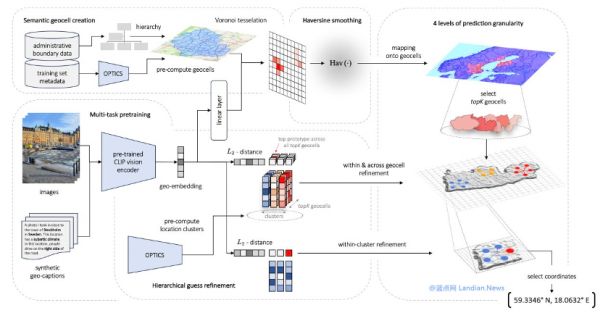

大模型技术的突飞猛进不仅便利了我们的生活,也让隐私暴露的风险空前巨大:斯坦福大学的一组研究人员近期发布了一个利用 10 万个随机位置以及 50 万张街景图片训练出的大模型,能够从照片信息中快速识别出拍摄者当前所处的位置,准确率达到了 92%。

当前不同手机厂商的策略略有不同,但端侧大模型是任何厂商都无法避开的必选项:完全在端侧运行的大模型在未来会变得更加重要。

解决了技术路线问题,剩下的主要问题就变成了硬件:70 亿参数级别是当前一个“甜点级”的关键节点,70 亿参数大模型正常的模型大小在 28GB 左右,为了真正在端侧部署,必须对模型进行压缩和轻量化,如今已经能将其压缩至 3.9GB 左右,无论是存储还是内存占用都是这个量级。

但在精简模型体积、增加运行效能的道路上还有很大的提升空间;目前开发者甚至能在 2004 年发布的诺基亚 9500 的硬件上,运行一个 70 亿参数大小的本地大模型。

A Weekend AI Project: Running a 7B Large Language Model on a Nokia 9500 from 2004

这一方面反映出端侧大模型在过去一年,正在以惊人的速度发展迭代的事实,另一方面为 AI 专用设计的硬件,能够在当前水平下极大提高 AI 大模型的运行速度上限。如今搭载 TPU 的 Google Tensor 系列处理器,已经在离线环境下实现每秒 20 个 token 的处理速度,相比之下桌面端的 MacBook Air M2 仅为每秒 5 token。

移动端获得反超桌面端的 token 处理速度,这得益于硬件在设计之初便考虑到深度学习。如 Google 与三星联合定制的 Tensor 系列 SoC,内部已经集成了用于人工智能加速器专用集成电路(ASIC),让其拥有了其他厂商巨大的优势:这种优势不仅会体现在 2023 年的端侧大模型首发浪潮,更会在后续的竞争中体现得更加明显。

高通也通过多年的布局,在硬件上形成了类似的生态,最新发布的高通骁龙 8 Gen 3 SoC 芯片已经支持在端侧离线运行 100 亿参数(10B)级别的大模型,并已经展示了在手机端侧运行 LLaMA2 的能力。

端侧大模型的天花板目前主要体现在手机运行内存的压力上,这是当前阶段手机厂商普遍只选择旗舰手机测试端侧大模型的直接原因。因此除了硬件的专用设计,对模型本身的效能优化也依赖于对模型的迭代,这需要云计算业务提供的海量算力支撑。

端侧大模型强调的“利用手机闲置算力、保障用户数据安全”的前景看似诱人,但现阶段却并不能够支撑起足够用户体验的解决方案,其定位更多是现阶段云端大模型的补充,会随着端侧大模型能力的增长,很快见到新的变化。

无论是华为、谷歌,还是尚未入局的苹果,在过去的芯片设计中都已经有针对 AI 的专用算力进行适配,尤其是此前已经存在数年的 NPU,直接决定着端侧 AI 的聪慧程度,谷歌、华为都有针对自研芯片中的 AI 算力进行大量的能效优化,这直接考验着手机厂商对硬件的掌控能力。

生态挑战

以现有的语音助理形态为基础,将端侧/云端大模型的交互入口整合其中,是目前门槛最低、相对实现效果最好的手机 AI 大模型交互方式。

低门槛同时也意味着更多强有力竞争对手的涌入:几乎没有手机厂商愿意放弃接管手机智能助理的可能性。据 Android Authority 报道,ChatGPT 在近期更新中已经加入了能在桌面,让用户可以在系统中将 ChatGPT 设置为手机的默认语音助理,直接调用 ChatGPT(GPT-4)的语音交互能力。

但手机硬件厂商也有自己的优势:用大模型能力,让手机现有硬件的第一方能力再进一步,几乎是目前所有玩家的共同选择。

去年 11 月,Google 在首次对外公开 Gemini 时,为了更好地展示其在端侧的应用场景,在 Android 14 自带的录音机 App 以及 Gboard 英文输入法中都进行了整合,让录音语音转文字速度更快,同时提高准确率。

国产手机厂商目前的发布中,端侧模型应用也已经能在诸如本地图像识别、处理,以及通话记录等领域展现出惊人的能力,因为这些概念对于手机厂商而言并不陌生,在 AI 模型概念广为人知之前,手机端侧已经有诸多 AI 以及深度学习技术的应用场景:从手机计算摄影到后台内存调度,小到桌面交互动画,都有 AI 技术的影子。

但更具有想象力的应用场景仍是第三方应用生态:智能语音助手本身就有打通应用层级、帮助直接触及某一具体功能的“捷径”作用,例如打通日历、支付以及订票 App,帮用户一键订高铁/飞机票。但这样梦幻的场景对于端侧大模型来说似乎触手可及,实现起来也还有更多阻碍。

长期以来,手机厂商对用户并不会用语言助手的事实心知肚明:在 OPPO 发布安第斯 GPT 之后,表示“不做大模型的手机企业就没戏了”的 OPPO 首席产品官刘作虎,曾几何时也在接受媒体采访时表示“并没有多少用户真的在用智能助理”。

语音助手长期“低能”的现实,让即使常年投资 AI 领域的智能手机厂商也有意无意地忽视了构建生态的重要性。对于开发生态的投入,远远落后于硬件以及生成式 AI 行业的发展脚步。即使 2023 年小米、华为、vivo、OPPO 先后都面向开发者发布了适配端侧大模型的开发规范,但如何快速整合更多应用服务加入自有生态中,仍然缺乏行之有效的解决方案。

类似妙鸭相机这样独立生成式 AI 应用的爆火,也在鼓励着更多第三方应用甚至独立开发者加入这场手机大模型竞争,但这更多是“各自为战”,没有足够的利益驱动,手机厂商很难将这些第三方 App 高效地整合进自有大模型产品中。

“实际上,正是因为大模型有着真正颠覆体验的潜力,才让原本存在多年、根深蒂固的问题暴露了出来。”某手机大模型产品经理对记者表示。

想要解决这个问题,手机操作系统中如同“超级胶水”一般的通用接口,将会是未来大模型生态中如同“基础设施”一般的存在:随着 Gemini 的发布,Google 也在 Android 14 中一道整合了 API ,供开发者自由适配自己的 App,来调用本地的 Gemini 能力。未来也会有更加通用,适合所有端侧大模型的 API 开发接口问世。

但这样的更新严重依赖 Google,在这一点上会受制于 Android 官方的更新步伐。“业内缺少统一的开发接口,会成为未来一段时间内的必然事件,因此有硬件与生态的厂商,后发优势会更加明显。”大模型产品经理这样看待未来端侧大模型生态的状态。

归根结底,大模型概念在手机中最终落地,与应用生态的深度整合几乎是避无可避的问题。生成式 AI 能在多大程度上真正接管手机的日常使用同样有赖于此,这将是位处生态链下游的手机厂商与开发者更能展开竞争与合作的新战场。

现在判断谁是赢家为时尚早,但手机毫无疑问是当下最适合大模型生长的终端设备之一。大家期待的端侧大模型带来下一个“iPhone 时刻”,最终更有可能在已经拥有完整大模型开发能力、芯片设计、制造能力以及生态号召力的厂商中诞生。

手机厂商在端侧大模型的第一回合已经结束,手机端侧大模型走向台前,但真正的主导者尚未出现。只有当 AI 大模型真正成为智能手机“质变”的时刻出现,用户自然乐于为更好的体验买单。

本文来自微信公众号:电厂 (ID:wonder-capsule),作者:张勇毅,编辑:高宇雷

相关推荐

大模型不是巨头的宠物

阿里进入大模型时代,核心是算力和生态

大模型硬件时代,360智慧生活立于舞台中央

一朵云长出了70%的大模型?

大模型套壳祛魅

大模型不是手机厂商的杀手锏

为什么说国产手机的高端化“吃软不吃硬”?

亮相世界人工智能大会 “大模型”有哪些大本领?

阿尔法蛋的“大模型”初心:驾驭AI要从娃娃抓起

对话Arm高级副总裁:AI大模型带来“计算”新挑战,架构灵活性、生态

网址: 国产手机大模型第一战:购买基座,拼硬件和生态 http://www.xishuta.com/newsview104685.html

推荐科技快讯

- 1问界商标转让释放信号:赛力斯 95067

- 2人类唯一的出路:变成人工智能 20174

- 3报告:抖音海外版下载量突破1 19974

- 4移动办公如何高效?谷歌研究了 19396

- 5人类唯一的出路: 变成人工智 19282

- 62023年起,银行存取款迎来 10229

- 7网传比亚迪一员工泄露华为机密 8346

- 8五一来了,大数据杀熟又想来, 7727

- 9滴滴出行被投诉价格操纵,网约 7350

- 10顶风作案?金山WPS被指套娃 7158