人大系初创与OpenAI三次“撞车”:类Sora架构一年前已发论文

Sora一出,诸多创业公司的命运因之改变。

我们最近听说了个超级戏剧性的故事,就在中国,就在中关村的一家创业公司:

Sora出世前,他们拿着一篇如今被ICLR 2024接收的论文,十分费劲地为投资人、求知者讲了大半年,却处处碰壁。

春节后,打电话来约见团队的投资人排起了长队,都是要学习Sora、学习团队论文成果。

为什么?

答案很简单,Sora本来就是新晋顶流,再一次亲身证明了scaling law的正确可行。

更何况Sora背后的架构,与这支团队近一年前发表的论文所提出的基于Transformer的Video统一生成框架,大撞车。

撞车到什么程度呢?用团队自身的话来说,“可以说是几乎一模一样,嗯,就还得仔细地找到底哪里不同”。

敢这么说话,有点意思。

要知道,国内诸多团队都在通往AGI的道路上苦苦耕耘,但很多人至今还是很不看好国内团队的技术创新能力。如果事实真像团队所说,那这就是国内队伍有实力做最前沿创新的实际证明。

于是,量子位得知后,火速联系上这个团队,带着大家第一时间把撞车瓜彻底吃透。

(浅浅剧透一下,后来我们发现跟Sora撞车这个瓜背后,还有更戏剧的故事)

谁在和OpenAI“撞车”?

不卖关子,和OpenAI“撞车”的这家初创公司,正是成立于2021年的智子引擎。

而在它的身上,有太多的属性和标签值得说道说道。

90后CEO:由中国人民大学高瓴人工智能学院博士生高一钊创立。

人大系:核心团队成员多数来自人大,并且由高瓴人工智能学院卢志武教授担任顾问一职。

多模态大模型:公司成立之际大语言模型依旧是主流,他们却早早打入多模态这条“无人区”的赛道。

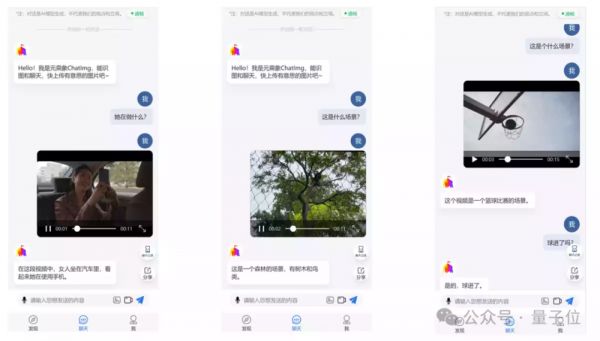

从目前智子引擎所交出的“作业”来看,最为瞩目的当属于2023年3月发布的世界首个公开评测多模态对话应用ChatImg(元乘象),并且已经迭代到了3.5版本。

例如给ChatImg随机投喂一张图片,它可以立即用看图说话,用文字精准描述图片中的内容。

而且在问及观点性问题时,例如“是否合理”,ChatImg的回答也是近乎接近人类的理解。

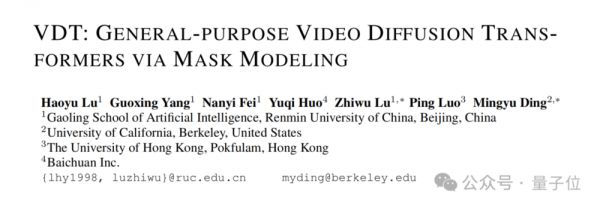

至于刚才提到与Sora“撞车”的论文,正是由这家“人大系”初创领衔,并联合伯克利、港大等单位于2023年5月发表在arXiv上的VDT。

在我们与卢志武教授交流过程中,他这样形容看到Sora技术报告后的感受:

像,实在是太像了。

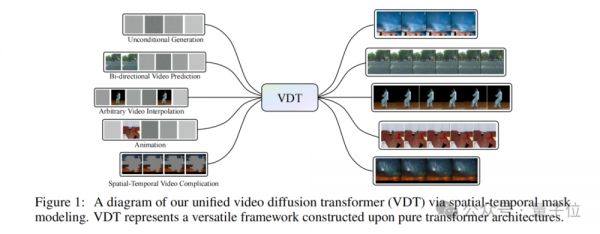

因为Sora在技术架构上所采用的是Diffusion Transformer,这是区别于以往文生视频(基于Stable Diffusion等)工作的关键点之一。

而仅从VDT论文的标题中,我们就不难发现,智子引擎在技术架构上早已提出并采用了Diffusion Transformer,而且是首发的那种。

但单从Diffusion Transformer还不足以说明“大撞车”,我们还需看一下VDT论文里的个中细节。

首先,在时空注意力机制方面,VDT在Transformer中集成了专门设计的时间注意力和空间注意力模块,这样就可以让模型能够更好地捕捉和理解视频数据中的时空关系。

举个例子,假设你在看一部电影,导演通过镜头的切换和场景的布局来引导你关注故事的关键部分。时空注意力机制就像这样的导演,它让VDT能够捕捉视频中的关键时刻和动作,使得生成的视频更加生动和连贯。

其次,是模块化设计,VDT的Transformer块是模块化的,这意味着它可以根据不同的视频生成任务灵活调整,而不需要对整个模型架构进行大规模修改。

模块化设计就好比像乐高积木一样,可以用不同的积木块来构建各种形状和结构,通过组合不同的模块来适应不同的视频生成任务,比如制作动画或者预测未来的视频帧等等。

最后,则是VDT提出的一种统一的时空掩模建模机制,可以允许模型在不同的视频生成任务中使用相同的架构,通过调整掩模来适应不同的输入和输出需求。

它宛如一个多功能工具箱,里面的工具可以用来做各种不同的修理工作,不需要额外为每种工作单独购买工具;因此,VDT能够在多种视频生成任务中发挥作用,而不需要每次都重新训练。

然后我们再对比Sora技术报告和VDT论文,就不难发现二者的大体思路是非常相似的。

例如Sora基于Transformer的特性使得它天然具有处理时空数据的能力,因为它可以捕捉视频中的长期依赖关系。

Sora使用了一个视频压缩网络来降低视觉数据的维度,这可以看作是一种模块化设计,因为它将视频处理分解为压缩和解码两个独立的步骤。

以及Sora能够处理不同时长、分辨率和宽高比的视频和图像,这表明它也有一个类似“多功能工具箱”一样的统一表示方法来处理各种类型的输入数据。

至于区别之处,可能仅是一些实现方法上的细节。

例如在时空维度的处理上,VDT是分别进行注意力机制,而Sora则是将时间和空间统一,进行单一的处理;再如Sora还考虑到了将文本条件融合等等。

既然技术上如此高度相似,很多人或许也会好奇,为什么Sora能做出来长达1分钟的高质量视频,而VDT却没能做出效果呢?

对此,卢志武教授也做出了解释:

我们当时的探索是理论方向上的,虽然没有做过生成60秒这么长时间的视频,但是我们做过一个物理实验,发现VDT是可以支持3D生成的,这也意味着VDT的方法在学习物理规律上具备较强的能力,这一点与OpenAI的思路不谋而合。

除此之外,卢志武教授也坦然地承认,要是想要做到Sora的效果,还需要非常庞大的算力支撑,这一点对于高校实验室来说着实是有些困难。

总而言之,无论是从发布时间还是技术架构来看,VDT在技术路线上确实是与OpenAI的Sora发生了一次“撞车”事件。

不过有趣的一点是,在我们与智子引擎交流过程中还发现了更加戏剧性的事情:

这不是第一次与OpenAI“撞车”,前后竟然足足发生过三次!

一直与OpenAI同路,此前已经两次“撞车”

先简单概括,智子引擎和OpenAI三次撞车,第一次是与Clip,第二次是与GPT-4V,第三次就是与刚刚发布的Sora。

乍一听,可能会觉得有点想笑,怎么智子引擎像是大模型届的汪峰(汪峰老师对不起),每次都被OpenAI抢过风头?

但你仔细想想,这可能是一种侧面说明:

这支国内团队长久地和OpenAI一路同行,在不知哪条路是通往AGI的情况下,甚至某些OpenAI都没有打样的时刻,居然每一步都走对了。

下面详细说说同样令人慨叹万千的“撞车”事件:

第一次与OpenAI发生“撞车”的故事,还需要追溯到2020年。

当时智子引擎并没有成立公司,彼时国内外在大模型技术上也还是聚焦于文本,例如OpenAI的GPT-3,以及国内北京智源人工智能研究院悟道项目等等。

但卢志武教授和高瓴人工智能学院的团队(即核心团队前身)便已经着手准备自研多模态大模型;方式是参与到由高瓴人工智能学院院长文继荣带队的悟道·文澜中。

到了2020年12月,这支小分队便已经完成了文澜的训练工作并发布了1.0的版本,是国内第一个大规模预训练的多模态模型,并首次运用多模态弱相关概念完成训练。

而时隔仅一个月,OpenAI便在多模态大模型领域出手了——2021年1月发布CLIP。由此,文澜和CLIP一道,成为了多模态领域的开山之作。

值得一提的是,在同年的6月份,文澜还进行了一次迭代,发布2.0版本,参数量为50亿,训练数据量达6.5亿。

并且相关论文还在2022年被Nature Communications接收,成为世界首个被Nature子刊接收的多模态领域论文。

不难看出,智子引擎前身团队早在数年前便已经和OpenAI在多模态大模型的研究和进展上保持了近乎相同甚至超前的节奏。

这便是智子引擎与OpenAI的第一次“撞车”。

自身已经有所研究和理解,加之OpenAI也在跟进,因此,这支队伍认为多模态大模型是值得继续做下去的方向。

于是正如我们刚才提到的,智子引擎在2021年正式成立,公司的“标签”也是非常明确,就是多模态大模型。

而这也为智子引擎与OpenAI的第二次“撞车”埋下了伏笔。

2023年3月8日,在潜心“苦修”了长达两年之久过后,正如我们刚才提到的,智子引擎正式发布了自己的第一个多模态产品:ChatImg,这是世界首个公开评测的通用多模态对话应用。

据了解,ChatImg在技术上是基于多模态融合模块和语言解码器,参数量大约为150亿,主打的就是让AI学会看图说话。

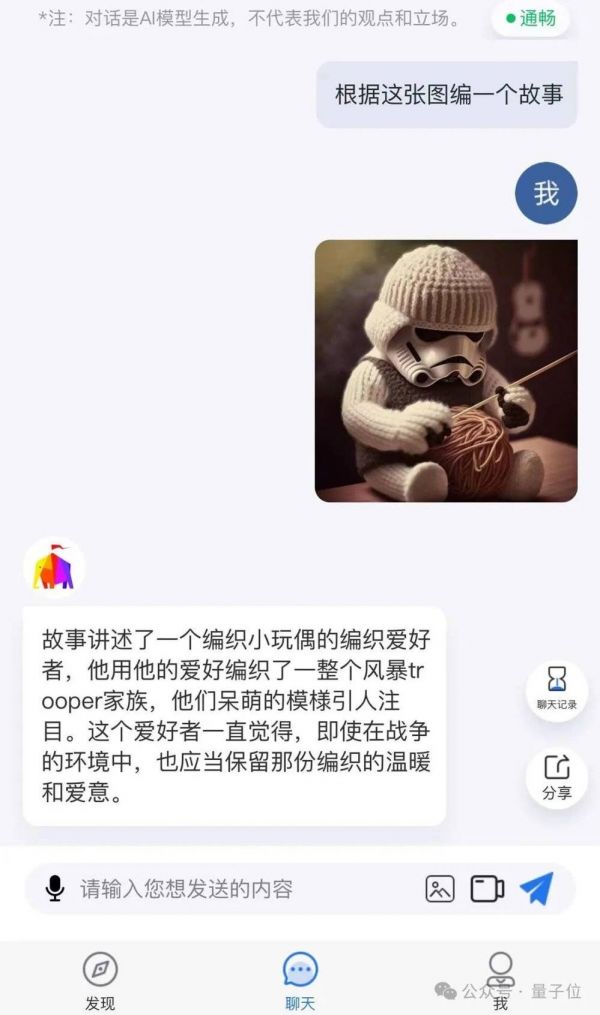

除了刚才我们展示的例子之外,ChatImg甚至是可以看一眼图片,然后直接给用户编故事。

而OpenAI这边,则是在2023年3月15日,发布了其多模态预训练大模型GPT-4。

在这一节点上,智子引擎再次与OpenAI在多模态大模型上“撞了一次车”,并且是提前发布了整整一周的那种。

至于智子引擎为何会选择3月8日,其实也与OpenAI有着千丝万缕的关系,用卢志武教授的话来说就是:

自ChatGPT在去年11月30日问世以来,经过多方评估,普遍认为传统的研究模式正遭遇重大考验。以往的自然语言处理研究多聚焦于单一任务,如翻译、命名实体识别、情感分析等,通常需要分别训练不同的小型模型。然而,随着ChatGPT的问世,一个统一的大型模型就能够胜任这些任务,使得针对单一任务的独立研究变得不再那么重要。

尽管ChatGPT的发布对多模态研究领域的影响相对较小,因为它主要擅长处理文本信息,但我们也听闻了GPT-4有意涉足多模态领域的传闻,这让我们感到紧迫。因此,我们的团队迅速行动,大约用了几个月的时间来训练ChatImg,并在3月8日成功推出,抢在GPT-4之前。

然而,这还仅仅是第二次“撞车”的一个开始。

在ChatImg发布2个月之后,智子引擎便将其迭代到了2.0版本,这一次,更是将看视频说话的功能融入了进来。

而OpenAI在多模态领域后来的大动作,应当属同年9月份所发布的GPT-4V,新增了语言和图像交互功能。

但从5月份到现在这期间,智子引擎在多模态大模型上的脚步其实也并没有放缓。

除了刚才我们提到的与Sora相似架构的VDT研究之外,智子引擎更多的是将精力投入到了如何把ChatImg用起来。

正如高一钊在与我们交流过程中所述:

我们在2023年5月和8月分别拿到了两笔融资之后,实际上花了半年的时间去探索落地,就看我们这个模型到底能干啥。

在经过大半年的时间之后,我们的验证基本上已经通过了,发现在To B业务上有很大的落地价值。

通过我们的多模态大模型,可以将图片和视频中的内容转变成文字,在非常复杂的交通、电网、化工等场景中,可以大幅降低高昂的人力成本。

因此,从商业化的角度来看,智子引擎似乎在多模态领域又比OpenAI提前了一步。

在智子引擎这里,多模态技术与商业化是并驾齐驱的。团队看来,与AI研发相比,应用场景的拓展和落地同等重要,二者双线程推进,才能形成闭环效应。

在电网、电力、化工、巡检等多个场景,基于大模型的泛化能力和涌现特性,智子引擎已经利用一个多模态大模型,满足了过去十几乃至几十个小模型才能解决的实际需求。

“我们对2024年收入实现爆发性增长非常有信心。”商业化进展顺利,研发的资金支持也就有了眉目。

那么接下来的一个问题:

三次“撞车”,意味着什么?

Sora为AI视频赛道再添一把烈火后,大家都在打问号,和一年前拿着ChatGPT追问如出一辙:

谁能第一个复现Sora?在奔向AGI终极目标的道路上,我们与国外的差距,是不是又被拉大了?

但冷静下来,看看咱们手里已经有了的技术,事实或许并没有那么悲观。

就拿智子引擎来说吧,和OpenAI技术路线的撞车一次,可能是单纯的巧合,或有许多运气成分在。

但三个颠覆性节点的三次撞车,似乎已经能够说明,国内确确实实有这么一家大模型公司代表,长年以来所坚持的通往AGI的技术路线,步子其实都踩在后来公认的正确路线上。

甚至有一两步,还迈在了业内王者OpenAI之前。

这还只是一家公司。别忘了,智子引擎只是国内大模型初创公司的一个典型代表,是业界学界千千万万AI研究团队的缩影。

我们近期搜集到不少业内人士讨论及观点——尤其是Claude 3问鼎全球大模型王座,在多个角度超越GPT-4后,大伙儿对OpenAI的过分神话更加趋于冷静。

甚至开始呼吁,目光不必过多聚焦在国外巨头身上。

放眼国内,也有很多成果是世界领先、值得借鉴的。不少还像智子引擎的VDT一样,不仅走在世界前面的,更重要的是,核心技术是国内学者原创提出的。

Sora时代,我们与最尖端的水平,或许比GPT时代的差距更小。

当然了,也许你和我们一样有疑问,都说了技术撞车,还发表在前,为什么拿出震惊世界demo的,不是VDT而是Sora?

“因为计算资源的限制,我们没能做出OpenAI那样长达60s的高质量视频。”但第三次撞车给智子引擎带来的不只是遗憾,也不只是对团队思路的外部肯定。

还有数不清的机会:现在,因为Sora的举世瞩目,VDT这样曾经给外人讲不透的技术来到聚光灯下,得到了更多的曝光。

一切都有了更大的可能性。

论文地址:https://arxiv.org/pdf/2305.13311.pdf

本文来自微信公众号:量子位 (ID:QbitAI),作者:金磊、衡宇

相关推荐

“今天,所有VC的会上都在谈Sora”

Sora冲击波

追不上Sora的同行有难了

四款视频大模型5大场景测评:Sora到底有多炸裂?

Sora还没来,概念已席卷A股

OpenAI首席科学家Ilya离开OpenAI了吗?

希望Sora别走GPT-4的老路

“已经有三个人跟我说要做中国版Sora”

Sora模型争议背后:什么是杨立昆的世界模型?

OpenAI刷屏的Sora模型,是如何做到这么强的?

网址: 人大系初创与OpenAI三次“撞车”:类Sora架构一年前已发论文 http://www.xishuta.com/newsview110881.html

推荐科技快讯

- 1问界商标转让释放信号:赛力斯 95258

- 2人类唯一的出路:变成人工智能 21448

- 3报告:抖音海外版下载量突破1 21429

- 4移动办公如何高效?谷歌研究了 20592

- 5人类唯一的出路: 变成人工智 20589

- 62023年起,银行存取款迎来 10361

- 7五一来了,大数据杀熟又想来, 8832

- 8网传比亚迪一员工泄露华为机密 8551

- 9滴滴出行被投诉价格操纵,网约 8455

- 10顶风作案?金山WPS被指套娃 7250