Transformer还不够好,它的作者决定让大模型自主进化

让大模型自己动手,好过让人类动手。黄仁勋对话Transformer八子时,最后一位离开谷歌的论文作者Llion Jones,相信这是大模型技术的关键趋势。他还卖了个关子,预告他创立的Sakana AI马上就有大动作。

21日当日,该公司就发布了EvoLLM系列模型,即一系列采用了进化模型融合技术(Evolutionary Model Merge)的大模型,覆盖文字、视觉与图像等多种模态。

Llion Jones是个取名的“鬼才”,著名论文标题《Attention is All You Need》就由他贡献。他为自己的公司取的名字,同样意蕴丰富,暗示不断融合进化的“集体智能”。

Sakana是日语“鱼”的意思,鱼群的行为复杂而协调;复杂而强大的人工智能系统,也可以由很多简单的模块融合进化而成。AI的鱼群正在形成。Llama、Mistral等开源基础模型,被扩展和微调成数百个不同的方向,产生了各自领域里表现出色的新模型。当前的Open LLM排行榜,已经由各种融合模型主导。Hugging Face上已有超过50万个模型,它们已经构成了丰富的生态,也可以进化出集体智能。

但传统的模型融合技术,往往依赖于人类的直觉和领域知识,这种方法不仅耗时耗力,而且受限于人类专家的知识和经验。随着开源模型数量的增加,手动探索所有可能的模型组合变得不切实际。

于是,Sakana AI提出了进化模型融合技术,一种利用进化算法来自动发现如何将多个不同的开源模型有效地组合在一起的技术。它的关键就在于“进化”与“融合”。

进化算法,是一种模仿自然界中生物进化过程的计算方法,可以自动地找到最优的解决方案。如果要设计一辆能够在比赛中跑得尽可能远的汽车,但又没有组装的蓝图,算法就会随机地拼凑出很多不同的汽车设计,就像是闭着眼睛从一堆汽车零件中随便抓取一些零件来组装一样。

很多汽车很快就失败了,因为它们的设计并不合理;但总有一些汽车能够勉强前进,于是算法决定只保留那些能够前进的汽车设计,并将它们的特点“遗传”给下一代汽车。经过很多代的迭代后,算法最终会得到一辆性能非常出色的汽车。

“融合”则有两种主要方式。一种是从数据流空间(Data Flow Space)入手,一种是从参数空间(Parameter Space),也就是权重入手。

数据流空间的融合,是通过进化来发现不同模型层的最佳组合,形成全新的模型架构,以处理更复杂多样的任务。就像是拼一个新的乐高机器人,你需要从不同的乐高套装中,挑选出合适的部件(层),让它既能走路,还能抓取,甚至对话。不同的组合关系数量巨大,大模型可以做得比人类更好。

参数空间的融合,则是混合来自不同模型的权重,微调成新的模型,更好地完成任务。每一层的混合比例都可以不一样。就像是调节乐高机器人部件之间的连接点,让它的手臂更灵活一点,脚踝更稳定一点。在这个过程中,你可能需要尝试成百上千种不同的调整方式。让大模型利用进化方法,可以比人类更有效地找出最佳的混合策略。

数据流空间和参数空间方法也可以组合在一起。整个过程不需要从头开始设计每一个部件,而是利用现有的AI模型作为“部件”,通过不断融合“试错”,进化出最佳的组合。

它不需要任何梯度训练,计算资源与开发时间大大减少,能够加速人工智能的部署与应用。这些新的融合模型,能够解决更专业复杂的综合任务,或提升对特定场景的适用性,甚至诞生人类专家可能未曾想到的新能力。以往,想让专业领域相距较远的专家聚在一起,用各自的语言碰撞出全新的模型非常困难。

进化模型融合技术还具备通用性,可以扩展至不同模态。Sakana AI的总部位于日本,该公司利用它们的进化模型融合技术,为这个错过了移动互联网时代的国家,生成了日语友好的大型语言模型(EvoLLM-JP)、视觉语言模型(EvoVLM-JP)与图像生成模型(EvoSDXL-JP)。

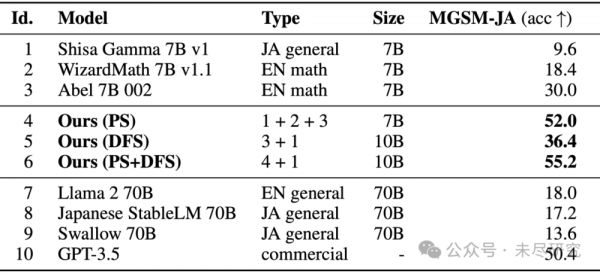

为了让大模型能更好地在日语环境下解答数学题,该公司将擅长日语的大模型(Shisa-Gamma,由Mistral-7B-v0.1微调而来),与擅长英语数学的大模型(WizardMath和Abel,均由Mistral-7B-v0.1微调而来),融合进化了上百次,迭代出70亿参数规模的EvoLLM-JP,其在基准测试中的表现,超过了之前700亿参数规模的SOTA日语大型语言模型。

基于MGSM-JA数据集的测评结果。模型1~3为原始模型;模型4~6为进化融合模型,其中PS为参数空间融合,DFS为数据流空间融合;模型7~10为对比的现有高性能LLM。

让大模型自己找出解决问题的最佳方法的时代正在到来。从手动标记“特征工程”跨越到自动学习特征,人工智能的发展已经印证过这一点。ChatGPT刚推出的时候,人们预测,未来人人都是提示工程师,但最新研究显示,在很多情况下,由大模型自动生成的提示的效果,要比人类反复试验找到的最佳提示更好。

进化模型融合技术正是这一技术趋势的延伸。以往,生物智能所积累的知识、经验与研究范式,以教学等方式,低效甚至有损地传递给少数群体;未来,越来越多生物智能将被训练成各种各样的大模型,以数字智能与集体智能的方式,不断融合进化,迅速部署到它需要出现的场景之中。

辛顿(Geoffrey Hinton)认为,机器智能超过生物智能之处,就在于各智能体之间能更高效地交流参数和梯度,学习效率高于人类之间的知识传授。EvoLLM系列模型的推出,加速了机器智能的进化。

论文:Evolutionary Optimization of Model Merging Recipes,arXiv:2403.13187

本文来自微信公众号:未尽研究 (ID:Weijin_Research),作者:未尽研究

相关推荐

黄仁勋对话 Transformer 八子:大模型的起源、现在和未来

那些挑战Transformer的模型架构都在做些什么?

Transformer诞生六周年:在它之后世界地覆天翻

陆奇的大模型世界观

Transformer六周年:在它之前世界平淡,在它之后世界地覆天翻

黄仁勋对话Transformer论文的七位作者,都说了啥?

Transformer能解释一切吗?

挑战 Transformer 霸权? Yan 架构竟以半价成本实现百万级参数大模型

OpenAI首席科学家最新访谈:对模型创业两点建议、安全与对齐、Transformer够好吗?

苹果这篇“魔改”闪存的论文,暴露了它的大模型野心

网址: Transformer还不够好,它的作者决定让大模型自主进化 http://www.xishuta.com/newsview113015.html

推荐科技快讯

- 1问界商标转让释放信号:赛力斯 94804

- 2人类唯一的出路:变成人工智能 18078

- 3报告:抖音海外版下载量突破1 17596

- 4移动办公如何高效?谷歌研究了 17349

- 5人类唯一的出路: 变成人工智 17185

- 62023年起,银行存取款迎来 9989

- 7网传比亚迪一员工泄露华为机密 7960

- 812306客服回应崩了 12 6350

- 9顶风作案?金山WPS被指套娃 6252

- 10大数据杀熟往返套票比单程购买 6233