存储芯片巨头打响HBM争霸战!美光、新思科技多位行业大牛解读功耗挑战

芯东西(公众号:aichip001)

芯东西(公众号:aichip001)编译 | 王傲翔

编辑 | 程茜

芯东西4月11日消息,美国半导体行业杂志EE Times(《电子工程专辑》)周二报道,在2023年生成式AI热潮下,随着HBM3的量产,适用于AI应用与数据计算的HBM内存的功耗受到越来越多关注。

随着AI技术的迅猛发展,企业对AI服务器内存带宽的需求正持续上升,但数据中心电力成本的不断上涨使企业开始将每瓦带宽作为重要的指标。企业在选择内存时面临成本和性能的平衡考量。

作为能够满足AI对高带宽内存需求的关键技术,HBM成为企业的首选内存。美光、三星等HBM供应商正探索创新解决方案,降低HBM功耗,确保HBM在未来高性能计算和AI应用中发挥关键作用。

EE Times专访了美国著名半导体技术供应商Rambus硅IP产品营销高级总监Lou Ternullo、美国市场研究和咨询公司Objective Analysis首席分析师Jim Handy、全球最大半导体IP接口供应商新思科技高级产品经理Graham Allan、以及美光产品管理高级总监Girish Cherussery,讨论了在当前AI持续发展下,HBM面临的功耗问题和供应商可以采取的技术措施等话题。

一、电力能耗持续上涨,内存选择受到成本限制

Lou Ternullo在接受采访时称,AI对内存带宽的需求不断增加,与HBM带宽的增加直接相关。他说:“在整个市场上,我们看到数据集和训练模型的参数越来越大,2023年的生成式AI热潮只是加速了这一趋势。”

他认为,人们对AI服务器的性能、内存带宽和内存大小等需求呈指数级增长,这给下一代HBM带来了更高的期望和压力。

此外,虽然每瓦带宽这一概念并不新鲜,HBM对每瓦带宽进行了优化以提高服务器效率,但AI数据中心的能耗一直在上升。Ternullo称:“2023年各企业对生成式AI的巨额投资和部署让一些人预测到2026年数据中心的用电量将翻一番。”

Ternullo补充说,数据中心快速增长的电力成本意味着,对于需要监控运营成本的企业来说,每瓦带宽正在成为一个更加重要的指标。随着社会对可持续发展倡议的日益关注,这一点变得更加重要。

与HBM相关的高成本和内存本身的高价格意味着,在决定超大功率内存是否需要应用时,企业总体拥有成本成为决定性因素,即企业整个数据中心的成本之和。客户在决定需要哪种内存时,首先会考虑内存的密度、性能和功耗等因素。

二、AI性能需求没有上限,HBM成AI服务器最佳内存

与其他存储芯片相比,AI或机器学习是极少数能够将更昂贵的HBM商业化的应用之一。Ternullo称:“像AI这样的应用对内存带宽有着无尽的渴求,这些应用能为企业带来更高的投资回报率,这就证明了HBM成本较高的合理性。”

不过,AI需求增加并不直接导致HBM成本上升。这是因为,AI需求主要推动企业对GPU使用的增加,但GPU通常需要HBM的使用才能达到AI服务器的预期性能。

Jim Handy称,企业需要明确的使用HBM的理由。对于某些图形应用,类似AMD这样的公司会在某些GPU上使用GDDR显存,因为GDDR相较HBM更加便宜。

Handy解释,在AI场景外,GPU主要用于图形处理,尤其是用于游戏和计算机动画后期特效。他说:“许多公司都在使用GPU,而且数量还不少。他们会有一个装满GPU的大型数据中心。”虽然GDDR最初为图形工作而设计,但多年来的新兴应用已使其他应用场景对GDDR产生了竞争性需求。

同样,Graham Allan认为,考虑到AI发展,昂贵的HBM现在也很难买到。虽然HBM仍有边缘应用,但大部分应用集中在AI领域。

即使HBM的第三次迭代已进入大批量生产阶段,Allan也不认为这项技术已经成熟。“HBM在DRAM方面是独一无二的,因为它是唯一不安装在处理器旁边主板上的DRAM。”他说,“不过,HBM的2.5D封装技术需要额外的技术步骤,这给整个行业带来了挑战。”

三、HBM需要集成在处理器上,多家供应商抓紧量产

Allan认为DRAM的实现非常简单。他说:“如果你想设计一个具有DDR5接口的SoC,你可以去查看开源的任何一种参考设计,例如找到英特尔批准的DDR5 DIMM,便可获得所有零部件号。这是一项成熟的技术。”

但对于HBM来说,包括DRAM在内的所有部分都封装在SoC内。企业可以从美光、三星和SK海力士等多家供应商中选择HBM,同时必须解决如何设计Interposer(中介层)组装以及其他问题,包括信号路径和信号完整性。

新思科技为客户提供控制HBM所需的IP,包括控制器(Controllers)、物理层接口(PHY)以及验证IP(verification IP)。Allan说:“客户正在寻求在HBM专业技术和特定参考设计方面的帮助。我们共享参考设计方案和一些最常见的中介层技术。此外,我们还协助硅片测试,包括中介层及组件的连接。这样一来,我们可以为客户提供完全定制的测试芯片。”

他认为硅片测试对于HBM尤为重要,因为企业一旦投入设计并将HBM应用到系统中,再进行更改就会非常耗时。

“HBM正在走向成熟,但仍远不及DDR和LPDDR技术成熟。尽管HBM4的逻辑方法与HBM3相似,但从DDR4到DDR5是一个巨大的飞跃。”Allan说,“选择使用HBM是一项重大承诺,因为它更加复杂,而且是一种低容量产品。客户希望尽可能降低决策风险。”

Allan还称,客户之所以选择HBM,是因为其他产品都无法满足他们的要求。在HBM之下,对于一些应用来说,GDDR内存可能是足够的,并且GDDR7的容量是GDDR6的两倍,数据传输率也有所提高。但数据传输率高是因为数据传输的通道相对较窄。

“你可以达到更高的数据传输率,但你必须非常小心地设计你的系统,因为你的系统运行速度非常快。”他说。

不过,GDDR7是2026年的技术,并且去年推出的HBM3带宽潜力较GDRR7还要高出3倍。Allan认为带宽的发展空间非常大。

他补充道,这并不意味着这样的带宽潜力足够满足企业对AI的需求,并且还有其他因素在影响整个服务器能完成多少任务。例如,中介层有可能成为瓶颈。如果服务器的PCB布线不佳,串扰过多,那么服务器性能最终可能会下降。

微电子产业领导标准机构固态技术协会(JEDEC)目前正在制定HBM4规范,但不愿说明这一规范的进展情况。SK海力士副总裁金基泰(Kim Chun-hwan)在2024年韩国半导体展(Semicon Korea 2024)上发表主题演讲时透露,该公司计划在2026年之前开始量产HBM4。

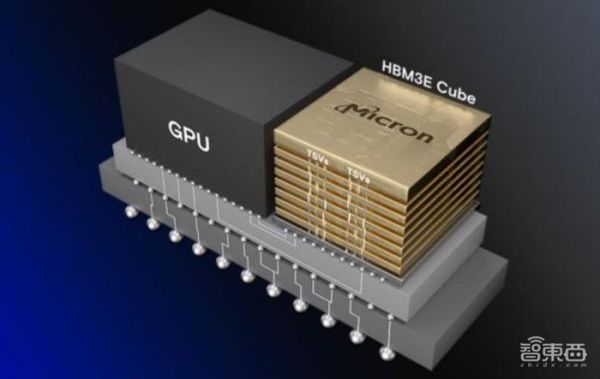

美光最近开始量产其HBM3E内存,今年HBM产能已基本售罄。该公司的首款HBM3E具备8层堆叠和24GB容量,并具有1024位接口、9.2GT/s的数据传输速率和1.2TB/s的总带宽。

▲美光HBM3E规格(图源:Micron Technology)

▲美光HBM3E规格(图源:Micron Technology)四、数据中心更加注重功耗,美光、三星采用不同方式降低内存功耗

Girish Cherussery称,HBM刚进入市场时,美光审查了HBM适用的工作负载,并决定将HBM性能目标定为比行业需求高出30%。“我们是经得起未来考验的。”Cherussery说,“一个关键指标是每瓦性能,这是一个关键的功耗边界条件。我们专注于确保每瓦性能显著提高。” 此外,客户还希望HBM靠近计算单元。

Cherussery解释道,包括大语言模型在内的许多AI工作负载正变得越来越受内存约束,而不是受计算约束。如果你的服务器有足够的计算能力,那么服务器内存带宽和容量就会成为制约因素。AI工作负载给数据中心带来了很大压力。

此外,内存利用率高意味着内存功率是数据中心的耗电大户,因此节省5瓦的电量就能提高内存利用的效率。越来越多的数据中心看重瓦特数而不是服务器的数量。使用HBM时,冷却HBM也是一个重要因素,因为它是一种堆叠式内存。HBM运转产生的热量需要散发出去。

除了带宽、功耗和整体散热情况外,易于集成是所有HBM最关键的特性。Cherussery称,美光拥有自己的专利,可以将其HBM集成到主机系统中。

“业界已经为HBM3E做好了准备,它可以很容易地被集成到使用HBM的系统中。”他说,“我们的产品可以无缝集成到相同的插槽中,无需任何改动。它的占位面积与上一代产品相同。”

更高的带宽和更大的容量将是HBM4的特点。随着AI大模型的增长,企业对HBM容量和带宽的要求也呈线性增长。

“内存行业整体处于一个有趣的阶段,因为从未出现过某种工作负载如生成式AI和普通AI一般,与内存带宽和内存容量的增长呈线性关系。这意味着对于计算和内存,企业将不得不开始考虑与过去略有不同的系统。数据中心本身正变得越来越异构。”他说。

三星也见证了数据中心里异构计算和更多以AI为重点的服务的显著增长。负责三星产品规划和业务支持的副总裁金仁东(Indong Kim)说:“这种增长似乎与同时提供直接和间接AI解决方案的超大型企业的崛起相吻合。”

他认为,数据中心正在不断发展,以便将计算资源的最大潜力用于包括AI在内的特定工作负载,实现这样潜力的重点在于DRAM带宽和容量。尤其令人兴奋的是,采用CPU和专用加速器这两种不同类型处理器的异构架构,在提升内存方面的目标是一致的。他相信,这一趋势将为DRAM制造商提供巨大的增长机会。

在Memcon 2024大会上,三星展示了该公司所称的全球首款12堆栈HBM3E DRAM。它采用了三星先进的热压非导电膜(TC NCF)技术,内部垂直密度较前代产品提高了20%以上,同时还提高了产品良率。随着大规模并行计算在高性能计算(HPC)环境中越来越普及,Kim称HBM需求还将激增。

三星的HBM3E DRAM专为满足高性能计算和苛刻的AI应用而设计。该公司还推出了基于Compute Express Link(CXL)开放互连协议的Memory Module-Box(CMM-B)内存盒模组,旨在支持需要大容量内存的应用,例如AI、内存数据库和数据分析。CMM-B还支持内存池(memory pooling),这是异构计算的一个关键要素。

▲三星推出CXL Memory Module-Box内存盒模组(图源:Samsung Electronics)

▲三星推出CXL Memory Module-Box内存盒模组(图源:Samsung Electronics)金仁东称,AI对内存容量和带宽的需求不断增长,模型的参数规模不断增长,加速了存储芯片玩家对不同存储技术研发的步伐。CXL协议与HBM相互交织,为应对不断增长的AI需求提供最佳特性,促进现有的DRAM-SSD存储层次结构的发展。

他说:“我们相信,CXL将成为不断增长的容量需求的完美补充,提供最佳特性,弥合现有的DRAM-SSD层次结构。”

结语:HBM发展前景广阔,帮助企业降低成本

随着AI对内存带宽需求的持续增长,HBM作为一种高性能内存技术受到越来越多的关注。尽管HBM面临着成本高、集成复杂等挑战,但其在AI数据中心和其他应用场景中的重要性不断凸显。HBM供应商也在采取不同的技术降低HBM功耗,以帮助节省数据中心电力成本。

在此背景下,HBM逐渐走向成熟,但仍需面临DDR和LPDDR等成熟技术的挑战。随着HBM4、HBM3E的开发和部署,预计HBM将继续在高性能计算和AI应用中发挥重要作用。

发布于:北京

相关推荐

存储芯片巨头打响HBM争霸战!美光、新思科技多位行业大牛解读功耗挑战

美光开始赚钱了

存储芯片,苦尽甘来?

存储芯片,拐点将至

HBM芯片暗战

AI国力战争:GPU是明线,HBM是暗线

HBM,新混战!

存储芯片巨头涌向新赛道

美光,押错宝?

英伟达点火!它,是存储芯片寒冬中的一把火

网址: 存储芯片巨头打响HBM争霸战!美光、新思科技多位行业大牛解读功耗挑战 http://www.xishuta.com/newsview114957.html

推荐科技快讯

- 1问界商标转让释放信号:赛力斯 95178

- 2人类唯一的出路:变成人工智能 20885

- 3报告:抖音海外版下载量突破1 20771

- 4移动办公如何高效?谷歌研究了 20054

- 5人类唯一的出路: 变成人工智 20036

- 62023年起,银行存取款迎来 10307

- 7网传比亚迪一员工泄露华为机密 8456

- 8五一来了,大数据杀熟又想来, 8338

- 9滴滴出行被投诉价格操纵,网约 7960

- 10顶风作案?金山WPS被指套娃 7213