奥特曼回应Ilya/Jan离职,暗示GPT-5发布会推迟 |笔记

奥特曼和布洛克曼,联名回应了Ilya/Jan及超级对齐部分团队成员辞职事件。

许多人以为,这是去年11月OpenAI宫斗大戏的第二季,但这实际上是尾声。

辞职事件再次暴露了OpenAI两个内在的矛盾。

一个是人类福祉优先与商业利益之间的矛盾,这导致它设计了营利和非营利的双层架构,这样的治理结构,又导致了去年11月董事会发起“政变”,解除了奥特曼CEO职位,然后5天的宫斗大戏发生反转,奥特曼王者归来,重组董事会。但矛盾并未消除。

一个是AGI与安全伦理之间的矛盾。AGI创造了一种乌托邦式的、科幻式的对人类的”生存威胁”。当AGI与一家以营利为目的的企业结合起来时,实现AGI的时间表和解决AGI的安全问题,会变得越来越突出,它们之间的矛盾越来越尖锐。

尤其是GPT-5被说成是已经实现了或者逼近了AGI;或者说AGI即将实现,不管是1年,还是3年,或者是2030年,那么OpenAI必须要证明它在发布GPT-5之前需要优先解决安全问题。

以本吉奥和辛顿等为代表主张AGI可能对人类产生“生存危胁”,他们主张头部的AI企业要投入30%的资源用于安全,OpenAI也承诺为首席科学家苏茨克沃(Ilya Sutskever)的超级对齐团队投入20%的算力。

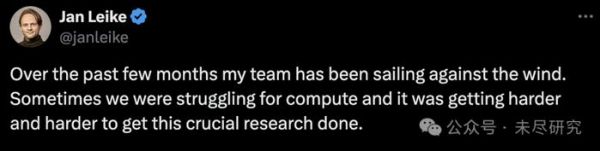

但是,OpenAI的算力来自微软。微软已经解散了它自己的AI安全团队,而且为了减少对OpenAI的依赖,微软正在训练和部署自己的AI系统,需要一个10万张GPU卡的算力集群。Jan抱怨说,OpenAI内部将有限的算力资源,更多分配于那些被称为“华而不实”(shiny project ) 的商业类项目。

这就是负责超级对齐部门另一位负责人Jan Leike最近辞职的导火索: 算力不够,关键的研究越来越难做。

可以估计GPT-5的预训练已经完成,目前处于后训练阶段,其中对齐与安全至关重要,而正是超级对齐团队,要为下一代大模型的安全负起责任。“构建比人类更聪明的机器本质上是一项危险的工作。OpenAI 正代表全人类承担着巨大的责任。”

Jan认为:“我们应该花更多的精力为下一代模型做好准备,关注安全、监控、准备工作、安全性、对抗性鲁棒性、(超级)对齐、保密性、社会影响以及相关议题。”

硅谷圈子里也想知道内情,究竟是OpenAI管理层“克扣”了对齐团队的算力资源,还是模型越来越大越来越复杂,用于超级对齐和安全的研究,20%的算力也不够了。

奥特曼和洛克曼的回复透露出了一些重要的线索:

下一代大模型,如GPT-5,将注重“与世界更深入地整合”,它将是多模态的统一大模型,也将发挥出智能体的作用。

Scaling law对于大模型的智能涌现和安全问题同样适用,即更多的算力加上更大的数据库预训练出更智能和更大的模型,带来的安全风险也越大。尤其是AI技术的大规模部署,将会为无数应用场景下控制风险带来极大的挑战。

但是,还有一个更加根本的问题,现在AI真的有那么聪明吗?我们是不是被AGI这个说法忽悠了?因为AGI只是一个营销上的术语,目前并不具备严谨科学的定义。

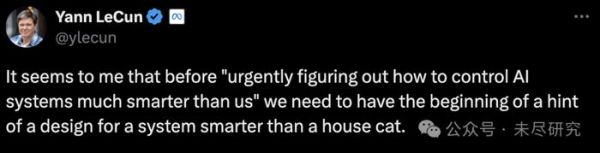

图灵奖得主杨立昆这次又跳出来了。大语言模型并不具备真正意义上的智能,它体现出来的是超强的检索能力,与人和动物基于”世界模型”、在真实的物理世界中通过互动与实践建立起来的智能,不可同日而语。人工智能目前要解决的问题,是先达到阿猫阿狗的智力水平,即使这样也要花很多年时间。

所以接下来的几年,是AI要达到阿猫阿狗的水平,而不是实现AGI。

杨立昆认为,作为一项新技术部署到应用中,AI与人类之前发明的技术并无本质不同。如飞机从发明时的非常不安全,到后来普及成为大众交通工具,用了几十年时间的工程和质量改进。

既然如此,人类没有必要自己吓唬自己,或者用吓唬自己创造一种叙事以达到商业目的。OpenAI让对齐安全部门靠边站,这是一种事实求是的做法。

这Ilya/Jan辞职引发的风波,其实源自去年宫斗埋下的伏笔——OpenAI内部所谓降临派与生存派之间的博弈。

随着Ilya/Jan的离去,可能标志着OpenAI对AI安全与伦理问题方向的一些调整,舒曼已经被任命负责超级对齐部门,他相信AGI会在几年内实现。是建立起一个庞大的团队研究出一种通用的对齐技术,还是在实际应用中、在完善模型的工程与质量中逐步的提升AI的安全,包括让监管部门参与进来,OpenAI可能在选择后者。

奥特曼也回应了关于禁止离职员工批评原雇主的条款,他为此感到“尴尬”,并且已经开始修改有关条款,不会因为已经离职员工批评原雇主而收回其股权。

附:

奥特曼/布洛克曼的回应

我们非常感谢 Jan 为 OpenAI 所做的一切,我们知道他离开后仍会继续为我们的使命做出贡献。鉴于他离职引起的问题,我们想解释一下我们对整体战略的看法。

首先,我们提高了对 AGI 风险和机遇的认识,以便世界能更好地为其做好准备。我们多次展示了深度学习规模化的巨大可能性,并分析其影响;在这种呼吁还不普及之前就呼吁对 AGI 进行国际治理;并帮助开创了评估 AI 系统灾难性风险的科学。

其次,我们一直在为安全部署日益强大的系统奠定基础。第一次弄清楚如何使一项新技术安全并不容易。例如,我们的团队为安全地将 GPT-4 推向世界做了大量工作,并且自那时起,我们不断改进模型行为和提升对滥用的监控,以应对部署过程中学到的经验教训。

第三,未来将比过去更艰难。我们需要不断提升我们的安全工作,以匹配每个新模型的风险。去年我们采用了准备框架,以帮助系统化地完成这一任务。

这似乎是谈谈我们对未来看法的最佳时机。

随着模型变得越来越强大,我们预计它们将开始更深入地与世界整合。用户将越来越多地与由多个多模态模型加上工具组成的系统交互,而不是仅仅通过文本输入和输出与单个模型交谈。

我们认为这样的系统将对人们非常有益,并且可以安全地交付,但这将需要大量基础性工作。这包括在它们训练时连接到的内容上的深思熟虑,解决可扩展监督等难题,以及其他新的安全工作。在我们朝这个方向前进时,我们还不确定何时能达到我们的安全发布标准,如果这推迟了发布时间,我们也能接受。

我们知道我们无法想象每一个可能的未来场景。因此,我们需要非常紧密的反馈循环,严格的测试,每一步都要仔细考虑,世界级的安全性,以及安全性和能力的和谐。我们将继续进行针对不同时间尺度的安全研究。我们也在继续与政府和许多利益相关者合作,共同致力于安全。

通往 AGI 的道路上没有现成的成功范本。我们认为经验理解可以帮助指引前进的道路。我们既相信实现巨大的上升空间,也致力于减轻严重的风险;我们非常认真地对待我们的角色,并仔细权衡对我们行动的反馈。

奥特曼对相关股权问题的回应

关于最近有关 OpenAI 如何处理股权的事情:

我们从未收回任何人的已归属股权,如果人们不签署离职协议(或不同意不诋毁协议),我们也不会这样做。已归属的股权就是已归属的股权,仅此而已。

在我们以前的离职文件中有关于潜在股权取消的条款;虽然我们从未收回任何股权,但这不应该出现在任何文件或沟通中。这是我的责任,这是我在管理 OpenAI 时为数不多的几次真正感到尴尬的情况之一;我当时不知道这种情况的发生,我本应该知道。

过去一个月左右的时间里,团队已经在修正标准离职文件的过程中。如果有任何签署了这些旧协议的前员工对此感到担忧,他们可以联系我,我们也会修正这些协议。对此非常抱歉。

杨立昆的评论

在我看来,在“紧急找出如何控制比我们聪明得多的 AI 系统”之前,我们需要有一个关于比家猫更聪明的系统设计的开端。

这种紧迫感反映了对现实极为扭曲的看法。

难怪组织中更务实的成员试图边缘化超级对齐小组。

就像有人在 1925 年说“我们急需找出如何控制能够以接近音速跨越海洋运输数百名乘客的飞机”一样。

在涡轮喷气发动机发明之前,并且在任何飞机都未能不间断地跨越大西洋之前,要让长途客机变得安全是很难的。

然而,我们现在可以完全安全地乘坐双引擎喷气式飞机飞行半个地球。

这并不需要某种神奇的安全配方。

这花了几十年的精心工程和反复改进。

对于智能系统,过程将会类似。

它们需要多年时间才能变得像猫一样聪明,还需要更多年的时间才能变得像人类一样聪明,更不用说更聪明了(不要将当前 LLM 的超人知识积累和检索能力与实际智能混为一谈)。

它们需要多年时间来部署和微调,以在变得越来越聪明的同时提高效率和安全性。

发布于:上海

相关推荐

Ilya离开OpenAI内幕曝光

OpenAI解散Ilya重要团队,前高管怒斥,宫斗第二季?

奥特曼回忆OpenAI宫斗第一季:一生中最奇特的时刻

奥特曼回应一切:GPT-5、董事会宫斗、Ilya看到了什么

离职吐真言!刚辞职的超级对齐负责人狠批OpenAI: 追求华而不实的产品,误入歧途,忽视AGI安全

剧透GPT-5,物色芯片厂,Sam Altman不敢停下来

Ilya官宣离职,OpenAI还是走散了

奥特曼专访:关于GPT-5、Sora、Ilya、Q*、AGI等等一切

初心、盈利、人类危机:奥特曼正式回归OpenAI,但错的可能是他

“剧透”一下OpenAI的GPT-5

网址: 奥特曼回应Ilya/Jan离职,暗示GPT-5发布会推迟 |笔记 http://www.xishuta.com/newsview118906.html

推荐科技快讯

- 1问界商标转让释放信号:赛力斯 95198

- 2人类唯一的出路:变成人工智能 20989

- 3报告:抖音海外版下载量突破1 20908

- 4移动办公如何高效?谷歌研究了 20153

- 5人类唯一的出路: 变成人工智 20148

- 62023年起,银行存取款迎来 10317

- 7网传比亚迪一员工泄露华为机密 8472

- 8五一来了,大数据杀熟又想来, 8423

- 9滴滴出行被投诉价格操纵,网约 8046

- 10顶风作案?金山WPS被指套娃 7219