字节终于掀桌子了

字节跳动低调潜行一年多,终于憋了一个大招。

5 月 15 日,字节跳动首次向外界“推销”旗下 AI 大模型——其自研豆包“全家桶”官宣将通过火山引擎(字节旗下六大业务板块之一,其余五块分别是抖音、大立教育、飞书、朝夕光年、TikTok)对外提供服务。

至此,字节跳动纵身跳入国内大模型混战,其大模型版图正式浮出水面。

图注:豆包大模型“全家桶”

之所以出手即“王炸”,源于字节已经跨过模型效果、推理成本、落地难度这三道最为关键的门槛。

首先,模型效果对 AI 落地最为关键,只有大使用量才能打磨出好模型——据火山引擎官方数据,经过一年时间的迭代,豆包大模型正成为国内使用量最大、应用场景最丰富的大模型之一,日均处理 1200 亿 Tokens 文本,生成 3000 万张图片。

此外,字节跳动产品和战略副总裁朱骏透露,豆包平台月度活跃用户达到2600万,已有超过 800 万个智能体被创建。作为对照,QuestMobile 数据显示,截至今年 3 月,豆包(字节跳动)、文心一言(百度)、天工(昆仑万维)、讯飞星火(科大讯飞)、Kimi 智能助手(月之暗面)位居 AIGC APP月活 TOP5——恐怖的是,豆包上线仅三个月就完成用户量逆袭。

数据来源:QuestMobile 统计

这背后,虎嗅了解到,字节跳动在过去一年通过拆解明确每个部门的 OKR(例如抖音主要负责拉新,而字节专门负责 AI 产品的 Flow 部门负责开发及产品增长)实现了部门间互不干涉,解决了互联网公司迅速扩张所面临的组织协同问题,是国内逐梦 AI 浪潮互联网公司中战略最清晰的一个。

值得一提的是,豆包大模型(原名:云雀)早于 2023 年就在字节内部完成了上线,并基于豆包大模型打造了 AI对话助手“豆包”、AI 应用开发平台“扣子”、互动娱乐应用“猫箱”,以及星绘、即梦等 AI 创作工具,并把大模型接入抖音、番茄小说、飞书、剪映等字节跳动旗下 50 余个业务,用以提升效率和优化产品体验。

“技术在快速演化,但用户核心的需求没有改变,比如高效获取信息、工作提效、自我表达、社交娱乐等;字节做了很多探索,寻找适合大模型应用的形态,希望自然交互走入更多人的日常生活。”朱骏说道。

这并非盲目乐观,IDC 发布的《2024 AIGC 应用层十大趋势白皮书》预测,2024 年全球将涌现出超过 5 亿个新应用,相当于过去 40 年间出现的应用数总和,智能化应用将呈现爆发式增长,大模型浪潮将加速渗透进人们的日常生活。

其次,降低推理成本是大模型快进到“价值创造阶段”的一个关键因素。

例如,腾讯混元大模型采用混合专家模型 (MoE)结构,自研 Angel 机器学习平台,训练速度达到主流框架的 2.6 倍,推理成本相比业界主流框架下降 70%;OpenAI、智谱大模型也都在近期降低了大模型价格。

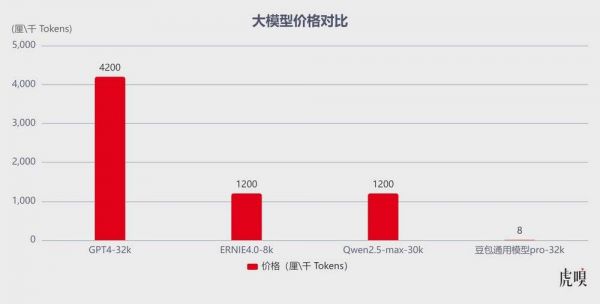

不过,当火山引擎总裁谭待宣布豆包主力模型(小于等于 32K)推理输入价格仅为 0.0008 元/千 Tokens 时,还是不免让人感到错愕——要知道,市面上同规格模型的定价一般为 0.12 元/千 Tokens,而豆包主力模型比行业便宜 99.3%。

按这个价格,8 块钱可以买到豆包模型的 1000万 Tokens,大约 1600 万个汉字——其正以“价格屠夫”的姿态打穿大模型市场,被外界戏称“打响大模型市场价格战第一枪”。

对此,谭待表示背后有两个原因:“一是能做到,二是需要这么做;主力模型比行业便宜 99.3% 在技术上可实现,未来还有很多手段降低成本。”

最后,豆包分布式推理还有混合调度,发挥各种各样的异构算力,解决了推理算力的问题,进而把模型推理的成本降到很低。

“以前企业做创新担心 ROI 打不正,一来创新项目 90% 会失败,二来创新按消耗 100 亿 Tokens 算就要 80 万;现在成本只需要 8000 元,失败也花不了多少钱,但剩下 10% 项目成功就可以把投入都赚回来,这无疑能帮助更多企业轻装上阵,无负担投身 AI 大潮。”谭待说道。

当然,字节愿意躬身给企业“搭台”的深层次原因还在于:移动互联网业到了用户、流量趋于见顶的成熟期,监管会更侧重产业互联网的推进与建设,这意味着技术走到平台重构生态的关键时期。

正如美团创始人兼 CEO 王兴当年讨论 BAT 竞争关系时说的那样,竞争这个词放在一起说就会变成思维定势,“麦克阿瑟将军在西点军校告别演讲说‘Only the dead have seen the end of war’(只有死去的人才能看到战争终结),战斗只是从一个战场变成另一个战场,从一个机会变成另一个机会,总有不断的变化。”

尤其,ChatGPT 横空出世让整个互联网都为之躁动,追赶大模型浪潮使得互联网又陷入一种混战的焦灼状态,而心有猛虎的公司都在寻找向上攀爬的入口——当通用人工智能时代呼啸而来,字节手握应用层及数据层的独特优势,抖音拥有丰富的数据素材和充足的算力资源,必须在快速发展时期果断投入(包括技术生态迭代、研发投入等),从而博一张未来的船票。

以下为虎嗅与火山引擎总裁谭待两次(5 月 15 日、5 月 16 日)沟通实录(部分表述因方便阅读需要有所删改):

字节凭什么把价格打下来?

Q:行业有声音说大模型算力资源短缺,字节为什么愿意大幅度降价?

谭待:一般说算力资源不够用说的是训练,但今天说的大模型 ToB 服务主要是推理。做推理只要技术基础做得好就可以用各种异构算力满足性能、减少延迟,还能解决算力瓶颈。豆包分布式推理还有混合调度,就是通过调度好各种异构算力解决了推理算力的问题。

其次,解决算力也就解决了成本问题,就能把模型推理成本降到很低。以前企业做创新担心 ROI 打不正,一来创新项目 90% 会失败,二来创新试错贵(按消耗 100 亿 Tokens 算就要 80 万);现在试错成本降到 8000 元,失败成本可控,只要剩下 10% 项目能成就可以把投入都赚回来,这让很多企业轻装上阵,无负担投身到 AI 大潮。

Q:字节把价格卷到以厘为单位的低价,这对于现阶段整个行业是好事吗?

谭待:当然,很多企业能以更低成本做各种创新了,对于做大模型创业者来说没有哪个是靠 ToB 赚了很多钱,通过 ToB 服务来把自己的大模型正循环这个不行了,现在还是一个特别早期的阶段,要把蛋糕做大先要做到普惠,这是最重要的。

Q:字节能将价格压到低于同行 99.3%,豆包的性能和成本如何?

谭待:现在模型应用落地时,精调是关键,豆包 pro 支持 128k 可精调。豆包主力模型可以跟所有主力模型去对比,网上可以看到很多第三方测试,拿豆包 APP 来说,现在月活 2600 万,用的人越多调用量就越大,模型自然就会越好。

至于成本问题,ToB 业务要看长期,用亏损换收入不可持续,字节从来不走这样的路,降价源于技术自信,这个定价是火山对技术有信心,未来还有很多手段持续降低成本。

Q:豆包大模型彻底把价格打下来了,为什么说“低价”是对技术的自信?

谭待:首先,技术上有非常多优化手段把成本做低且让效果更好,比如模型结构优化调整;其次在工程上以前都单机推理,现在是分布式推理,自然能把各种底层算力用得更好,进而大大降低成本,尤其调度量非常大后,能将不同负载作为混合调度,使成本大幅下降。而且,OpenAI 也在降价,试想未来大模型在人们日常生活每天都用,低价是真正广泛应用的前提。

其次,今年大模型能力在明显提升,做应用变得越发重要。很多客户都想去做大模型尝试,但碍于价格(AI试错、业务创新风险高),要面临非常多不确定性,必须把试错成本降得非常低,才能让大家(企业、个人开发者)广泛用起来。所以,当下最迫切的就是降低成本。

Q:豆包大模型应用于字节内部产品的使用情况如何?

谭待:首先,同名 APP 豆包(截至今年 4 月,豆包在苹果中国区 App Store 效率榜排名第一;其安卓市场累计下载量 1.37 亿,在 AIGC 类应用中断崖式领先)用户量(月活达 2600 万)说明效果非常好,还有星绘这样的创新应用。

除了 AI 原生应用外,抖音、头条、飞书部分功能都使用了大模型,比如抖音搜索、头条搜索结果就是用豆包大模型来生成,它还可以进一步追问用户想了解什么信息?包括抖音电商很多营销文案、导购、助手等等领域都有应用。

除了这些应用场景,传统很多用 NLP(自然语言处理)解决的问题豆包也可以做得更好,可以为一些业务后台操作带来极大的效率提升。

Q:AI落地场景很重要,火山有哪些客户应用场景可以分享?

谭待:手机交互场景太多了,手机搜索、助手AI 等(OPPO 小布助手、荣耀智慧办公智能助手、小米“小爱同学”、华硕豆叮 AI 助手均已接入火山引擎大模型服务);车机现在也比较多,导航顺便看商圈、餐厅、周边影院,(不方便看手机时)模型会告诉车把对应内容找出来完成交互;再比如汽车座舱对模型能力要求不那么高,适合用豆包通用模型 lite,不光推理单价更低,延迟也低 50%。

当然,场景落地一方面技术要提升,像 pro、lite、角色扮演,语音都有广阔的应用场景;另一方面,应用生态是一堆人的群体智慧,更好模型、更低成本、更易落地才能繁荣生态,大企业是高代码,但个人开发者要的是低代码,必须低门槛这个事情才能做起来,形成 AI 时代的创新。

字节蓄力,“火山”爆发?

Q:如何看待互联网巨头在大模型赛道的激烈竞争?

谭待:国内大模型现在还不是谈竞争的时候,因为大模型现在还是在初期,池塘有多大鱼才多大,大模型市场才刚刚开始,这个时候一起把大模型做好、把应用落地做好、把成本做低,让更多人和企业受益才是关键,现在远未到激烈的竞争。

Q:之前周鸿祎和李彦宏有关于开源与闭源的讨论,火山会朝开源还是闭源发展?

谭待:首先,对于模型公司来说开源闭源不是非黑即白,而是综合的方式,我们内部也在讨论,是不是未来某一个版本、某一个尺寸的模型就用开源来做;其次,企业模型应用是开源还是闭源本质在于背后的需求,是担心安全问题,还是担心成本问题,还是担心服务问题等。

Q:互联网大厂在云计算领域竞争激烈,大模型应用到云计算领域会侧重在哪些层面布局?

谭待:云生态包括 IaaS、PaaS、SaaS,AI 大模型本身对云来说是锦上添花,是把数字化往深往广去做,比如模型推理可以通过云的方式把成本做到很低,所以从价格去考虑 AI 是建立一个算力到智能的相关性,把越来越多数字化需求、生活场景与算力融合。

当然,火山更关注 ToB 方向:第一,有一些行业很有集中性,比如手机、汽车可以通过联盟一起做好;第二,一些行业不是特别清晰,就和最有想法的企业深度合作;第三,开发者非常重要,面对新技术浪潮做出不同创新的不是过去的巨头,而是新的开发者,怎么把他们服务好,让他们做出更优秀的 AI 应用很重要。

而且做公有云,字节的理念就是要成本低,就像做电商要优质、低价一样,降本增效是写到火山引擎愿景里去的,不知道其他人有没有写,这是认知上的差别。

Q:字节有数据优势,在文生视频这方面是否有布局实现弯道超车?

谭待:字节有款产品即梦(Dreamina),除了文生图还有一些短视频生成功能。模型训练一定要技术扎实,本质上不存在弯道超车;其他模态也一样,要先把基础做好,如果基础都做不好,那文生图就是一个‘人工智障’——因为它连文字都不能理解,视频能好到哪儿去?所以没有弯道超车,要一步一步扎实去做。

虎嗅注:事实上,字节跳动于 2023 年 11 月已发布视频生成研究成果 PixelDance,提出基于文本指导 + 首尾帧图片指导的技术方法,能生成具有高度一致性和丰富动态性的视频;今年 1 月,字节又发布视频生成模型 MagicVideo-V2,效果比肩 SVD-XT、Pika1.0、Gen-2(Runway) 等同类模型。

Q:最近 OpenAI(GPT-4o)、谷歌(谷歌I/O大会升级 Gemini 全家桶)相继公布最新大模型进展,国内外所处阶段及差距如何?

谭待:实事求是地讲 OpenAI 肯定还是全球第一,包括 anthropic、Gemini 也做得非常好,要承认差距;但反过来说有两点,一是我们的模型在不断进化,一旦进化到某一个层次,就有可能去上面做应用。

为什么(字节)这么久才正式对外发布豆包?因为豆包到了大家可以广泛用它去做应用的程度,只有越来越多的人去做更多应用,反过来又可以驱动技术进步,形成一个正循环。

前天(5 月14日)OpenAI 发布会,语音做得好不好对整个交互体验影响很大,可能模型很聪明但讲话像机器人,豆包和全球最好的产品仍有差距,需要一个追赶的过程,目前追的速度还行,用户量也越来越大。

#我是虎嗅商业、消费与机动组副组长黄青春,关注文娱社交、游戏影音等多个领域,行业人士交流加微信:724051399,新闻线索亦可邮件至 huangqingchun@huxiu.com

相关推荐

阿里云为何又“掀桌子”了?

B站掀桌子了

长城跟比亚迪掀桌子,究竟为什么?

苹果获车载智能桌子专利:可自由调整位置、苹果车载桌子可做显示器

李国庆直播首秀,自曝因俞渝掀两次桌子,现在自责

谷歌母公司聘了100多台机器人,扫地热菜擦桌子,还能自主学习

抖音支付上线,字节跳动的机会终于来了?

大模型也疯狂:字节卷价格、腾讯终开源,OpenAI与谷歌互搏

杨幂新剧播出,“掀桌文学”又开始了?

巨头终于入局,字节涉足音乐业务有何打法?

网址: 字节终于掀桌子了 http://www.xishuta.com/newsview118947.html

推荐科技快讯

- 1问界商标转让释放信号:赛力斯 95093

- 2人类唯一的出路:变成人工智能 20339

- 3报告:抖音海外版下载量突破1 20157

- 4移动办公如何高效?谷歌研究了 19551

- 5人类唯一的出路: 变成人工智 19456

- 62023年起,银行存取款迎来 10251

- 7网传比亚迪一员工泄露华为机密 8371

- 8五一来了,大数据杀熟又想来, 7877

- 9滴滴出行被投诉价格操纵,网约 7501

- 10顶风作案?金山WPS被指套娃 7171