阿里云饱和式投入 AI,不想在 “迟疑中错过变革”

吴泳铭:生成式 AI 最大的想象力,不是一两个手机上的超级 App。

文丨贺乾明

编辑丨程曼祺

吴泳铭难得的公开亮相,给了阿里云。

去年 9 月,吴泳铭接任阿里巴巴集团 CEO,后直接管理两大业务板块:一是阿里赖以起家,目前仍为最大主业的电商,吴泳铭是淘天集团董事长兼 CEO;另一个就是阿里云,吴泳铭同时担任阿里云智能集团董事长兼 CEO。自那以后,吴泳铭甚少公开露面,去年的双十一晚会他也没有参加。

在 9 月 19 日举办的 2024 云栖大会上,吴泳铭在主题演讲中说:“新技术应用早期,渗透率比较低,大部分人会产生怀疑,这很正常。但新技术革命会在人们的怀疑中成长,让很多人在迟疑中错过。”

这概括了如今大模型领域的观点分歧。由 ChatGPT 引发的大模型和生成式 AI 热潮,因一系列进展不如预期——GPT-5 迟迟未发、Sora 未大规模开放等——在今年下半年转冷。微软、Goolge 等公司的财报会上,高管们频繁被追问:到底如何平衡大模型的投入与收益?

直到一周前,OpenAI 在 9 月 13 日发布最新模型 o1 系列,展示投入更多算力、数据等资源,依然能换来模型性能提升,才一定程度上扭转了市场风向。

阿里云对 AI 的投入有自己的逻辑,它将 AI 机会视为算力基础设施 + 模型 + 应用的整体,阿里云定位于做好基础设施,并通过开放更先进的模型,建设 AI 生态。吴泳铭昨日说,阿里云会持续以前所未有的强度投入 AI 技术研发和基础设施建设。

阿里云已看到了真实需求。吴泳铭说,当前新增算力需求中,超过 50% 由 AI 驱动,而且规模持续扩大。“过去一年,阿里云投资新建大量 AI 算力,还是远远不能满足客户的旺盛需求。”

阿里也看好生成式 AI 的长期前景。当前大多数投资大模型的公司把重心放在研发应用上,希望开发出下一个类似淘宝、微信或抖音的超级 App。

而在吴泳铭看来,现在仍处于 AGI 变革的早期:“生成式 AI 最大的想象力,绝不是在手机上做一两个新的超级 App,而是接管数字世界、改变物理世界。” 这意味着,几乎所有行业都需要性能更强、规模更大、更适应 AI 需求的基础设施。

围绕这些判断,阿里云宣布了一系列新动作,除继续全方位建设更有效率的 AI 大模型计算设施;还开源了性能逼近 GPT-4o 的大模型 Qwen 2.5,涵盖能用到多种场景的 0.5B 到 72B 参数规模的多个版本;以及再次大幅降价——Qwen 系列主力模型降价 85%,百万 tokens 价格低至 0.3 元。阿里云 CTO 周靖人说,这些新动作会进一步刺激开发者和各行各业客户使用大模型的需求。

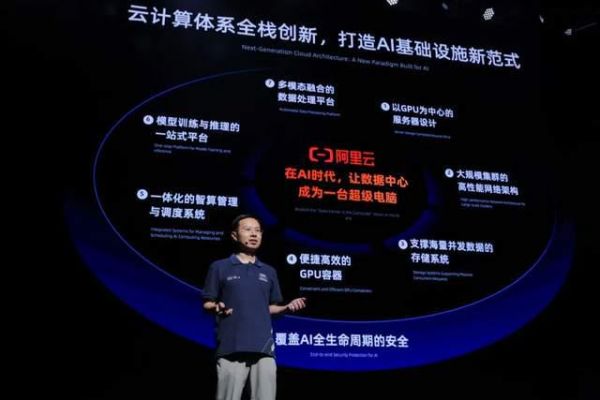

从底层硬件开始重构计算体系,持续建设 AI 基础设施

支撑大模型的基础设施,与早些年的云计算设施相比有明显变化。广为人知的是算力芯片从以 CPU 为主变成 GPU 为主。这推动英伟达成为全球最大的芯片公司,市值一度突破 3 万亿美元。

底层硬件只是计算基础设施转变的一部分。“AI 技术变革,触达计算体系的方方面面,是全栈、全系列的技术革命。” 周靖人在昨日的群访中说。

生成式 AI 的模型规模大幅提升,动辄达到数百亿、数千亿,甚至万亿参数。这需要云计算公司根据 GPU 特点和大规模并行计算的网络特性建立新型计算体系,这包括:

训练和使用参数多的大模型时,只有几块 GPU 不够,得把大量 GPU、服务器等算力节点组成一个庞大的算力网络。这需要新的网络架构。用算力网络训练、调度大模型时,还需要存储、处理海量数据。这需要更大的内存带宽和文件存储系统。对开发者和企业用户而言,希望更简单地调用 AI 算力,屏蔽底层硬件复杂管理,自动匹配不同应用环境。这需要新的容器技术及系统服务。

过去两年,AWS、Google Cloud、微软 Azure、阿里云等云计算平台,都投入了大量资源建设新型计算基础设施。据红杉资本估算,今年科技行业投入规模会达到 6000 亿美元。

得益于大公司积极建设基础设施,大模型也在迅速发展:大语言模型的参数从千亿增长到万亿,融合语音、图像、文本的多模态模型成为热门趋势,生成图像、视频的模型不断迭代,大模型也进入自动驾驶、机器人等领域,触达物理世界。每一个变化,都需要计算基础设施跟着优化。

在云栖大会上,周靖人介绍了一批阿里云 AI 基础设施的升级:

磐久 AI 服务器可以支持单机 16 卡、显存 1.5T,提供 AI 算法预测 GPU 故障,准确率到 92%;高性能网络架构 HPN7.0 可支持 10 万个 GPU 稳定互连,模型端到端训练性能提升 10% 以上;CPFS 文件存储的数据吞吐 20TB/s,为 AI 智算提供指数级扩展存储能力;人工智能平台 PAI,可以实现万卡级别的训练推理一体化弹性调度,AI 算力有效利用率超 90%。

阿里云 CTO 周靖人介绍的阿里云 AI 基础设施。

“云优化一点,大模型才能发展一点,模型发展到一定程度又遇到挑战,又需要云去升级。” 周靖人去年曾说。“大家表面上看到的是一句 ‘AI 的基础设施’,但中间有很多重要创新。正是这些重要创新,才让大模型的训练、大模型的创新变成了可能。”

行业领先的大模型公司都离不开云基础供应商,比如 OpenAI 与微软 Azure 绑定,Anthropic 拿了 AWS、Google 的投资,国内多个大模型公司都拿了阿里的投资。它们借助云计算公司的基础设施训练更强的大模型时,反过来也推动云计算基础设施迭代。今年 6 月,零一万物 CEO 李开复说,阿里云为零一万物的大模型训练提供了很多帮助,还组成了专业小组来保证训练的稳定性。

大型科技公司的基础设施投资竞赛还会继续。高盛今年 6 月发布报告称,科技巨头和其他公司未来几年还会投入上万亿美元,用于采购芯片和电力资源,建数据中心。

以开源、降价激发需求,建立规模效应

建好基础设施只是云计算公司业务的起点。云计算是典型的规模越大、效益越好的生意,只有获得大量客户,云计算公司才能收回早期建设基础设施的投入、获得利润,建立竞争优势。所以许多云计算公司发展多年,还处于亏损状态。

在大模型时代,所有的云厂商都处于建立规模效应的早期阶段。红杉资本合伙人大卫·卡恩(David Cahn)在一篇文章中写道,就算慷慨地假设 Google、微软、Meta 等公司每家一年能获得 100 亿美元新的 AI 收入,甲骨文、阿里巴巴、字节跳动、腾讯等公司每家获得 50 亿美元,从投入到收入的缺口还有 5000 亿美元。

补足缺口的关键是加速下游模型用量增长。在云栖大会上,阿里云展示了吸引客户使用大模型基建的多个动作。

首先是开发一批更强的大模型。周靖人昨天发布阿里最新的旗舰模型 Qwen-Max,称在多个数据集上的评测结果超过或接近 GPT-4o。同时,他们升级针对不同场景开发的大模型,比如数学领域的 Qwen-Math、编程领域的 Qwen-Coder、具备视觉理解能力的 Qwen-VL,以及生成图片的通义万相 Wanx,还新增视频生成功能。

阿里云是中国大模型开源力度最大的大型科技公司,开源战略仍在持续。据周靖人介绍,当前阿里云开源的 Qwen 系列大模型,下载量突破 4000 万,衍生出超过 5 万款大模型,成为仅次于美国 Llama 的模型群。

云栖大会上,阿里云开源最新的大模型 Qwen 2.5 系列,囊括 0.5B 到 72B 的不同参数版本。在周靖人看来,参数 3B 及以下的模型和能够理解视觉的 Qwen-VL,将能够扩大大模型的应用范围,前者能让大模型在终端硬件中运行,后者可以让硬件具备理解物理世界的能力。

过去两年,阿里云还在持续搭建开源模型社区魔搭,目前已经上架上万款各类开源模型供开发者下载,开发者数量超过 690 万。

在这些大模型的基础上,阿里云用两种方式把它们产品化,降低客户使用门槛:

一方面开发百炼平台,向企业客户和开发者提供大模型服务。百炼平台中内置提示词优化、检索增强生成(RAG)、模型微调等一系列工具,让那些对开发大模型应用有兴趣、有需求的客户,只在阿里云就能调用多种模型开发和部署产品。

“(客户)不需要关注模型背后的 GPU 资源,不需要去关注如何去拉几个模型。只需要一个简简单单的 API,就可以随心所欲调用模型。” 周靖人说。

阿里云还开发了各种面向个人消费者的大模型应用,比如辅助编程的通义灵码,辅助语音转写总结、阅读长文档、生成 PPT 等功能的多种 AI 助手。

阿里云扩大需求的另一个举措是持续降价。今年 5 月以来,中国的大模型公司开启一轮价格战。当时阿里云把对标 GPT-4 的 Qwen-Long API 输入价格降到 0.5 元 / 百万 Tokens。现在阿里云再次降价,幅度达到 85%,同时给新用户赠送 5000 万免费 tokens 和 4500 张图片生成用量。

“相对未来庞大的应用来说,今天的价格还是还太贵了。大量开发者无法有效、大规模使用。” 周靖人说,只有降低价格,才能推动 AI 应用爆发。

这些阿里云过去来两年持续推进的措施,已经发挥部分作用。据阿里财报,过去几个季度,阿里云 AI 相关产品收入持续三位数增长,在其公有云收入中的占比持续提升。在阿里 7 月的财报会上,吴泳铭说,借助 AI 驱动,阿里云的整体收入将在今年四季度恢复两位数增长,此后会逐步加速。

周靖人说,当前一共有 30 万企业客户接入了通义大模型。其中不仅有对大模型更热情、大众容易感知到的移动互联网客户,如微博、携程、喜马拉雅等;还有饮料公司三得利(中国),以及中国一汽、联想、OPPO 等制造业公司。也有一些公司与阿里云合作建设智算中心,训练大型 AI 模型,如阿里云透露,阿里云与小鹏在乌兰察布合作建设的数据中心,2022 年以来,规模已扩大了 4 倍。

吴泳铭所说的 AI 接管数字世界,改变物理世界的趋势已经有了迹象。

面对大模型,投入不足的风险更大

今年是阿里云成立的第十五年。它的起点是阿里巴巴替代成本不断扩大的 IT 设施。当时在海外已经有一批科技公司开始建立公共云计算平台,但国内还没有达成共识——不乏有互联网、科技公司高管抛出 “云计算是新瓶装旧酒”“还需要很长时间才能普及” 或者 “私有的算力中心才是重点” 的论断。

后来的故事是,阿里云借助早期大额投资,抓住 2015 年前后在中国兴起的移动互联网创业浪潮,成为中国云计算市场第一,并持续到现在。

在吴泳铭看来,生成式 AI 创造的价值,可能是移动互联网连接价值的十倍、几十倍。他认为,过去三十年,互联网浪潮的本质是连接,互联网连接人、信息、商业和工厂,通过连接提高世界的协作效率。生成式 AI 则让世界有了统一的语言——Token。AI 模型可以把物理世界数据的 Token 化,理解真实世界的方方面面,从而模仿人类执行物理世界的任务,这将带来新的产业革命。

等到生成式 AI 应用爆发,作为基础设施供应商的云计算公司显然会从中获得更多收入。而且对于阿里云等中国的云计算公司来说,生成式 AI 还能改变公共云计算在中国市场的前景。

此前多年,中国云计算公司并不像 AWS 那样,公共云客户遍布各行各业,囊括美国证券交易所、大型石油公司、银行业巨头等。中国各个行业的大公司 “习惯于自己掌控” 基础设施,让云服务商从采购服务器建机房开始做起,最后才是软件解决方案。它们服务的不同客户之间的技术复用程度很低,难以降低边际成本。

现在这些客户想要从头建立生成式 AI 基础设施、训练大模型,需要投入更多资源。“全世界先进模型竞争的投入门槛,将达到数十亿、数百亿美金的级别。” 吴泳铭说。这意味着,在生成式 AI 时代,中国公共云计算平台的重要性会大幅提升。

去年 11 月,吴泳铭接任阿里云董事长兼 CEO 两个月后,就在内部明确 “AI 驱动、公共云优先” 的战略。阿里云持续建设大模型基础设施的同时,饱和式投入大模型——模型层面,除了自研大模型、还开源大模型,投资一批大模型公司;产品层面,除了开发为开发者、企业服务的百炼平台,还开发一批面向消费者的大模型助手。

阿里云的目标很明确:不在迟疑中错过新一轮的技术革命。正如 Google CEO 桑达尔·皮查伊(Sundar Pichai)所说,面对大模型,“投资不足的风险,要远远大于过度投资的风险,哪怕事实证明我们是过度投资。”

相关推荐

阿里云饱和式投入 AI,不想在 “迟疑中错过变革”

芯片过热?一场芯片供应链的饱和式救援

喂不饱的AI四小龙

阿里云回应:“公共云优先”不意味着放弃政企市场

阿里年报披露变革一年成绩单:海外电商收入破千亿,阿里云利润增长49%

阿里CEO吴泳铭:阿里云专注AI和公共云,云智能集团仍保持独立公司运作

阿里云CTO周靖人:全面投入升级AI大基建

独家 | 阿里云组织架构调整,大刀阔斧推进“AI驱动、公共云优先”战略

阿里云张勇:“AI云服务需求非常旺盛,增量机会刚刚开始释放”

变革一年后,阿里赌注抬升

网址: 阿里云饱和式投入 AI,不想在 “迟疑中错过变革” http://www.xishuta.com/newsview125514.html

推荐科技快讯

- 1问界商标转让释放信号:赛力斯 95189

- 2人类唯一的出路:变成人工智能 20955

- 3报告:抖音海外版下载量突破1 20863

- 4移动办公如何高效?谷歌研究了 20120

- 5人类唯一的出路: 变成人工智 20111

- 62023年起,银行存取款迎来 10313

- 7网传比亚迪一员工泄露华为机密 8466

- 8五一来了,大数据杀熟又想来, 8395

- 9滴滴出行被投诉价格操纵,网约 8017

- 10顶风作案?金山WPS被指套娃 7219