大模型热潮,会是一场泡沫吗?

“天体的运动可以计算,但民众的疯狂无法计算。”

这句话来自经典物理学之父,艾萨克·牛顿。1720年,南海股票市值暴涨,民众对股票市场充斥着狂热情绪,牛顿同样也参与其中。他以每股120英镑的价格买入,并以270英镑的价格卖出,最终获取了投资额两倍的利润。

短短几个月后,因为难抵持续上涨的股价诱惑,牛顿以600英镑每股的价格再次买入,并计划在1200英镑时卖出。他充满信心,但事与愿违。在不到一个月的时间里,南海公司股价在触及1000英镑的高点之后一路狂泻,即便英格兰银行下场救市,也没能阻止它跌到135英镑的价格。这一次,牛顿损失了20000英镑并割肉离场。按照购买力平价理论,他的损失约合如今的几百万英镑。

这是有史以来的第一次股票泡沫。这个故事显示,即便是智商高达190的牛顿,也难以抵抗短期的行业热潮带来的非理性投资冲动。

在这些历史上一再出现的行业泡沫面前,无论是天才如牛顿,抑或是普通民众,都是无可争议的受害者:在百年难见的变革和机会面前,他们在膨胀的泡沫面前,都认为这是未来,市场便因这些希冀而膨胀,进而偏离了客观的资产定价。

自ChatGPT推出以来,人工智能的快速发展伴随着无尽的争论。大把的业内人士通过各种方式告诉周围的人:这一次,技术真的将改变我们的世界。

当然,跟资本市场的投资泡沫不同,这波大模型的热潮,拥有汗牛充栋的论文以及雨后春笋般涌现的模型作为支撑框架,并且已经有初步的商业落地和产品应用。

但在短短两年时间里,无论是前端投资,还是中后端的模型和产品,大模型增长速度已经逐渐放缓,高成本和低回报的趋势已然浮现。

我们曾经期待的人工智能行业奇点,是否跟历史上的无数行业泡沫一样,会是短短的昙花一现?

大模型狂潮在冷却?

从最新的公开报道来看,来自Meta、OpenAI、谷歌等科技公司的人工智能革新,仍然在不断推进,但就其产品的“革命性”而言,早已不如2022年底鸿蒙初开时来得惊艳。

以OpenAI为例,早在今年二月,其文生视频模型Sora已经以论文的形式发布。但时至今日,获得内测资格的用户,仍然是少量官方钦定的艺术家——除了OpenAI的官方账号会时不时更新基于Sora的艺术作品,普通用户难有直接使用Sora生成内容的机会。

而根据CNBC的最新爆料,时至今日,Sora模型还处于研究阶段,今年内可能无法推出。

换言之,被认为是2024年AI最新方向的“文生视频”,其主要玩家的主要产品,仍然处于“电子期货”的状态。而作为其主力产品的GPT-4发布已经一年多,下一代产品GPT-5迟迟没有发布的迹象。

取而代之发布的“o1”,根据奥特曼的说法,是一个可以进行通用复杂推理的人工智能。

在o1输出回答前,会产生一个很长的思维链条,来给出推理的答案。链条越长,推理效果越好。其中一个例证是,在此前的2024 IOI信息学奥赛题目中,o1的微调版本在每题尝试50次条件下取得了213分,属于人类选手中前49%的成绩。如果尝试次数足够多,时间足够长,拿到金牌的难度也并不算大。

需要指出的是,o1模型看起来更好的推理效果,是用更贵的价格和更慢的反应速度换来的。具体而言,o1模型的API调用价格,在每百万token输入15美元,输出则在60美元,相较于GPT-4o 5美元输入和15美元的输出,分别存在3倍和4倍的价差。虽然能实时显示推理链条,但其反应速度也降低到了十几秒的级别。

且不论这种模型能力是否有过剩的可能,单看其模型用途,它最大的能力并不在于解决GPT-4所覆盖的通用型问题——囿于其庞大的推理算力需求导致的高成本,以及纯文字反馈的输出形态,中信证券研报指出:其短期内的应用范围仍然会集中于编程和科研等高价值领域。也因此,在没有足够用户基数的前提下,这个模型在商业角度很难算得过账。

另一个切面则是,生成式AI每一次的产品迭代,其资本增密的速度,已经跟不上技术迭代的脚步。这也导致了部分业内人士,对生成式AI的看法逐渐变得消极。

早在今年三月,阿波罗首席经济学家Torsten Sløk撰文指出,AI泡沫的“糟糕程度”不仅超过了1990年代,还已经超过了互联网泡沫巅峰时期的水平。据IDC预测,2024年全球将涌现超过5亿个智能化应用,这相当于过去40年的总和。

另一个“吹哨人”,红杉合伙人David Chan则在连续两年的时间里发出警告——AI企业年营收总和需达6000亿美元,才能支付基础设施建设资金。而在当下必然不可能。

这些担心反馈到资本市场领域。在2024年8月5日的“黑色星期一”,以英伟达、苹果、特斯拉为代表的科技7巨头,盘初总市值蒸发1.3万亿美元,当日蒸发的市值则为6500亿美元以上。

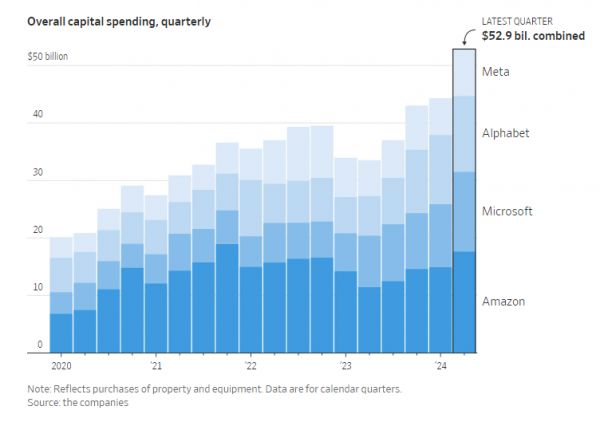

而一级投资市场对于AI相关的投资力度仍然不减。据国外媒体报道,仅就2024年第二季度,亚马逊、微软、谷歌母公司Alphabet和Meta,在人工智能领域的投入就高达500多亿美元。

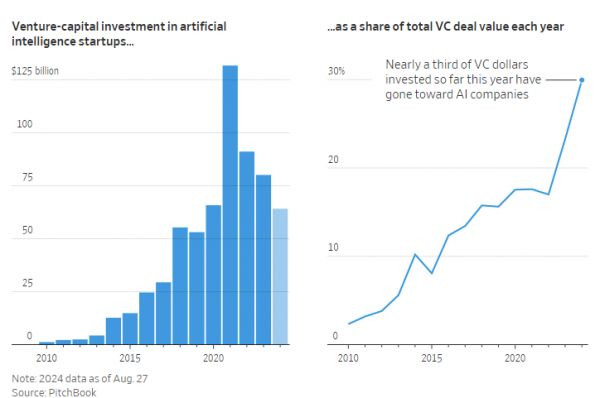

而到目前为止,人工智能创业公司所获得的风投总额,已经高达641亿。2024年至今,仅人工智能领域的投资已经占据全行业一级市场投资的30%以上。

人工智能浪潮的三起两落

回顾人工智能的发展史,从1956年的达特茅斯会议算起,到2016年以来的云计算和算力爆发,一个甲子的两端,分别代表了人工智能第一次浪潮的起点,和第三次浪潮的涌现。

但三次波峰,也意味着出现了两次低谷。这或许对于当下的生成式AI浪潮,也有一定指导意义。

作为计算机科学和人工智能领域的先驱,图灵在1950年发表的著名论文:《Computing Machinery and Intelligence》中,开放性地讨论了“机器能否拥有智能”这一问题。他虽然并未能给出明确定义,但文中提出的“图灵测试”,已经开启了人类探索机器智能的先河。

1956年的达特茅斯会议上,约翰·麦卡锡、马文·明斯基等科学家,在会议上正式定义了何为“人工智能”——“研究、开发用于模拟、延伸和扩展人的智能的理论、方法、技术及应用系统的一门技术科学。通过了解智能的实质,并生产出一种新的能以人类智能相似的方式做出反应的智能机器,人工智能可以对人的意识、思维的信息过程进行模拟。人工智能不是人的智能,但能像人那样思考、也可能超过人的智能。智能涉及到诸如意识、自我、思维、心理、记忆等等问题。”

这一定义的提出,标志着“人工智能”作为独立学科的正式诞生。

但在当时,人工智能的实现条件远比现在困难。其一是硬件条件的限制。在会议召开的时间点,电子计算机仍然是32K内存的晶体管计算机。1962年,当时就职于IBM的阿瑟·萨缪尔在IBM 7090晶体管计算机上研制出了西洋跳棋(Checkers)AI程序,并击败了当时全美最强的西洋棋选手之一的罗伯特·尼雷。

在跳棋AI程序的研发过程中,他第一次提出了“机器学习”的概念,即不需要显式地编程,让机器具有学习的能力。因此,阿瑟·萨缪尔被称为机器学习之父。西洋跳棋AI程序的核心技术,是通过自我对弈来学习评价函数。无论是此后的AlphaGo围棋AI算法和当今深度学习领域非常火爆的生成式对抗网络(GAN)都采用了类似的思想。

这股浪潮一直持续到1970年代,虽然这个时候已经出现了集成电路的电子计算机,但凭借当时已经很强,现在来看十分羸弱的内存和运行速度,并不足以解决任何实际的问题。虽然当时数据库的概念和初期产品已经诞生,但它并不足以支撑人工智能运行所需。而随着计算复杂程度的增加,同样也超出了当年的机能限制——这导致了第一波人工智能浪潮的衰退。

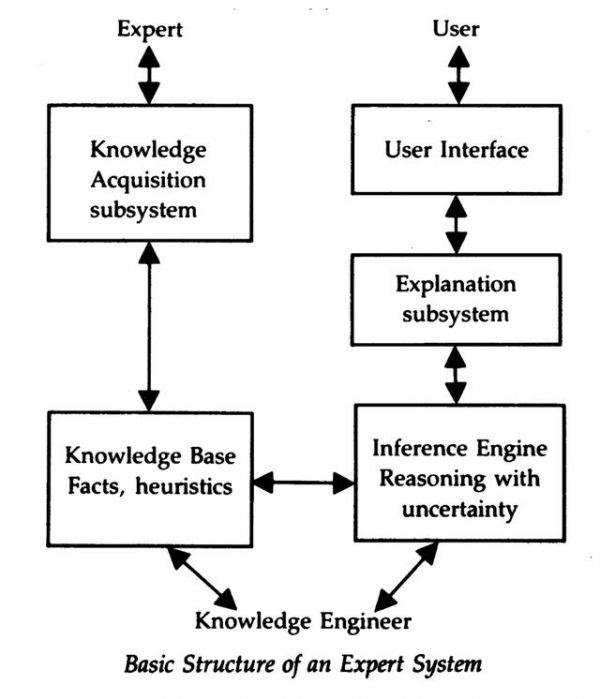

第二次浪潮的兴起,则在5年后——随着拥有大量内存的计算机的出现,知识密集型应用的开发成为可能,以Marvin Minskyzai 1975年提出的框架理论为标志,人工智能开始以框架为单位整合知识,进而实现认知推理。一年后,Randall Davis构建和维护的大规模知识库,让以专家系统为代表的人工智能技术路线,开始大规模涌现。

这一时期的主要特点,则是将知识工程和专家经验,编码到计算机系统中,同时以规则和逻辑推理,来模拟人类专家的决策过程。AI也从偏学术领域转向实际应用。

卡内基梅隆大学的约翰·麦克德莫特于1980年1月提出了第一个专家系统XCON(eXpert CONfigurer)。XCON被数字设备公司(DEC)用于简化其VAX计算机的配置过程。到1987年,XCON处理了大量订单,展示了其影响力和有效性。

这一时期,AI小组的成功案例激增,让很多当时的科技公司跟风成立了AI小组,而个人电脑等终端设备的兴起,也让普通人开始拥有接触并了解AI的机会。直到1985年,共有150家公司在内部AI小组上花费了10亿美元。

1986年,美国AI相关硬件和软件的销售额达到了4.25亿美元,成立了40家新公司,总投资额为3亿美元。这一时期,AI相关的软硬件,主要在称为LISP机器的微型计算机上,运行LISP的相关程序。

第二次AI寒冬的到来,相较第一次更具戏剧性。首先是学术界以外的“无关人士”的疯狂涌入——1980年,美国人工智能协会的首次会议吸引了大约一千名研究人员,而到1985年,随着记者、风投机构、行业猎头和企业家们的涌入,AAAI和IJCAI的联合会议的出席人数接近六千,氛围从休闲装变成了正式装。

其次是硬件系统的替代导致的原有硬件市场崩溃。以第一代UNIX计算机工作站和服务器为代表,这些通用工作站对LISP机器构成了不小的挑战。再后来,Apple和IBM的桌面计算机出现了更简单的架构来运行LISP应用程序,原有的专家机器开始变得过时,原来价值五亿的行业,在一年时间里被迅速取代。

不过,即便这些更先进的硬件更新了LISP程序的运行环境,最终也只起到了“续命”的作用,到20世纪90年代初,大多数商业LISP公司,包括Symbolics和Lucid Inc.,都失败了,德州仪器和施乐公司也退出了这个领域。而“专家系统”一词和独立AI系统的概念,也在IT教材中,变成了过眼云烟。

跟第二次拥有诸多相似之处,第三次人工智能浪潮,同样基于神经网络技术的发展。有所不同的是,第三次人工智能浪潮,更多是多层神经网络的成功。

2006年,Hinton教授提出的深度信念网络,标志着深度学习算法的诞生,它通过构建多层神经网络,使机器能够从大量数据中自动学习特征;强化学习算法,则通过与环境的交互来学习策略,以达到最大化累积奖励;

2012年,AlexNet在ImageNet在大规模视觉识别竞赛中取得显著成绩,标志着深度学习在图像识别领域的突破;

2016年,Google旗下DeepMind开发的AlphaGo人工智能机器人战胜世界围棋冠军李世石,进一步展示了人工智能在复杂策略游戏中的能力。以这些重要突破为历史节点,推荐算法、图像识别、自然语言处理等“识别式”AI,开始占据AI的主流赛道。

与此同时,Apple、Microsoft及Google等国际知名IT企业,都投入大量人力物力财力开展深度学习的研究。例如Apple Siri的语音识别,Microsoft搜索引擎Bing的影像搜寻等等,而Google的深度学习项目也已超过1500项。

当然,以Chatgpt为代表的生成式AI,某种程度上也是第三次AI浪潮的延续。我们并不能妄下断言说这一次浪潮,势必会像前两次有所回落,但它们呈现出来的某些“不可调和性矛盾”,仍然值得去正视与警惕,并进行最大程度的“战术规避”。

大模型的问题

不能否认的是,生成式AI出世至今的一年半时间里,已经在诸多专业领域,展现了令人惊叹的潜力,无论是基于用户的自然语言指令,生成越来越长的高连贯和高逻辑文本,还是以此为基础,生成图片、视频等多模态内容。即便技术路线各有不同,但仍万变不离其宗。

但基于模型内部的“黑盒”属性,其具体的推理过程和模型决策过程,至今仍然难以一窥全貌。这也导致了自生成式AI诞生以来一直困扰从业者和研究者的幻觉问题。幻觉导致的开发资源浪费、审查难度提高,都让AI“飞入寻常百姓家”的翅膀,加上一道枷锁。

幻觉问题的产生,很大程度源于大语言模型的工作机制。AI技术的本质在于对语言的概率模型预测,通过庞大的训练数据对下一个token进行推测。当这种生成机制不足以捕捉复杂的上下文关系时,模型就可能毫无根据地生成显著偏离事实的信息。

如果放在文字生成领域,可以是生成结果的不知所云,如果是图片生成领域,则是生成了预料之外的要素”,导致整个生成图片的“古神化”。

也正是因为幻觉问题的存在,美国纽约大学心理学和神经科学名誉教授加里·马库斯(Gary Marcus)认为:“(目前)人工智能系统的智能化程度并不高。他指出,目前人工智能工具中经常被吹嘘的神经网络与人类大脑神经网络的功能完全不同;

虽然人工智能机器可以进行反射性统计分析,但它们几乎不具备有意推理的能力。虽然这些机器可以学习,但这种学习主要围绕单词的统计和对提示的正确反应;它们并不学习抽象概念——而且与人类不同,它们没有内部模型来理解周围的世界。

马库斯说,通用人工智能最终可能会实现,但今天我们离它还很遥远,再多的投资也不可能改变这一现状。

除了幻觉,人工智能也有另外一个问题——随着模型需要解决问题的多元化和专业化,剩余的可用作数据集的训练数据,正在变得越来越少。

《经济学人》此前在一篇题为《AI firms will soon exhaust most of the internet’s data》的文章中指出,大语言模型(LLM)的发展,高度依赖于互联网数据——它通常的训练模式,并不是预测哪个词最能描述图像的内容,而是根据周围的其他单词,来预测一段文本中缺失的单词。

基于这种训练模式,它不需要人工标记和数据清洗,它能在被称为“自我监督训练”的过程中,删去待预测单词,对其进行猜测,并根据接近与否,给最终答案打分。

从训练过程也能发现,这对于训练文本量的要求极其之大——随着系统训练量的上升,其模型效果就越好。在目前互联网数十万亿字的存量文本面前,模型和它的关系,一如游戏《Minecraft》里的矿脉和矿工。

但随着模型能力的扩张,互联网文本线性增长的速度,很难满足呈指数级别增长的模型样本量。据研究公司Epoch AI估计,最迟到2028年,互联网上的高质量文本将全部被使用。

第三则是生成式AI训练涉及到的版权问题。用于训练大语言模型的高质量数据集,通常有对应的版权,如果没有签署对应的版权合同,则很难合法获取对应的高质量训练集。譬如在2024年5月,OpenAI就宣布与新闻集团旗下媒体如《华尔街日报》达成合作伙伴关系,以5年2.5亿美元现金的代价,获得旗下文章的访问权,并用于大模型训练。

而视频生成模型Sora,使用的视频训练数据则来自YouTube,从《纽约时报》的报道来看,OpenAI在使用来自YouTube的数据时,并未经过授权。这显然导致了严重的潜在法律风险。某种程度上,Sora正式版至今仍未上线,很大程度上跟预训练视频内容的知识产权归属纠纷,有着较为密切的关系。

结语:正视大模型的长期价值

当人工智能的历程走过一个甲子轮回,我们可以从历次浪潮中发现,尽管每一次技术奇点都让AI的智能程度更进一步,但伴随其间的,往往都是业界内外的非理性预期以及与实际价值严重背离的社会追捧。

但大模型并非是一个资金进入两三年,便能“万丈高楼平地起”的行业。实际上,它仍然是一个重资产、长周期的“慢行业”,底层模型只是其最基础的拼图。

对于技术,人们常犯的一个错误是:高估它的短期价值,却又低估它的长期价值。

以互联网的发展史类比,初代电子计算机出现于上世纪40年代,个人电脑的出现在40年后,Windows操作系统的出现,则还要等10年;互联网的初代版本——万维网和网景浏览器的出现时间,是1990年代,到第一个可验证的互联网广告模式出现,并有公司以此盈利,还需等到下个世纪,其间又是近20年。而这已经是相对“轻资产”的行业。

但同样是互联网行业,只需一部类似苹果手机的终端,一种类似互联网广告的商业模式,就能带来旷日持久的巨大变现可能。

一旦有类似模式在生成式AI中出现并得到验证,其商业价值的规模和想象力,或许也是前所未有的。

相关推荐

大模型热潮,会是一场泡沫吗?

自动驾驶需要一场泡沫

AI是下一场“互联网泡沫”?谈谈大模型发展的三个瓶颈

朱啸虎VS傅盛:大模型的终极形态会是什么样?

大模型热潮,救不了AI融资趋势

AGI市场,必然要迎来一次泡沫吗?

具身智能离现实有多远:热潮、泡沫和商业化

大模型前传:一场拍卖会与巨头间的人才战

大模型,一场骗局

医疗大模型,有出路吗?

网址: 大模型热潮,会是一场泡沫吗? http://www.xishuta.com/newsview125756.html

推荐科技快讯

- 1问界商标转让释放信号:赛力斯 95124

- 2人类唯一的出路:变成人工智能 20535

- 3报告:抖音海外版下载量突破1 20375

- 4移动办公如何高效?谷歌研究了 19720

- 5人类唯一的出路: 变成人工智 19648

- 62023年起,银行存取款迎来 10272

- 7网传比亚迪一员工泄露华为机密 8400

- 8五一来了,大数据杀熟又想来, 8039

- 9滴滴出行被投诉价格操纵,网约 7662

- 10顶风作案?金山WPS被指套娃 7184