上手尝鲜苹果智能:ChatGPT负责Intelligence,Apple负责失望

我有一台可以用Apple Intelligence的iPhone 16pro,懂苹果的人都知道这里面的门道有多深。

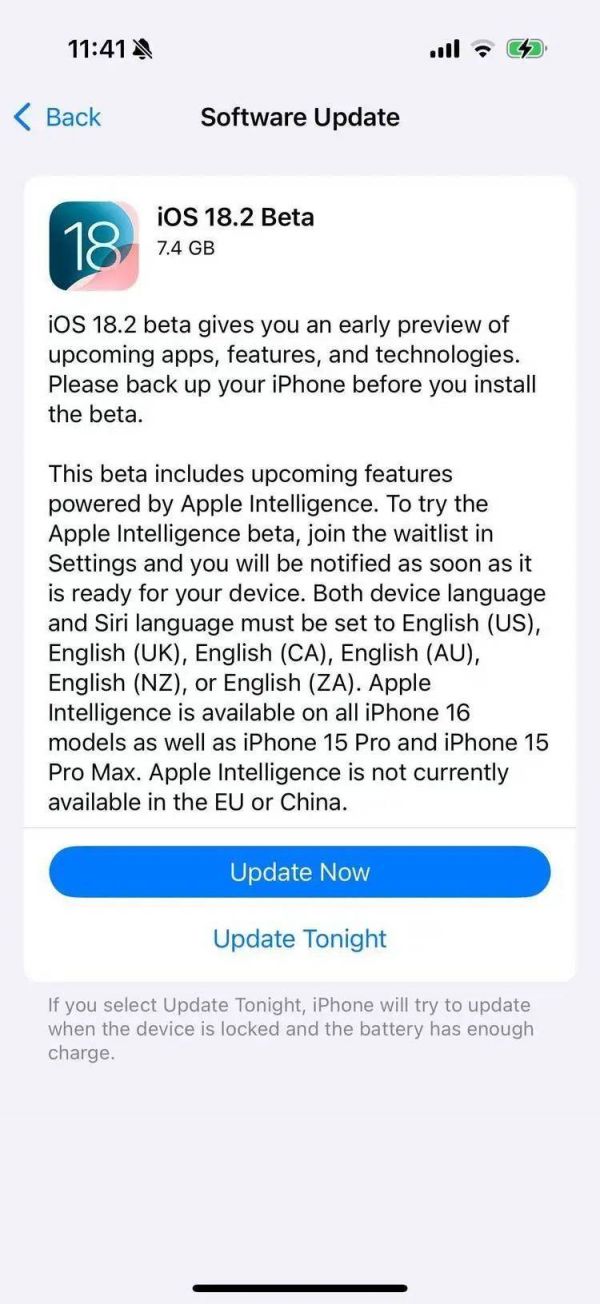

于是在10月24日苹果推送iOS 18.2的首个开发者测试版后,我第一时间下载体验了这个最接近正式系统的版本。

这也是苹果首次推送有ChatGPT的Apple Intelligence。

当一切就绪,我体验了这次推送里的几个核心功能,也是苹果此前发布Apple Intelligence时重点画饼的功能:更聪明的Siri、笔记应用里的ChatGPT辅助写作、“相机按钮”长按唤起的Visual Intelligence和我最终并没有体验的AI画图功能

一、“更聪明的Siri”

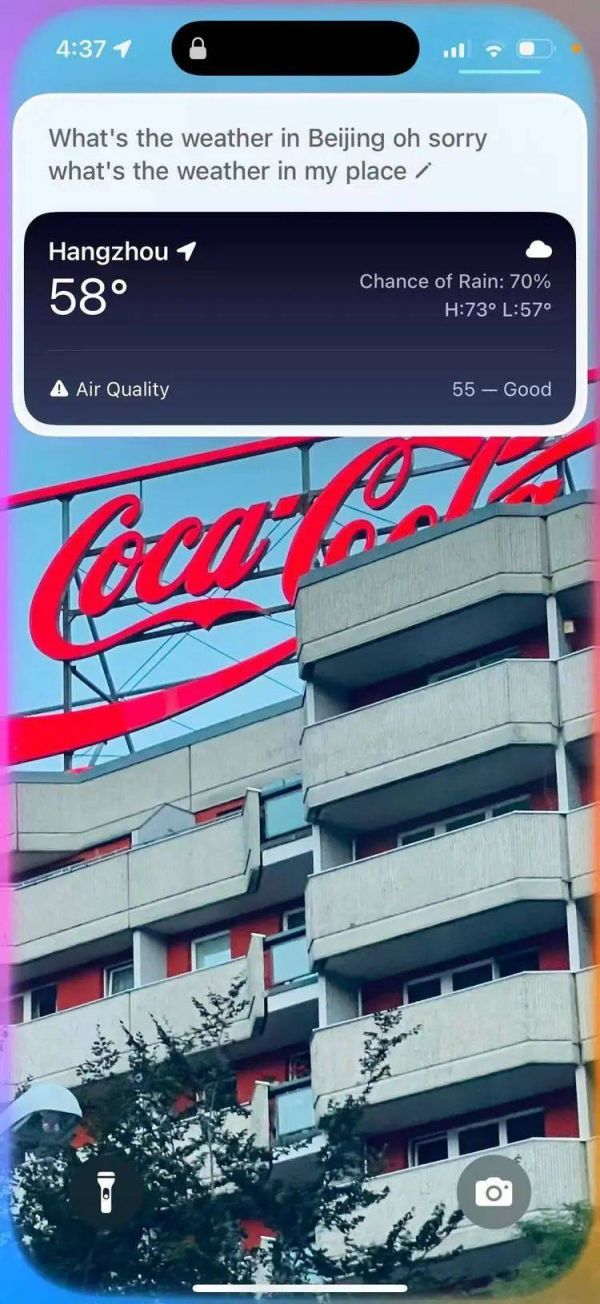

在Apple Intelligence里,Siri可以只通过叫它“Siri”唤起,而唤起时整个屏幕会有一个动画效果,像是被一道彩虹波纹划过,屏幕也会跟着微微颤抖几下。

您目前设备暂不支持播放

当你用语音唤醒,波浪从底部荡起。

您目前设备暂不支持播放

当你用开关键唤醒,波浪从右侧荡漾开来。

你基本可以在任何界面随时唤起Siri。

这是个初看很高级的效果,不过也已经在此前的一些iPhone之间的触碰交互上出现过。

我试了试用语音让Siri打开一些app,完成截屏,“帮我写一个笔记,内容是xxx”,它都可以快速响应。已经有了调用和直接操作app,尤其是自带的app的能力。

而且,你现在可以跟Siri对话时说得更自然,比如我在询问天气时,说错了地名然后改正,它也可以理解。

但目前跨app的能力依然有限。

我尝试让它把正在播放的音乐分享给朋友,它回答:我做不到,我只能分享截屏,然后自顾自截取了屏幕,问我,分享给谁。

您目前设备暂不支持播放

这就让现阶段更能够体现Siri更聪明的那些地方,都来自它首次可以调用的ChatGPT。

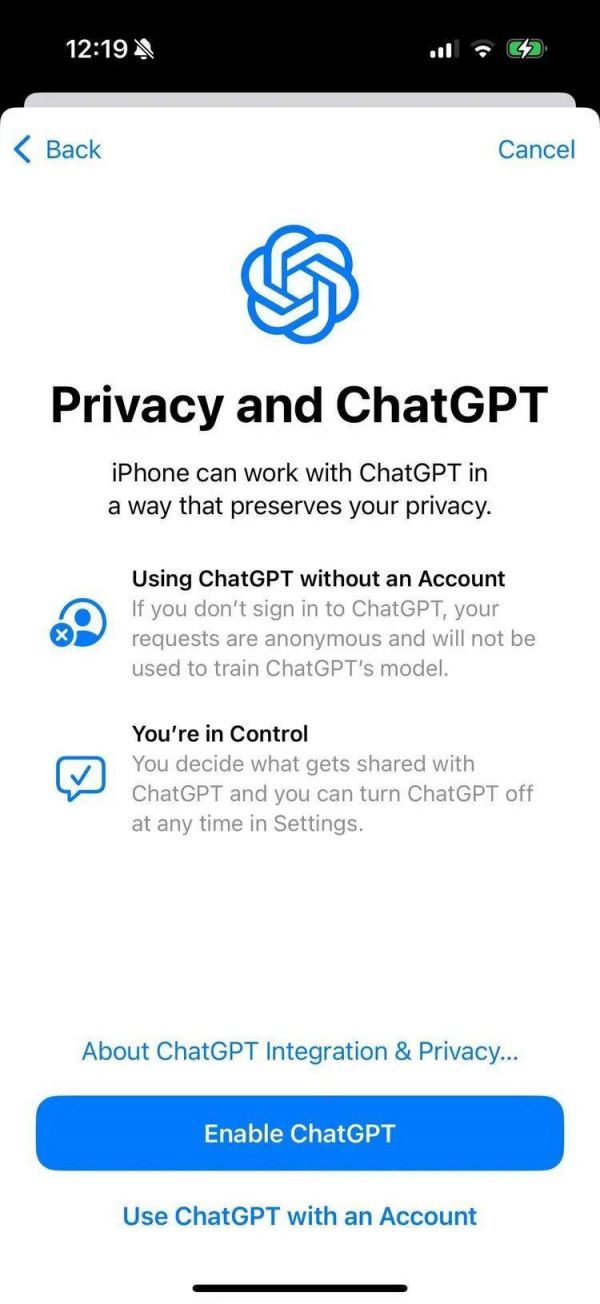

你不需要有ChatGPT的账号,就可以在Siri里使用它。当然,你也可以登陆你的账号,来留存记录。没有账号似乎更符合苹果的宣传:在隐私层面更加安全。

ChatGPT提供的基本上是一个低配版GPT-4o的功能,你可以语音问它,然后它会回答。比如需要提供菜谱,提供旅游计划等。(这几个是我看一些开发者体验时用的例子,我也试了试,试的过程我一直在想,我为什么不打开ChatGPT去里面完成这些任务呢?)

而且,当你只是召唤Siri时,Siri也会主动问你是否要请ChatGPT帮忙。或者你也可以直接说:Siri,ask ChatGPT。

对,走到库克家门口敲门让库克出来然后告诉他,请帮我去找Sam Altman的即视感。

当我让Siri完成一个任务:识别我屏幕上的内容然后告诉我更多的信息时,它问我,可以把截图发给ChatGPT么。然后它发送了截图给ChatGPT。ChatGPT完成了回答。

但这类任务的稳定性有些奇怪,有几次ChatGPT又说它无权处理截图。

而在我让它完成另一个任务时——识别我在听的歌,然后告诉我更多关于这首歌的信息,基本证明了,苹果没有给ChatGPT直接接触系统的权限,所以链条变成Siri听、识别,然后问我:可以发给ChatGPT帮忙么,然后ChatGPT出现。

我还试图完成一个任务,通过语音让Siri把默认搜索改成Google。这其实是一个典型场景——用自然语言来完成手机的设置。但Siri先是问我是否可以请出ChatGPT帮忙,然后请出ChatGPT,给了我一个如何改设置的网络搜索答案。

这种让人无语的操作背后,苹果的纠结更加明显了——它似乎默认了ChatGPT是更聪明的那一个,遇到稍微复杂的难题就要找它,但同时,它又处处防着ChatGPT,不给它在自己地盘上完全施展的空间。

于是,ChatGPT显得很智能,而苹果在里面参与的一切,都显得让人有些失望。

而且,这种纠结会持续下去,此前苹果强调的隐私,与ChatGPT强调的用户数据都要拿来训练模型之间的冲突如何解决,看起来也会是个更大的问题。

二、笔记应用里的ChatGPT辅助写作

笔记里的AI写作功能基本都由ChatGPT提供。

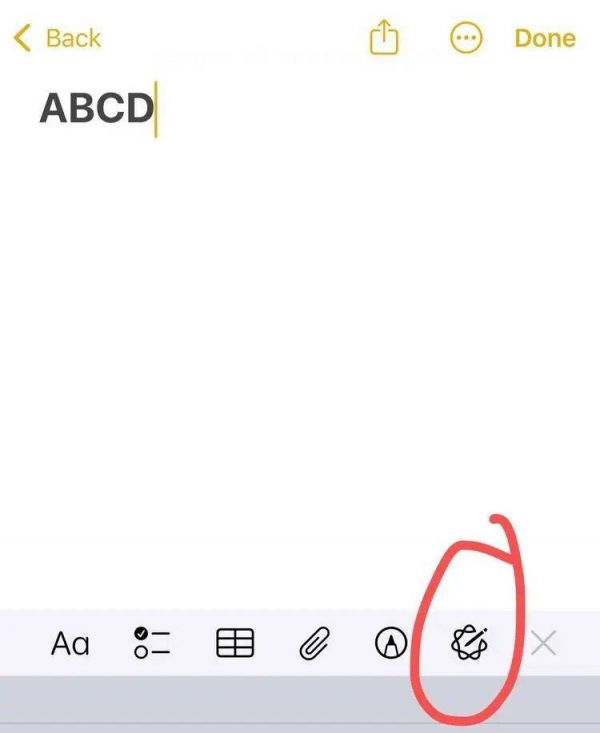

在下端的工具栏,有一个专门的按钮。

点击后出现一个新的AI操作界面。说实话,也不太好看,因为和整个app完全是不同的风格,给人感觉是一个外来的强加的角色被唤醒了。

您目前设备暂不支持播放

它的功能也很基础,比如所有AI写作都有的那些:改写,修正检查,输入你的Prompt等。除此之外,它还有总结、整理要点等模板功能,点击后出现的结果不会在输入区域,而是在这个操作板下方。

所以,显得很拥挤。

而且,在UI上,AI写作时的效果,像是一个3岁儿童往你的屏幕上贴了个他最爱的blingbling的长条贴纸,下一秒出来的仿佛不是AI写的字,而是小马宝莉。

您目前设备暂不支持播放

我第一次在苹果的实际产品体验上,找到了它那些自我感觉良好的中文翻译给我的诡异感。

三、长按“相机按钮”唤起的Visual Intelligence

iPhone 16 pro系列多出来的那个相机控制按键,在发货后被很多很多人诟病。几乎所有使用过的人都会感慨为了提高拍照体验真的需要一个这东西么。

但看起来就像很多网友替苹果争辩的那样,苹果这个按键不是为了拍照,而是一个AI功能的启动按键。

这个设计在理论上确实很重要。

“按键”在AI硬件时代重新显现出它的意义——它可以减少用户操作步骤,这和大模型带来的交互潜力一致,苹果的思路似乎是:一个“Siri”,一个增加的实体按键,前者对应语音交互,后者对应视觉。这两个是大模型的最重要交互方式,各自必须在手机的机身上就有一个一键触发的入口,避免任何划动屏幕等多余的动作。就一步,这俩AI功能就要立刻开始服务用户。

这里面最关键的是,用户对这俩功能的使用要足够高频,功能本身也要足够强大。

当你长按相机按钮后,就可以进入Visual Intelligence的模式(我甚至怀疑,当人们都放弃用这个键拍照后,它会变成Visual Intelligence的专属键,然后单击、双击、触控划动等都会服务于对应的视觉AI功能)。

在同样的彩虹波浪动效之后,屏幕出现一个拍照按钮和两侧的两个选项:问ChatGPT,和用Google搜。

这几乎完美展示了苹果在AI上的处境——明明是自己地盘上的重要任务,却都交给了别人。

当你点了Ask后,ChatGPT会不管你到底要ask什么,直接给你一个它看到的此刻的图片的看图说话。

接下来是ChatGPT大显神威的时刻。

我拍了一张照,并让ChatGPT基于照片写一篇小作文。它快速做到了。

您目前设备暂不支持播放

这一下子多了很多想象空间。视觉识别后,基于这些信息进行接下来的任务。

而苹果自身则依然有些拉垮,它的跨app能力还是没有发挥作用。我让它复制这篇小作文到笔记应用,它却开始搜索互联网。云端和端侧模型能力的差距看出来了。

还有一个问题是,我也不知道支持Apple Intelligence但没有相机控制按钮的iPhone 15们,要怎么启用visual intelligence。苹果会再单独做个app,还是或者就直接不支持了。总之,阉割的种类又多了。

四、我没体验AI画图功能,因为第一眼就觉得它太不苹果了

看看这个升级后就会自动出现的猫头app的图标,和它的界面。谁会想到它是苹果做的呢。

你可能的确可以用苹果手机做一堆沙威玛传奇那样的图片出来。

但真的想要体验文生图,图生图,甚至图生视频,有比这个app更好的选择。

目前Apple Intelligence还有一些没有推送的功能,其中在此前发布会里最令人期待的就是通过Siri识别iPhone屏幕上正在发生的一切事情,然后基于你的指令帮你完成任务。也就是一个超级Siri agent。

但它会在月底的正式推送中到来么?还是会如苹果说的“分阶段”在未来推送?

没人知道。

同样没人知道的是,苹果的AI团队们是不是把精力都用在了开发这个超级Siri agent上,才让前面这几个苹果自己提供的AI体验有些拉垮到让人失望。

希望是这样的。希望,苹果,大的在后面。不然,这手机迟早有一天要改叫OpenAiPhone了。

本文来自微信公众号:硅星人Pro (ID:gh_c0bb185caa8d),作者:王兆洋

相关推荐

苹果软件主管透露:Apple Intelligence将分阶段推出

Siri接入ChatGPT,苹果首批AI功能即将发布

明年,苹果iPhone可能迎来“ChatGPT时刻”

苹果公布 Apple Intelligence 明年将支持的更多语言

Apple Intelligence中文版明年推出 等一手iPhone 17?

你负责许愿,微软AI负责实现

iPhone 16下月发布 Apple Intelligence变付费项目?

AI功能爽约,苹果并未迎来“高光时刻”

苹果发布会将至,消息称Apple Intelligence将作为新机的宣传重点

观察|“苹果智能”接入GPT,能否从AI竞赛中胜出

网址: 上手尝鲜苹果智能:ChatGPT负责Intelligence,Apple负责失望 http://www.xishuta.com/newsview127256.html

推荐科技快讯

- 1问界商标转让释放信号:赛力斯 94991

- 2人类唯一的出路:变成人工智能 19561

- 3报告:抖音海外版下载量突破1 19300

- 4移动办公如何高效?谷歌研究了 18798

- 5人类唯一的出路: 变成人工智 18666

- 62023年起,银行存取款迎来 10162

- 7网传比亚迪一员工泄露华为机密 8236

- 8五一来了,大数据杀熟又想来, 7158

- 9顶风作案?金山WPS被指套娃 7120

- 10大数据杀熟往返套票比单程购买 7069