光子芯片,助力AI

来源:半导体产业纵横

利用新兴光子解决方案扩展AI性能。

人工智能 (AI)和机器学习 (ML)不断突破传统半导体架构的极限。为了提高速度、降低延迟并优化高性能工作负载的功耗,半导体公司和研究机构正在开发基于光而不是电流原理运行的先进光子芯片。

本文讨论了传统半导体在 AI 和 ML 方面的局限性,例如冯·诺依曼瓶颈和摩尔定律的放缓。它探讨了工程师如何利用光子芯片实现效率和可扩展性,重点介绍了Lightmatter等公司以及麻省理工学院 (MIT)和清华大学等研究机构取得的进展。最后,它概述了Lightmatter如何通过基于云的高性能计算 (HPC)解决方案优化电子设计自动化 (EDA)工作负载。

传统半导体对人工智能的局限性

数据中心和智能边缘中的高性能 AI 和 ML 应用推动了对更快、更具可扩展性的芯片的需求。在数据中心,大量的训练数据集、大型语言模型 (LLM)和深度强化学习 (DRL)突破了计算能力和内存带宽的极限。在边缘,高级驾驶辅助系统 (ADAS)、可穿戴设备、医疗设备和工业 4.0基础设施需要越来越复杂的芯片,以便在更低功耗范围内实现快速实时推理(图 1)。

图 1. ADAS 处理复杂的 AI 工作负载,以实现边缘实时推理。来源:Fundacion Mapfre

图 1. ADAS 处理复杂的 AI 工作负载,以实现边缘实时推理。来源:Fundacion Mapfre同时,研究机构正在推进通用人工智能 (AGI)模型,以实现人类水平的认知能力。与创建新内容的生成式人工智能 (GenAI)或通过反复试验优化决策的 DRL 不同,AGI 将独立适应、学习并完成任务,而无需有针对性的预编程。

然而,人工智能的发展受到摩尔定律逐渐减弱、每个封装的硅面积有限以及先进计算系统不断增长的能源需求的制约。CMOS技术的物理限制(例如7nm以下节点的量子隧穿效应)进一步减缓了传统半导体的小型化和性能提升。

经典的冯·诺依曼瓶颈加剧了这些挑战,内存和处理单元之间的数据传输限制了性能。更大的人工智能模型需要在片外内存和片上计算单元之间频繁移动数据,从而增加了延迟和能耗。异构架构、内存计算和光子芯片等新兴解决方案旨在通过最大限度地减少数据移动并更紧密地集成内存和计算来解决这些限制。

利用光子芯片释放效率和可扩展性

基于光的光子芯片可以为更高效、更可持续的 GenAI、DRL 和 AGI 工作负载提供互补且可行的解决方案。有些芯片在不到半纳秒的时间内完成计算,同时执行多个向量矩阵乘法——这是神经网络中的一项基本运算。虽然光子集成电路 (PIC) 通常产生的热量比传统电子集成电路 (IC) 少,但热管理仍然很重要,尤其是对于有源光子元件和密集集成的设计。

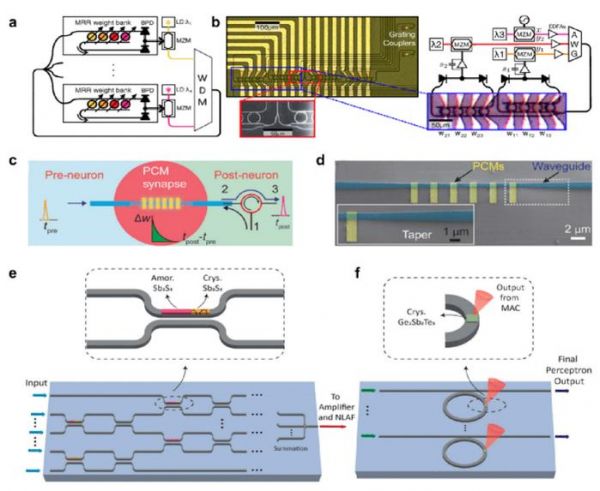

图 2. 光子芯片使用环形谐振器、WDM 和混合光子电子元件来实现用于 AI 工作负载的高吞吐量光学神经网络 (ONN)。来源:MDPI

光子芯片使用波分复用 (WDM)和环形谐振器(图 2)在单个波导内对多个波长的光进行并行计算。这些组件可实现密集信息编码和高吞吐量处理,使其成为许多光子芯片架构的基础。在某些设计中,环形谐振器是将自由空间光强度图像转换为相干光信号以供片上处理的关键,从而无需单独的图像传感器并减少系统延迟。

光子芯片实现了与传统半导体相当的高准确率:训练期间超过 96%,推理期间超过 92% 。通过直接使用光处理数据,一些光子设计可以减少(甚至可能消除)中间存储阶段和对工作内存的需求。同时,先进的架构支持内存或近内存计算。这些创新减少了数据移动,降低了延迟,并提高了 AI 工作负载的整体效率。

光子芯片还擅长在单个芯片上进行并行处理,利用光波同时执行多个计算而不会产生电干扰。

虽然一些光子芯片设计可以使用传统的 CMOS 工艺制造,但许多光子芯片设计依赖于专用材料和高精度技术,这增加了制造复杂性。某些光子芯片与GPU AI 加速器集成,实现了光电混合AI 操作,尽管集成在许多场景中仍然带来重大技术挑战。

利用新兴光子解决方案扩展 AI 性能

许多研究机构和公司正在推进光子半导体技术。例如,牛津大学的科学家展示了一个系统,该系统使用一个具有九个输入通道的部分相干光源以每秒约 1000 亿次操作的速度执行高速 AI 任务。这一突破有可能彻底改变光互连技术。

光子芯片设计的进步使得光学神经网络 (ONN)能够完全在光学领域执行线性和非线性运算。麻省理工学院的光子芯片集成了非线性光学功能单元 (NOFU),结合了电子和光学元件,无需外部放大器即可执行非线性运算。通过在最终读出之前一直保持在光学领域,该设备可以直接在芯片上进行深度神经网络的原位训练,在纳秒级运行时提供与传统硬件相当的性能。

来自不同公司和研究机构的其他新兴光子解决方案包括:

Celestial AI:为AI计算和内存基础设施提供先进的光互连。

ANT:为本机处理单元 (NPU) 提供 PCI Express 卡,其能效比传统 CMOS 技术高出 30 倍。

CogniFiber:使用其 DeepLight 处理器提供高达 1,000 倍的 AI 推理速度,同时显著降低成本、能耗和物理占用空间。

Neurophos:将超高密度、高速光学调制器与平面光学堆栈相结合,以消除互连问题。它使其 OPU 理论上能够以每瓦 300 TOPS 的速度提供 160,000 TOPS — 比领先的 GPU 快 100 倍,效率更高。

Salience Labs:开发用于 AI 应用的混合光子电子开关,强调兼容性、可靠性和可制造性,同时降低大型集群的功率和成本。

波光子学(Wave Photonics):加速跨各种波长和平台的 PIC 的开发。

iPronics:设计可编程光子处理器和无损光开关,以支持低延迟、可重构的 AI 架构。

清华大学:提出ACCEL芯片(图3)。该光电设计采用衍射神经网络进行视觉特征提取,并在单个集成设备上结合了衍射光学计算与模拟电子处理。

图 3. ACCEL 芯片的详细图示。来源:清华大学

值得注意的是,Lightmatter 正在开发具有硅片面积缩小和扩展“前沿”的光子芯片,从而实现整个芯片区域的光学 I/O,以实现高性能互连。该公司利用先进的封装技术,包括将客户芯片 3D 集成到硅光子互连上,以连接高带宽、低延迟域中的数百到数百万个芯片。此外,Lightmatter 还与 GPU 和交换机制造商合作,以支持极端扩展。

使用基于云的 HPC 解决方案优化光子 EDA 工作负载

Lightmatter 使用AWS 高性能计算 (HPC)基础设施上的研究与工程工作室 (RES)来简化光子芯片的 EDA 流程。该开源平台使管理员能够部署预装应用程序和工具的虚拟桌面,以实现协作和数据共享。

Lightmatter 还使用 AWS ParallelCluster 和 Slurm 调度程序管理 HPC 集群。此设置可在远程节点上高效运行并行光子芯片模拟,同时在本地和云资源之间保持一致的环境。其他 AWS 组件(例如用于 OpenZFS 共享存储的 Amazon FSx 和用于自动任务调度的Jenkins )进一步增强了功能。

Jenkins通过检测设计变更、启动工作流程并将结果传递到仪表板和 Slack 频道以获得实时反馈,实现了夜间验证模拟和物理设计流程的自动化。这种集成设置简化了小规模和大规模模拟之间的转换,并优化了设计流程所有阶段的工作流程。

结论

工程师们正在开发使用光而不是电流来处理数据的光子芯片。这些进步旨在满足高性能 AI 和 ML 工作负载的需求。光子芯片通过最大限度地减少数据移动并实现内存或近内存计算,可以减少延迟、优化功耗并提高 AI 和 ML 应用的效率。

*声明:本文系原作者创作。文章内容系其个人观点,我方转载仅为分享与讨论,不代表我方赞成或认同,如有异议,请联系后台。

相关推荐

Nature连发两篇光子AI芯片论文,光子计算时代已至?

中国存储、硅光子芯片重磅突破!

我国成功研制超光子芯片,引领无线通信和AI技术创新浪潮

摩尔定律渐行渐缓,中国光子芯片能否「弯道超车」?

研发光子计算芯片,曦智科技完成2600万美元A轮融资

科学家开发出首个通用、可编程、多功能光子芯片

36氪首发|「图灵量子」完成数亿元Pre-A轮融资,正规划国内首条光子芯片中试线

台积电正在押注的硅光子,到底是什么?

趋近0能耗,国外开发出新型光子芯片,A股概念股出炉

光电集成芯片有望助力解决“芯片之痛”

网址: 光子芯片,助力AI http://www.xishuta.com/newsview131992.html

推荐科技快讯

- 1问界商标转让释放信号:赛力斯 95042

- 2人类唯一的出路:变成人工智能 20011

- 3报告:抖音海外版下载量突破1 19799

- 4移动办公如何高效?谷歌研究了 19237

- 5人类唯一的出路: 变成人工智 19111

- 62023年起,银行存取款迎来 10206

- 7网传比亚迪一员工泄露华为机密 8318

- 8五一来了,大数据杀熟又想来, 7574

- 9滴滴出行被投诉价格操纵,网约 7192

- 10顶风作案?金山WPS被指套娃 7146