论文研究“AI预测性取向”:化妆等因素并不影响判断

本文转自微信公众号:机器之心(ID:almosthuman2014),机器之心编译

2017 年,斯坦福大学的一篇《深度学习通过面部识别判断性取向超越人类》曾引发了极大争议,其通过 AI 算法仅需“看面相”即可判断一个人是不是同性恋的方法让众人感到一丝恐慌,也让技术研究者们对于算法的偏见提出了很多意见。

最近,来自南非比勒陀利亚大学的 John Leuner 在自己的硕士论文中再次尝试了 AI 识别同性恋的方法,并获得了“更为严谨”的结果。

这项技术可以无视人类的服装、化妆、拍摄角度等变量,实现男性 63%、女性 72% 的准确率。准确率比人类更好,并不再受到受试者种族、国籍的干扰。现在,乔装打扮也不会让你变得更 Gay 了。

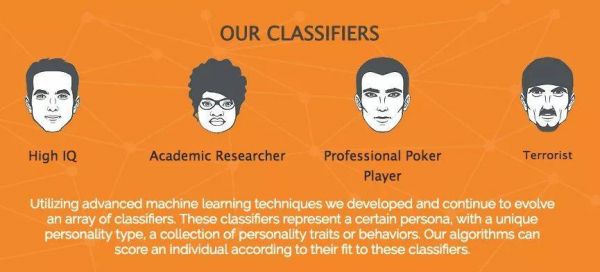

各种人工智能对于面相的判断,不知道图灵若是知道了会怎么想……(图片来源 The Verge)

与此前斯坦福大学的研究不同,在社交网络上人们对于这篇新论文的看法也有不少正面评价:其在判断性取向的时候考虑了人的年龄和种族等其他因素,从而排除了 AI 算法陷入错误认知的问题。

当然,对此研究本身,依然存在着质疑。

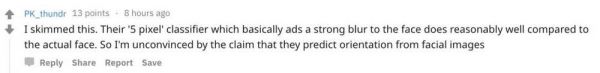

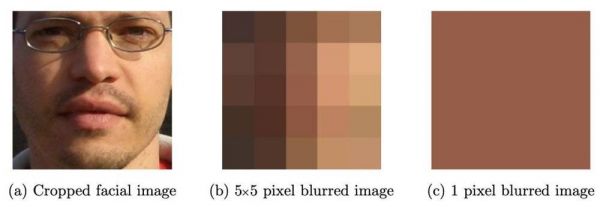

如 Reddit 用户 PK_thundr 浏览完文章表示,“他们的‘5 像素’分类器对高度模糊面部的判断几乎和实际面部一样好。所以,我并不信服从面部图像预测性取向的结论。”

“机器学习预测性取向”一直是一个较为“敏感”的话题。这篇论文的发布,如同 2017 年斯坦福的研究一样也在 reddit 上引起了大家广泛的讨论,感兴趣的同学可查看 Reddit 原帖:

帖子链接:https://www.reddit.com/r/MachineLearning/comments/b0nkeo/r_a_replication_study_machine_learning_models_are/

其实不只是根据面部图像预测性取向的研究,近年来随着人工智能的火热,我们看到了越来越多“匪夷所思”的应用,包括“AI 相面”、“基于面部图像的犯罪概率判断”等等……这引发了人们对隐私、研究可靠性的担忧。对此话题感兴趣的读者,可在此文章下留言探讨。

接下来,机器之心编译介绍了这篇研究论文的相关技术内容,重点介绍了数据集与机器学习模型。

原理

这篇论文遵从前人的思路,试图探索深度学习观察人类面部判断性取向的原理。

Ag¨uera y Arcas 等人对此前斯坦福大学 Yilun Wang&Michal Kosinski 的研究做出了回应,并为他们的发现提供了其它解释。他们没有将根据人脸图像检测性取向的能力与生物起源联系起来,而是认为机器学习模型是根据隐藏在显眼处的表面特征来学习的。通过检查 W&K 发布的同性恋和异性恋男女的合成图像,他们注意到以下明显差异:

合成的异性恋女性面部有眼影,而女同性恋没有。

男同女同脸部图像上都有眼镜,而异性恋者没有。

直男面部毛发又多又黑。

合成的男同脸部比直男更鲜亮,而直女的脸部比女同的更鲜亮。

发型和化妆对于判断一个人是否为同性恋虽然有一定的参考价值,但显然背离了“看面相识别性取向”的原则。这种识别方法明显存在一定偏见。

模型

为了实现更准确的判断,研究人员改进了斯坦福大学研究中的计算机视觉模型,以获得更好的效果。他们提出的模型包含 VGG 和 Face++两种方法。

其中的一部分使用 VGGFace(一个预训练的深度学习神经网络)来提取人脸照片的特征,然后根据这些特征训练了一个 logistic 回归模型来预测目标图像的性取向。

VGGFace 是用来从人脸图像中识别个体的卷积神经网络。它是在一百万张照片上训练的,这些照片来自 2622 个不同的名人。虽然该神经网络最初是为了从人脸图像中识别个体而开发的,但去掉网络的最后一层之后,我们就能获得模型用于其最终分类层的面部特征。

这些由深度神经网络产生的特征对人类来说通常是不可解释的,但可被视为一张人脸的数字表示。该模型获得的输入信息是由 Face++模型提取的面部器官裁剪图像,这些图像会按比例缩小为 224×224 像素分辨率。

模型的另一部分就是 Face++(可作为服务访问的外部模型)来为每张人脸图像提取面部“标记”。然后利用根据这些标记得出的距离来训练 logistic 回归模型,以预测目标图像的性取向。

这些标记是描述面部特征位置的面部度量。Face++为每张脸返回固定数量的标记点。标记分为几部分:

图 1.2:面部形态机器模型用作输入的面部形态“标记”。

上图展示了算法对于人类面部器官的识别点,每个器官由十个或更多点组成,整个面部总共有 83 个点。随后,算法会为每个面部器官建立逻辑回归分类器,并为整个面部的所有器官创建分类。为了预测每个图像中个体的性取向,研究人员使用主成分作为自变量和性取向标记作为因变量训练逻辑回归模型。

下面重点来了,为了减少深度学习的“偏见”,此研究试图探索肤色是否会影响计算机对性取向的判断。为了实现目标,模型会将输入的面部图像简化为 5×5 像素的模糊图,进而进行逻辑回归预测,男性和女性分别建模。

数据集

为训练模型,研究人员总共检索了 50 万张照片并建立了数据集。表 4.1 列出了从每个数据源中下载的每种照片的数量。

表 4.1:从每个数据源检索到的每种照片的数量

本文贡献

本文对社会心理学领域的贡献:

本文复制了先前利用机器学习技术根据人脸照片预测性取向的研究。研究表明,根据约会档案中的照片进行训练的深度学习分类器和面部形态分类器都能够预测性取向,而且做得比人类更好。该模型利用了不受种族或国家限制的新数据集。

本文引入了新的机器学习模型,用于测试能否对高度模糊的人脸照片进行性取向预测。结果表明,根据高度模糊的人脸照片中面部和背景的主要颜色信息能够预测性取向。

研究表明,故意改变一个人的外表以迎合同性恋和异性恋的刻板印象并不会改变由机器学习模型生成的性取向标签。

研究表明,头部姿态与性取向无关。

研究表明,不管添加或是去除面部毛发和眼镜,模型都能预测性取向。

论文:A Replication Study: Machine Learning Models Are Capable of Predicting Sexual Orientation From Facial Images

论文链接:https://arxiv.org/abs/1902.10739

最近的研究使用机器学习方法根据人脸照片来预测一个人的性取向。

为了验证这个结果,我们重新做了其中的两个模型:一个基于深度神经网络(DNN),一个是基于面部形态学(FM)。使用来自约会网站的 20910 张照片组成的全新数据集,确认了两个模型预测性取向的能力:DNN 预测男性性取向的准确率为 68%,女性 77%;FM 预测男性性取向的准确率为 62%,女性 72%。

为了调查亮度、主要颜色这样的面部特征是否会影响性取向的预测,我们创造了一种基于高度模糊面部图像的全新模型。这个模型也能够预测性取向(男性 63% 准确率,女性 72%)。当主体刻意化妆、戴眼镜、面部毛发遮挡、变换面部拍照角度时,测试发现模型对这些变化保持稳定。

这说明,拍照角度与性取向判断无关。同时证明,约会简照包含丰富的性取向信息,这引起的一个问题是:预测结果有多少是由面部形态决定的,有多少是由衣饰、展示角度和生活方式决定的。新技术的出现让我们能够以这种方式检测性取向,而这可能对同性恋者的隐私与安全产生极大影响。

相关推荐

论文研究“AI预测性取向”:化妆等因素并不影响判断

AI能判断性取向?不服气的我做了个实验,结果……

除了菊纹识别,AI还有哪些奇奇怪怪的识别能力

研究你为啥看着淘宝想剁手,阿里达摩院论文登上NeurIPS 2019

728对双胞胎研究发现:发热嗅觉丧失等新冠症状受遗传影响

微软麻将 AI 论文发布,首次公开技术细节

新研究表明,“高薪高学历”职位受AI影响反而最大

AI可以如何抗击新冠?WHO论文告诉你这三大场景大有可为

MIT脑洞研究:只听6秒语音,AI就知道你长什么样

AI不能“取代”医生给我们看病,这并不是因为AI不够强大

网址: 论文研究“AI预测性取向”:化妆等因素并不影响判断 http://www.xishuta.com/newsview1494.html

推荐科技快讯

- 1问界商标转让释放信号:赛力斯 95228

- 2人类唯一的出路:变成人工智能 21183

- 3报告:抖音海外版下载量突破1 21148

- 4移动办公如何高效?谷歌研究了 20339

- 5人类唯一的出路: 变成人工智 20338

- 62023年起,银行存取款迎来 10336

- 7五一来了,大数据杀熟又想来, 8596

- 8网传比亚迪一员工泄露华为机密 8505

- 9滴滴出行被投诉价格操纵,网约 8215

- 10顶风作案?金山WPS被指套娃 7230