特斯拉为什么只跟大货车过不去?是人性的依赖还是机器的失职?

编者按:本文来自微信公众号“汽车之心”(ID:Auto-Bit),36氪经授权发布。

作者 / 姚旭阳

编辑 / 王德芙

自打 2015 年特斯拉开放 Autopilot 软件功能以来,大货车一直是 Autopilot 的噩梦。

看看这些事故:

2016 年 5 月,Model S 车主 Joshua Brown 在 Autopilot 开启状态下,与一辆横穿马路的大货车相撞,Joshua Brown 在事故中死亡。

2019 年 3 月,一辆 Model 3 在美国佛罗里达州开启 Autopilot 时撞上了一台白色拖挂卡车,驾驶员不幸身亡。

今年 6 月初,在台湾嘉义县的中山高速上,一辆 Model 3 也在 Autopilot 开启状态下撞向了一辆大货车。当时大货车并不是在行驶中,而是侧翻在路面。

6 月 24 日下午,在深圳南坪一段道路上,一辆开启了 Autopilot 功能的 Model 3,与一辆并线的大货车发生碰撞。

事故发生时,大货车正从 Model 3 车辆右前方并线进入本车道,Autopilot 没有减速,Model 3 车主事后反馈:在前车并线时,Autopilot 反倒加速撞向了大货车。

事故判定结果:大货车全责。

在 6 月底的事故发生后,当事的特斯拉 Model 3 车主刘先生在多个渠道提出了对特斯拉 Autopilot 的质疑。

这也是今天不少特斯拉车主和准车主们想弄清楚的问题——Autopilot 在这次或者这类交通事故中究竟是否存在问题?

01 事故始末

让我们简单还原一下 6 月下旬的这次事故:

24 日下午三时左右,天气晴朗,车主刘先生驾驶着 Model 3 上了深圳南坪快速路。

和往常一样,他开启了特斯拉 Autopilot。在 ACC(自适应巡航)模式下,Model 3 跟在一辆黄色大货车后行驶。

这是一条他平时上下班常走的路线,以往使用 Autopilot 时,系统基本上可以顺利完成自动跟车等驾驶任务,所以他也习惯了将一只手搭在方向盘上。

不过这次,Autopilot 给了他一场惊吓。

就在行驶到一段虚线路段时,Model 3 右前方的车道上大货车开启转向灯,并向 Model 3 车道突然并线。

根据 Model 3 车身摄像头拍摄的视频画面显示,在大货车并线向本车道行驶时,特斯拉依然向前行驶。

几秒后,Model 3 撞上了大货车。

事故责任很快厘清。

从现场照片看,大货车变道时没有避让相邻车道的车辆,碰撞事故发生时大货车车身压在了道路虚线上。保险公司认定为大货车全责。

虽然事故是由大货车造成的,但当事的 Model 3 车主的质疑是:

为什么在大货车并线进入本车道时,Model 3 没有采取减速或制动的避让措施?

Autopilot 是不是根本没有识别到渣土车?

在快要撞上大货车时,为什么 Model 3 还要加速向前冲上去,导致车主没有充足的时间顺利接管车辆?

02 核心争议:Autopilot 是否「失职」?

在最近的一次沟通中,特斯拉官方对这场事故做了结论:

特斯拉华南区总经理向当事 Model 3 车主表示,特斯拉的产品没有问题。

至于 FSD 为什么会撞上货车,官方解释是:「因为路况复杂,驾驶员手没放在方向盘上,没有及时接管。当时所有自动驾驶硬件均正常工作,后台数据没有异常。」

「驾驶员的手没有放在方向盘上」,这点是特斯拉从后台调取数据后做出的判断。

而车主告诉汽车之心,他的手一直握着方向盘,只是不会一直对方向盘施加压力。

有自动驾驶领域的业内人士认为,「感应方向盘太容易被钻空子,属于明显的漏洞。自动驾驶还是得依靠系统功能安全性,而不是限制驾驶员。」

截止到发稿前,此次交通事故的车主仍在就 Autopilot 是否存在问题与特斯拉沟通。

实际上,从视频中的事故情况看,如果换成人类驾驶员驾驶,只要看到了大货车进行并线,几乎一定会做出减速或者制动的反应。

但 Autopilot 显然没有做到这一点。

那么,特斯拉 Autopilot 是否真的存在问题?

03 Autopilot 对加塞行为的判断逻辑

首先在感知层面,特斯拉是否识别到了大货车?

广汽研究院智能驾驶技术部部长郭继舜分享了他此前对特斯拉进行测试的一些经验。

他认为,特斯拉 Autopilot 识别加塞的逻辑,是需要前车车身或车尾的二分之一进入本车道时,系统才会认为是这是一次加塞。

这样进行加塞意图判断的逻辑,是为了避免误触发,因为相邻车道的车辆可能仅仅是部分贴近车道线行驶,但并没有真正做出加塞动作。

因此,特斯拉会针对相邻车道的加塞意图设定一个具体的阈值。

车身或车尾的二分之一,也是业界在加塞场景中其中一个采用较多的阈值。

而且 Autopilot 在功能开发上做了更多的工作:

如果特斯拉检测到相邻车辆的三分之一进入本车道,但还没有达到加塞的阈值,这时特斯拉在本车道内有时不会减速,而是向另外一侧进行小幅避让。

根据事故当时的视频画面,在这次交通事故中,大货车大约有六分之一进入了特斯拉的车道,这么近的距离还要进入加塞,本身就是大货车的全责。

至于特斯拉是否识别到了大货车,郭继舜认为,在此次交通事故中,特斯拉侧面主要依靠摄像头来进行识别,而摄像头只能够看到大货车的局部特征。

也就是说,特斯拉的摄像头很可能无法判断大货车是不是一辆车。

退一步说,即使特斯拉通过局部特征判断那是一辆大货车,也无法做出对方将进行加塞的判断。

因为大货车加塞进入特斯拉车道的比例没有达到 Autopilot 设定的加塞行为判断的阈值。

第二个问题是,为什么 Model 3 会突然加速撞车?

目前可以明确的是,根据特斯拉的后台数据记录,当事车主在整个事故过程中没有踩下加速踏板,也就是说,加速属于特斯拉 Autopilot 控制下的行为。

当时,特斯拉处于 ACC 自适应巡航模式下,Autopilot 会追踪前方车辆进行自动跟车。

因而,发生此次撞车事故有两种可能:

一是特斯拉无法识别正在并线的大货车,在发现前方 ACC 的目标驶离后,车辆采取了加速跟车,从而发生撞车事故。

二是,特斯拉识别到了大货车,但 Autopilot 认为没有加塞的可能性,于是继续自动跟车,导致撞车事故。

从算法逻辑上讲,特斯拉 Aupilot 并没有做错什么。

不过,也有业内人士持不同观点。

一位国内自动驾驶公司技术工程师解释:

「特斯拉的超声波雷达可以检测 8 到 12 米之间,基本上可以覆盖一个半车道。

在这次事故中,大货车的车轮驶进车道时,超声波肯定是能够检测到,但由于大货车底盘高,车轮经过时系统会认为有障碍物。车轮通过后,又会认为没有障碍物,系统可能过滤掉了超声波雷达的检测结果。

Autopilot 的算法策略是重摄像头轻毫米波雷达,感知融合有可能没有开发得特别完善。

最终,在算法层面,由于传感器融合检测缺陷,特斯拉肯定没有识别到大货车。」

04 屡撞大货车的背后

特斯拉已经不止一次撞上大货车。

今年 6 月,一辆 Model 3 在台湾嘉义县中山高速上撞上一辆大货车。事发时,内侧车道上有一辆货车发生侧翻,后方驶来的 Model 3 直接撞上货车。

在这次事故中,Model 3 开启了 Autopilot 功能,时速约为 110 公里。事后车主回忆,当时并未注意到前方车辆侧翻,而是在车辆撞击前 2 秒才进行了紧急制动。

2019 年 3 月,一辆 Model 3 在美国佛罗里达州开启 Autopilot 时撞上了一台白色拖挂卡车,驾驶员不幸身亡。

2016 年 5 月,同样在佛罗里达,一辆 Model S 在 Autopilot 模式下撞上一台白色大货车。

当时,白色大货车正在调头转弯,特斯拉与大货车侧面发生碰撞,并从卡车底部钻过,整个车顶被彻底「削掉」,驾驶员 Joshua Brown 身亡。

这一系列事故背后,Autopilot 怎么了?不能识别大货车吗?

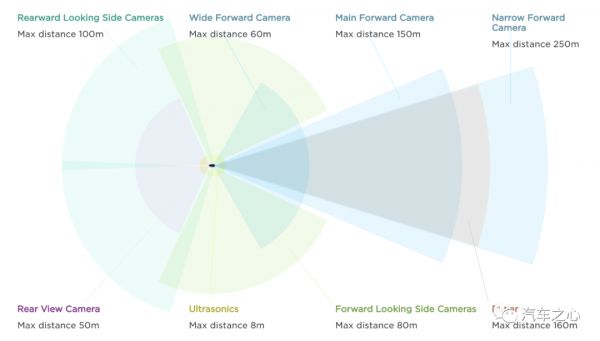

Autopilot 的传感器主要由 8 个摄像头、12 个超声波传感器和 1 个增强版毫米波雷达组成。

对于这套方案,法雷奥中国 CTO 顾剑民认为,「对摄像头来说,需要用机器学习来训练识别物体。但静态物体类别多,形态也千差万别,没经过样本训练便识别不了。」

这里的逻辑是,自动驾驶公司在开发视觉感知时,基本上采用深度学习技术,这项技术具备迁移和泛化特点。

比如,让系统看到一匹白色的马,下次再看到一匹黑色的马,系统仍然可以判断出来那是一匹马。但如果出现一只猪,系统就无法识别,因为没有学习过。

车辆的视觉检测与之类似。

以发生在台湾的交通事故为例,翻倒的大货车场景,是特斯拉从来没有见过的,根本检测不出来是一辆车,系统可能把大货车当成了天空。

所有的视觉检测任务,首先要有完整的场景需求,然后根据场景需求进行算法设计,而算法都是有局限性和边界的。

这便是特斯拉 Autopilot 和许多自动驾驶视觉检测方案的天然缺陷。

这种缺陷体现到大货车的视觉检测上,便暴露得更加明显。

如今,大货车视觉检测是全世界公认的难题,尤其是近距离大货车视觉检测。

这是因为,大车的异型车辆种类非常多,小车无非是换下颜色,或者车体结构存在如 SUV 和小轿车等的区别。

但大车种类丰富,主要有拖挂车、平板车、水泥罐车等,再加上这些大货车在实际驾驶场景中出现的频率相比小车来说要低很多,想要收集数据并进行训练相对困难。

这意味着,如果把此次深圳南坪交通事故中的场景交给其他自动驾驶公司去应对,很可能也无法成功避免交通事故。

即使在这个场景中应对成功,但同样的场景下,把大货车换成一辆集装箱车辆,近距离加塞时仍然有可能发生碰撞事故。

05 改进之路

在一些消费者看来,加塞行为是道路上常见的真实场景,尤其是在城市里面,加塞场景更需要被处理好。否则,只能说明自动驾驶还不完善。

而大家更关心的是,如果车企的自动驾驶系统确实无法处理所有的场景,便应该明确告知消费者它的自动驾驶功能的局限性。

Model 3 车主刘先生回忆,在买这辆车时,「特斯拉的工作人员跟我说,花 5.6 万就可以(让车辆)具备完全自动驾驶能力……因为相信它,我才愿意花 5.6 万。风险方面,他一点也没告诉我,没告诉我不能识别雪糕筒,也没告诉我不能识别大货车。」

正是因为 Autopilot 提供驾驶便利,车主会信任它。但又因为系统不成熟,在遇到Autopilot 无法解决的情况时,又存在车主无法及时接管车辆的可能性。

这就到了考验人性和驾驶员经验的时刻,人类驾驶员既不能完全信任 Autopilot,又要利用它来完成某些路段的自动驾驶任务。

那么,如何完善自动驾驶功能?

有业内人士建议,可以从传感器方面,尝试增加角雷达来进行提高感知能力等。

此外,在自动驾驶尚未完全成熟之前,自动驾驶测试进行得多么充分,都无法穷尽现实道路中的所有场景。

再加上中国道路的复杂性和国人的交通习惯,特斯拉或许应该在算法层面更加保守,同时要更加注重对人类驾驶员的教育和宣传。

毕竟,特斯拉 Autopilot 已经不是一件普通意义上的商品,它处于不断迭代更新的过程中,而且是一场由车企和消费者共同参与的技术迭代之旅。

所以,在更高级别自动驾驶到来前,驾驶员仍需要克服人性对机器的依赖,掌握驾驶的主导权。

相关推荐

特斯拉为什么只跟大货车过不去?是人性的依赖还是机器的失职?

塑料蓝、原谅绿,iPhone 12为什么跟颜色过不去?

自动驾驶为什么会要了你的命

快递司机批亚马逊:只发1包消毒湿巾清洁送货车

打脸马斯克,“无人车依赖LiDAR注定失败”的预言实测并不成立

特斯拉智能召唤面面观:是实用功能还是纯玩票?

为什么特斯拉为汽车产业链上市公司带来的,不仅仅是订单?

SaaS公司做PaaS:过去了就厉害,过不去就会死

为什么特斯拉的自动驾驶总是很好骗?

人性善恶,决定科技善恶

网址: 特斯拉为什么只跟大货车过不去?是人性的依赖还是机器的失职? http://www.xishuta.com/newsview26817.html

推荐科技快讯

- 1问界商标转让释放信号:赛力斯 95228

- 2人类唯一的出路:变成人工智能 21183

- 3报告:抖音海外版下载量突破1 21148

- 4移动办公如何高效?谷歌研究了 20339

- 5人类唯一的出路: 变成人工智 20338

- 62023年起,银行存取款迎来 10336

- 7五一来了,大数据杀熟又想来, 8596

- 8网传比亚迪一员工泄露华为机密 8505

- 9滴滴出行被投诉价格操纵,网约 8215

- 10顶风作案?金山WPS被指套娃 7230