“透视皮肤”传感器与多模态感知框架: 视觉、触觉数据联动预测物体运动轨迹

编者按:本文来自微信公众号“将门创投”(ID:thejiangmen),作者:让创新获得认可,36氪经授权发布。

From: VentureBeat;编译: Shelly

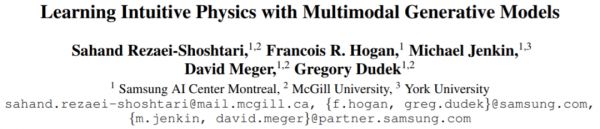

一直以来,预测物体运动轨迹是AI领域的一大难关。近期,三星、麦吉尔大学和纽约大学的研究人员开发出一种名为“透视皮肤(See-Through-your-Skin)”的传感器,它既可以捕捉包括物体3D形状、所处位置在内的视觉信息,也能够提供详细的触觉测量数据,根据这些视觉和触觉信息来预测物体的运动变化。

物体运动轨迹预测挑战重重

近期,人工智能的研究指出了触觉和视觉之间的协同效应:一种是测量物体的三维表面和惯性特性,另一种是描绘物体投影外观的整体视图。

在这项工作的基础上,通过测量物体初始状态的视觉和触觉信息,是否可以预测物体的运动轨迹?对此,三星、麦吉尔大学和约克大学的研究人员进行了探究。

研究结果令人振奋,可以说,这是第一个利用视觉和触觉感知来学习多模态动力学模型的研究。

运动预测是自动化领域的一项关键技术,通过预判物体和环境的交互方式,自动化系统能作出更加智能的决策。该团队的这项研究,又将这一技术的应用向前推进了一步。

研究人员在一篇论文中这样写道:“以往研究表明,由于存在未知的摩擦力、几何特性,以及相互作用表面的不确定的压力分布,想要预测物体在运动中的轨迹,具有很大的挑战性。”

论文入口:https://arxiv.org/pdf/2101.04454.pdf

在该团队研究人员看来,视觉、触觉信号的联手,或有助于推测出物体运动后的最终稳定状态。

其中,触觉数据可以反映物体和环境间的作用力、物体运动和接触等关键信息,提供一种展现物体与环境交互过程的整体视角;而视觉数据则可以直观反映物体的立体形状、位置等属性。

“透视皮肤”传感器

“为了克服轨迹预测面临的这些困难,我们借助于一种预测器,它能捕捉运动轨迹中信息最关键、最稳定的元素。”研究人员在文章中写道。

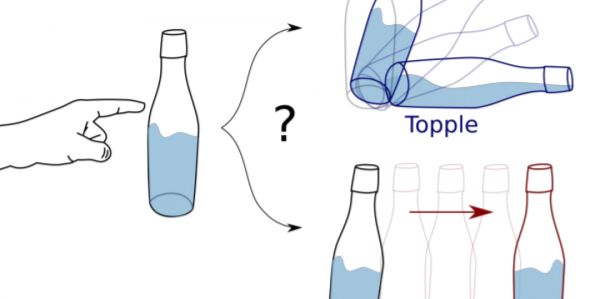

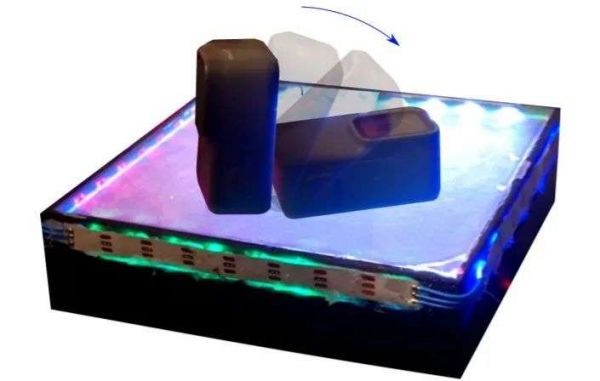

研究人员开发了一种名为“透视皮肤”(See-Through-your-Skin,简称STS)的传感器,这种传感器能在捕捉图像的同时提供详细的触觉测量,并重建在1640×1232的高分辨率图像中。

由于光学触觉传感器通常使用不透明和反光的涂料涂层,研究人员开发了一种透明度可控的薄膜,使传感器能同时采集物理交互的触觉信息和外部世界的视觉信息。

具体而言,研究人员通过改变STS传感器的内部照明条件,来控制传感器的触觉与视觉测量的占空比,从而设置反光涂料层的透明度。利用内部照明可将传感器表面变成透明,从而使得传感器内置摄像头能直接采集传感器外部世界的图像;传感器也可以保持内外一致的亮度,通过感知膜形变来采集物理交互触觉信息。

利用STS传感器和Pybullet模拟器,研究人员快速生成了大量动态场景中物体交互的视觉和触觉数据集,以验证他们传感系统的性能。

受多模态变分自编码器(MVAE)的启发,研究团队设计了一个生成式多模态感知系统,在统一的MVAE框架内集成了视觉、触觉和3D姿态反馈。

MVAE可以对STS传感器采集到的视觉和触觉数据进行解读,将物体所有模式的关键信息映射到一个共享的嵌入式空间中,用于推断物体运动后的最终稳定状态。

结果表明,训练MVAE结构可以预测多模态运动轨迹中最稳定、信息量最大的元素。

多模态感知框架

除此之外,研究人员还创建了一个生成式多模态感知的框架,利用视觉和触觉数据,学习给物体姿态、形状和力学信息编码,对物体力学做出预测。

为了预测物体在物理交互过程中的静止状态,他们使用了静息状态预测,利用了动态场景中的视觉-触觉运动数据集。物体运动下的状态包括:物体在平面上自由落体、物体从斜面滑下,以及物体静止状态受到干扰等。

在实验中,该方法能够准确地预测运动物体在原始状态(即静止状态)的视觉和接触数据。实验证明,预测结果与地面的事实标签非常吻合。此外,研究人员的框架学会了视觉、触觉和3D姿态之间的映射,因此它可以很好地处理信息缺失的情况,比如,当输入的触觉信息不可用时,框架可以自行根据其他信息“脑补”计算出来,类似于初中数学的解X方程。

它还可以预测物体从传感器表面掉下来的意外情况,这种情况下,框架输出的图片为空白。

“如果一个神秘的‘天外来物’突然落到你的掌心,我们不仅能够推断出它的类别、猜测它的一些物理性质,还能直接判断出你能否牢牢握住它,以及你是否需要换一种方式托举物体以防止它滑落。”研究人员写道。

“我们发现,在物理场景中预测物体运动受益于这两种模式:视觉信息用于捕捉物体的属性,如3D形状和位置;而触觉信息则提供相互作用力和随之产生的运动与接触信息的关键线索。”

简言之,这项新成果基于触觉、视觉的双模态数据对物体的运动轨迹进行预测,并判断物体的最终静止状态。较于以往的运动预测技术,该研究实现了触觉和视觉数据的双向推测,赋予制造业的自动化更多可能。

ref :

https://venturebeat.com/2021/01/18/researchers-develop-ai-framework-that-predicts-object-motion-from-image-and-tactile-data/

https://arxiv.org/pdf/2101.04454.pdf

相关推荐

“透视皮肤”传感器与多模态感知框架: 视觉、触觉数据联动预测物体运动轨迹

多模态学习,带来AI全新应用场景?

华为投资深思考,多模态语义理解的时代来了?

机器视觉农业应用,帮助识别环境、监测作物

MIT十美元AI“灭霸手套”来了

将视觉感知与运动规划技术结合,「如本科技」要大幅提高机器人的易用性

潮科技 | 自动化所在视觉物体检测与识别领域取得系列进展

研发离电子压力传感器,「钛深科技」要为机器人、可穿戴设备贴上“触觉电子皮”

多模人车交互,智能汽车的AI感知进化

深思考杨志明:多模态语义理解能推动人工智能大规模落地 | 2019 WISE新经济之王大会

网址: “透视皮肤”传感器与多模态感知框架: 视觉、触觉数据联动预测物体运动轨迹 http://www.xishuta.com/newsview38134.html

推荐科技快讯

- 1问界商标转让释放信号:赛力斯 95228

- 2人类唯一的出路:变成人工智能 21183

- 3报告:抖音海外版下载量突破1 21148

- 4移动办公如何高效?谷歌研究了 20339

- 5人类唯一的出路: 变成人工智 20338

- 62023年起,银行存取款迎来 10336

- 7五一来了,大数据杀熟又想来, 8596

- 8网传比亚迪一员工泄露华为机密 8505

- 9滴滴出行被投诉价格操纵,网约 8215

- 10顶风作案?金山WPS被指套娃 7230