十年磨一剑,英伟达能否掌控人工智能的未来?

编者按:本文来自硅谷封面,36氪经授权发布。

【划重点】

目前97.4%的人工智能加速器部署的都是英伟达GPU芯片,英伟达在人工智能算法训练市场上占据“近100%”的份额。

英伟达高管强调这不是误打误撞,公司在进军人工智能市场方面一直非常注重策略性。

英伟达仍主导谷歌发明的人工智能行业标准MLPerf基准测试。

英伟达之所以要收购ARM,是想要在边缘推理芯片方面获得更多优势。

业内人士认为英伟达在隐藏GPU复杂性方面做得非常出色。

英伟达斥资数千万美元打造人工智能超算是为了吸引行业顶尖人才。

目前英伟达的GPU主导着人工智能芯片领域。但十年过去,越来越多的企业开始利用人工智能来从收集的海量数据寻找规律,而很多机构和组织也在向深度学习研究投入巨额资金。许多初创企业表示,单靠GPU已经落伍,快速发展的人工智能领域需要新的架构。加之物联网生成的海量数据扑面而来,英伟达将如何掌控人工智能的未来?

以下为文章正文:

英伟达到底是如何从显卡制造商发展到主宰人工智能芯片领域的?这个故事似乎和猫有关系。现任英伟达首席科学家的比尔·戴利(Bill Dally)在2010年曾与斯坦福大学同事、计算机科学家吴恩达吃过一次早餐。吴恩达当时正和谷歌合作开发一个项目。戴利回忆道,“他正试图在互联网上找猫。他当时没有这么说,但这就是他正在做的。”

吴恩达当时正在谷歌旗下的Google X实验室从事研究项目,试图开发出一个能够自主学习的神经网络。这个神经网络播放YouTube上的1000万段视频,并学会如何识别人脸、身体和猫。但吴恩达实现这一点用了几千个CPU芯片。“我当时说,’我打赌我们只用几个GPU就能做到,’”戴利回忆。当时图形图像处理器(GPU)主要用于处理3D渲染等更密集的工作负载,这使得它们在人工智能方面比CPU效果更好。

戴利求助于英伟达深度学习现任研究主管布莱恩·卡坦扎罗(Bryan Catanzaro),希望实现这一想法。结果他做到了。他们只用了12个GPU,就证明GPU的并行处理能力在训练吴恩达的人工智能识别模型时比CPU更快更高效。

但卡坦扎罗想让大家知道的是,英伟达深耕人工智能并不只是源自那次偶然的早餐。事实上,早在2008年加入英伟达之前,卡坦扎罗还是伯克利大学的研究生时就已经在开发用于人工智能的GPU了。他表示:“英伟达目前所拥有的市场地位绝非偶然。”

英伟达深度学习现任研究主管布莱恩·卡坦扎罗(Bryan Catanzaro)

不论如何,英伟达已经在人工智能芯片领域占据了主导地位,关于公司何时开始以及如何实现这一目标的说辞似乎已无关紧要。目前英伟达的主要营收来源仍然是游戏显卡,但上一财年公司用于数据中心的GPU销售额攀升至67亿美元。2019年,在亚马逊云服务(AWS)、谷歌、阿里巴巴和微软Azure这四大云服务商的数据中心中,97.4%的人工智能加速器中部署的都是英伟达GPU芯片。市场研究公司Cambrian AI Research分析师卡尔·弗罗因德(Karl Freund)表示,英伟达在人工智能算法训练市场上占据“近100%”的份额。在全世界500强超级计算机中,近70%使用的也是英伟达GPU。几乎所有的人工智能里程碑都少不了英伟达的芯片。吴恩达的YouTube视频猫识别系统、DeepMind开发的围棋冠军AlphaGo、OpenAI的语言预测模型GPT-3都是在英伟达的硬件上运行。可以说,英伟达GPU成了人工智能研究人员的立足点。

尽管英伟达取得了成功,但卡坦扎罗仍然对有关英伟达是误打误撞从游戏领域进入人工智能领域的说法很不满。“我发誓,我读过的每一个故事几乎都是这样的:GPU碰巧在人工智能方面表现出色,英伟达通过向新市场出售现有芯片暂时到手了笔意外之财,很快它们就会被初创公司所取代。”卡坦扎罗说,“但10年来,英伟达在进军人工智能市场方面一直非常注重策略性。”

十年过去,颠覆现有市场的时机已经成熟。越来越多的企业开始利用人工智能来从收集的海量数据寻找规律,而很多机构和组织也在向深度学习研究投入巨额资金。德勤分析师科斯蒂·佩里科斯(Costi Perricos)表示,人工智能将成为各国竞相争夺的焦点。与此同时,深度学习模型的规模和复杂性都在不断增加,需要硬件能提供更多算力。

OpenAI的GPT-3就是其中最极端的例子。这个深度学习系统可以自动生成人们可理解的文本。整个系统由1750亿个参数及变量组成,计算成本约为460万美元。随后,GPT-3被拥有1.6万亿参数的谷歌语言模型所超越。为了提高精度,人工智能系统往往需要更高效的硬件来处理更多参数和数据,但同时也要防止人工智能本身成为更大的环境灾难。丹麦研究人员表示,训练GPT-3所需的能量相当于汽车行驶70万公里的碳排放量。

人们需要更多的人工智能芯片,也需要更好的人工智能芯片。尽管英伟达的早期研发工作在业内领先一步,但挑战者们正在竞相追赶。谷歌于2015年开始制造自家的人工智能芯片;亚马逊在2016年收购了以色列芯片设计公司Annapurna Labs,从去年开始将数字助理Alexa的大脑换成自家的Inferentia机器学习芯片;百度旗下的昆仑芯片最近估值达到了20亿美元;高通在2019年宣布推出一款人工智能专用芯片Cloud AI 100;IBM正在研究一种低能耗人工智能芯片设计;AMD收购赛灵思,专注于人工智能数据中心;英特尔在2019年为其至强数据中心CPU添加了人工智能加速功能。此外,英特尔先是在2016年以4.08亿美元的价格收购了神经网络芯片公司Nervana,又在2019年以20亿美元收购人工智能芯片制造商Habana Labs。在过去的几年里,Graphcore、SambaNova、Cerebras、Mythic AI、Blaize和TensTorrent等初创公司陆续发布或开始测试人工智能芯片。

但全世界仍处于人工智能领域的早期阶段。吴恩达的猫是十年前才计算出来的;业内大多数初创公司只有几年的历史。随着智能物联网设备开始一场机器对机器的革命,更多的数据集将会流动起来,所有人的观点都集中在同一件事上:如何掌控人工智能芯片的未来。

打开人工智能大门的GPU

机器学习是一种完全不同的计算工作负载,需要用不那么精确的大量数据完成大量数学运算。传统的高性能计算是将多个系统并在一起,构建出超级计算机来处理科学模拟或金融建模等复杂工作负载。这些任务通常用高精度的64位数据完成计算。相比之下,人工智能计算也需要庞大的计算基础设施,但所使用的数据并没有那么精确,只有16位甚至是8位,这有些类似于超现实图像和上世纪80年代像素化游戏之间的区别。人工智能芯片初创公司Cerebras首席执行官安德鲁·费尔德曼(Andrew Feldman)表示:“数据处理基本上很简单,但也很复杂。”

人工智能芯片可以是任何针对谷歌TensorFlow或Facebook的PyTorch等机器学习工作负载进行过优化的处理器。在训练或运行深度学习模型时,人工智能芯片不一定要完成所有的计算工作,主要是当作加速器来处理最密集的工作负载。例如,英伟达封装的人工智能系统DGX A100就用8个安培A100 GPU当作加速器,此外还有一个128核的AMD CPU。

人工智能并不是什么新鲜事,但之前人们缺少让深度学习模型成为现实的计算能力,这让研究人员花时间等待硬件的进步。另一家制造人工智能芯片的初创公司SambaNova联合创始人兼首席执行官Rodrigo Liang表示:“GPU打开了人工智能的大门。”

一年一度的ImageNet计算机视觉挑战赛让研究人员相互竞争,开发能够识别图像或物体的算法。2012年,多伦多大学研究人员亚历克斯·克里热夫斯基(Alex Krizhevsky)基于GPU的深度学习系统击败了其他参赛者。到2015年,所有在ImageNet中排名靠前的参赛者用的都是基于GPU硬件的算法。

这让深度学习研究呈现爆炸式增长的局面。英伟达的技术让深度学习处理速度提高了20倍以上。但英国芯片初创公司Graphcore联合创始人在公司刚刚成立时却一度找不到投资者。“我们从风投那里经常听到的一句话是:’什么是人工智能?’”该公司联合创始人兼首席技术官西蒙·诺尔斯(Simon Knowles)回忆起2015年去加州寻求融资的经历时这样说。“令人惊讶的是,几个月后,也就是2016年初,一切都变了。那时每个人都热衷于人工智能,”诺尔斯说。“然而,他们对芯片硬件却没有那么感兴趣。”新的芯片架构当时被认为没有必要,英伟达已经占据了整个行业。

但是2016年5月,谷歌改变了一切。Cerebras的费尔德曼称谷歌做出了一个“夸张的战略决策”,宣布谷歌已经为人工智能应用自行开发芯片。这些所谓张量处理单元(TPU)的芯片就是为了与谷歌TensorFlow机器学习编程框架协同工作。Graphcore的诺尔斯表示,此举向投资者发出了一个信号,即新的人工智能芯片设计或许有市场。“突然间所有的风投都在想:那些疯狂的英国人现在在哪儿?”诺尔斯说。从那之后,Graphcore拿到了7.1亿美元的融资。

英伟达的竞争对手们认为,GPU是为图形图像处理而非机器学习设计的,尽管其强大的处理能力意味着比CPU更胜任人工智能任务。但由于系统优化的局限性和软件层的复杂性,它们的市场主导地位只能维持这么长的时间。“英伟达在隐藏GPU复杂性方面做得非常出色,”Graphcore联合创始人兼首席执行官奈杰尔·图恩(Nigel Toon)表示。“GPU之所以有效,是因为他们开发的软件库、框架并进行优化,隐藏了计算层面的复杂性。对于英伟达来说,这是一项非常艰巨的任务。”

但抛开GPU的话,可能需要从头开始设计拥有全新架构的人工智能芯片。谷歌的TPU芯片是针对特定工作负载设计的专用集成电路;Cerebras开发的则是晶圆级引擎,这种巨型芯片要比其他芯片大56倍;IBM和BrainChip则是以人脑为模型开发神经形态芯片;而Mythic和Graphcore生产的是智能处理单元(IPU),但设计有所不同。

但卡坦扎罗认为,许多芯片只是人工智能加速器的变体。他说:“我们可以说GPU、TPU或IPU或其他什么,但人们只是很习惯这些字母。“我们这样称呼GPU是因为以前就这么说……但GPU一直是用于加速计算的,而人们所关心的工作负载性质在不断变化。”

有谁能和英伟达抗衡?目前英伟达仍主导MLPerf基准测试.MLPerf是深度学习芯片的黄金标准。市场研究公司Cambrian AI Research分析师卡尔·弗罗因德(Karl Freund)指出,由学术界和行业参与者设计的标杆工具MLPerf目前由谷歌和英伟达主导,但初创企业通常不会费心去完成所有这类测试,因为打造一个系统的成本最好花在别处。

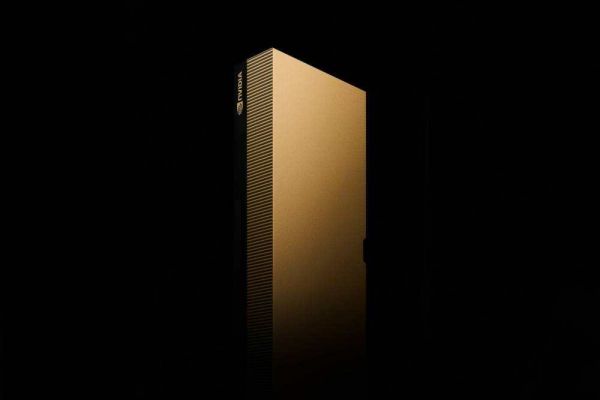

每个英伟达SuperPOD内有20个DGX人工智能系统

英伟达在每年的MLPerf测试中都要超过谷歌的TPU。“谷歌发明MLPerf来显示他们的TPU有多好,”英伟达解决方案架构和工程主管马克·汉密尔顿(Marc Hamilton)说,“黄仁勋说,只要每次跑MLPerf测试时我们的GPU都能超过谷歌TPU就行,哪怕只有一点就很好。”

据称,为了确保能在某次基准测试中名列前茅,英伟达将一台超级计算机所搭载的DGX系统从36个升级到96个,这需要对整台设备重新布线。为了尽快完工,工程师们直接剪断了各种线缆,汉密尔顿说整套线缆价值100万美元。这种疯狂行为凸显出基准测试的刺激作用,但也启发英伟达对DGX系统进行重新设计。如今的DGX系统能以20个为一组自由组合,无需重新布线。

转战边缘推理

当涉及到基准测试和组装超级计算机时,人们总是可以通过添加更多人工智能芯片来提高性能。但对于另一种人工智能计算,也就是边缘推理则完全不同。

2020年,英伟达宣布将以400亿美元的价格收购英国芯片设计公司ARM,吸引了全世界的目光。要知道,后者的芯片架构被用于全球95%的智能手机。但业内反响并不很积极。仍持有公司股份的ARM联合创始人赫尔曼·豪泽(Hermann Hauser)称这是一场“灾难”,可能会破坏ARM在市场中的中立地位。世界各地的监管机构都在密切关注这笔交易。

ARM只设计芯片,并将知识产权授权给芯片制造公司。如果某个人工智能芯片制造商需要一款CPU,他们可以从ARM获得芯片设计许可,并按照自家规格进行制造。竞争对手担心英伟达控制ARM后可能会限制相关合作,不过黄仁勋曾“明确”表示,英伟达将尊重ARM现有的开放模式。

边缘推理芯片能够将深度学习用于现实世界,而ARM正是这种芯片的主要设计者。英伟达收购ARM意味着可能对现有市场态势产生巨大影响。在ARM的帮助下,英伟达可以凭借GPU和边缘推理方面的优势地位在数据中心领域占据主导地位。

什么是边缘推理?为了训练和应用人工智能模型,英伟达的高性能系统会对数据进行大量处理。但在人工智能领域,还有推理这种更轻量级的任务,也就是使用训练过的模型来解释某些现实景象。比如无人驾驶汽车理解摄像头看到的东西,一个智能手机应用程序扫描用户脸部,把猫耳朵贴在自拍照上,或者一个对医学影像进行病理分析等等。由于训练需要巨大算力,通常会在数据中心完成;但推理可以在数据中心、也可以在边缘设备上完成。

第一种推理在数据中心完成。当你问数字助理Alexa或Siri一个问题时,其会被传送回亚马逊和苹果的服务器进行转录并回复。第二种推理则发生在相机、汽车或智能手机等终端用户设备中,这被称为边缘计算。第二种推理需要的算力不多,但处理速度要快。

英伟达目前主导着数据中心领域的推理工作。其A100利用数据进行训练,而推理被虚拟化到更小的迷你服务器中,在同一硬件上能同时完成50个或更多推理工作负载。这对AWS等提供人工智能服务的科技巨头很有帮助,因为多家公司可以使用相同硬件而且不会有数据泄露的风险。在边缘计算领域,英伟达拥有用于无人驾驶汽车的DRIVE芯片和用于现场推理的EGX芯片,但低功耗芯片并不是英伟达的专长所在。如果你曾经使用过搭载英伟达显卡的游戏笔记本电脑,就会发现其电池续航时间比Chromebook要短。但设计低功耗芯片是ARM最擅长的事情,这也是为什么英伟达不惜斥资400亿美元收购ARM的原因。

ARM在人工智能领域的研究主要集中在两个方面。首先,其将软件框架整合到现有CPU上。为了应对更密集的工作负载,ARM开发了一种名为Ethos的神经处理单元(NPU)当作人工智能加速器使用。ARM IP产品部门总裁雷内·哈斯(Rene Haas)说,使用Ethos-U55设计的设备应该很快就会上市,因为获得该设计许可的公司已经生产出了成品芯片。

有了边缘推理,语音助手将不再需要将用户语音上传到AWS或苹果服务器进行处理,而可以基于本地智能做出响应。哈斯说:“这使得工作可以在本地设备上完成,在很多方面都有助于提高效率。”他指出,将数据在设备和云端之间来回传送需要消耗电池能量。

英伟达负责欧洲、中东和非洲地区(EMEA)的副总裁戴维·霍根(David Hogan)表示:“很长一段时间以来我们都在谈论物联网,但这个愿景直到现在才实现。”“这种转型是我们收购ARM的计划核心。”

打造人工智能超级计算机

去年,英伟达解决方案架构和工程主管马克·汉密尔顿(Marc Hamilton)花很多时间和精力打造一台价值5000多万美元的超级计算机,这就是“剑桥1号”。搭积木般的系统设计风格让开发“剑桥1号”变得更容易。“剑桥1号”由一排排成组的DGX人工智能系统组成,每组有20个DGX,被称为SuperPod。而单个DGX售价19.9万美元,堪称一台完整的人工智能计算机,其中用8个A100芯片作为DGX计算系统核心,同时具有内存、网络和其他功能。

汉密尔顿说,“剑桥1号”建成后将是英国最强大的人工智能超级计算机,在全世界排名第30位,但在英伟达打造的人工智能超级计算机中只能排到第五。“剑桥1号”有80个DGX A100系统,而最大的Selene超级计算机有560个。

英伟达的“剑桥1号”人工智能超级计算机

虽然“剑桥1号”不是最快的,也不是最大的超级计算机,但它拿到了两个第一。汉密尔顿称其为世界上第一台原生云超级计算机,有类似于AWS的区划功能,企业能够使用相同硬件而不会有安全漏洞或数据泄露的风险。此外,“剑桥1号”也是英伟达唯一向外部合作伙伴开放的超级计算机,各个大学机构、医疗巨头阿斯利康、牛津纳米孔和葛兰素史克都可以在“剑桥1号”上运行自己的深度学习模型。

为什么英伟达要打造超级计算机?一个原因是,英伟达需要超级计算机来吸引行内最优秀的人才。2016年,英伟达还没有超级计算机,而Facebook和谷歌正在抢最好的人工智能研究员。汉密尔顿说:“这并不是因为他们付的工资更高。而是因为谷歌和Facebook在运营业务方面有成千上万的GPU,他们可以让人工智能研究员访问这些GPU。”

现在,英伟达的超级计算机Selene是全球第五大计算机,仅次于日本的一台、中国的一台和美国拥有的两台。汉密尔顿表示,这意味着,如果你是一名想要接触到最快人工智能硬件的研究人员,完全可以来英伟达工作。

单纯提高硬件算力有用吗

在卡坦扎罗的40人实验室里,研究人员开发用于英伟达自家系统的人工智能,但该实验室也充当系统架构师的培养基地,让他们得以了解深度学习模型未来可能如何工作。卡坦扎罗说:“如果你想为未来制造芯片,你想让它在未来有用,你必须具备预测未来最重要的工作负载是什么。”“如果你搞砸了,你就造错了芯片。”芯片的设计和制造往往需要数年时间,因此这种研究很有必要。

如果开发的人工智能模型以后不在GPU上运行,或者至少不能在GPU上运行,那会怎么样?英伟达的戴利承认有这种可能性,但由于大多数研究人员都在研究GPU,他认为这种想法不太可能成为现实。他说:“在新模型上线之前,我们通常都听说过它,并有机会对其进行测试,确保其在我们的GPU上运行良好。”

其他人则不同意戴利的这种说法。他们认为GPU可能影响到深度学习模型发挥全部潜力。Cerebras公司的费尔德曼说:“每个人都在根据当今的技术调整自己的模型。”“我们最高兴、最兴奋的事情之一,是有一群正在编写全新模型的客户。”他说今年Cerebras将展示所谓的“GPU不可能完成的工作”实例。费尔德曼强调,GPU根本无法完成某些人工智能工作。

Graphcore公司的图恩则表示,研究人员早就抱怨,当今硬件已经成了绊脚石,影像人们思考更复杂的问题。图恩说:“比如概率机器学习等想法仍然被搁置,因为目前GPU等硬件不允许这种想法向前发展。”“竞争的焦点在于英伟达能以多快速度升级GPU,还是用新的东西来实现这一点?”

麻省理工学院计算机科学和人工智能实验室研究员尼尔·汤普森(Neil Thompson)在人工智能会议上注意到一个趋势,研究人员暗示,计算能力的限制影响了他们的模型开发,限制了他们的选择和数据集,因为他们无法负担高昂成本、通过重新运行模型来解决问题。他说:“这真的很普遍。就深度学习的未来而言,这是一个非常大的问题。”

汤普森和同事分析了1058篇人工智能论文,发现机器学习对算力的需求远远超过硬件改进或模型训练的效率。长此以往,系统总有一天需要花费数亿甚至数十亿美元来进行训练,这还没有算其他成本。汤普森说:“使用更多GPU的问题在于,将GPU数每增加一倍,成本就会增加一倍,由此带来的碳排放和环境污染也会增加一倍。”

他认为,仅靠英伟达等公司的硬件解决方案都不足以阻止人工智能创新陷入困境。相反,研究员需要开发更高效的模型,更好利用现有模型。诸如稀疏性(忽略数据集中的零以节省算力)之类的想法可以提供帮助,因为这种方法可以更有条理地处理数据,只将其与相关参数进行比较。另一个想法是将人们从模型中学到的东西提炼成更轻量级的方程,只运行模型中和问题相关的部分。

如果没有这方面的努力,人们将需要更大的数据中心。但人工智能不应局限于那些负担得起超级计算机的人。汤普森说,在从事高端深度学习研究工作的大学中,“计算机能力较弱的大学越来越少”。“现在仍然有相当多的机构可以参与人工智能研究,但是随着算力的增加,玩家数量越来越少。我们已经到了有些人被排除在外的地步。”

削减成本可能是初创公司击败现有公司赢得客户的一种方式。AWS去年将Habana Labs的人工智能芯片添加到其云服务中,称Habana Labs人工智能系统的运行成本要低40%。Habana Labs首席商务官埃坦·麦地那(Eitan Medina)表示:“要让人工智能惠及所有人,而不仅仅是富人,你真的需要提高性价比。”

人工智能已经存在偏见问题,而硬件访问方面的不平等加剧了这一问题。英伟达新兴领域主管凯特·卡洛(Kate Kallot)表示:“这意味着我们观察问题会存在片面性。”“如果你忽略了世界上很大一部分人口……那我们如何能解决世界各地的挑战?”她表示许多人工智能研究人员正将工作转向应对贫困和气候危机等挑战,但访问硬件的问题将在很大程度上影响新兴市场。

除此之外还有其他挑战。最近芯片制造一直受到限制。欧盟最近承诺,到2030年计划生产全球五分之一的高端芯片。今年3月,英特尔宣布计划首次在美国开设两家新工厂,并代工芯片。

随着这些障碍被克服,芯片会继续升级,人工智能将扩展到生活中的方方面面。在未来,智能不仅仅意味着联网,还意味着嵌入人工智能。“它将无处不在,”ARM的哈斯说。“在未来几年内,它将无处不在地出现在每一个计算应用程序中。”(皎晗)

相关推荐

十年磨一剑,英伟达能否掌控人工智能的未来?

孙正义为何清空“人工智能第一股”英伟达

从识别猫到厨房机器人:探究英伟达的人工智能之路

股价暴跌14% 英伟达人工智能第一股的美梦就要破碎?

英伟达的未来,不只是GPU

英伟达防“滑”奋战

英伟达和英特尔的AI战事

英伟达跨入企业协同设计领域,能否改变行业游戏规则?

年报深解:英伟达或将由盛转衰?

“逃离”英伟达

网址: 十年磨一剑,英伟达能否掌控人工智能的未来? http://www.xishuta.com/newsview45577.html

推荐科技快讯

- 1问界商标转让释放信号:赛力斯 95228

- 2人类唯一的出路:变成人工智能 21183

- 3报告:抖音海外版下载量突破1 21148

- 4移动办公如何高效?谷歌研究了 20339

- 5人类唯一的出路: 变成人工智 20338

- 62023年起,银行存取款迎来 10336

- 7五一来了,大数据杀熟又想来, 8596

- 8网传比亚迪一员工泄露华为机密 8505

- 9滴滴出行被投诉价格操纵,网约 8215

- 10顶风作案?金山WPS被指套娃 7230