为什么苹果一定要“扫描”你的相册?

“阿里员工遭性侵”事件中,因为不具备通话录音功能,iPhone“意外”卷入舆论,遭到了各路网友的吐槽:

考虑到对隐私的保护,iPhone不提供通话录音功能也无可厚非。

但意想不到的是,在另一个事件中,同样是面对隐私问题,苹果却做了另外一个选择。

为了保护儿童,苹果要“扫描”用户相册

这一次选择源自几天前苹果官宣的一则消息。

苹果表示,为了更好的保护儿童,公司将在iOS 15、watchOS 8、iPadOS 15和macOS Monterey的年底更新中推出3项全新的技术:

第一项技术涉及Siri——当用户向Siri询问“如何举报儿童遭到剥削”等类似问题时,后者会提供相应的举报途径;又或者用户尝试搜索关于儿童性虐内容关键词时,Siri会出面干预;

第二项技术为“Messanges通信检测”——Messages 应用的可选通信安全功能,可以在接收或发送色情照片时警告儿童及其父母;

第三项技术涉及照片和iCloud——系统“neuralMatch”将能够检测存储在iCloud照片中的已知儿童性虐内容(CSAM)图像,从而使Apple能够将这些情况报告给国家失踪和受虐儿童中心(NCMEC)。

其中,引起最大争议的就是第二、三项技术。

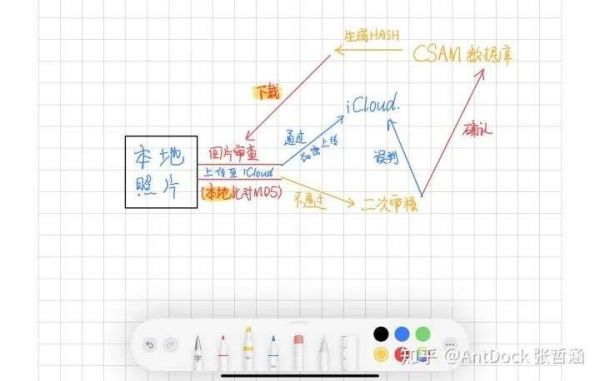

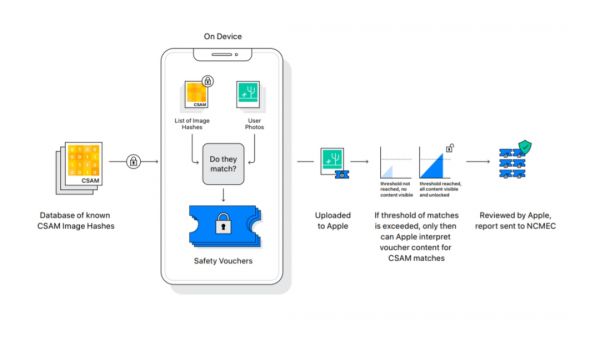

比如第三项技术,依据苹果所对外公布的文件公告,CSAM检测的应用过程中,在用户将张照片上传至iCloud之前,系统会在设备端将本地照片与NCMEC和其他儿童安防组织提供的已知儿童性虐图像的哈希数据库进行匹配。

一旦发现相关内容,相关材料会交由人工进行二次审核。

若审核结果确认违法,苹果将会禁用公司账户,并联系执法部门。

在知乎,有网友@AntDock张哲涵将以上原理画了出来:

图 | 源自:知乎网友@AntDock张哲涵的回答

从图像我们可以清楚意识到,一旦该技术被用在iPhone、iPad等设备中,当用户将iCloud功能开启,所有的照片都会被系统“扫描”一遍,可能有些还会进行二次人工审核。

这么一套操作下来,虽然看起来iPhone的出发点是好的,但是用户还有“隐私”可言吗?

6000+人签名反对新技术:这是给苹果的安全“开后门”

苹果这边宣布完消息没多久,那边就有人在网上写了一公开信。

信中写道,苹果的意图是善意的,但它的提议是在系统中引入“后门”,而这个行为可能会破坏对所有苹果产品用户的基本隐私保护。

截至目前,这封公开信已经得到了6649名个人或组织的支持,其中不乏知名安全和隐私专家、密码学家、研究人员、教授、法律专家等。

比如霍普金斯大学教授、密码学家Matthew Green,他表示:

这种工具能够可以帮助查找手机中的儿童色情内容,但想象一下,如果掌握权力的公司或机构获得了这种系统,会发生什么?

又比如社会组织“民主与技术中心(CDT)”表示:

苹果公司的变化在事实上是给儿童和所有用户带来新的风险,这严重背离了苹果从长期持有的隐私和安全协议。

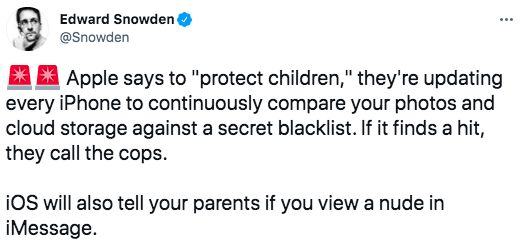

甚至斯诺登也出来针对此事发表观点,称:

不管用意有多好,苹果都在通过这种方式向全世界输出大规模监控。如果他们今天可以扫描儿童色情内容,那么明天就可以扫描任何东西。他们毫无征兆地将价值1万亿美元的设备变成了监控设施。

同时,他还在推特上发文呼吁大家去联名抵制苹果。

在这封公开信的最后,专家们也对苹果提出两点要求:

· 苹果立即停止尝试部署所提议的内容监控技术;

· 苹果发表声明重申他们对端到端和用户隐私的承诺。

针对业内的质疑,苹果也作了新回应,包括系统仅适用于上传到iCloud的照片,以及会坚定拒绝来自政府的扩展该技术的要求。

而依据这份回应,我们也能够看出,苹果是铁了心要实施这几项技术。

更甚者,苹果还明确,将在未来向第三方应用程序开放这三项新技术。

不过,Facebook旗下即时通讯应用WhatsApp负责人Will Cathcart在接受媒体采访时已经明确拒绝在平台上采用类似系统,更是在推特上连发数条进行“谴责”,表示:

该方法给世界带来了以些非常让人担忧的东西,因为它是由苹果构建和运营的一套监控系统,能够被轻易地用于扫描私人内容,以查找由该公司、或政府决定控制的任何内容。

苹果高空走绳

回头再来看整个事件,核心问题在于“科技向善”与“隐私安全”之间的矛盾。

用科技赋能是值得受到认可的,因为它真的能够做到人工所不能做到的。

比如同样是儿童性虐照片检测,谷歌就曾在2018年推出一款名为Content Safety API的内容排查工具包,能够大规模地识别和报告网络上儿童性虐待信息材料(CSAM),减轻了分析师的工作负担,以及将这个工作变得更加有效率。

又比如在国内,基于AI人脸寻人技术,不少被拐儿童得以在十数年,甚至更长时间之后找到回家的路。

但可以注意到,以上两个案例过程中,并未过多涉及个人用户的隐私安全,也达到了当初项目启动的目的。

事实上,为了隐私安全,苹果也进行了一系列保护措施,比如使用哈希算法进行加密。

但过程中依旧存在被攻破的危险,尤其对于本就没有设置端到端加密的iCloud而言。届时,一旦被攻破,黑客就完全可以获取到用户的隐私照片。

而即便没有泄露,一旦出现误报,就意味着负责二次审核的人工将能够看到用户的照片,并且还是无关儿童性虐的照片,这也相当于侵犯用户隐私了。

不可否认,苹果这一技术的背后是善意的、是值得被认可的,能够找出更多潜伏在冰山下、不为人知的儿童性虐恶性事件,但是它现在更需要思考的是,如何在执行“科技向善”的同时,做好与隐私安全之间的平衡。

这就相当于高空走绳,只有找到那个平衡点,苹果才能把CSAM项目很好地继续实施下去。

本文来自微信公众号“镁客网”(ID:im2maker),作者:来自镁客星球的韩璐,36氪经授权发布。

相关推荐

为什么苹果一定要“扫描”你的相册?

因为“强制扫描用户相册”,苹果陷入矛盾风波

远程扫描iPhone相册?苹果的好心网友不领情

垃圾信息入侵iPhone相册背后

罗永浩,你一定要成功

创业者复盘:为什么品牌一定要慢慢做?

中国为什么一定要搞新基建?到2030年你就都明白了

iPhone的共享相册,堪称数码圈“一大奇观”

远程办公不只是电话会议,这三个工作要点你一定要掌握

谷歌相册要收费了,这是拆分大型科技公司的理由吗?

网址: 为什么苹果一定要“扫描”你的相册? http://www.xishuta.com/newsview48460.html

推荐科技快讯

- 1问界商标转让释放信号:赛力斯 95273

- 2人类唯一的出路:变成人工智能 21579

- 3报告:抖音海外版下载量突破1 21553

- 4移动办公如何高效?谷歌研究了 20718

- 5人类唯一的出路: 变成人工智 20712

- 62023年起,银行存取款迎来 10377

- 7五一来了,大数据杀熟又想来, 8945

- 8网传比亚迪一员工泄露华为机密 8569

- 9滴滴出行被投诉价格操纵,网约 8567

- 10顶风作案?金山WPS被指套娃 7258