你的 iPhone 相册正在被监控?我猜你还没搞懂 Apple 新出的这个功能

本文来自微信公众号“少数派”(ID:sspaime),作者:SCHOENBERG,36氪经授权发布。

8 月 5 日,Apple 公布了保护未成年人安全的新举措,计划在今年后续发布的新版系统中引入一系列新的功能和机制(统称「儿童安全功能」),以保护未成年人免受性虐待等违法行为的伤害、阻却涉儿童色情相关内容。尽管这些举措尚未生效,且最初将仅限于美国用户,但已经引发了世界各地安全专家和用户的讨论。

本文中,我们就来介绍「儿童安全」功能的具体内容及原理,以及它为什么引起了不小的争议。

儿童安全功能的内容和原理

根据 Apple 上周发布的 说明[1],拟上线的儿童安全功能主要包括:

在信息 app 中向儿童及其家长警示对话中出现的裸露(explicit)图片

在 Siri 和搜索功能中提供儿童安全相关的求助资源和提示信息

检测 iCloud 图库中的未成年人色情图像,在超过一定门槛后禁用账户同时向安全部门举报

根据 Apple 的说法,这些功能在设计时就考虑到了对用户隐私的保护并在网站上提供了更多的技术细节,借此我们也值得一探背后的技术原理。

首先,如果用户在 iOS 中配置了家人共享功能,未成年人的 Apple ID 在信息 app 中的对话将受到基于本地机器学习的监控。

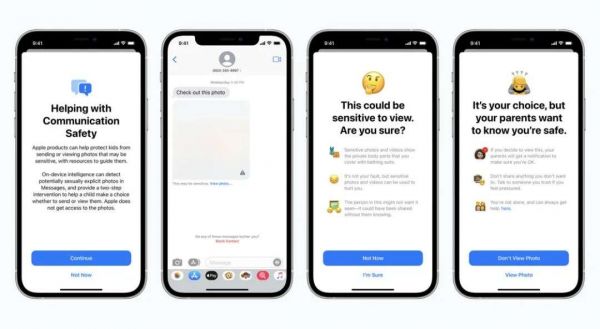

举个例子,当未成年人所使用的 Apple ID 在信息 app 中收到或即将发出露骨色情图片时,系统会发出警告,同时图像也会被模糊处理,效果如下图所示:

信息 app 中的提示。图源:Apple 网站

在这些警告和提示中,Apple 会尝试向未成年人解释什么是敏感照片以及分享、查看这些照片所伴随的风险,同时也向未成年用户表明,如果真的要观看或者发送敏感照片,与之关联的家长账户会被告知此事。

和此前的隐私保护策略中提到的相同,这里 Apple 再次宣称自己无法获取信息 app 中的通信内容,这份说明文档特别强调,即时通信消息对用户而言是相当敏感的隐私数据,因为 iMessage 使用了端到端加密,除了聊天双方,Apple 服务器并不知道用户具体在聊什么。

所以要判定图像内容是否为「儿童不宜」只能采用本地机器学习,另外就聊天中的图像内容进行提醒、通知家长等信息也不会上传给 Apple 或执法机构。

其次,Siri 和搜索功能会为用户提供与儿童安全相关的帮助和提示。

如果用户搜索如何举报「儿童性虐待内容」(Child Sexual Abuse Material,下文将缩写为 CSAM),那么 Siri 会向用户提供更直接的指引来简化非法内容的举报流程。

介入并告知用户。图源:Apple 网站

尽管 Siri 和搜索功能是 Apple 长期以来宣称自己无法获得用户信息的两个领域,如果用户试图在网上查找、获取 CSAM 信息,Siri 和搜索功能还是会介入并告知用户这些数据的非法性和危害性并提供可能需要的帮助,从文档提供的截图来看,这类帮助主要包括匿名热线和心理指导。

第三,儿童安全功能上线后,Apple 还会检测 iCloud 图库中涉及 CSAM 的非法内容。

和上面提到的聊天消息提醒不同的是,iCloud 图库照片检测不仅依赖本地机器学习,因而也成为了本次网络争论的重点。简而言之,如果用户尝试上传了过多的 CSAM 数据,超过了 Apple 设定的「门槛」,Apple 则会知悉上传数据的账号、将其禁用或上报给美国的相关安全部门。

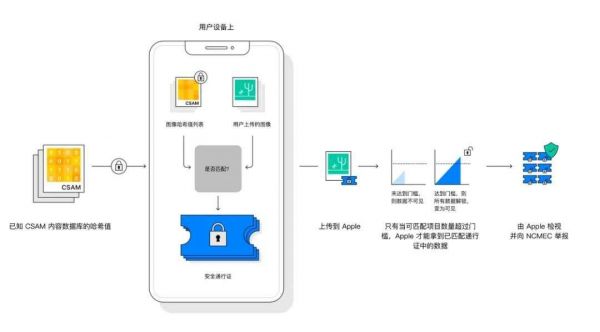

通过 Apple 官方给出的资料我们可以进一步了解这个扫描流程:美国国家失踪和受虐儿童帮助中心(NCMEC)向 Apple 提供了一个基础的数据库,Apple 通过将用户上传到 iCloud 图库的图像资料与这个数据库进行对比,从而确定即将上传的资料是否存在 CSAM 信息。这个资料对比过程发生在用户设备本地。

CSAM 检测流程示意图。图源:Apple

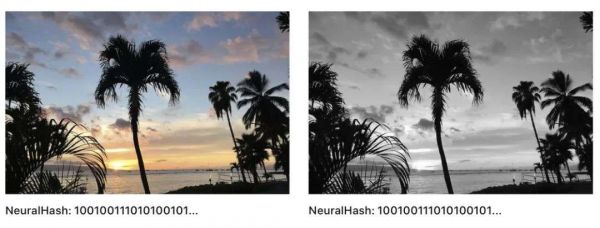

为了尽可能减少匹配中的错误并增加匹配概率,Apple 在这里使用了一项称为 NeuralHash 的技术——将相关机构提供的 CSAM 数据库和用户图像分别转换成 NeuralHash 哈希值,然后对比这些哈希值是否相同、确定用户是否上传了 CSAM 内容。Apple 表示即便一张图片被轻微裁剪、压缩或转换成黑白风格,图像的 NeuralHash 哈希值也不会改变,如此一来可以最大限度地提高检测的精确性。

一张图片和它的黑白版本具有相同的 NeuralHash 哈希值。图源:Apple 给出的技术简介

本地分析完成后,用户设备上会创建一份包含了匹配结果的加密安全通行证,通行证会通过隐私交集技术(Private Set Intersection,以下简称 PSI)进行加密并与图像一起上传到 iCloud 图库,PSI 的加密流程同样也在用户设备本地进行。如此一来 Apple 无法获取除了已匹配的 CSAM 之外其他内容的 NeuralHash 哈希值,一方面保证用户的非 CSAM 内容泄露,另一方面也能避免用户了解到匹配结果。

至于安全通行证本身,Apple 还采用了称为「秘密分享门槛」的技术(Threshold Secret Sharing)作为第二层保障,并宣称「秘密分享门槛」仅有一万亿分之一出错率。在这项技术下,只有获得了足够多的 CSAM 匹配、超过了预先设定的「解密门槛」,Apple 才能将数据解密。

比如一份隐私内容包含 1000 份碎片,而解密门槛被设定为了 10,如果这一组隐私内容有 11 份碎片被匹配到了,则认为超过门槛,这部分上传的数据将被解密并交由人工核验;但如果只有 9 份碎片匹配成功,相关数据则会处于加密状态。

换句话说,用户数据只有达到了一定的门槛后 Apple 才可以将数据解密,从而人工检视这些包含 CSAM 数据的通行证,而其他 iCloud 相册中的照片 Apple 依然无法访问。确认用户上传了非法信息后 Apple 将禁用该 iCloud 账号并向 NCMEC 举报;如果用户认为自己的账号被错误地禁用,也可以向 Apple 提出解禁申诉。

围绕新功能的讨论与争议

Apple 宣布的上述新举措,尤其是 CSAM 内容检测功能,在传统媒体、行业专家和资深用户中引发了广泛的讨论,现有观点普遍就儿童安全功能对用户隐私和设备安全的潜在影响表达了担忧。

究其原因,首先,Apple 此次在沟通方式上存在考虑不周之处。官方给出的说明没有区分信息 app 和 iCloud 图库在检测技术、适用群体和处置方式上的显著差异,而是一并作为「儿童安全功能」来宣传。这在最初引发了很多混淆。作为回应,Apple 后来专门发布了一则 官方问答[2],开篇即再次强调两者的区别。

其次,就检测和举报 iCloud 图库中的违法内容而言,尽管为儿童安全而配合执法是完全正当的,但很难保证为此而开的先例不会被滥用(无论从技术还是政策上)。对此,知名互联网权利组织电子前线基金会(Electronic Frontier Foundation,EFF)的观点最具代表性。EFF 认为,iMessage 内容检测功能可以被用来「开后门」——如果 Apple 能把儿童色情图片信息上报给家长,谁来保证用户的其他敏感信息不被报告给其他监管部门呢?换句话说:

It's impossible to build a client-side scanning system that can only be used for sexually explicit images sent or received by children.

想要开发一个事实上可以扫描一切,但仅仅被用来检测儿童收发的色情图片的客户端系统是不可能的。

第三,就信息 app 的非法内容检测而言,现有实践表明基于算法的检测或许并不能达到 Apple 宣称的可靠性。根据 Apple 的说法,信息 app 中使用的检测算法将能把出错率限制在一万亿分之一。

然而,图像处理领域的博客 RENT-A-FOUNDER[3] 指出,Apple 图像匹配算法的核心「感知性哈希值」(这里指的是 perceptual hashing 技术)在市面上已经有类似的技术,但这种技术在很多情况下仍然不能避免错误。例如,很多类似技术会认为将下面两张图片混为一谈:

图源:见水印,由 RENT-A-FOUNDER 整理

RENT-A-FOUNDER 指出,他们的业务主要是出于避免盗版图片的目的使用检测技术,但在儿童安全这一更为严肃的场景下,无论是误报还是漏报,后果都是更加严重的。

互联网隐私领域的博客 THE HACKER FACTOR BLOG[4] 则对「一万亿分之一」这一数字的可信度提出了质疑。文章指出,既然 Apple 一向宣称对用户隐私不感兴趣,如何能得到一万亿份图像资料来印证这种准确性呢?如果训练素材的图片是来自第三方,那么其可靠性也不是 Apple 可以控制的。即使这个比例的依据是算法考虑的图片特征数量,「感知性哈希值」技术的 AI 属性也导致其错误率不是可以精准计算的。因此,「一万亿分之一」更可能只是一种估测和宣传口径。

关于这次儿童安全功能互联网上还有很多关于其他技术细节的讨论,受文章篇幅的影响没有办法一一列出。你对这项新功能有什么看法,或是有什么技术细节想要讨论,欢迎大家在评论区理性地留言和讨论。

引用链接

[1] 说明:

https://www.apple.com/child-safety/

[2] 官方问答:

https://sspai.com/s/l7jx

[3] RENT-A-FOUNDER:

https://rentafounder.com/the-problem-with-perceptual-hashes/

[4] THE HACKER FACTOR BLOG:

https://www.hackerfactor.com/blog/index.php?/archives/929-One-Bad-Apple.html

相关推荐

你的 iPhone 相册正在被监控?我猜你还没搞懂 Apple 新出的这个功能

垃圾信息入侵iPhone相册背后

为什么苹果一定要“扫描”你的相册?

你的微信正在被克隆,成为养号刷量的水军

iPhone的共享相册,堪称数码圈“一大奇观”

你的“脸”正在被交易

iPhone 12的这个隐藏功能,iPhone 13来实现?

远程扫描iPhone相册?苹果的好心网友不领情

iPhone 12 的这个隐藏功能,iPhone 13 来实现?

带口罩的你,还能等到iPhone的屏下指纹吗?

网址: 你的 iPhone 相册正在被监控?我猜你还没搞懂 Apple 新出的这个功能 http://www.xishuta.com/newsview48581.html

推荐科技快讯

- 1问界商标转让释放信号:赛力斯 95009

- 2人类唯一的出路:变成人工智能 19751

- 3报告:抖音海外版下载量突破1 19527

- 4移动办公如何高效?谷歌研究了 18985

- 5人类唯一的出路: 变成人工智 18857

- 62023年起,银行存取款迎来 10182

- 7网传比亚迪一员工泄露华为机密 8271

- 8五一来了,大数据杀熟又想来, 7340

- 9顶风作案?金山WPS被指套娃 7131

- 10大数据杀熟往返套票比单程购买 7077