MIT新研究:过去80年,算法效率提升到底有多快?

随着摩尔定律走向终结,靠提升计算机硬件性能可能越发难以满足海量计算的需要,未来的解决之道在于提升算法的效率。MIT的这篇新论文总结了过去80年来,算法效率的提升究竟有多快。

提起算法,它有点像计算机的父母,它会告诉计算机如何理解信息,而计算机反过来可以从算法中获得有用的东西。

算法的效率越高,计算机要做的工作就越少。对于计算机硬件的所有技术进步,以及备受争议的摩尔定律的寿命问题来说,计算机硬件的性能只是问题的一方面。

而问题另一方面则在硬件之外:算法的效率问题。如果算法的效率提升了,对同一计算任务需要的算力就会降低。

虽然算法效率问题可能不太受关注,但你是否注意到,经常使用的搜索引擎是否突然变快了十分之一,而在大型数据集中活动,就感觉就像在泥泞中跋涉一样艰难缓慢。

这些都与算法效率有关。

近日,麻省理工学院计算机科学与人工智能实验室 (CSAIL) 的科学家提出疑问:算法效率的提升速度到底有多快?

关于这个问题,现有数据大部分是叙事性的,其中很大一部分是面向特定算法的案例研究,再把这些研究结果加以推广。

面对实证研究数据的不足,研究团队主要利用了来自 57 部教科书和 1110 多篇研究论文的数据,以追溯算法效率提升的历史。

其中有些论文的结论中直接给出了新的算法有多高效,有的论文则需要作者使用“伪代码”(对算法基本细节的简单描述)进行重构。

研究人员总共研究了 113 个“算法系”,即解决计算机科学教科书中最重要的同一问题的算法集。他们对每个算法族的历史进行了回顾,跟踪每次针对某一问题提出的新算法,并特别注意更高效的算法。

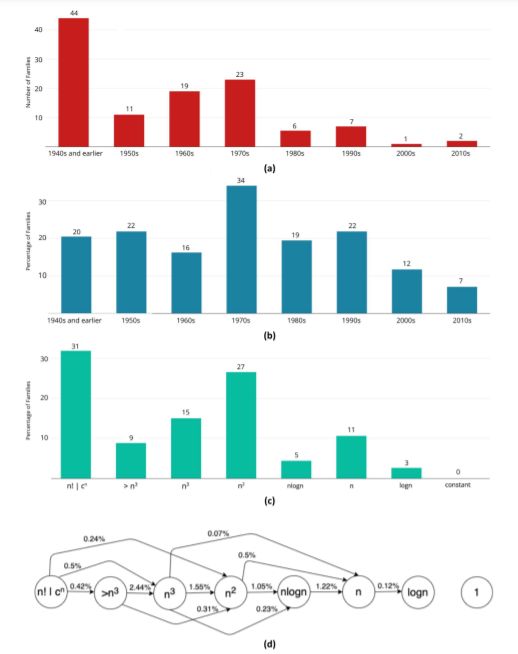

图1 算法发现和改进。(a) 每十年发现的新算法系的数量。(b) 已知算法系的比例每十年都有所提高。(c) 首次发现时算法系的渐近时间复杂度分类。(d) 同一时间复杂度的算法转换到另一个时间复杂度的每年平均概率(反应算法系复杂度提升的平均水平)。在(c)和(d)中“>n3”的时间复杂度表示超过多项式级,但不到指数级。

最早的算法系可追溯到上世纪40年代,每个算法系平均有 8 个算法,按时间顺序效率逐步提升。为了共享这一发现,团队还创建了“算法维基”页面(Algorithm-Wiki.org)。

研究人员绘制了图表,标识这些算法族效率提升的速度,重点关注算法分析最多的特征——这些特征往往决定了解决问题的速度有多快(用计算机术语说,就是“最坏情况下的时间复杂度”)。

图 2 算法系的相对效率提升,使用渐近时间复杂度的变化计算。参考线是SPECInt 基准性能。(a) 与该系列中的第一个算法(n = 100 万)相比,四个算法系的历史改进。(b) 算法改进对“最近邻搜索”算法系列的输入大小 (n)的敏感度。为了便于比较算法改进效果随时间的变化,在图(b) 中将算法系和硬件基准的起始时间段对齐。

结果显示,变数很大,但也发现了关于计算机科学变革性算法效率提升的重要信息。即:

对于大型计算问题,43% 的算法系的效率提升带来的收益,不低于摩尔定律带来的收益。

在 14% 的问题中,算法效率提升的收益远超硬件性能提升的收益。

对于大数据问题,算法效率提升收益特别大,因此近年来,这一效果与摩尔定律相比越来越明显。

当算法系从指数复杂度过渡到多项式复杂度时,情况出现了最大的变化。

所谓指数复杂度算法,就像一个人猜密码锁的密码一样。如果密码盘上只有一位数,那么任务很简单。如果像自行车锁一样,表盘是4位数,估计你的自行车很难有人偷得走,但仍然可以一个个试。如果是表盘是50位的,就几乎不可能破解了,需要的步骤太多了。

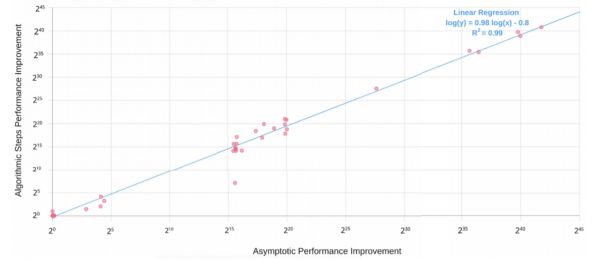

图3 基于渐近时间复杂度计算的110个算法系效率提升的年平均速度分布,其中问题规模为:(a) n = 1000,(b) n = 100万,(c) n = 10亿。硬件性能提升线表示从 1978 年到 2017 年,SPECInt 基准性能的平均年增长率

这类问题也是计算机面对的难题,随着问题的规模越来越大,很快就会超过计算机的处理能力,这个问题光靠摩尔定律是解决不了的。

解决之道在于找到多项式复杂度的算法。

研究人员表示,随着摩尔定律终结这个话题越来越多地被提及,我们需要将未来的解决方案的重点放在算法的效率提升上。

图4 前导常数在算法性能提升中的重要性评价

研究结果表明,从历史上看,算法效率的提升带来的收益是巨大的。不过二者之间存在着频度的差异,摩尔定律带来的提升是平滑而缓慢的,而算法效率的提升是阶梯式的跃进,但出现没那么频繁。

本文通讯作者尼尔·汤普森说:

这是业界第一篇说明算法效率提升速度的论文。通过我们的分析,可以得出算法改进后,使用同样的算力可以完成多少任务。

随着问题的规模不断增大,比如达到数十亿或数万亿个数据点,算法效率的提升带来的收益,比硬件性能的提升更重要,而且重要得多。

在我们开始逐步为算力不足发愁的时代,在摩尔定律越来越显出疲态的今天,这一发现可能为未来解决超大型计算问题开辟一条新的思路。

参考链接:

https://news.mit.edu/2021/how-quickly-do-algorithms-improve-0920

https://ieeexplore.ieee.org/stamp/stamp.jsp?tp=&arnumber=9540991

本文来自微信公众号“新智元”(ID:AI_era),来源:MIT,编辑:David,36氪经授权发布。

相关推荐

MIT新研究:过去80年,算法效率提升到底有多快?

中国快递到底有多快:从发货到送达 平均只需48小时

Wi-Fi 6 到底有多溜

绷紧肌肉就能操控无人机,MIT硬核研究:AI让你的麒麟臂变遥控器

36氪首发 |「XYZ Robotics」完成A轮融资,以手眼协调技术提升物流和工业自动化效率

剑桥大学新研究:用AI算法“监听”手机打字,触摸屏也中招

MIT出品的自动驾驶船,你敢坐吗?

MIT万字报道:竞争压力裹挟下的OpenAI,理想如何安置?

MIT搞机器学习种菜?不过是“韭菜”收割机罢了

MIT实验室研发出一种新设备,可以解析梦境

网址: MIT新研究:过去80年,算法效率提升到底有多快? http://www.xishuta.com/newsview50933.html

推荐科技快讯

- 1问界商标转让释放信号:赛力斯 95273

- 2人类唯一的出路:变成人工智能 21579

- 3报告:抖音海外版下载量突破1 21553

- 4移动办公如何高效?谷歌研究了 20718

- 5人类唯一的出路: 变成人工智 20712

- 62023年起,银行存取款迎来 10377

- 7五一来了,大数据杀熟又想来, 8945

- 8网传比亚迪一员工泄露华为机密 8569

- 9滴滴出行被投诉价格操纵,网约 8567

- 10顶风作案?金山WPS被指套娃 7258