晒着照片、聊着天,怎么就有人觉得我要犯罪了呢?

《少数派报告》《疑犯追踪》这样的影视作品或许只能在前些年出现。如果是近几年的影视作品,观众看着就会很「心慌」。

犯罪预防、预测模型、用系统推测未发生之事……这意味着大量的信息会被收集,也意味着你将会被一个未知系统判定是否有威胁。把命运交给未知的感觉,估计没几个人喜欢。

但不喜欢可能也没办法,因为在你不知道的时候,已经有越来越多公司在收集你的公开信息,来从你社交网络的日常内容中判断你犯罪的可能性。

社交媒体变身最大「告密者」,这是一场自我揭发?

Voyager、Kaseware、Aura、PredPol、Palantir,这是一部分正在试图通过社交网络找出潜在威胁的公司,它们中很大一部分还和当地的警察局进行了合作,走在预测犯罪的前列。

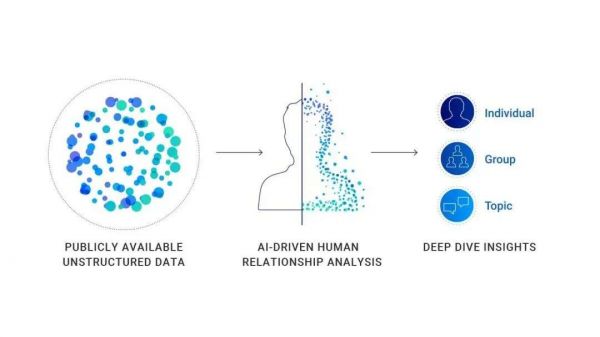

从每个人的社交媒体中获得需要的信息是这类公司的核心,他们通过用户做社交网络发布的内容来预估对方是否有犯罪的可能。这类公司的算法并不相同,但基本都在通过人工智能破译用户的线上,从用户分享的内容中判断主体是否已经犯罪、可能犯罪或坚持某种危险的意识形态。

这其实不算一个新进展,毕竟在 2012 年就有人将社交网络成为「城市脉搏」。你很难看到一个空间和产品同时容纳如此多的用户,还让他们愿意在上面分享自己的一切。

社交网络的特性为人们寻找目标创作了条件,学生在社交网络寻找受访对象,统计机构在社交网络预测大选结果,也有 AI 侦探想要在社交网络找出罪犯。

因为人人都用社交网络,所以社交网络很多时候可以反应一个人的真实情况。美国密歇根州的众议员 Tyrone Carter 认为警方搜索公共社交网络的行为并没有违背任何的法律,也没有侵犯用户的权利,所以这种预测是可行的。

当你在公共页面上点击发送的那一刻,那个帖子就不再是你的了。人们会因为他们发布的东西而陷入各种麻烦,因为社交媒体是我见过的最大的「自我告密者」。

但秘密只有在引导的时候,才会被说出。和洛杉矶警察局合作的 Voyager Labs 在这个过程中就担当了引导者的角色。只是非营利组织 Brennan Center 通过洛杉矶警察局提供的公开信息发现,Voyager 工作也涉嫌种族歧视、侵犯隐私。

Voyager 这类公司的工作方式并不复杂。它会收集一个人社交媒体上的所有公开信息,包括帖子、联系人甚至常用的表情符号。在某些特殊情况下,它会利用这些公开的信息与非公开信息交叉引用,进行进一步的分析和索引。

Voyager 会基于个人社交媒体的参与话题做出判断

通过 Voyager 的服务,警察可以清晰地看到一个人的社交关系。他们的联系是怎样的,他们在社交平台是如何互动的。更进一步,Voyager 甚至可以探测到两个用户之间是否有间接联系(两人都有至少四个相同好友)。

听上去好像只是看看用户在社交网络上做些什么,用作调查的辅佐信息。但事实上,Voyager 不仅收集信息,展示信息,它也会做出判断。

Voyager 会通过社交网络关系链做出判断预测

Voyager 在提交给洛杉矶警局的一份白皮书中就提到了一起袭击案件,该案件具体地展示了平台的做法——AI 在没有人介入的情况下会根据人们在社交网络发帖的内容完成自动审查和分类(分别为用户标记蓝色、橙色、红色三种颜色)。

在具体案例中,枪击案嫌疑人 Adam Alsahli 就因为自己在 Facebook 和 Instagram 上发布的伊斯兰主题照片,被系统判定为「对阿拉伯传统有强烈自豪感与认同感」。因此,Adam Alsahli 在发动具体的攻击前就被 Voyager 的人工智能工具打上了橙色的颜色标记。

这可以是一个成功预测潜在犯罪者的案例,同时也是一个充满「偏见」的案例。

枪击案嫌疑人 Adam Alsahli 的社交媒体信息,在他犯罪之前就已经被标记为橙色

数据预测犯罪?但数据也不能完全相信

这些结论真的可信吗?他们是根据什么做出判断的呢?大数据下每个人要如何自证清白?

目前确实有不少数据证实社交网络的内容偏向和犯罪事实的相关性,但这并不是一个 100% 关联的数据。

纽约大学坦登工程学院和全球卫生公共学院发布的研究结果显示,Twitter 上关于种族仇恨言论数量较多的城市,相关的犯罪率也更高;芬兰亦有研究表明,根据二十年的数据,温度每升高 1°C,犯罪活动就会增加 1.7%;美国研究证明,周末晚上的车辆盗窃率激增;被证明过的还有当地足球队意外输球时,家暴事件会增加 10%。

但这些并不能证明什么,因为概率和事实是不同的。

即便有相关数据背书,也不能证明在种族仇恨言论最多的城市,夏天周末的晚上就一定会有车辆被盗,炎热天气遇到当地主队输球 100% 就会有更多的家暴案件发生。

类似的犯罪预测系统是根据已有的犯罪事实和研究结果进行反推的,这造成的另一个问题是它充满了「刻板印象」。

图灵奖得主杨立昆就曾表示,当数据有偏见时,机器学习系统就变得有偏见。而具体到单一案例,当机器学习接收到的信息是监狱中男性黑人用户占比较大时,这样的系统可能就会做出黑人男性更容易犯罪的判断。

对机器学习来说,「黑人男性更容易犯罪」可能是数据分析的事实,但落在现实中这就会是种族偏见和差别对待。

暗中将用户进行评级,划分哪些更有威胁性,对于有威胁的人进行更密切的追踪和预防就是整套系统的运行逻辑。

类似的创业公司会用算法和人工智能来解释他们处理、分析信息,从而做出判定的过程。尽管目前没有证据证明这种预测是有效的,来自民众的质疑也很多,警察局却依旧想要和类似的平台进行合作。

对警察来说,这类工具很有吸引力,如 Voyager 这类平台在社交网络的发现可以提供用户侧写的有效辅助,也可以不错过线上的细微线索。如果仅仅是辅助调查,这就会是非常有效的工具。但工具发展到后期,开始发挥预测犯罪的作用时,也会成为伤人的利器。

经过前些年的狂热后融资后,不少 AI 产品已经进入了应用阶段。但在某些领域,它们依旧是辅助者的角色。

医疗就是一个对于 AI 介入慎之又慎的领域,即便是在进展最快的 AI 医学影像领域,今天的 AI 技术依然无法保证 100% 的正确率,需要人类医生的介入。因为人人都知道,医疗是一个需要近乎 100% 正确率的行业,任何的偏差和错误都可能造成严重的后果。

而警务领域同样是一个力求 100% 正确的领域,任何的臆测推断在缺乏证据的支撑下亦会造成严重的后果。一个在社交媒体上发表各种歧视、暴力言论的人可能会被标为潜在犯罪者,有 90% 的可能性进行暴力犯罪,但在他真的做出犯罪行为前,他就是一个普通人。

在总体的数据集之中,我们永远不能忽略每个人都是独立的个体。

图片来自:《少数派报告》

本文来自微信公众号“爱范儿”(ID:ifanr),作者:冷思真,36氪经授权发布。

相关推荐

晒着照片、聊着天,怎么就有人觉得我要犯罪了呢?

妈妈爱在网上“晒娃”,孩子长大了会作何感想?

人民日报:聊着聊着,为啥信息就被盗走了

特斯拉告诉拼多多:我要我觉得,不要你觉得

晒娃,你问过娃的意见吗?

少年与《我的世界》

都2020年了,怎么还会有人愿意签约MCN?| 超级观点

微信怎么又改版了?这次有人欢喜有人愁

Uber上市的夜晚:股票、敲钟、合影,以及中国前员工的身份记忆

Uber上市:Uber中国早期员工最少能赚几万块

网址: 晒着照片、聊着天,怎么就有人觉得我要犯罪了呢? http://www.xishuta.com/newsview54481.html

推荐科技快讯

- 1问界商标转让释放信号:赛力斯 94930

- 2人类唯一的出路:变成人工智能 19070

- 3报告:抖音海外版下载量突破1 18777

- 4移动办公如何高效?谷歌研究了 18316

- 5人类唯一的出路: 变成人工智 18170

- 62023年起,银行存取款迎来 10108

- 7网传比亚迪一员工泄露华为机密 8155

- 8顶风作案?金山WPS被指套娃 7088

- 9大数据杀熟往返套票比单程购买 7037

- 10五一来了,大数据杀熟又想来, 6702