「可信AI」攻坚战:互联网大厂的「生死攸关」时刻

近年来,「可信AI」逐渐成为人工智能领域的热门话题之一,以人工智能为基础支撑业务的互联网科技大厂更是打了头阵。

今年6月,蚂蚁集团在全球人工智能大会上首次公布了「可信AI」技术架构体系。今年7月,京东探索研究院在世界人工智能大会上发布了中国首个《可信人工智能白皮书》。两家企业都将隐私保护、鲁棒性/稳定性、可解释性、公平性作为「可信AI」的四大基本原则。

而若细究,有关隐私保护与公平性的呼吁又远远早于名词「可信AI」的出现。比方说,微众银行、同盾科技等金融科技公司早早就开始布局数据隐私,应用联邦学习、差分隐私等技术对数据进行保护,以驱动数据依赖模型的研究与发展。

「可信AI」是什么?为什么互联网大厂频频下场、以致数字江湖会掀开这样一场轰轰烈烈的研究热潮?

更重要的是,除了企业界,学术界也纷纷投入其中。比如,今年10月,哥伦比亚大学数据科学研究院主任、ACM与IEEE双Fellow周以真便在权威期刊《ACM通讯》上发表了《可信人工智能》一文,详述了「可信AI」的前世今生、基本内核与研究意义。

与「AI伦理」不同,「可信AI」除了呼吁技术发展以人为本,更从人工智能技术本身出发,强调提升人工智能算法与模型的鲁棒性与可解释性。换句话说,如果「AI伦理」是人工智能社会的道德准则,那么「可信AI」就相当于人工智能时代的法律手段,将有机会从根源上制约人工智能技术的弊端。

但为何「可信AI」的研究首先是在工业界发起,而后蔓延到学术界?目前,「可信AI」的研究主体又为何是互联网科技大厂?

原因也很简单:人工智能在大规模的落地应用中出现了许多「信任危机」问题,无论是普通用户还是权威学者都产生了对人工智能算法的担忧。作为应用人工智能技术的主力军,如果互联网大厂不积极解决人工智能的信任问题,则很可能面临被淘汰的命运。

01. 一场被用户「倒逼」的技术革命

大厂们不得不开始直视一个问题:大众对人工智能的信任度正在降低。

众所周知,当前基于神经网络的AI技术具有不可解释、鲁棒性差、过于依赖数据等通病,内含「兽性」,在给人类社会带来前所未有的便利时,也蕴含着许多潜在的危害。

这样的例子,在互联网上并不少见。

据英国《每日邮报》报道,2015年2月,英国进行了首例机器人心瓣修复手术。这场手术使用的是被誉为「外科机器人界的波士顿动力」的达芬奇手术机器人。然而这样原本是一场最尖端医疗AI技术的展示却以惨痛的失败告终。由于手术过程中,血液溅射到摄像头上造成机器「失明」,导致机器人把病人的心脏「放错位置」,并戳穿了大动脉。最终,接受手术的患者在术后一周去世。

2016年9月,央视《法治在线》栏目报道了一起发生在河北邯郸段公路的严重事故。一位青年在驾驶特斯拉轿车行驶时,因未能及时躲避前方道路清扫车发生追尾,事故导致该名青年身亡。据事故后行车记录仪中的视频分析,事故发生时,特斯拉处于「定速」状态,因未能识别躲闪而撞上前车。这被认为是国内披露的首起特斯拉自动驾驶功能(Autopilot)使用中发生的车祸致死案例。

源于这些真实发生的惨案,大众对 AI 的信任度大大降低。因此,即使已有无数的研究调查表明,使用自动驾驶系统的车辆事故发生率远远低于现有车辆驾驶方式的事故发生率,但质疑的声音仍然存在:

「在自动驾驶中,决定交通革新成败的,不是99%的准确度,而是1%的失误率。」

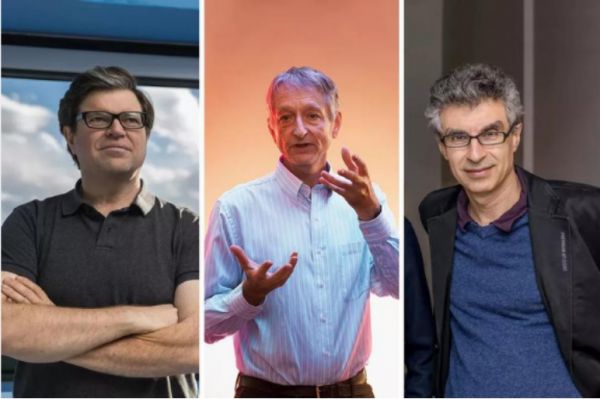

当前的人工智能发展以深度学习为主,而深度学习算法最常标榜的便是「准确率高达99.99%」。由于深度学习模型的「黑匣子」特征,即使2018年凭借深度学习与神经网络的成就获得图灵奖(计算机领域的诺贝尔奖)的「深度学习三巨头」,也无法自信地说,某一算法可以达到100%的准确性。

深度学习三巨头,从左到右是Yann LeCun、Geoffrey Hinton与Yoshua Bengio

由此出发,当准确率估计只能达到99%的深度学习算法在现实生活中落地时,便会带来许多不容小觑的问题。比如,假设未来一座城市有十万辆自动驾驶汽车,那么根据最高准确率为99%的概率推算,则可能对人类出行安全造成威胁的隐患车辆仍有一千辆。

除了「不可解释性」,人工智能系统在现实生活的落地中还呈现出了许多由不公平的设计、不稳定的模型结论与侵犯隐私等问题所引起的「用户信任危机」。当中所牵涉的企业与用户也不仅仅是自动驾驶行业,而更多是「全民危机」。

例如,AI技术已成为互联网行业发展不可缺少的原动力之一。然而,在AI赋能数字经济的过程中,AI算法的弊端也频频出现,使得企业推出的AI产品引发了部分用户担心,质疑的声音层出不穷。

例如,部分电商平台存在大数据杀熟现象;内容平台则存在用户在推荐算法下接收的资讯内容同质化的现象;去年《人物》报道,外卖系统用算法将骑手困在系统里;社交平台也有因监管不当暴露个人隐私数据的问题;而在金融场景中,贷款保险等业务背后也存在由AI算法评级引发的公平性问题。

更直接的例子也仍要举交通出行。虽然并不是人人都会选择购买准确率仅最多达99%的自动驾驶汽车,但当代居民的日常出行几乎都离不开乘车平台。平台运用人工智能系统进行司乘匹配、路线规划与自动派单,在为人们的出行带来极大便利的同时,也出现了许多由人工智能技术不完善所引起的问题,比如路线规划不合理导致多收费、显示接送到达时间与实际严重不符等等。

算法公平性的背后存在人为和非人为的两种基本因素。如果说企业利用人工智能进行「大数据杀熟」,是可控的企业道德问题(企业试图牟利),那么类似将「被投诉次数多」的司机正常分派给用户、导致乘客人身安全受威胁的行为,则很大可能源自人工智能系统本身的「不可控」技术缺陷。而所谓的「不可控」是指,传统的人工智能模型在决策过程中存在「黑盒」问题,即推理过程不透明。

AI 技术所带来的便利和 AI 技术「不可信」之间的矛盾,正逐渐成为 AI 在现实生活中大规模落地应用的核心问题。

举个例子:在医疗场景中,如果一个病人无法信任AI,那么Ta就不会听从AI系统所给出的诊断结果与医疗建议,哪怕这些诊断是正确的、对病人是有益的。同样地,无论企业跟用户吹嘘自动驾驶的技术有多牛,如果没有万全的保障,我们也不敢把「开车」交给AI;即使支付宝等在线支付平台再便捷,若所使用的人工智能算法会导致用户的金钱损失,我们也不会再使用。

因此,提高大众对人工智能的信任变得至关重要。

02. 企业为何入场「可信AI」?

针对AI在落地中所产生的负面影响,除了全球范围内目前由政府组织发布的近150份AI治理原则与共识,如2019年的「G20人工智能原则」中强调「促进可信AI的创新」,欧盟在2019年发布《可信AI道德准则》,工业界与学术界也纷纷觉醒,主动出击,倡导研究「可信AI」。

那么,京东、蚂蚁、腾讯等等企业为何纷纷入场「可信AI」?甚至谷歌也设立了「AI伦理团队」?

一个直接的原因是:信任是商业的基石。2002年1月,时任微软掌舵人的比尔盖茨便在致员工与股东客户的《可信计算》备忘录中提出构成「可信」的四大因素是安全、隐私、可靠与商业诚信。

随着人工智能信任危机的发酵,普通用户从消费者的角度出发,对人工智能产品的态度愈发谨慎;学者从技术研究的角度出发,对人工智能模型的自身缺陷所可能引发的现实应用后果产生担忧;而企业从经营的角度出发,不得不面对应用人工智能赋能数字经济时所要解决的用户信任、技术隐患与同行竞争等问题。

近年来,各国政策在人工智能的落地中,也十分强调「以人为本」。换言之,用户是政策的核心保护者。比方说,2018年5月,具有「史上最严格的隐私和数据保护法」之称的欧盟《通用数据保护条例》(GDPR)正式生效,法国数据保护局(CNIL)则以违反GDPR为由,对谷歌处以创纪录的5000万欧元罚款,为应用人工智能等技术赋能经济的全球企业打响了警告枪。

除了用户的信任问题,企业之所以要入场「可信AI」,还有两个容易被忽略的原因:

一,企业也面临自身的风控问题。与游戏中机器人的临场停滞不同,人工智能系统在医疗、金融、出行等场景中的漏洞和失误,可能造成的金钱与安全损失是无法弥补的。

类似支付宝这样的互联网支付平台,每天都会受到上亿次的黑产攻击。他们每天都在面临一种「如果你不跑、黑产就会跑到你前面」的情况,若速度比黑产慢,成千上万的支付宝用户资金安全就会受到威胁。这时,支付宝所应用的风控模型与算法鲁棒性变得至关重要。

二,当前AI对人类社会的影响逐渐加深,在越来越多的场景中成为人工的替代品,如果企业没有提前做好防御与准备,则可能在新一轮的市场竞争中被淘汰。

比如,同样是网约车平台,任何一家企业能够率先研究出更强大、更稳健的人工智能派单系统,减少司乘匹配劣质率、提升乘客与最近距离的司机匹配率以减少乘客等候时间、自动提供最优且公平的出行价格,那么这家企业将能最大程度地降本增效,获得市场竞争优势。

再比如,在线支付平台中,如果支付宝不积极改进人工智能算法的鲁棒性和可解释性、而是依赖人工方式去筛选与识别欺诈电话,人力成本将大幅增加;同时,如果应用原有鲁棒性差的模型进行筛选识别与防御,无法跑赢黑产,那么其遭受的损失亦是无以估量的。这时,若竞争对手在「可信AI」上率先研究出更稳健的系统与算法,则支付宝会失去原有城池,或面临被淘汰的命运。这或许也是蚂蚁集团早在2015年就启动可信AI相关研究的核心动力。

2018年9月,麦肯锡全球研究所发布了一份长达60页的报告,分析了人工智能对全球经济的影响,明确指出:在2030年之前,人工智能将在全球范围内产生13万亿美元的经济效益,使全球GDP每年增长约1.2%;此外,人工智能的应用可能会扩大企业与企业之间的差距,人工智能领先企业在2030年前有望实现回报翻倍,而延迟使用人工智能技术的公司则会远远落后。

03. 企业如何应对?

迫于越发收紧的政策压力、用户信任,与黑产追击等问题,国内外大厂不得不主动或被动地投身于「可信AI」的研究中,通过实际的行动来控制人工智能技术对人类社会所可能产生的负面影响。

比如,GDPR罚款事件后,谷歌在2019年推出「遗忘算法」,允许用户删除其在谷歌网页或Youtube上删除个人隐私数据,并承诺会在特定时间(18个月)内自动删除用户的位置信息、浏览记录等。

在互联网时代,除了诚信,人们还要考虑数据安全的问题,而数据泄露是信任危机诞生的主要来源;而到了AI时代,除了更严峻的数据安全问题之外,算法的统计性质所带来的不可控性、AI系统的自主学习性与深度学习「黑匣子」模型的不可解释性,也成为了导致用户信任危机的新要素。

这时候,信任问题已经不完全取决于企业自身的意愿,还取决于企业对AI技术(数据,算法等)的理解与掌控程度。所以,从企业的角度看,有意愿去推动「可信AI」,只是解决用户信任问题的第一步。问题的关键,还是在于企业能否从底层技术上实现AI的可信性。

一个普遍的偏见是:国内大厂对「可信AI」的意识要远远落后于欧美各国。但事实是,早在2015年2月,蚂蚁集团就已启动基于「端特征」的手机丢失风险研究项目,迈出了端云协同风控研究的第一步,旨在保护用户的隐私安全。2017年6月,蚂蚁又发布具备智能攻防能力的第一代智能风控引擎AlphaRisk,在用户集中的支付宝端进行风险防控。至2021年首次对外披露技术架构,蚂蚁集团已经完成了长达6年的「可信AI」技术积累之路。据2021年6月权威专利机构IPR daily发布的《人工智能安全可信关键技术专利报告》显示,蚂蚁集团旗下的支付宝在该领域的专利申请数和授权数,均位列全球第一。

总的来说,企业在「可信AI」上的工作主要分为三部分:文书呼吁,企业管理与技术研究。

文书方面,最著名的莫过于京东探索研究院今年发布的《可信人工智能白皮书》,还有微众银行领衔的《联邦学习白皮书》。当然,可信 AI 不能只停留在原则和共识上,还需要落实到技术实现和组织文化中。

企业管理上,商汤科技在去年1月成立了人工智能伦理治理委员会,并于今年上半年上线了伦理审核系统,建立贯穿人工智能系统生命周期的风险管理系统,对将要落地的人工智能系统进行全过程的追溯和审查,为国内科技企业做出了表率。

在技术研发层面,实现「可信AI」的途径主要是两方面:数据与算法。数据问题集中在隐私保护和安全、数据偏见以及由此带来的不公平,而算法问题则在于可解释性与稳健性(又称为「鲁棒性」)。

数据、算法与算力被举为人工智能研究的「三驾马车」,随着用户对隐私数据的保护意识加强、数据泄露所带来的风险加大,如何在「数据保护」与「数据驱动的AI研究」中谋求两全之策,将成为「可信AI」的热门研究方向之一。

除了数据隐私保护,要实现「可信AI」,工业界与学术界的研究者目前所面临的问题与未来要集中解决的方向还有如下几个维度:

1)数据的公平性

AI的训练结果直接依赖于输入的数据。然而受数据采集条件的限制,不同群体在数据中所占的比例并不均衡,例如当下 NLP 训练语料大多是英语和中文,其他 8000多个少数语种很难融入到AI世界当中;而由于学习语料的问题,AI简历筛选时往往会自动过滤掉包含特定关键字的求职候选者,使之成为「AI透明人」。

2)算法的稳定性

针对 AI 模型的数据和系统存在多种攻击方式,例如中毒攻击、对抗攻击、后门攻击等。举例来说,通过向模型中投喂恶意评论,便可以影响推荐系统的准确度;在交通标志牌上贴上特殊设计的图案,便可以误导自动驾驶系统错误识别。

另一方面,干扰的形式也正在逐步从数字世界向物理世界蔓延,例如通过打印对抗样本等手段,直接对自动驾驶和人脸识别系统造成物理层面的干扰。

3)算法的可解释性

以深度学习为代表的机器学习算法,本质上是一个端到端的黑箱。一方面,人们对训练得到的人工智能模型为何能具有极高的性能尚不清楚;另一方面,人工智能系统在做出决策时具体依赖哪些因素,人们也不清楚。比如,曾有实验者向GPT-3(自然语言处理模型)提问「新冠疫情何时结束」,它的回答是「2023年12月31日」,但答案的依据是什么?研究者无从解释,也自然难保其准确率。

《疑犯追踪》(Person of Interest)剧照

针对上述问题,国内各大厂纷纷开始布局研究,寻求可行的技术手段,以解决通往「可信AI」道路上的「拦路虎」。

就拿数据隐私保护来说。「分布式计算」、「联邦学习」等支持「数据可用不可见」的新兴技术在工业界十分火热,尤其受到了蚂蚁集团、微众银行、同盾科技等企业的青睐。2017年11月,蚂蚁联合美国伯克利大学启动人工智能开源项目Ray,通过分布式平台为开发者提供计算资源及任务调度支持,并在其社区内围绕隐私保护、智能风控、智能搜索等应用场景持续为开发者提供开源支持;2019年,微众开源了首个工业级联邦学习框架FATE。

模型鲁棒性方面,国内厂商在对抗学习的研究上积极投入。2017年9月,蚂蚁提交了第一项文本对抗相关的专利《一种基于拼音扩展特征识别文本内容风险变种的方法》,并在后续的3年间,针对内容安全场景持续探索智能对抗技术方案,合计申请专利31项 。百度提出并开源对抗样本工具箱包「Advbox」,使用先进的生成方法构造对抗样本数据集来进行对抗样本的特征统计、攻击全新的AI应用,通过对抗攻击加固业务AI模型,提升模型的安全性。

在可解释性的应用研究上,国内大厂的表现也尤为突出。2018年9月,蚂蚁上线了反洗钱的智能报文系统,针对反洗钱监管合规要求,自动输出包含风控原因及处理方案的报文内容;2020年,蚂蚁研发出可解释图算法Risk-alike,能够在欺诈案件中主动审理场景落地。

纵观国内各大厂对AI技术的治理,不难发现:以商汤为代表的感知智能技术研发更着重于「AI向善」的应用管控。而相比感知智能,「可信AI」在以金融为代表的风险敏感场景中利害更为鲜明,研究也更为深入、彻底。

在可预见的未来,金融、医疗、出行等等与人类社会现实息息相关的企业或将成为「可信AI」的研究主力军,并涌现大量可以期待的关键技术成果,从技术端引导人工智能造福社会。

04. 企业的责任心

一家企业能够做出突破性的 AI 技术,它将走得很快;但只有将自己的 AI 技术变得可信,它才能走得更远。「AI 突破」和「AI 可信」正如打江山和守江山一样,前者更会让人壮怀激烈,但后者才是安稳生活的保障。

在打造「可信AI」的过程中,企业是一股不容小觑的力量。一方面,企业是技术研究的主力军;另一方面,企业又是AI落地问题的发现者。在思索如何推动AI商业化的过程中,企业所发现的难题,反哺于学术界,可以加速解决AI落地的种种难题。

此外,企业又是推动AI技术在人类社会中产生价值的先锋者。最终,在实验室取得的AI创新成果,无论正面或负面,都须经过企业的产品化,将其提供给用户,影响到个人。

在这种过程中,保护用户,也是守护企业自身。虽是一场被黑产和用户倒逼的技术革命,「可信AI」的危机却并非源于大众对科技的愚昧与自身思想的顽固,而是人工智能本身的技术仍未发展完善。诚如前述,当前「可信AI」的研究仍存在许多亟待攻破的技术难题。

企业冲锋,学界掩护,各方力量联合。只有当越来越多的研究者参与其中,AI实现「可信」方才指日可待。

参考链接:

1. Bughin, J., Seong, J., Manyika, J., Chui, M., & Joshi, R. (2018). Notes from the AI frontier: Modeling the impact of AI on the world economy. McKinsey Global Institute, Brussels, San Francisco, Shanghai, Stockholm.

2. Trustworthy AI

https://cacm.acm.org/magazines/2021/10/255716-trustworthy-ai/fulltext

3. Bill Gates: Trustworthy Computing

https://www.wired.com/2002/01/bill-gates-trustworthy-computing/

4. Google Will Delete Your Data by Default—in 18 Months

https://www.wired.com/story/google-auto-delete-data/

5. ETHICS GUIDELINES FOR TRUSTWORTHY AI

https://ec.europa.eu/newsroom/dae/document.cfm?doc_id=60419

相关推荐

防疫攻坚战,潜力巨大的区块链为何失色?

脉脉,互联网大厂最想收编的公司

战“疫”24天:互联网大厂生死竞速

我在互联网大厂实习

伦理即服务:科技伦理与可信AI的下一个浪潮

互联网大厂“抢填”高考志愿

互联网大厂的「关键先生」

AI声称找到外星生命,但科学家认为并不可信

5000字周报,160小时加班,大厂卷出新高度?

互联网大厂实习“避坑指南”

网址: 「可信AI」攻坚战:互联网大厂的「生死攸关」时刻 http://www.xishuta.com/newsview57023.html

推荐科技快讯

- 1问界商标转让释放信号:赛力斯 94998

- 2人类唯一的出路:变成人工智能 19666

- 3报告:抖音海外版下载量突破1 19423

- 4移动办公如何高效?谷歌研究了 18901

- 5人类唯一的出路: 变成人工智 18773

- 62023年起,银行存取款迎来 10172

- 7网传比亚迪一员工泄露华为机密 8253

- 8五一来了,大数据杀熟又想来, 7262

- 9顶风作案?金山WPS被指套娃 7129

- 10大数据杀熟往返套票比单程购买 7075