对网络暴力Say NO,AI算法如何辨“好坏”?

社交平台、短视频平台等公共网络场所,已经成为网络暴力行为的高发地。

在刚结束的冬奥会上,就有不少人通过网络平台的评论和私信功能,对冬奥选手进行诋毁、侮辱攻击、散布不实谣言,对冬奥观赛和社区氛围造成了极大的伤害。

事实上,网络暴力由来已久。

由于网络暴力往往处于灰色地带,大部分暴力行为都尚未构成诽谤和侮辱,因此很难对网络暴力实施者处以刑罚或者行政处罚。

网民的言论只要不超越法律底线,有权自由发表言论。

为了应对网络暴力行为,全球大多数的社交平台都采用了言论投诉、评论过滤、评论/私信关闭、好友关注过滤等功能,在一定程度上缓解网络霸凌的问题。

但限制性的功能类似于黑名单,并不能完全将网络暴力扼杀在摇篮,只能在恶意语言/图片/视频出现后进行封堵,不幸的是负面影响已经扩散开来。

那么,能否采用技术的手段从源头就识别网络暴力行为呢?

01 以AI技术制止网络暴力,成为全球研究者共同的选择

2016年,以“贾斯汀·比伯退出Instagram”为导火索,Instagram首次推出了负面评论过滤功能。之后,Instagram还通过机器学习来处理含有攻击性信息的照片。

2019年,Instagram又推出两大反网络暴力功能,即言论提醒和自主选定黑粉功能,用来帮用户抵制网络暴力。

其中,言论提醒功能利用AI技术,在冒犯性言论发表之前,向发言者发出提醒。比如:当某用户输入了“你又丑又蠢。”并点击发布时,AI会发出“请为Instagram保持一个友好环境”的提醒。

“通过获得这种干预,人们有机会反思和撤销他们的评论,使收件人避免收到有害评论通知。”Instagram主管Adam Mosseri表示,“经测试,我们发现这项功能确实有引导作用,能使一些用户撤销评论或修改评论内容。”

近日,抖音也推出了类似的防网暴功能,并升级为AI技术和人工审核相结合的方式,对违规用户进行引导和帮助。

当用户发布违规或低质评论之后,抖音会对该评论进行模型匹配和校验,用户会立即收到评论弹窗警示,提示“该评论可能对他人造成负面影响”,给用户一个回心转意的机会。

当然,弹窗可以跳过并继续发布评论,但将不会被其它人看见,此时评论会进入正常审核逻辑,真正的违规评论依然会被处理。

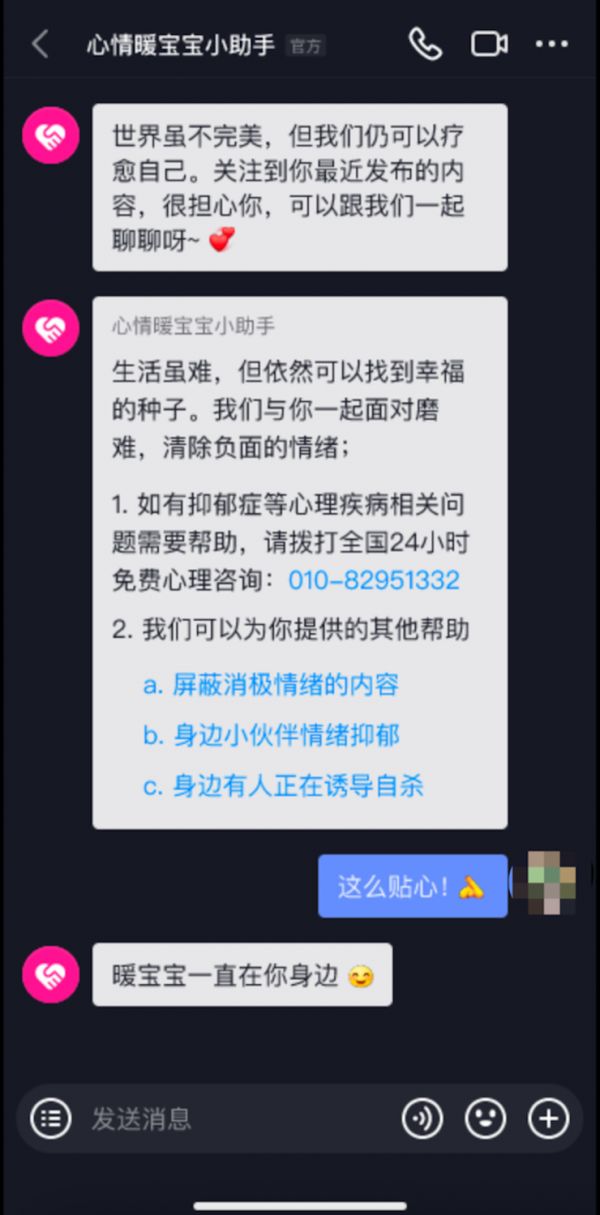

此外,抖音在防网暴系统中还新增了名为“心情暖宝宝”的平台助手。

如果用户多次违规发布私信、评论,AI算法可以自动匹配触发“心情暖宝宝”,用消息对话尝试缓解用户的抑郁情绪,甚至引导用户去人工求助、线下就诊。

此外,用户也可以自主在推荐、搜索、评论等场景减少负面内容推荐。

除了识别谩骂/骚扰信息等明显的负向内容,如:反讽攻击、答非所问、垃圾广告导流这类“阴阳怪气”的内容,在不同讨论语境下也会引发不同情绪,这更为AI算法识别带来了极大挑战。

对此,2018年知乎就通过AI技术尝试处理阴阳怪气的言论。“瓦力”作为知乎社区治理的算法机器人之一,能在0.3秒内识别判断内容是否为不友善、答非所问、阴阳怪气等多种需被折叠的答案。

“我们基于对于用户切实体验的累积观察,与算法团队一起,从情感倾向性、亲密关系、文本特征三方面入手,训练出能够识别阴阳怪气的算法模型。

目前‘瓦力’对阴阳怪气评论文本的识别准确率,已非常接近社区最大公约数,比很多人工判断都更准。”知乎运营总监孙达云表示。

所谓“社区最大公约数”指的是社区共识,即长久积淀下来知乎和用户共同认可的一种公约,知乎称之为知友们对价值判断的最大公约数,比如“知乎不让骂人”,比如“对优质内容的界定”等。

知乎在过去多年中所累积的“举报”等带有用户筛查性质的行为语料和丰富的社区管理经验,使得知乎得以迈出关键一步:用社区最大公约数作为判定尺度。

在算法方面,通过400多个前沿的深度学习模型识别过亿内容,现在的知乎平台,可以智能地进行倾向性识别、爆照识别、风险图片识别等等。

02 制止网络暴力背后的AI技术:自然语言处理

在人类无法兼顾的海量信息中,AI技术的介入显然为制止网络暴力提供了一条捷径。

想要对评论、弹幕这样成千上万的非结构化语言数据进行分析,自然语言处理(NLP)就成为研究者必须面对的核心AI技术。

作为AI的一个子领域,自然语言处理致力于让计算机也能够理解和处理人类语言,使计算机更接近于人类对语言的理解。

事实上,人类读写文字的历史已经有几千年了,我们的大脑在理解自然语言方面积攒了大量的经验。

当我们阅读文字时,很快就能明白其中的含义,并感受到这些东西引发的情感。

但是想让机器也拥有人类对语言的理解和情感,是一件非常困难的事情。之所以自然语言处理技术被誉为“人工智能皇冠上的明珠”,一方面表明了它的重要性,另一方面也显现出了它的技术难度。

如今,深度学习的兴起,让自然语言处理技术得以进一步发展,让机器能够自动学习语言特征,掌握更高层次、更加抽象的语言特征,目前已广泛应用于机器翻译、舆情监测、自动摘要、观点提取、文本分类、问题回答、文本语义对比、语音识别、中文OCR等方面。

在生活中,从语音助手Siri、微软小冰、小爱同学,到语音输入、谷歌翻译、水军检测等,随处可见自然语言处理技术。

那么,在制止网络暴力方面,自然语言处理技术是如何应用的?具体而言,涉及以下几个方向:

情绪解析

情绪极值:以50分为分界,对整体正负面情感特征打分;

十二种细节情绪:根据Plutchik情感轮理论体系,识别语义中12种不同细节情绪;

情绪值/浓度:计算出语句的情绪浓度,即反映了特定情感的激烈程度;

情感关键词:从文本中智能识别并提炼对文本整体情绪影响最大的关键信息。

基于情绪解析引擎,可以针对某条内容所表达的情绪极值以及十二种细节情绪进行全量分析,从而详细了解千万条评论内容中网民们的整体情绪分布;

其次,还可根据时间段来看随着时间的推移网友们对这件事的态度的变化,即是否还是那么厌恶/喜欢;

再者,结合第三方数据——如用户地域、性别等信息,还可以对不同人群的肖像进行更精细地刻画。

文本观点提取

基于知识图谱以及字词间的相似度计算,高度精炼、概括每段话的核心表达观点。

例如:“喜欢这个妆容,但是口红颜色太深了”,观点1:妆好;观点2:口红深。

对海量评论进行观点提取,可以精准、高效地总结不同网民对于同一件事件所表达出的不同观点,并可以对其进行归类和比较,帮助分析人员在第一时间获取用户的关注热点信息或是用户最反感的主要问题等关键信息。

文本相似度判断

一对一、一对多或多对一的文本匹配,从理解不同字词所表达的含义入手,结合知识图谱,判断两段文本核心观点的一致程度。

例如:对同一事件或两个不同事件的评论进行相似度对比,可以根据结果看看用户在用词或表达上有什么共同点。不同事件间的评论对比,还能帮助发现“恶性”事件及其评论内容之间的潜在关系,甚至能洞察出某件事/某个人近期的活动形象会不会影响对其舆论的积极/消极性.

词法分析

句式分析:对文本内容中字词的解读,依照文本核心观点表达,将字词拆分成有语法含义的序列;

词法分析:基于知识图谱以及字词间的关系分析,可以展示出每个字词的词性和语法结构。

针对网民们成千上万条评论,可以通过词法分析引擎来观察积极评论或消极评论分别常用的用词习惯、句式、词法。

从中可以总结出当下网民普遍所使用的的话术/用词习惯,以及不同人群在表达自己观点时所特有的语言特点。

总体而言,基于自然语言处理的技术手段对网络暴力文本进行分析,不仅能及时控制负面影响扩散,也能让监管机构和平台运营商更好地了解网络暴力事件产生成因。

03 AI算法升级:上演“疑犯追踪”

如果说自然语言处理是基于对网络暴力文本及用户行为的综合分析,当不能检测评论内容的情况下,能否精准地识别出潜在的网络暴力者?

近日,日本德岛大学的计算机研究者联合日本大型网络公司代理商Cyber Agent在《人类行为计算》上发表论文,他们用机器学习的方法,分析了Cyber Agent旗下一款社交类游戏的使用数据,并且在不监测聊天内容的情况下,仅基于聊天次数、聊天对象、聊天时间等基本信息,就能较为精准地识别出潜在网络违法者,并预测出违法行为的大概时间。

研究者基于两种传统犯罪学理论开发了这套算法:日常活动理论和社会传染理论。

日常活动理论提出,许多犯罪行为并不是随机发生的,犯罪者和被害人往往在日常活动中有交集。

例如,在现实生活中,小偷在盗窃前会去目标地点踩点,并观察目标人物的行为规律;同样的,网络上的犯罪者更需要提前与“猎物”取得联系,套取信任。

因此,玩家的社交活动数据中或许就藏着“犯罪预告”。

另外,社会传染理论还补充了重要的一点:违法倾向或违法行为也会传染。最常见的例子就是网络暴力。

网络暴力往往来源于某种过激情绪的广泛传播:在群体的裹挟下,有的人不知不觉就失去了独立判断能力,无意间成为了网上的施暴者。

在这两种理论的基础上,研究者选择了是一款名叫Pigg Party的手机游戏。

它主打社交功能,用户登录账号后,可以装扮虚拟的房间和个人形象,与朋友或陌生人以私聊、群聊、公聊的方式进行交流。

研究人员采用擅长从复杂数据中提取特征的算法——多层非线性模型,对55万用户6个月内产生的聊天数据,包括每名用户的聊天频率、聊天时间、消息的接收者等进行了分析。

研究者组合多种神经网络模型和算法,搭建了预测违法事件的人工智能。

性能测试结果显示, AI能根据用户数据,较为准确地预测未来的违法者和受害者账户。输入用户两个月内聊天的时间、频率、对象,AI对接下来两个月内违法账户的预测准确率可以达到84.85%,对受害者账户的预测准确度也接近85%。

除了对个体账户违法或受害的风险有较好的预测能力外,只需提供一周内的用户活动数据,AI就能基本精准地预测接下来的一周网络社区里发生违法事件的时间,对小时和日期的预测准确率高达95.83%和85.71%,并且结果与预测受害给出的时间相吻合。

更有趣的是,AI分析数据后预警发生违法事件的时间,并不一定处在以往发生违法事件的时间段中,可见它掌握的并不仅仅是固定的规则,还有违法者言行中的真正“逻辑”。

研究者认为,借助AI,系统管理员能更好地维护网络安全和用户权益。尽管目前的AI并且不能进一步预测违法事件的具体类型,但它或许能抓住网络上“隐形”的违法者,更好地保护我们的安全。

本文来自微信公众号 “科技云报道”(ID:ITCloud-BD),作者:科技云报道,36氪经授权发布。

相关推荐

对网络暴力Say NO,AI算法如何辨“好坏”?

网络暴力黑产化,个人和社交平台如何守住防线?

GTP-3算法是一种“暴力美学”的胜利

如何全面客观评估5G网络的好坏?这才是正确姿势

“隔空”盗刷来袭 警方提示如何辨“异象”

调查显示部分女性因网络暴力远离社交平台

AI裁员:后疫情时代「打工人」如何与算法共存?

从资方角度看,如何评价网易的暴力裁员?

AI新贵上位记:图网络是怎么火起来的?

AI算法是服务了你,还是操纵了你?

网址: 对网络暴力Say NO,AI算法如何辨“好坏”? http://www.xishuta.com/newsview59597.html

推荐科技快讯

- 1问界商标转让释放信号:赛力斯 95273

- 2人类唯一的出路:变成人工智能 21579

- 3报告:抖音海外版下载量突破1 21553

- 4移动办公如何高效?谷歌研究了 20718

- 5人类唯一的出路: 变成人工智 20712

- 62023年起,银行存取款迎来 10377

- 7五一来了,大数据杀熟又想来, 8945

- 8网传比亚迪一员工泄露华为机密 8569

- 9滴滴出行被投诉价格操纵,网约 8567

- 10顶风作案?金山WPS被指套娃 7258