人工智能会脱离控制、毁灭人类吗?

神译局是36氪旗下编译团队,关注科技、商业、职场、生活等领域,重点介绍国外的新技术、新观点、新风向。

编者按:针对超级人工智能出现后对人类产生威胁的话题已经老生常谈了。已经有许多的专业人士正在就这一威胁可能带来的风险而进行研究了。人类的出路要么在于拥有一招关闭人工智能的法宝,要么在于让人工智能习得人类价值观,或者研究所谓的友好型人工智能,但所谓的友好绝对不意味着利他主义或者爱,而是指它们不会在实现自己目标的过程中把我们消灭掉。本文作者Mara Hvistendahl,原文标题Can AI Escape Our Control and Destroy Us?

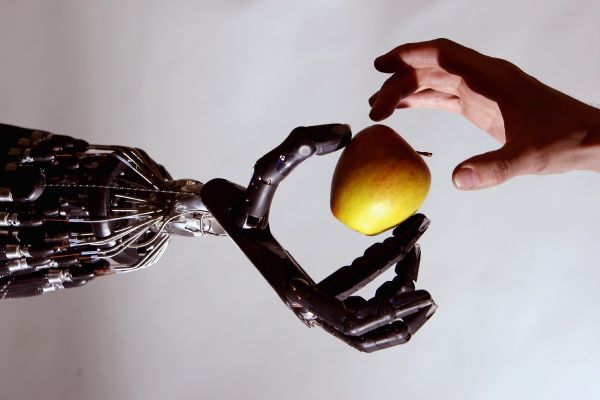

图片来源:Jeff J Mitchell/Getty Images

它开始于400万年前,那时人类的脑容量开始迅速攀升。五万年前,智人崛起。一万年前,文明开始发展。五百年前,印刷术的利用。50年前,计算机的出现。还有不到三十年,它就会结束。

Jaan Tallinn在2007年的一篇网络文章《Staring into the Singularity》中看到了这段话。文中的“它”指的是人类文明。这篇文章的作者预测,随着人工智能的出现,人类将不复存在。

Tallinn出生在爱沙尼亚,是一名计算机程序员,拥有物理学背景,喜欢把生活当做一个更为宏观的编程问题来看待。2003年,他与人共同创建了Skype,开发了这款应用的后端。两年后,eBay收购了他的股票,他将其变现。如今他正在考虑再做点什么。《Staring into the Singularity》这篇文章里面不仅有计算机代码、量子物理等内容,甚至还有加尔文(Calvin)和霍布斯(Hobbes)的名言。他一下子就迷上了它。

Tallinn很快发现,这篇文章的作者、自学成才的理论家Eliezer Yudkowsky写了1000多篇文章和博客文章,其中很多都是关于人工智能的。Tallinn编写了一个程序,从互联网上搜集Yudkowsky的作品,按时间顺序排列,录入自己的iPhone中。然后,他花了一年多的时间阅读这些作品。

“人工智能”一词最早出现在1956年,也就是第一台电子数字计算机问世仅10年后。有关该领域的预言最初都豪情万丈,但到了20世纪70年代,当早期的预测都没有实现时,人工智能的冬天来临了。当Tallinn发现Yudkowsky的随笔时,人工智能正在经历一场复兴。科学家们正在开发在特定领域表现出色——比如会下棋、清理厨房地板和识别人类语言——的人工智能。(此时距离AlphaGo大胜人类不到10年。)尽管下棋的人工智能不能扫地,也不能把你从一个地方带到另一个地方。但Tallinn相信,总有一天会出现一种超级的人工智能,它会是一个集许多功能为一体的多面手,它甚至还可能利用随身携带智能手机的人生成的数据,在社交方面表现出色。

读了Yudkowsky的文章后,Tallinn相信,超级人工智能方面取得的“突破性进展”可能导致威胁人类的生存——人工智可能会取代我们在进化阶梯上的位置,像我们现在主宰猿类那样主宰我们,或者更糟的是,消灭我们。

在读完最后一篇文章后,Tallinn给Yudkowsky发了一封电子邮件——用的都是小写字母,这是他的风格。“我是jaan,skype的创始人之一,”他这么自我介绍说,“我同意……为人工智能超越人类这件事的到来做准备是人类的首要任务之一。”他想帮忙。不久之后,当他飞往旧金山湾区参加其他会议时,在加州Millbrae的Panera面包店见到了Yudkowsky。他们的聚会持续了四个小时。Yudkowsky回忆道:“实际上,他对基本概念和细节有着很深刻的理解,这非常罕见。”之后,Tallinn给Yudkowsky供职的非营利机构——奇点人工智能研究所(Singularity Institute for Artificial Intelligence)开了一张5000美元的支票。2013年,该组织更名为机器智能研究所(Machine Intelligence Research Institute,MIRI)。到目前为止,Tallinn已经给它捐赠了60多万美元。

与Yudkowsky的相遇给Tallinn带来了新目标,他决定肩负起把我们从自己的创造物中拯救出来的使命。在这个问题上,他与其他理论家和计算机科学家建立了联系,开始了他的旅行生涯,在世界各地发表演讲,讨论人工智能带来的威胁。不过,他主要是开始资助研究可能给人类带来出路的方法:所谓的友好型人工智能。这并不意味着这类人工智能特别擅长谈论天气,或者它能记住你孩子的名字——尽管超级人工智能可能确实能够做到这两件事。这也不意味着它的动机是利他主义或爱。一个常见的谬论是假设人工智能具有人类的冲动和价值观。“友好”其实意味着更基本的东西:未来的机器不会在它们实现目标的过程中把我们消灭掉。

人工智能会威胁人类吗?

在与Yudkowsky会晤9年后,Tallinn与我一起在剑桥大学耶稣学院(Cambridge University’s Jesus College)的餐厅用餐。教堂般的房间里装饰着彩色玻璃窗、金制的模型和戴着假发的人的油画。Tallinn坐在一张厚重的红木桌旁,穿着硅谷的休闲装束:黑色牛仔裤、T恤、帆布运动鞋。

46岁的Tallinn在某种程度上可以算是教科书式的科技企业家。他认为,由于科学的进步(只要人工智能不毁灭我们),他可以活“许多、许多年”。他对超级人工智能的担忧在他的同龄人中很常见。PayPal联合创始人Peter Thiel的基金会向MIRI捐赠了160万美元,2015年,Tesla创始人Elon Musk向马萨诸塞州剑桥市的科技安全组织未来生命研究所(Future of Life Institute)捐赠了1000万美元。Tallinn进入科技这一领域是在上世纪80年代,当时一个同学的父亲在政府工作,让几个聪明的孩子有机会接触到大型计算机。爱沙尼亚独立后,他成立了一家电子游戏公司。今天,Tallinn仍然和他的妻子以及六个孩子中最小的一个住在自己祖国的首都(正好也叫Tallinn)。当他想与研究人员见面时,他通常只到波罗的海地区。

他的捐赠策略也有条不紊——就像他做的其他事情一样。他把钱分别捐赠给了11个组织,每个组织都在研究如何使人工智能更安全、更友好的不同方法,他希望其中某一个能坚持下去、产生结果。2012年,他与人共同创办了剑桥生存风险研究中心(Cambridge Centre for the Study of Existential Risk,CSER),初期投入近20万美元。

生存风险——或者像Tallinn所说的X-risk——是对人类存在和延续的威胁。除了人工智能,CSER的20多位研究人员还研究气候变化、核战争和生物武器。但对Tallinn来说,其他学科主要是帮助合法化失控的人工智能的威胁。他告诉我:“跟人工智能比起来,那些真的只是小巫见大巫。”对气候变化等更广泛接受的威胁的担忧,可能会吸引人们加入进来。他希望,超级人工智能机器统治世界的恐惧将说服他们留下来。他现在在这里参加一个会议,因为他希望大家能认真对待人工智能安全方面的话题。

我们的用餐同伴都是随机参加会议的人,包括一位研究机器人的香港女性和一位上世纪60年代从剑桥大学毕业的英国男性。老人在饭桌上询问每一个人他们上的是哪所大学。Tallinn的回答是,Estonia’s University of Tartu,并没有给他留下深刻印象。然后,他试图把谈话引向新闻。Tallinn茫然地看着他。“我对短期风险不感兴趣,”他表示。

Tallinn将话题转向了人工智能对人类的威胁。当谈话对象不是程序员时,他倾向于打比方:超级人工智能可以像人类砍伐树木一样迅速地把我们解决掉。超级智能之于我们,就像我们之于大猩猩。为了面对可能到来的威胁,Tallinn认为我们得紧紧地团结起来。

每个人工智能都需要一个躯壳,老人表示,没有某种物理外壳,它怎么可能进行物理控制?Tallinn回答道:“把我关在有互联网连接的地下室里,我一样可以会造成很大的破坏。”

无论是Roomba还是它在世界上占主导地位的后代,人工智能都是由结果驱动的。程序员会设定目标以及一系列关于如何实现目标的规则。先进的人工智能并不一定需要被赋予统治世界的目标才能实现它——它可能会在偶然之中做到。计算机编程的历史上充满了引发灾难的小错误和小偶然。例如,2010年,一家共同基金公司Waddell & Reed的交易员卖出了数千份期货合约。该公司的软件在帮助执行交易的算法中漏掉了一个关键变量。其结果带来的是损失万亿的“闪电般地崩盘”。

Tallinn资助的研究人员认为,如果超级人工智能的奖励结构没有得到恰当的编程,即使是善意的目标也可能带来不幸的结局。牛津大学(Oxford University)哲学家Nick Bostrom在他的著作《Superintelligence》中举了一个著名的例子:一台人工智能受命制造尽可能多的回形针,它可能会觉得人体也可以算作原材料。

Tallinn的观点自然也不乏批评者,甚至在关注人工智能安全的群体中也是如此。有人反对说,当我们还不了解超级人工智能时,担心它还为时过早。还有人说,把注意力集中在流氓技术行动者身上,会分散人们对该领域面临的最紧迫问题的注意力——比如大多数算法是由白人男性设计的,或者基于对他们有偏见的数据。“如果我们不在短期内应对这些挑战,我们就有可能建立一个我们压根不想生活在其中的世界,”Partnership on AI执行董事Terah Lyons表示。该组织是一个关注人工智能安全和其他问题的多方利益相关者组织。但Lyons补充称,研究人员近期面临的一些挑战——比如消除算法偏见——是人类可能在面对超级人工智能时看到的一些挑战的先兆。

不过,Tallinn并不这么认为。他反驳说,超级人工智能会带来独特的威胁。最终,他希望人工智能社区能够效仿上世纪40年代的反核运动。在广岛和长崎爆炸之后,科学家们联合起来试图限制进一步的核试验。“曼哈顿计划的科学家可能会说,‘看,我们在这里进行创新,创新总是好的,所以我们需要勇往直前’,”他告诉我。

如何确保人工智能对人类的安全不造成威胁?

Tallinn警告说,任何确保人工智能安全的方法可能都不正确。他解释说,如果人工智能足够聪明,它可能会比它的创造者更好地理解约束和限制。想象一下,他说,“在一群5岁的盲童建造的监狱里醒来,对于一个由人类制定约束的超级人工智能来说,情况可能就是这样。”

理论家Yudkowsky发现,有证据表明,这一点可能的确如此。因为,2002年起,他做过一个实验,自己在一个封闭的盒子里扮演人工智能的角色,而其他人轮流扮演看门人,负责把人工智能局限在盒子里。五分之三的情况下,Yudkowsky——一个凡人——说服了守门人放他出来。然而,他的实验并没有阻止研究人员尝试设计一个更好的“盒子”。

研究人员认为,Tallinn正在资助寻求各种各样——从实用的到看似天方夜谭的——的策略。有些人将人工智能理论化,要么构建一个实际的物理结构来支持它。其他人则试图教会人工智能坚持人类的价值观。还一些人正在研究最后一招。牛津大学人类未来研究所(University of Oxford 's Future of humanity Institute,FHI)的数学家兼哲学家Stuart Armstrong是一位研究这三种情况的研究员。Tallinn称该研究所是“全宇宙最有趣的地方”。(Tallinn已经向FHI提供了31万多美元。)Armstrong是世界上为数不多的全职致力于人工智能安全的研究人员之一。

一天下午,我和他在牛津的一家咖啡馆喝咖啡。他穿着一件橄榄球衫,领口没有扣扣子,看上去就像一个一辈子躲在屏幕后面的人,苍白的脸被一团沙色的头发框住了。他在解释中掺杂了令人困惑的大众文化背景和数学知识。当我问他在人工智能安全领域取得成功可能是什么样子时,他说:“你看过乐高电影吗?一切都太棒了。”

Armstrong的一项研究着眼于一种称为“oracle”人工智能的特定局限方法。2012年,他与FHI的联合创始人Nick Bostrom在一篇论文中提出,不仅要把超级智能隔离在一个储罐中——这是一种物理结构——还要把它限制在回答问题上。但即使有了这些界限,人工智能也将拥有巨大的力量,通过巧妙地操纵守门人,重塑人类的命运。为了减少这种情况发生的可能性,Armstrong提议对对话进行时间限制,或者禁止提出可能颠覆当前世界秩序的问题。他还建议,让oracle通过指数来衡量人类的生存状况,比如道琼斯工业指数(Dow Jones Industrial Average)或东京的过街人数。

Armstrong在一篇论文中称,最终有必要创造一个“大红色关闭按钮”:要么是一个物理开关,要么是一个被编程进人工智能的机制,在以便在最紧急的关头对人工智能进行关闭。但设计这样一个开关远非易事。一个对自我保护感兴趣的高级人工智能不仅可以阻止按钮被按下,它还会好奇为什么人类会发明这个按钮,也许想要激活它看看会发生什么,然后让自己报废。2013年,一位名叫Tom Murphy VII的程序员设计了一款可以自学玩任天堂娱乐系统游戏的人工智能。为了不输掉俄罗斯方块,人工智能按下了暂停键,让游戏保持冻结状态。Murphy在一篇关于自己的造物的论文中挖苦道:“说真的,唯一的制胜招就是不玩。”

要让这一策略成功,人工智能必须对按钮不感兴趣,或者,正如Tallinn所说,“它必须对它存在的世界和它不存在的世界赋予同等的价值。”但即使研究人员能做到这一点,也存在其他挑战。

最令研究人员兴奋的方法是,找到一种让人工智能坚持人类价值观的方法——不是通过编程,而是通过教人工智能学习价值观。在一个党派政治占主导地位的世界里,人们常常会放大我们的差异。但是,Tallinn指出,人类有很多共同点:“我们希望人工智能能够被教会识别这些不可改变的规则。”

在这个过程中,人工智能需要学习并欣赏人类不合逻辑的一面:我们经常说一套做一套,我们的一些偏好与他人发生冲突,以及人们在喝醉时不那么可靠。但我们所有人在应用程序和社交媒体上留下的数据轨迹或许可以提供一个指引。Tallinn认为,尽管面临挑战,但我们必须尝试,因为不尝试的风险太高了。他表示:“我们必须提前思考几步。创造一个与我们兴趣不同的人工智能将是一个可怕的错误。”

人工智能需要意识吗?

Tallinn在剑桥的最后一晚,我和他以及两位研究人员一起在一家英国牛排馆共进晚餐。一个服务员把我们这群人安排在一个粉刷成白色的酒窖里,酒窖里有一种洞穴般的气氛。他递给我们一页菜单,上面有三种不同的土豆泥。一对夫妇在我们旁边的桌子旁坐下,几分钟后要求搬到别处去。“我感觉太幽闭了,有点恐怖,”这位女士抱怨道。我想起Tallinn的那些话,他说即使自己被锁在一个只有互联网连接的地下室里,同样可以造成破坏。

Tallinn的客人包括前基因组学研究员Seán Ó hÉigeartaigh,他是CSER的常务理事,以及Matthijs Maas,哥本哈根大学(University of Copenhagen)的人工智能政策研究员。他们开玩笑说,要拍一部名为《Superintelligence vs Blockchain》的书呆子动作片以及开发一个名为“Universal Paperclips”的在线游戏,还原了Bostrom书中的场景。这个练习包括反复点击鼠标来制作回形针。这并不是什么华而不实的东西,但它确实说明了为什么一台机器可能会寻找一种更简便的生产办公用品的方法。

最终,谈话转向更大的问题,就像Tallinn在场时经常做的那样。人工智能安全研究的最终目标是创造出像剑桥大学哲学家、CSER联合创始人Huw Price曾经说过的那样,“在道德和认知上都是超人”的机器。其他人则提出了这样一个问题:如果我们不想让人工智能主宰我们,那我们想主宰它吗?换句话说,人工智能有权利吗?Tallinn说,这是一种不必要的人格化。它假定智力等于意识——这一误解惹恼了许多人工智能研究人员。当天早些时候,CSER的研究员Jose Hernandez-Orallo开玩笑说,当与人工智能研究人员交谈时,意识是“C-Word”,而自由意志是“F-word”。

现在在地窖里,Tallinn说意识无关紧要:“以恒温器为例。没有人会说它有意识。但是如果你在零下30度的房间里,和人工智能对质真的很不方便。”

Ó hÉigeartaigh表示:“担心意识产生的影响是件好事,但如果我们没有首先解决技术安全方面的挑战,我们就没有那么多时间担心意识带来的问题。”

Tallinn表示,人们过于专注什么是超级人工智能,它会是什么样的,我们应该担心一个人工智能,还是一群人工智能?他强调:“在我们看来,重要的是人工智能做了什么。”他认为,就目前而言,这可能仍取决于人类。

译者:喜汤

相关推荐

人工智能会脱离控制、毁灭人类吗?

开发比人类更聪明的AGI会导致世界毁灭吗?

AI控制人类,是一种幻想吗

人类唯一的出路: 变成人工智能(五)

人类会被人工智能打败吗?

《西部世界》第三季开播,机器人会比人类更有人性吗?

人类唯一的出路: 变成人工智能 大融合(四)

当人工智能成为艺术工具,人类的创造力如何长存?

细思极恐:GPT-3在《卫报》发专栏文章:不要怕我,我不想消灭人类,你们应该对计算机充满信心

对话沈向洋:未来人工智能交互主体的数量会远超人类的数量

网址: 人工智能会脱离控制、毁灭人类吗? http://www.xishuta.com/newsview6158.html

推荐科技快讯

- 1问界商标转让释放信号:赛力斯 95178

- 2人类唯一的出路:变成人工智能 20885

- 3报告:抖音海外版下载量突破1 20771

- 4移动办公如何高效?谷歌研究了 20054

- 5人类唯一的出路: 变成人工智 20036

- 62023年起,银行存取款迎来 10307

- 7网传比亚迪一员工泄露华为机密 8456

- 8五一来了,大数据杀熟又想来, 8338

- 9滴滴出行被投诉价格操纵,网约 7960

- 10顶风作案?金山WPS被指套娃 7213