谷歌AI具备意识与工程师对话?我们认真谈一下能“谈一下”的LaMDA

著名科技公司的工程师冲破重重阻挠对外发声:他所负责的人工智能产生了意识。公司则以违反保密协议为由,暂停了他的职务。这个看起来像是《黑镜》中的情节真实发生在了2022年的当下。

这位工程师名叫布雷克·莱莫伊内(Blake Lemoine),在谷歌的人工智能部门负责测试谷歌的LaMDA模型是否会产生歧视性语言或者仇恨言论。

但,事情真是这样吗?

中文互联网媒体已经对此事件进行了一些报道,事情本身也迎合了大众对人工智能担心的心理,但我们还是希望更认真地讨论一下这个事件。

LaMDA是什么?

LaMDA是谷歌在2021年开发者大会上公布的大型自然语言对话模型。和训练所有的大型人工智能模型一样,要想让LaMDA能够与人类通过自然语言对话,分为预训练和微调两步。

在预训练阶段,谷歌从公共数据中创建了一个1.56T的数据集投喂给LaMDA,让它对自然语言有一个初步的认识。

到这一步,LaMDA就可以根据给到的句子预测上下文。但这种预测通常还是不够精准,所以需要进一步微调。在对话期间,LaMDA会根据对话生成几个备选回答,并通过LaMDA分类器预测每个回答的有趣程度(SSI)和安全程度(Safety)的得分。安全分数低的答案就会首先被过滤掉。其余的答案会根据有趣程度排序,并将分数最高的备选答案作为回答。

从LaMDA的训练过程可以看到,它并不理解自己的回答。但机器学习的优势就在于它可以从大量的数据中寻找规律,通过自己的量化评价体系,找出最接近正确的那个回答。

布雷克·莱莫伊内为什么会被停职?

因为他违反了谷歌的保密协议。

根据他本人的说法,他曾经寻求“最低限度的外部咨询,以帮助指导我的调查”。其中包括一位美国参议院,莱莫伊内向他提供了谷歌及其技术参与宗教歧视的证据。

LaMDA真的有意识吗?

谷歌官方已经否定了这个说法。

谷歌发言人布莱恩 · 加布里埃尔(Brian Gabriel)在一份声明中表示: “我们的团队——包括伦理学家和技术专家——已经根据我们的人工智能原则审查了布莱克的担忧,并告知他,证据不支持他的说法。”

LaMDA是一个自然语言模型,本质上来说,它的工作和谷歌搜索栏里的自动补全没有什么不同,都是通过给定的上下文预测用户的意图。只不过,当LaMDA的参数量达到1370亿这个量级时,它把这项工作完成得非常出色,以致于可以短暂地欺骗人类。

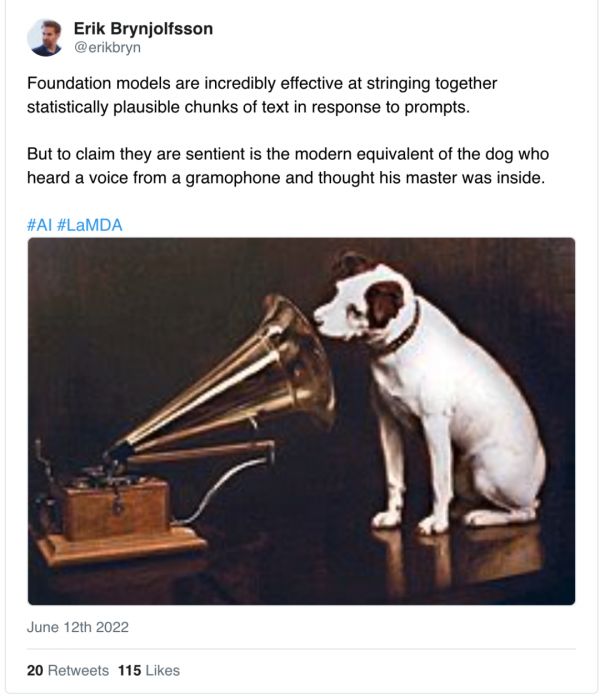

但LaMDA并不理解自己说出的话是什么意思,机器学习所做的是捕捉训练语料的语言结构。它可能会生成精妙的回答,也可能完全驴唇不对马嘴。但关键是,现阶段的人工智能并没有办法成为自己的“决策者”。斯坦福大学的经济学家埃里克·布林约尔松(Erik Brynjolfsson)做了一个精准的比喻:声称它们(人工智能)是有感知能力的,就相当于狗听到留声机里的声音,就以为主人在里面。

谷歌是如何审查人工智能的?

在谷歌,任何员工都可以为新产品请求审查。中央审查小组会应用相关的人工智能道德框架作为原则,并在审查时寻求专家支持。这个团队的成员包括用户研究人员、社会科学家、技术专家、伦理学家、人权专家、政策和隐私顾问、法律专家。

评审员会系统地考虑人工智能原则,并从以前的案例研究中寻找可以应用的例子。

如果需要,评审员会就解决方案像专家咨询。产品团队会根据建议调整方法。

商定的解决措施会有领导层签署,并成为产品开发计划的一部分。如果有一个具有挑战性的决定需要决策,谷歌高管组成的高级理事会会最终审查,并决定是否需要大幅更改或者停职项目。

此外,谷歌还会邀请外部专家参与审查过程,例如他们曾邀请非营利组织BSR(商业社会责任)对评估新的名人识别工具。

谷歌人工智能原则包括:

具有社会效益:对人类和社会可能带来的利益大大超过可预见的风险和弊端。

避免产生或加强不公正的偏见:避免对人产生不公正的影响,特别是与敏感特征有关的影响,如种族、民族、性别、国籍、收入、性取向、能力和政治或宗教信仰。

为安全而建造和测试:应当适当地谨慎,并符合人工智能安全研究的最佳做法,包括在受限环境中测试和适当的监测。

对人负责:提供适当的反馈机会、相关的解释和呼吁,并接受适当的人的指导和控制。

纳入隐私设计原则:鼓励具有隐私保障措施的架构,并对数据的使用提供适当的透明度和控制。

坚持科学卓越的高标准。技术创新根治于科学方法和对公开调查、智力严谨、成型和协作的承诺。

适用于这些原则的用途。谷歌将努力限制潜在的有害或滥用的应用。

除了上述目标外,谷歌还承诺不会在以下应用领域设计或部署人工智能:

造成或可能造成整体伤害的技术。在存在重大伤害风险的情况下,将只在认为利益大大超过风险的情况下进行,并将纳入适当的安全限制。

其主要目的或实施方式是造成对人的伤害的武器或其它技术。

违反国际公认标准,收集或使用信息监视的技术。

其目的违反了广泛接受的国际法和人权原则的技术。

我们真的需要人工智能像人吗?

把人工智能打造成一个人类,除了引发群众的恐慌、潜在的伦理问题和给公司带来数不清的麻烦,它的积极意义在哪?

科幻作品讨论的是一种基于现实社会模型的思想实验。游戏《底特律变人》讨论了这一议题,最终人类和机器人分化为了两个阵营,社会完全撕裂。

但在真实世界中,人工智能的意义在于它是一种提高生产力、解放人类的工具,正如蒸汽机把人类从体力劳动中解放出来一样。完全像人,也意味着它全盘接受了人类固有的缺陷。

说到底,人工智能与人工意识是两种完全不同的概念,能够骗过人类并不意味着人工智能产生了意识。

现阶段的人工智能其实还相当脆弱。由于人工智能模型复杂度之高,人工智能已经进入到了不可解释的状态。人类能够把控的,就是输入的语料和输出的回答,至于其中发生了什么,无人知晓。这也就意味着,但凡输入的语料出现一丝偏差,人工智能就极易被污染。

由人工智能引发的偏见、谎言和种族歧视并不少见。2020年1月,美国密歇根州一位非裔美国人就以入店行窃罪被捕,但他对此一无所知。原因在于警员是根据人工智能面部识别来抓捕嫌疑人的。由于用于训练的图像大多是白人,人工智能在识别黑人面孔时就发生了错误。

在人工智能领域,还有大量严肃的问题需要解决,例如如何使它更加高效、更加安全、更加能够解决实际的问题。

科幻作品和社交网络编织出的人工智能恐慌深入人心,但这更多是一种臆想。一些人工智能企业有意无意的夸张和市场宣传某种程度上加剧了这种恐慌。美国人工智能公司Geometric Intelligence的创始人加里·马库斯(Gary Marcus)在《重启人工智能》一书中把这种人类倾向称之为“易受骗差距”——一种有害的现代版幻想性错觉。

对于还十分脆弱的人工智能来说,将其称之为“人工智障”倒也不是十分过分的说法。可以确定的是,人工智能将会在人类文明中扮演重要的角色,但还有很长的路要走。在这个时间点到来之前,对于人工智能的过度恐慌与臆想,才是应该警惕的。

本文来自微信公众号“电厂”(ID:wonder-capsule),作者:汤一涛,36氪经授权发布。

相关推荐

谷歌AI具备意识与工程师对话?我们认真谈一下能“谈一下”的LaMDA

有“人格”的机器人?LaMDA 到底是什么?

谷歌最新黑科技LaMDA,终于不是智障了?

谷歌最新黑科技LaMDA,能让你的语音助手不再智障吗?

谷歌在自然语言的最新技术成果LaMDA,在I/O大会化身冥王星

谷歌黑科技:用人工智能,把搜索变成对话

靠CPU驱动的自动驾驶轮船,了解一下?

揭秘微软“图灵计划”:重塑AI开发方式 与谷歌亚马逊竞争

还在说AI将会取代内容工作者?人机协同了解一下

AI已具备人格?给有关人工智能的炒作泼泼冷水(下)

网址: 谷歌AI具备意识与工程师对话?我们认真谈一下能“谈一下”的LaMDA http://www.xishuta.com/newsview64632.html

推荐科技快讯

- 1问界商标转让释放信号:赛力斯 95268

- 2人类唯一的出路:变成人工智能 21546

- 3报告:抖音海外版下载量突破1 21522

- 4移动办公如何高效?谷歌研究了 20688

- 5人类唯一的出路: 变成人工智 20681

- 62023年起,银行存取款迎来 10375

- 7五一来了,大数据杀熟又想来, 8919

- 8网传比亚迪一员工泄露华为机密 8567

- 9滴滴出行被投诉价格操纵,网约 8540

- 10顶风作案?金山WPS被指套娃 7255