ChatGPT动了谁的奶酪?

本文来自微信公众号:信睿播客 (ID:thethinkerFM),嘉宾:周忆粟,主持、审校:周发发,整理:卓睿,题图来自:视觉中国

近日,多位学界和业界名人联合签署公开信,要求暂停训练比GPT-4更强大的 AI 模型,引发广泛关注。而此前,基于较低版本模型、但拥有更为简洁交互界面的ChatGPT,已经让我们直接体验到GPT模型强大的语言能力。在流利自如的应答中,GPT不经意间宣示了这样一种可能性:长篇大论不再是知识精英的特权,知识结构也不必再通过艰苦的海量阅读构建——这引发了部分知识精英的焦虑,甚至可能动摇更广义上精英教育的基础。

本期节目,我们邀请到澳门大学教育学院副教授周忆粟老师,一起聊一聊ChatGPT给精英教育和学术生产带来的挑战。我们并未在GPT的原理及应用方面过分深入,相反,我们更希望能以ChatGPT为镜,理解我们如何阅读、写作、积累知识,并尝试以ChatGPT为标尺,测度出人类在知识生产领域的上限与下限。

当机器开始具备精英特征

周发发:周老师一直是我朋友圈里的“潮男”,也是我朋友圈里第一位发与ChatGPT相关的信息的人。我翻了一下,早在2022年的12月4日,周老师就激动地连发了两条朋友圈来讲他使用ChatGPT的感受。当时还没有创投圈的各种“炒作”,所以当时周老师的激动、喜悦,应该完全是基于使用这个产品本身的惊喜感。所以想先问一下周老师,您当时第一次用ChatGPT的感受是什么?为什么您当时就觉得这是未来可能引发科技圈强震的产品?

周忆粟:我一直是对新技术比较敏感的人,正好看到一些技术圈的朋友们说ChatGPT给他们带来的感受,所以就花时间研究了一下。第一感受确实比较震撼。其实在此之前,我们跟各种各样的机器都发生过互动,不管是在游戏场景里跟NPC发生互动,还是在购物网站上跟AI客服发生互动,但是从来没有ChatGPT给我这么像人的感觉——ChatGPT给第一次使用它的人带来的震撼,在于它确实很像一个人,它给出的答案是人类能够说出的话。

我这学期在给本科生上一门关于全球化的通识课,我就把我上课的一些讨论问题和作业给了ChatGPT,它能够给出非常流利,逻辑上大致是通顺和正确的回答——而且是非常完整的。

它的创造性也是让人感觉很惊讶的一点。我自己的小孩上课的时候,老师会让他们写儿童诗。我就试试看说,我把同样的题目给机器,看看机器会写出什么样的诗来。后来我有一个同事,他的业余爱好是写歌词,我就让ChatGPT也试着去写,当然英文流行歌词写出来比中文要好很多,但是这种以前所谓的创造性能力,也是我从来没有在其他类似的机器身上感受到过的。

周发发:除了完整性、流畅性和创造性,很多的科技评论人士也会说,ChatGPT的一个特点,就是进行结构化写作的能力非常强。你问它一个问题,它就会给你列出一、二、三……几点,还有一个总结。其实我们回想一下,我们从基础教育到高等教育,一直都被要求写这样子的作文,并且也要求我们展现出归纳、推断、演绎的能力。所以我有一个问题,就是为什么现在全球各地的高等教育入学考试都要考“写作”这门课?

周忆粟:这个问题很有意思。大概可以有两类的解释,并且我认为这两类解释是互相关联的。第一,在现代教育的观念中,无论在哪个文化里,能进行有理有据的长篇大论都是知识精英的特征。你是精英,就代表着你能够就社会、政治或者个人话题,发表一些符合逻辑、能说服别人的看法。不管是我们高中时候背过的文章,或者是在现代西方的语境下面都如此。

第二类解释是说这和现代大学制度很有关系。在现代大学尤其是当代美国的大学里面,人文学科(humanities)基本上诞生于1928到1941年,首先还是在精英大学里面,然后在二战以后向州立大学蔓延。人文学科自认为是一系列的理想(ideas)和一系列对人类状况(human conditions)的“感性”(sensibility)。

由于“二战”之前,专业化的科学技术在欧美社会开始发端,人被技术社会限定在一个非常小的圈子里,坚守人文学的这些人对于这种现象既忧虑也反感,这就构成了作为一种运动的人文学科的主要目的。对他们来说,他们感兴趣的不是能够生成大量东西的能力,而是有质量的论证胜过大量的论证。他们对实证主义、客观知识持有非常深刻的怀疑论,所以对他们来说很重要的一点是阐释:能够对知识进行不断的更新,更新对知识主体的认识,以及对人在整个社会和发展里面的中心位置的思考。

因此,论证写作和推断是人文领域的核心。我觉得人文学科非常好地体现了安德鲁·阿伯特教授在《大学教育和知识的未来》中提到的“现代教育观”,他认为教育是为了培养一种“能够自我再生的技能”(a making of a set of skills that are self-reproducing)。从这个意义上来说,论证和写作是这一类技能的核心。

大学教育与知识的未来,[美]安德鲁·阿伯特,生活·读书·新知三联书店,2023

周发发:作为一名老师,您觉得ChatGPT未来可能会如何改变写作教学,它未来有没有可能作为教学的一种辅助工具?

周忆粟:我先说一个大的判断,ChatGPT刚出来的时候,在《大西洋月刊》(The Atlantic)上有一篇文章叫做《大学论文已死》(“The College Essay is Dead”)。这个判断我还是比较同意的,大部分的非精英大学里面的一般论文基本上没有空间了,因为学生一旦能够接触到ChatGPT之后,他能够非常快速地获得一个答案。

这一点应该会在未来的几个月到几年里面迫使大学做出一些反应,可能最简单的反应就是直接禁用ChatGPT,很多的大学都已经做了这个事情,像离我们比较近的香港大学,已经说学生不能够在作业里面使用任何机器。

我个人认为这个方法虽然说简便,但它并没有改变核心问题。我上课时问过我的学生,很多学生其实也怀疑,过分依赖ChatGPT这样打包的技术会不会让自己的思考能力没办法得到锻炼。

但是我一般喜欢挑战学生的想法,我说:我问一下你们上其他的课用辅助性的写作软件吗?这一类软件在过去10年里面事实上是很风靡的,比如Grammarly,还有一个类似的竞品叫做ProWritingAid,这些软件打的广告都是所谓的AI-powered(人工智能驱动的)。我问学生说,这一类软件大家都认为是可以使用的,那么,如果微软把ChatGPT整合到Word里面,大家能用吗?

这说明,技术的应用不是一个黑和白的问题,它引入了一系列的梯度(gradience)和各种不同的应用场景。我自己的态度是,不管是学生还是教育者,要试图去理解它到底是什么,而且理解的过程中,依赖人类专家知识这一点仍是不可能回避的。但是它也意味着我们现有的教学的手段和模式,尤其是评估模式,其实会发生比较重大的变化。我们过去往往依赖于标准化考试,但在有互联网和ChatGPT双重加持的情况下,我们原有的评估模式可能就不太行。

GPT映照下的“知识危机”

周发发:ChatGPT不仅对课堂教学带来了挑战,对科研领域也造成了一些影响。我们近期也看到,不管是办各种研讨会也好,还是有很多人文社科的学者出来发声也好,都似乎在竭力声明“人文学科是不可取代的”。从这些反应中其实也可以看出,ChatGPT在一定程度上引发了一些文科学者的焦虑。

在人文社科研究中,我觉得最有技术含量的技能之一可能是从经验世界到理论世界的抽象和对应的过程。但ChatGPT恰恰相反,它为我们实践了这种可能性:它完全不知道什么是经验世界、完全只依靠语料和“二手文献”,也能产出一篇看上去非常像样的论文。

所以我觉得是不是正是因为它展现出的这种可能性,引发了一种本体论上的焦虑,就是说我们人文社科之前是不是也一直只是在干像ChatGPT一样的工作?周老师能不能聊一下,ChatGPT为什么会引发一些人文学者的焦虑?它是不是我们当前文科面临的知识危机的一种反映?

周忆粟:我觉得这种焦虑我完全能理解。对当代的人文学科来说,存在主义式的焦虑一直是它内在的东西。最近有一本非常好的书,它的标题就叫做《永久性的危机》(Permanent Crisis)。危机模式(crisis mode)不是人文主义的新形式,从17世纪开始它一直就不断地把自己置于这样的危机模式下面。当然,自动化现在加重了这种焦虑。

Permanent Crisis, Paul Reitter / Chad Wellmon, University of Chicago Press, 2021

这种焦虑包含了两个因素,第一个是机器有能力生产常规的论文。我不认为机器能够做到长篇幅、高质量的论证和说理,但它能够给出一些短小的bulletin points,也就是分点的、罗列式的论证,或者简单的“三段论”它也可以做。所以我们如果套用库恩评判常规科学的标准的话,确实机器现在已经可以做得很好了。机器生产此类论文的能力,如果现在不行的话,再几年就赶上了。因为生产这一类型的常规科学的基本元素,现在早就已经具备了。

比方说在社会科学领域里面,你可以设计一个研究方案,然后搞一堆数据,让预置的统计软件跑几百个模型,从里面挑出一个显著的关系进行研究,再回过头来假装这一切什么都没有发生过,根据你的研究草拟一个假设,说自己找了一套数据来验证假设,你就写出一篇论文来了。这一切不需要什么复杂的知识,也没有什么头脑可言,但这就是在我们这个论文爆炸、以数字式的标准来评价研究产出的世界里,大部分所谓的知识生产者在做的事情。

从这个意义上来说,ChatGPT提供了一面镜子,它帮助我们认识自己,认识到我们一直在做的都是什么事情。人类语言可能没有我们想象的那么特别。虽然现在没有人能够解释清机器究竟是怎么做到这么流畅,但是它已经能够模仿出这样一套结果来了。

第二,我们自己产出的这些所谓的知识,绝大部分也就是没有用的东西。我们今天产出的这些论文,可能有99%不会被普通读者读到,它只不过是变成了学术生态里自我运作、自我增殖的一个部分而已。从这个意义上来说,这些论文没有任何用,因为它不跟人交流。

早期写论文是和同行交流的过程,但现在大家都不去读论文了,我们的很多学生也好,同行也好,写论文最后写的才是文献,因为对ta来说文献根本没有用处,ta只需要提出一套实证的操作逻辑和模式,只要能够把它做出个结果来就行了,文献完全是一种点缀。在这个意义上,ChatGPT是一个很好的加速器,它加速了类似的论文生产模式走向毁灭。

周发发:我也问了ChatGPT一些社会科学领域的问题,它所给出的回答,其实在我看来就特别“和稀泥”。它会给你罗列出所有可能的影响因素,它可能总结很多前人有的研究发现,或者是他会给你一个模棱两可的答案,说这件事情是复杂的,受多方面的影响,我们不能单纯地把它归咎于什么因素——然而这些答案,确实很像一个社科专家可以给出的答案。所以在我们看到了这些答案之后,我们就会反思说到底什么才是学术创新。

ChatGPT回答典型的社会科学提问。问题来源:《历史与变革(第一辑)》

周忆粟:对,它也让我们反思,为什么认为这个人是专家?他说的话只不过是把原有的东西翻来覆去再说一遍而已。

周发发:那么,到底什么才是一个真正有价值的研究成果,社会科学研究又到底会不会有发展?

周忆粟:在回答大问题之前,我们先往回退两步。首先,ChatGPT的流畅性和总结、提炼的能力是非常厉害的,从这个角度上来说,我觉得它作为一种辅助性的工具有相当大的价值,它能够帮助你提炼一些东西。但是,我套用一篇我挺喜欢的论文里面指出的,这一类型的大型语言模型的本质仍然是鹦鹉学舌。

有一个很好的词叫做stochastic parrot(随机鹦鹉),这些模型是建立在一个随机统计模型上面的鹦鹉,因为它事实上还是一种预测型的算法,根据你给的内容,从它所读的大量的人类文本里面,用一套神经网络的方法让整个模型给出一些最有可能出现的文本回答。它的目的仍然是生成一段看起来像人回答的东西,而不是说产生一些新的知识,也不保证它的准确性。这一点我相信很多使用过它的人都知道,ChatGPT会在那儿说一些语法上非常正确,但是没有任何意义的话。

再往下一步,ChatGPT会不会改变社会科学的阅读和写作方式?如果我们了解知识在社会科学里面怎么产出、怎么积累的话,可能大家就不会有这么强的技术决定论。比如我们先从一点来说,所有人文社科的课程都会要求大家读各种各样的书。我的学生就问了我一个问题,既然机器已经那么强了,能不能只看机器给我的总结和提炼,就相当于它帮我读了一遍书?

在我看来,在社会科学里面,读经典还是非常重要的。一般而言,我们的阅读模式有两种,一种我们叫做经典或者叫“正典”(canons),另外一种就是文摘。文摘就是一种简化,我们从篇幅非常长的原文里面提炼出一些最精华的东西。在你时间紧迫的情况下,文摘是一个让你快速进入某一个领域的很重要的一条捷径。其实在机器出现之前,我们已经发明了很多用于文摘的技术。

但是我们回过来想说,我们为什么必须要亲自去阅读经典?我举一个例子。我们知道杜威是一个很著名的教育哲学家,他1894年入职芝加哥大学,那时候芝加哥大学刚刚成立。如果你研究杜威的生平和历史的话,这个当然是一个很重要的事实,我们一般把它叫做兰克式的事实,它主要是以史学家利奥波德·兰克的名字来命名的。

你可以收集很多的这类事实,而且机器能够告诉你很多这类事实,但是它不会告诉我们的是,杜威为什么在他的《民主与教育》里有一个很重要的论断——“任何思想和观念不能以观念的形式,由一个人传达给另外一个人”?

我问ChatGPT,为什么杜威会说这句话?ChatGPT给我的一个回答是:“这句话显示的是杜威的一种信念,这个信念认为人类之间的沟通是不完美也不完善的一个过程。杜威认为每个人都有一套独立的经验和视角来认识这个世界,这种独特性会让我们和别人沟通的时候产生很多的困难。”——这是机器给出的一个文摘式回答。

这个回答错吗?不错,杜威肯定有这样的想法。但是很显然,任何人文领域的学者会告诉你,这只是杜威众多阐释里面的一种阐释而已,它不是唯一正确的一种,因为根本就不存在唯一正确的一种。人类知识和人类社会独特的一点,就在于对意义的阐释是无穷无尽的。

如果我们去读《民主与教育》,他在这本书的后面就写到:“当观念被人讲述的时候,对被告知的人而言,它是一个给定的事实,而不是一个观念。这种思想的交流可能刺激另一个人意识到他自己的疑问,并提出相似的观念,也可能窒息他理智上的兴趣,抑制他开始思维的努力。然而无论如何,他直接得到的不可能是一个观念,只有通过全力地应对各种状况,探索和追寻他自己的解决之道,他才是在思考。”

所以学习意味着思考,而不只是把知识当作一个被找到的东西,这个过程意味着你要学会自己去理解这个东西是怎么来的。阅读经典就意味着掌握一个很复杂的论点,把握它的情境脉络,给出有可能会出现的这些阐释,并提出新的阐释。

这一点文摘是做不到的,文摘只能把知识当成一个现成的东西打包给你,在你读到它的那一刻起,它就变成了一个事实而不是观念,但对我们而言更重要的是新的观念的生成。所以从这个意义上来说,如果我们非常严肃地对待我们的职业,我觉得ChatGPT的威胁没有我们想象中的那么大。

民主与教育,[美]约翰·杜威 著,华东师范大学出版社,2019

周发发:刚刚我问了周老师一个特别大的问题,然后周老师退了两步来回答。我们现在再回答最开始那个问题:在我们好像已经知道了所有的细节,也知道了不可能找到一个“唯一”的答案之后,我们应该怎么去认识社会科学的学术发展和成果?社会科学所谓的研究“进展”究竟是什么?

周忆粟:这个问题还挺好玩,我们从ChatGPT聊到了知识论的问题。从这个角度上来说,我们谈论的是说社会科学有没有创新,知识会不会积累,我们整个行当是不是在进步。

我的看法主要是这样,在大的尺度上,我们的社会科学在19世纪末20世纪初以后,就已经没有范式意义的创新了。不管你在什么学科,我们大致上有5种基本的框架:一种是功利主义的个人框架,一种是社会力量框架,一种是辩证法和其他冲突理论的框架,还有一种是过程和生态论的框架。最新的一种框架是戈夫曼,或者说人类学家在20世纪的中期开创的,认为说人类社会其实就是一套符号系统,大概就是这5个框架。

和自然科学一样,这5个框架是不通约的,你没办法把一个框架里面的研究结果移到另外一个框架里面去。它们互相之间无法沟通,但是也没有办法互相推翻,它们更多的是提供一种规范性的框架。

和进步的观念紧密相连的是一个学术生态里的重要机制,就是我们不断在忘掉新的东西。我们虽然有很好的机器,有维基百科,还有每年出版的大量 Handbook,但这是没有用的。对现在这一代的学生而言,20世纪90年代的文献就已经是旧的文献了,对他们来说,引用这些东西的时候可能就是一句话带过,或者是根本就不会去引用,因为他们投稿的时候可能编辑跟他们说,你这玩意儿20多年了,不要去看它了。

从这一点上来说,我们是现代人,但是我们和狩猎-采集社会里的同胞也没有什么区别。人类学家埃文思-普里查德在《努尔人》中记载了非洲的一个部落,他们只记得上下5代人之间发生的事情,5代人以上的事完全不记得了。从这点上来说,我们和努尔人是一样的:我们通过遗忘来不断地重新书写我们的学术历史和知识,通过这种方式来坚固我们对于创新的一种信念,就是我们要不断发现新的东西。所以遗忘是一种很重要的机制,它让当下的人相信自己正在开拓一个新的方向。

努尔人, [英] 埃文思-普里查德,商务印书馆,2017

那么回到我自己的看法,我觉得学术创新有不同的层次,在微观层次上,创新意味着我们能够对社会现实提出一种新的说法(a new account of our social world)。套用一个比较抽象的说法,就是用一种人类前所未见的方式来填充社会现象的可能阐释空间——我们阐释社会现象的可能性空间是无限大的,因为人类可以不断发明新的观念和新的价值,能够找到一种以前人没有用过的方法来填充它,我觉得就是一种微观层面的创新。

相对而言,宏观层面上的创新意味着打破了一些我们原来习惯的看待世界的方式。比方说你是用实证主义的方式看待这个世界,还是用阐释的方式看待?你是用分析的方式看待这个世界,还是用叙事的方式?你是用实在论的方式看待这个世界,还是用建构论的方式,等等。

这类中层次的创新是机器做不到的,因为它的运作方式其实很好理解,在这个领域里面最深入浅出的一篇文章来自于物理学家和计算机科学家Stephen Wolfram,他讨论的就是大型语言模型(LLM)的主要作用。这篇博客文章有一个小标题,叫做“It's just adding one word at a time”,模型通过一次加一个词的方式把这个句子给你造出来。

我们刚刚讲过,大型语言模型的核心是一种预测,它会在一个给定的语义空间里面,根据人类所给它的提示(prompt)预测出现某个词的频率,但它的前提是一切建立在现有语料的基础上。从这个意义上来说,中层次的创新是一种非常小概率的事件,因为它要打破一些我们之前认定的“常规”。所以从这个角度上来说,我反而没有那么担心机器取代人类做出这些创新程度非常大的事情。

周发发:感谢周老师非常完整、精彩、严谨的论述,听完周老师的这一段,我觉得ChatGPT短时间内还是不会追上社会科学学者的。我觉得ChatGPT最习惯给出的还是并列因素的回答,它好像还不太会做这种让步的假设或者是递进的推理。

周忆粟:对,目前来说机器没有办法做到这种长篇幅的discursive reasoning,人类可以做到。虽然说我们大家都知道说阅读那些长篇幅的东西,比方说我们教育社会学里,你要读布迪厄还是一件很痛苦的事情,他会开无数的脑洞——但是这确实就是一项很特别的人类特征。

什么是未来的“铁饭碗”?

周发发:现在可能很多人都关心自己的职业会不会被ChatGPT取代。可能过几年几十年,我们的工作都被ChatGPT取代了之后,我们进行下岗再就业的培训中,要学习什么样类型的技能,才会保证自己将来不会再次被取代?在您看来,什么样的人类智能或者技能是最不可能被替代的?感觉这是很多人非常真切的焦虑。

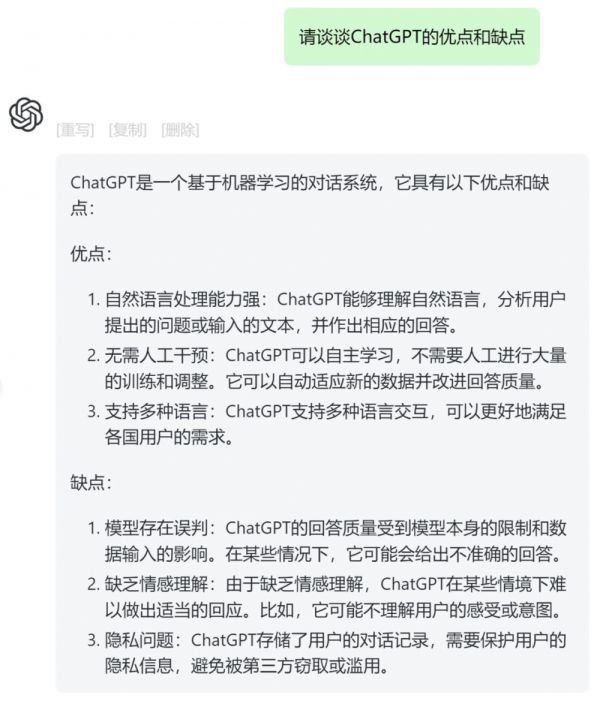

周忆粟:我觉得播客主播肯定是不会被机器取代的,因为它需要的这种临场发挥和创造性没有办法由机器来完成。机器能够协助你把播客办得更好,能协助你生成一些结构化的东西,比方说可以让机器来生成一个四平八稳的、讨论ChatGPT优点和缺点的大纲。但是四平八稳的东西往往也缺乏新意,大部分读者可能觉得跟喝白水一样,你能讲其他播客也能讲,没有办法显示出你的任何特点。

让ChatGPT谈谈自己的优缺点

所以我觉得在讨论ChatGPT能够取代什么样的工作之前,我们还是要回到它是什么,能干什么?它是一种基于神经网的人工智能,它的作用是生成文本,所以文本是它的老本行。哪一些文本是它能够做得比较好的?我目前看到的大概是文书型的工作,如工作邮件、格式化的新闻,公众号、财经网站上发布的报表更新和行政审批流程,这些文书它都能够写得非常好。

第二类型我觉得是所谓的低端创意类工作,我们认为它是创意类,但是其实它所蕴含的创造性可能没有我们想象这么大。这个也是给很多人一些冲击的地方,比如我刚刚讲过的孩子的诗歌、某些类型的口水歌歌词、命题小作文,这些东西需要一些创意,但是可能不需要那么多,那么从这个角度上来说,机器完全可以搞。

第三个就是结构化的文本,这其实是很大的领域,最常见的就是写代码,我观察了一些做这个领域的身边好友,他们确实认为说机器能够给出大致上可以的代码。

总结一下的话,大概就是说我们的常规性的工作(routine job)可能会被取代,包括处理这些常规性工作的人以及生产这些内容的人,我们今天主要谈论的是ChatGPT,但是我觉得哪怕没有ChatGPT,这些行业里面的理性化生产其实已经发生了,只不过AI大大加速了这个过程而已。比方说我们前面讲过标准化的新闻,很多的我们叫做内容工厂也好,或者是这些新闻网站也好,都已经在尝试用基于某种模板的非AI的方式来生成它,AI只不过给他们提供了一种新的思路。

接下去说,如果我们的思考不限于文本,也不限于图像或者是声音,那么任何大规模的数据是不是都能够通过机器学习的方法被掌握?我觉得这个是AI未来很大的方向,就是说它通过机器学习的方法,给它一大堆的语料,目前是语料,以后可能是一堆蛋白结构,它通过学习然后外推,我认为在这个意义上来说,它不是取代了我们,而是开拓了一片非常广阔的新天地。

我前两天听到一场非常出色的关于将ChatGPT用来预测蛋白结构的一场讨论,我觉得这是一个完全崭新的领域,但是这个崭新绝对不会由机器自己完成,它一定需要大量的专业人员来辅助它完成,所以我觉得更重要的可能是一种人机的结合。

讲到这儿我可以讲一个小小的例子。在我们教育领域里,尤其是在欧美,20世纪七八十年代计算器被引入课堂了以后,当时数学教育领域就有讨论,计算器会不会让我们的孩子变傻变笨?会不会导致他们依赖计算器,以至于没有办法把数学学好?著名的数学家Henry Pollack说过三个论断,我觉得挺有趣的:

有了计算器之后,

(1)以前一些用纸笔来算的数学现在没那么重要了,因为计算器可以做了;

(2)以前那些没有计算器比较难解的数学,在计算器辅助的语境下变得更重要了;

(3)以前那些不可能通过手算得出答案的问题,这样的数学领域现在成为了可能。

所以新技术带来的可能性和它替代的东西我觉得是同样重要的——我们不能只看到一边。我希望这个例子可以被用到我们对知识和工作的讨论里面。

我的看法是,新技术开拓的知识的边疆可能会变得更广阔一点。人类的知识我认为是没有穷尽的,所以就这一点来说,并不是现有的知识没用了我们就完蛋了,我们也可以再学习,这是我们作为教育者和学习者的一个很重要的特性。

不过我确实认为技术带来的马太效应是一件很值得提防和思考的事情,因为这种不平等可能会因为机器的出现而加剧。因为本来就很聪明的这些人,有可能因为掌握了新的工具,使得他们的优势变得更大了。那会不会出现一群技术寡头,因为垄断了数据或者新技术本身,导致了其他人怎么样都跟不上?这个我觉得是值得探讨和思考的。

最后,我觉得肯定有一些重复性比较高的职业会被取代,但是我认为“专家技能”(expertise)不会被取代,事实上我觉得,这一类型的工作只会增加而不会减少。为什么?因为我们讨论技术也好,讨论专家技能也好,它不只是你脑子里面的这个东西而已,它是知识和行动的结合。你得会做事情,你得会下判断,你需要根据客户的反应来做出这样的判断,而不只是你能够说出一些东西来。

ChatGPT能够说出很多东西,但是他没办法给你做任何判断。主播刚才也说了,你如果问一些让它给你下判断的事情,它会跟你说,我是个AI,我做不了这个事情——但人可以做这个事情。

“专家技能”具体包含哪些东西?职业社会学过去30年的研究告诉我们最重要的是三样东西,第一就是它包括对一组特定的任务所做的诊断(diagnosis)、推断(inference)以及它的处置/治疗(treatment)。

从这个角度上来说,机器能够给我们提供判断的依据,比方说医院里面可以通过AI的算法,把你的肺部造影或者CT片做得更好,但是大量研究告诉我们说AI没办法替人做这个判断。所以我们大家需要了解的是,智能机器产出的东西是“半成品”,英文叫做rough-made,它不是ready-made,它能够给你一个思路,但给不出一个方案。所以说我觉得人和机器的合作这一点可能会变得更重要。

第二就是机器不能负责,机器没办法为任何决策负责任,这一点只能人来做。不管是从法律角度还是实践角度,我们都不太能够把后果严重的决策(high-stake decision making)交给机器,我们需要有人来做。

第三点就是说专家技能事实上是一个“活”的东西,它并不是说律师只能做什么、医生只能做什么,不是这样的。专家技能的很大一部分是建立在给专家自己处理的任务划定界限的过程上,我要能够跟人说明说这个任务只能我来干,你干不了——这一点机器也做不了。

从职业生涯或者职业周期的角度上来说,我们所说的专家不断地把别的专家从自己的领地上赶走,给自己划定一个专属管辖区,他说这一类型的活我来干,机器也许能够帮我干得更好。所以这一点上来说机器也做不了,它能够帮助你建立一些优势,但是最终是要靠人来建立这样一种专属的管辖区。所以从这些角度上来说,机器确实能够节省我们很多的时间,但是高端的专业性的劳动,我觉得它做不了。

本文来自微信公众号:信睿播客 (ID:thethinkerFM),整理:卓睿,审校、主持:周发发,嘉宾:周忆粟

相关推荐

ChatGPT动了谁的奶酪?

微信出圈,动了谁的奶酪?

苹果造车,动了谁的奶酪?

TikTok动了谁的奶酪?

ChatGPT概念股狂飙,谁是李逵谁“李鬼”?

ChatGPT警示:不同的中美AI故事

阿里版ChatGPT上线,谁会是大模型生态的下一个卷王?

入局教育领域,小度动了谁的奶酪 ?

一家投资机构关于ChatGPT的内部讨论会

ChatGPT兵临城下,搜索三巨头混战24小时

网址: ChatGPT动了谁的奶酪? http://www.xishuta.com/newsview71195.html

推荐科技快讯

- 1问界商标转让释放信号:赛力斯 95228

- 2人类唯一的出路:变成人工智能 21183

- 3报告:抖音海外版下载量突破1 21148

- 4移动办公如何高效?谷歌研究了 20339

- 5人类唯一的出路: 变成人工智 20338

- 62023年起,银行存取款迎来 10336

- 7五一来了,大数据杀熟又想来, 8596

- 8网传比亚迪一员工泄露华为机密 8505

- 9滴滴出行被投诉价格操纵,网约 8215

- 10顶风作案?金山WPS被指套娃 7230