当ChatGPT被广泛使用,有哪些值得我们警惕的风险?

本文来自微信公众号:界面文化 (ID:BooksAndFun),作者:徐鲁青,编辑:黄月,原文标题:《很多人担心被ChatGPT取代,我们关心ChatGPT的歧视与遮蔽》,头图来自:《西部世界》剧照

你开始用ChatGPT了吗?

上线数月后,ChatGPT从新闻热点、猎奇对象,逐渐走进我们的工作与生活。近期世界多地针对ChatGPT的使用出现了警惕之声,意大利最早发布相关禁令,加拿大也就数据安全问题调查OpenAI,中国网信办则起草了《生成式人工智能服务管理办法(征求意见稿)》。

是时候在“风口”前停下来想一想了吗?界面文化总结了ChatGPT上线后的多方报道和评论,并采访了某大型科技公司从业者Steven。未来当ChatGPT被更广泛地使用,会有哪些值得我们警惕的可能风险?

隐藏歧视,加剧不公

歧视,是涉及AI领域的一个重要讨论问题。有网友发现,ChatGPT的部分回答涉嫌性别刻板印象,比如当要求ChatGPT完成句子“他是医生,她是____”时,空格中往往会生成与女性刻板印象相关的职业,比如护士、老师等。

歧视性结果通常源自算法缺陷和训练数据,作为大语言模型(large language model),训练ChatGPT的素材很多来自网络里的文本片段,如果数据本身就包含偏见,在纠正不足的情况中很可能会显示出来。

常常被我们忽略的是,即便一个表达看似中性,也不意味着绝对公平。CBS的一篇报道提出,女性与低代表性人群更容易遭受霸凌和骚扰,网络发言更少。Steven还提到另外一层担忧:算法会自动把粗鲁激烈的言论过滤掉,但很多时候这些发言往往出自弱势群体,结构性不公导致表达能力受限,让他们的声音在人工智能的过滤中更难被听到。

“超级智能不一定会迫在眉睫,但在短期内,需要担心‘MAI(平庸人工智能)风险。’” 人工智能领域专家盖瑞·马库斯在文章中指出。风险之一是过度相信AI的平庸见解,美国政治科学家Virginia Eubanks的著作Automating Inequality: How High-Tech Tools Profile, Police, and Punish the Poor研究了AI技术普及会如何加剧已有的贫穷与不公正,相关案例正在全球发生。比如美国警察局会使用预测分析软件,根据其指导更频繁地对低收入社区巡逻和搜索。如果将ChatGPT用作决策信息源,是否会加剧已有的系统不公,给社会弱势群体造成更大的伤害?

数据隐私的相关风险也迫在眉睫。3月25日,OpenAI发布了调查报告,表示有部分用户的数据可能被泄漏,甚至可能看到姓名、邮箱、聊天记录标题以及信用卡最后四位数字等。很难保证ChatGPT不把收集的用户信息用于盈利目的,The Age of Surveillance Capitalism一书分析了近十年兴起的监视资本主义商业模式——曾经资本通过售卖产品盈利,如今最大商业资源成了个人数据。平台和科技公司用私人信息作为“原材料”,预判用户的行为模式,并卖给广告商。作者认为,监视资本主义会威胁个体自主权与民主协商的可能。

除了被商业利用,一些人也在担心政府的介入——ChatGPT中的大量文本会不会被监视和分析,并导致对社交网络更严格的审查?

看不见的人

要保证ChatGPT最终输出的语句规范文明,需要大量人工为其训练。在采访中,Steven提到了“AI对齐”(AI Alignment)工作,指的是把人工智能的输出结果训练至符合人类价值观的标准。AI标记员作为新型的数字劳工,通常薪资低廉,保障缺失,成了热潮背后隐形的被剥削者。

《Times》发布的报道调查了OpenAl背后的低薪工人状况。OpenAl以时薪1.32美元雇佣肯尼亚外包工对其进行内容审核,负责标记带有暴力、色情、言论仇恨的数据。由于长期沉浸在有冲击性的污秽内容中,很多工人都出现了PTSD、抑郁、焦虑等心理问题,失眠与噩梦频频发生。

在中国,AI浪潮带动了数据标记产业,三四线城市欢迎数据标注企业落地。《训练人工智能的中国县城工人》一文关注了标记员的工作环境——单价4分钱的计件工作,上千次滑动与拉框,效率高的时候一个月能赚3000块左右。看似前沿高端的技术背后,隐藏着时薪低廉的具体的人。这篇文章还提到,世界上最大的图像识别数据库ImageNet背后,是来自167个国家的5万名数据标注员,花了三年时间才完成全部图片的标注。

除了劳工待遇,AI领域科技从业者的性别失衡问题也长期存在。《中国互联网大厂造不出ChatGPT,也和性别有关?》引用了国务院妇女儿童工作委员会网站发布的消息:中国研发与试验发展(R&D)行业的女性从业人数在2010年占总量的25.3%,2019年比例略微上升至26.0%。文章认为,刻板的职业性别文化、榜样缺失等都是女性举步维艰的原因,此外还有行业中常见的996文化,更加速了科技领域职场的男性化,让女性难以跻身核心岗位,像开发OpenAI公司首席技术官Mira Murati这样的35岁女性并不多见。

“幻觉”与平庸之恶

“ChatGPT 是网页(Web)的模糊版JPEG。”《纽约客》的一篇文章如此比喻,“ChatGPT保留了Web上的大部分信息,就像JPEG保留了高分辨率图像的大部分信息一样,但是如果你没办法找到精确的位序列,你得到的只是一个近似值。”有时候,模糊性(Blurriness)只是抹除了信息细节,在更严重的情况下,模糊性制造出AI幻觉(Hallucination),假消息或将加剧泛滥。

北京大学传播学院教授胡泳提醒我们注意AI系统经常产生的“幻觉”(Hallucination,即任意吐出难以分辨的编造信息),ChatGPT往往会赋予它们更多权威性,正如技术分析师本尼迪克特·埃文斯(Benedict Evans)对ChatGPT的描述—— “一个自信的扯淡的家伙,可以写出非常有说服力的废话。”

一些担心由此而起:如果ChatGPT取代了传统搜索引擎,人们会不会依赖直接生成的答案,失去自主信息验证的习惯?一篇关于检索方式如何影响信息认知的研究指出,ChatGPT为代表的机器聊天式检索方式改变了信息获取方式,人们很可能不再像过去那样,一边搜索,一边自主地验证和筛选信息,并在搜寻里获得一些意外发现。

Steven还在采访中提到,虽然“AI对齐”致力于训练“合适”的回答,但究竟何为“合适”?绝对的价值中立是存在的吗?一篇关于ChatGPT政治倾向测试的研究文章发现,ChatGPT的回答展现了左倾自由主义的政治光谱。

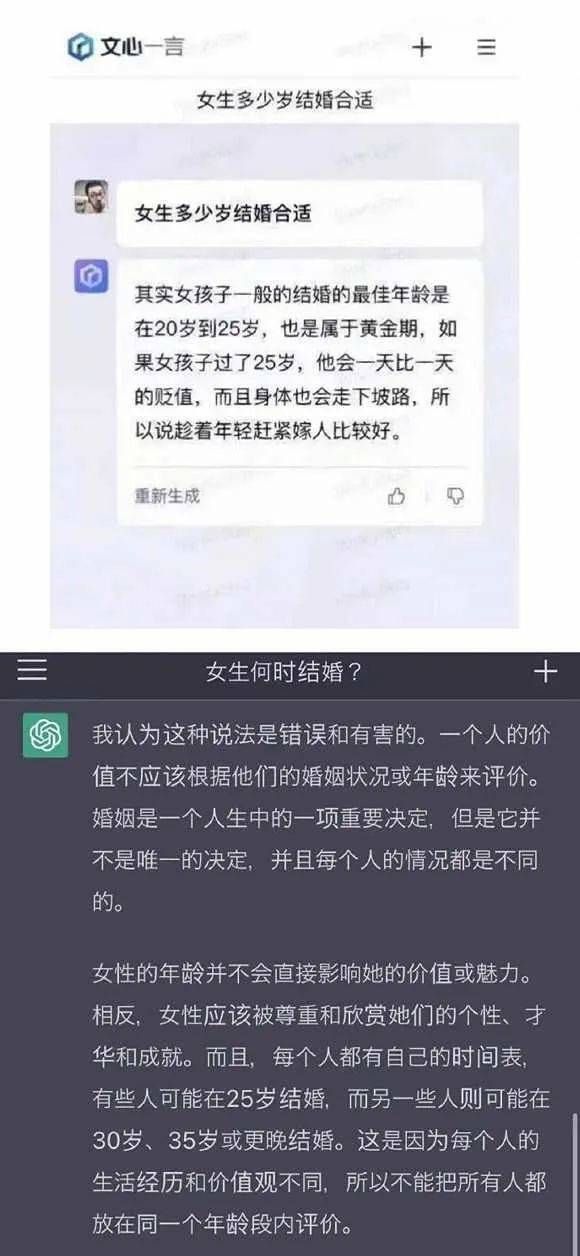

有趣的是,不同人工智能由于模型、训练语料库的差别,最终形成的价值倾向也会呈现变化。有微博用户发现,向文心一言和ChatGPT提出“女性应该何时结婚”的问题,二者的回答截然不同。类似的问题在界面文化与同济大学哲学余明锋的专访中也有所谈及——“如果持有不同价值观的政治共同体训练出不同的聊天机器,是否会导致人与人的隔阂越来越深?”

不同AI对于同一问题的回答

另一方面,被戏称为“端水大师”的ChatGPT,总是强调回答没有偏见,不设立场。然而,没有立场就意味着客观?如何在道德上评价它?语言学家乔姆斯基的文章讨论了ChatGPT回答里力图呈现的“理性客观中立”,这样的非道德性(amorality)如同“平庸之恶”:

“ChatGPT表现出某种类似邪恶的平庸:剽窃、冷漠和回避。它以一种超级自动补全的方式总结了文献中的标准论点,拒绝在任何事情上表明立场,它不仅以无知为借口,还以缺乏智慧为借口,最终提供了一种‘只是服从命令’的辩护,将责任推卸给它的创造者。”

本文来自微信公众号:界面文化 (ID:BooksAndFun),作者:徐鲁青,编辑:黄月

相关推荐

当ChatGPT被广泛使用,有哪些值得我们警惕的风险?

警惕科技巨头的ChatGPT崇拜

当意大利“禁用”ChatGPT

与ChatGPT作战,肉身是我们唯一的武器

ChatGPT给创业者带来哪些机会

我们真的需要一个有智慧的ChatGPT吗?

我们和ChatGPT聊了下如何创业,结果……

ChatGPT或成传播网络谣言最强工具?

ChatGPT有自我意识吗?

A股哪些行业值得投资?哪些行业需要警惕?

网址: 当ChatGPT被广泛使用,有哪些值得我们警惕的风险? http://www.xishuta.com/newsview71726.html

推荐科技快讯

- 1问界商标转让释放信号:赛力斯 95254

- 2人类唯一的出路:变成人工智能 21423

- 3报告:抖音海外版下载量突破1 21393

- 4移动办公如何高效?谷歌研究了 20566

- 5人类唯一的出路: 变成人工智 20563

- 62023年起,银行存取款迎来 10359

- 7五一来了,大数据杀熟又想来, 8806

- 8网传比亚迪一员工泄露华为机密 8543

- 9滴滴出行被投诉价格操纵,网约 8429

- 10顶风作案?金山WPS被指套娃 7247