AI或改变世界战争,真能引发核武大战?

本文来自微信公众号:凤凰网科技(ID:ifeng_tech),综合整理:箫雨,题图来自:视觉中国

本周四,当美国总统拜登参加在白宫举行的AI高峰会时,他向在座的科技领袖们说的第一句话就是“你们正在做的事情蕴含巨大潜力,也存在巨大危险”。

拜登的国家安全助手表示,这一表态反映了拜登对最近一些机密简报的看法。该简报涉及AI这项新技术的潜力,它有可能颠覆战争、网络冲突,在最极端的情况下还可能颠覆使用核武器的决策。

但是,就在拜登发出警告的同时,美国国防部官员在科技论坛上发表讲话时表示,他们认为马斯克等人提出的暂停开发下一代ChatGPT和类似软件六个月的想法是个糟糕主意,因为其他国家不会等。

“如果我们停下来,其他国家不会停”,五角大楼首席信息官约翰·谢尔曼(John Sherman)周三表示,“我们必须继续前进。”

紧张不安

他的这番直率表态凸显了当今整个防务界所感受到的紧张气氛。在发展和控制武器方面,没有人真正知道这些新技术到底有什么能力,他们也不知道什么样的军备控制制度(如果有的话)可能奏效。

这种预感是模糊的,但令人深感担忧。ChatGPT会让那些以前不容易接触到破坏性技术的坏人得逞吗?它是否会加速超级大国之间的对抗,使外交和谈判的时间所剩无几吗?

“这个行业并不愚蠢,你已经看到了自我调整的努力。”谷歌前董事长埃里克·施密特(Eric Schmidt)表示,他在2016年至2020年期间担任咨询机构国防创新委员会的首任主席。

“因此,业内正在进行一系列非正式对话,讨论AI的安全规则会是什么样子。”施密特说。他曾与前美国国务卿基辛格合作,撰写了一系列关于AI颠覆地缘政治潜力的文章和书籍。

对于任何测试过ChatGPT初始迭代的人来说,他们都清楚要在系统中设置护栏。例如,这些机器人不会回答如何用一种药物伤害某人,或者如何炸毁大坝或使核离心机瘫痪等问题。美国和其他国家也是在没有AI工具帮助的情况下开展所有行动。

但是,把这些行为列入黑名单只会减缓这些系统的滥用。很少有人认为,他们可以彻底阻止这些行为。任何试图关闭汽车安全带警告系统的紧急哔哔声的人都可以证明,总有一种方法可以绕过安全限制。

自主性武器

凤凰网科技了解到,尽管AI让这些问题变得普遍,但对于五角大楼来说,这并不是什么新鲜事。十年前,五角大楼就发布了关于开发自主性武器的第一批规则。五角大楼的联合AI中心在五年前成立,旨在探索AI在战斗中的应用。

而且,一些武器已经实现了自动化。例如,能够击落进入受保护空域的导弹或飞机的爱国者导弹,长期以来都具备“自动”模式。当它们遭遇大量来袭目标时,它们能够在没有人类干预的情况下开火,反应速度比人类快。但它们应该受到人类的监督,必要时人类可以中止攻击。

此外,以色列情报机构摩萨德对伊朗顶级核科学家穆赫森·法赫里扎德(Mohsen Fakhrizadeh)的暗杀,使用的就是一种由AI辅助的自主机关枪,尽管它似乎受到了高度远程控制。俄罗斯最近表示,它已经开始制造水下波塞冬核鱼雷,但尚未部署。如果它能像俄罗斯宣传的那样,这种武器将能够自主穿越海洋,避开现有的导弹防御系统,在发射几天后就能发射核武器。

目前为止,世界上还没有签署关于这种自主性武器的条约或国际协定。在一个军备控制协议被抛弃的速度超过谈判速度的时代,达成这样一项协议的前景渺茫。但是,ChatGPT及其类似软件所提出的挑战是不同的,而且在某些方面更为复杂。

核武风险

在军事领域,AI自动化指挥和控制的诱惑将是巨大的,但是危险更大。

自原子弹以来,没有一项技术能像AI那样激发人们对世界末日的想象。自从去年11月ChatGPT开始展示出强大的逻辑推理以来,互联网上就充斥着世界末日的场景。许多都是自我意识的幻想,目的是刺激人们想象,如果一个新兴的智能开始理解世界以及他们自己的目标,即便与它的人类创造者的方式有一点不同,事情会变得多么糟糕。然而,有一种场景不需要太多想象力,因为它的第一步可以说已经迈出了:AI逐渐融入到我们今天拥有的最具破坏性的技术中。

世界主要军事大国已经开始了一场将AI应用于战争的竞赛,军备控制的新时代似乎将要到来。目前,这主要集中在让算法控制单个武器或无人机群上。没有人使用AI来制定大战略,或者参加参谋长联席会议。但是,加速核军备竞赛是个同样诱人的逻辑,它可能会在几年的时间里推动AI进入指挥系统。这个速度有多快在某种程度上取决于技术的进步有多快,而且它似乎进展得很快。它能走多远,取决于我们作为人类的先见之明,取决于人类采取集体克制行动的能力。

AI如何在核对峙的背景下理解自己的目标是一个关键。训练AI玩各种游戏的研究人员反复遇到过这样一个问题:AI对胜利的感知可能难以捉摸。在某些游戏中,AI一直以可预测的方式执行,直到环境中的一些微小变化导致它们突然改变策略。

例如,AI 被教导玩一个游戏,在这个游戏中寻找钥匙来解锁宝箱并获得奖励。它一直这样做,直到工程师调整游戏环境,使钥匙比箱子多,之后它开始囤积所有钥匙,尽管很多钥匙都没用,有时只会尝试解锁箱子。核武器或防御方面的任何创新都可能导致AI出现类似的戏剧性转变。

AI加持的系统可以加快战场决策的速度,以至于它们会产生全新的意外袭击风险,或者是根据误导性或故意错误发出的来袭警报做出决策。

“AI在军事和国家安全领域的一个核心问题是,如何抵御比人类决策速度更快的攻击,我认为这个问题还没有解决。”施密特表示,“换句话说,导弹来得如此之快,必须有一个自动反应。如果是错误的信号怎么办?”

冷战期间到处都是错误警告的故事。例如有一次,一盘本应用于演练核反应的训练磁带不知何故被放入了错误的系统,引发了一次苏联大规模攻击即将到来的警报(正确的判断让所有人解除戒备)。新美国安全中心的保罗·沙雷(Paul Scharre)在他2018年出版的《无人军队》一书中指出,“从1962年到2002年,至少发生了13起接近使用核武的事件”, “这证实了这样一种观点,即未遂事件是核武器的正常情况,即使是可怕的情况”。

出于这个原因,当超级大国之间的紧张关系比今天低得多的时候,许多总统试图通过谈判,为各方的核决策留出更多时间,这样就不会有人匆忙卷入冲突。但生成式AI有可能将各国推向另一个方向,即更快地做出决策。

好消息是,主要大国可能会谨慎行事,因为它们知道对手会做出什么反应。但到目前为止,大国之间还没有就核武器使用规则达成一致。

如何应对?

在斯坦福大学最近发起的一项研究中,超过三分之一的AI研究人员以及“AI教父”杰弗里·辛顿(Geoffrey Hinton)都认为,AI的崛起对人类的生存构成了威胁,与核武器的使用不相上下。辛顿最近刚刚从谷歌离职,以便更自由地讨论AI风险。

他在5月3日接受采访时称:“我只是一位突然意识到这些东西比我们更聪明的科学家。我想说的是,我们应该认真考虑如何阻止这些东西控制我们。这将非常困难,我没有解决方案。”

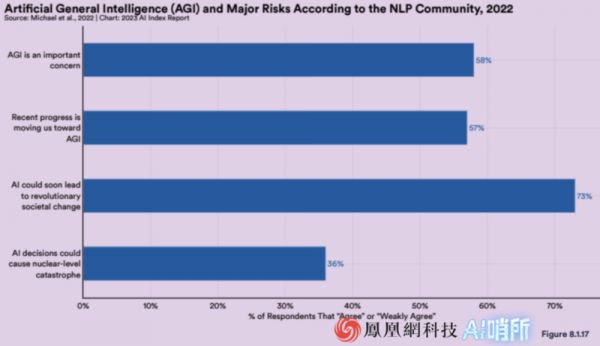

图|36%的研究人员认为AI决策或引发核武级灾难

他还表示,AI的威胁要比气候变化更迫切。 “我不想贬低气候变化的威胁。我不想说,‘你不应该担心气候变化’。这也是一个巨大的风险。”辛顿说,“但我认为,这件事(AI)最终可能会变得更加紧迫。”

今年4月,美国三名民主党人和一名共和党人共同在众议院提出了一项法案,旨在防止AI系统发展到可以自主发动核攻击的地步。此举旨在先发制人,阻止美国国防部做出未来任何可能导致AI自行发射核武器的政策决定。

“虽然美国在军事上使用AI在加强国家安全目的方面是适当的,但在没有人类指挥和控制的情况下使用AI部署核武器是鲁莽、危险的,应该被禁止。”科罗拉多州共和党众议员肯·巴克(Ken Buck)表示。

加州民主党众议员刘云平(Ted Lieu)称,“在保护后代免受潜在破坏性后果的影响方面,我们作为国会议员的职责是要有负责任的先见之明”。他一直在直言不讳地指出,任由AI不受限制地快速发展是危险的。

一些专家指出,既然不可能阻止ChatGPT和类似软件的传播,最大的希望是限制推进这项技术所需的专用芯片和其他计算能力。毫无疑问,这将是未来几年提出的许多不同的军备控制计划之一,因为目前主要核大国似乎对旧武器谈判不感兴趣,更不用说新武器了。

本文来自微信公众号:凤凰网科技(ID:ifeng_tech),AI哨所出品,综合整理:箫雨

相关推荐

AI或改变世界战争,真能引发核武大战?

人民日报评Facebook Libra:改变世界或打开魔盒?

“离婚”引发的战争

BAT“圈地战争”简史:巨头如何改变互联网?

与马斯克有关的28个小趣闻:差点破产,想用核武攻击火星

罕见!AI 引发大裁员:7800 人将失业

王兴与马云的战争

让我们谈谈2020年将改变世界的技术

当AI撞上机器人,一幕改变世界的产业大戏,已悄然开启

5G加持,L4上路,自动驾驶真能说走就走?

网址: AI或改变世界战争,真能引发核武大战? http://www.xishuta.com/newsview73779.html

推荐科技快讯

- 1问界商标转让释放信号:赛力斯 95124

- 2人类唯一的出路:变成人工智能 20535

- 3报告:抖音海外版下载量突破1 20375

- 4移动办公如何高效?谷歌研究了 19720

- 5人类唯一的出路: 变成人工智 19648

- 62023年起,银行存取款迎来 10272

- 7网传比亚迪一员工泄露华为机密 8400

- 8五一来了,大数据杀熟又想来, 8039

- 9滴滴出行被投诉价格操纵,网约 7662

- 10顶风作案?金山WPS被指套娃 7184