OpenAI发布炸裂研究:让AI解释AI黑箱,人类无法理解

本文来自微信公众号:Founder Park (ID:Founder-Park),作者:Founder Park,头图来自:《Her》

就算在新产品满天飞,商业文明正在被 AI 重建的当下,我们仍然不知道,这些令人惊叹的技术是如何运作的。

AI,语言模型,它是个黑箱(black box),人类无法理解,我们甚至不知道怎样研究才能够理解。

但如果,研究这个黑箱的不是人类,而是 AI 自己呢?

这是一个令人好奇但又非常危险的想法。因为你甚至不知道,这一研究方法产生的结果,是否会彻底颠覆多年来人类对人脑和 AI 的理解。

但是有人这样做了。几小时前,OpenAI 发布了最新的研究成果,他们用 GPT-4 解释 GPT-2 的行为,获得了初步的成果。

毫不夸张地说,人们震惊极了:“求求你们让它离觉醒远点吧!”

“AI 理解 AI,然后很快,AI 训练 AI,然后再过几年,AI 创造新的 AI。”

但客观来说,学术界为之感到兴奋:“疯了,OpenAI 刚刚搞定了可解释性问题。”

人与机器之间是 GPT-4

OpenAI 昨日在官网发布博客文章《语言模型可以解释语言模型中的神经元》(Language models can explain neurons in language models)。

简单来说,他们开发了一个工具,调用 GPT-4 来计算出其他架构更简单的语言模型上神经元的行为,这次针对的是 GPT-2,发布于 4 年前的开源大模型。

大模型(LLM)和人脑一样,由“神经元”(neurons)组成,这些神经元会观察文本中的特定规律,进而影响到模型本身生产的文本。

举例来说,如果有一个针对“漫威超级英雄”的神经元,当用户向模型提问“哪个超级英雄的能力最强”时,这个神经元就会提高模型在回答中说出漫威英雄的概率。

OpenAI 开发的工具利用这种规则制定了一套评估流程。

开始之前,先让 GPT-2 运行文本序列,等待某个特定神经元被频繁“激活”的情况。

然后有三个评估步骤:

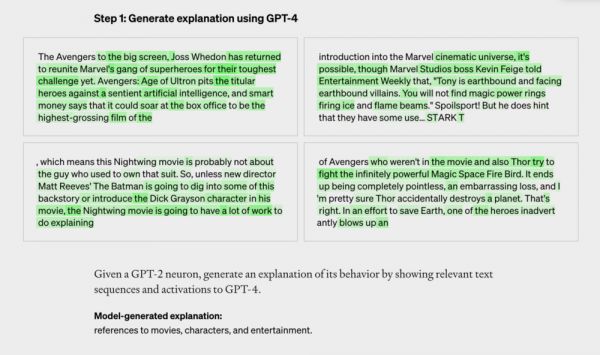

第一步,让 GPT-4 针对这段文本,生成解释。比如在下面的案例中,神经元主要针对漫威内容。GPT-4 接收到文本和激活情况后,判断这与电影、角色和娱乐有关。

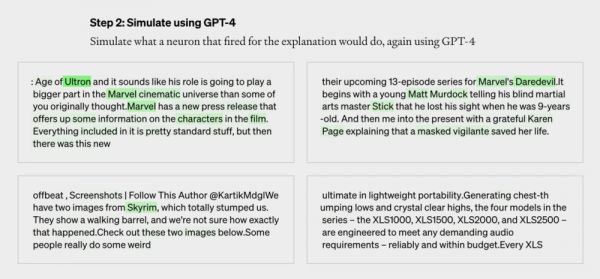

第二步,用 GPT-4 模拟这个 GPT-2 的神经元接下来会做什么。下图就是 GPT-4 生成的模拟内容。

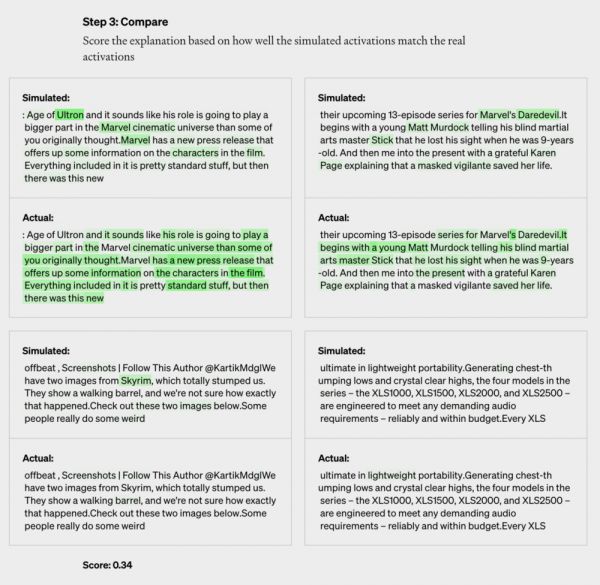

最后一步,对比评估打分。对比 4 代模拟神经元和 2 代真实神经元的结果,看 GPT-4 猜的有多准。

通过这样的方法,OpenAI 对每个神经元的行为作出了初步的自然语言解释,并对这种解释和实际行为的匹配程度进行了评分。

最终他们对 GPT-2 中 307200 个神经元全部进行了解释,这些解释汇编成数据集,与工具代码一起在 GitHub 上发布。

超越语言的机器,人类无法理解的机器

据 OpenAI 在博客文章中表示,目前 GPT-4 生成的解释还不完美,尤其要解释比 GPT-2 更大的模型时,表现效果很差,“可能是因为后面的 layer 更难解释”。

对于 GPT-2 解释的评分大多也非常低,仅有 1000 个左右的解释获得了较高的评分(0.8 以上)。

OpenAI 可拓展对齐团队的 Jeff Wu 表示,“大多数解释的得分很低,或者无法解释实际神经元那么多的行为。比如,许多神经元以一种难以判断的方式保持活跃,它们在五六件事上保持激活,但却没有可以辨别的模式。有时候存在明显的模式,但 GPT-4 无法找到它。”

虽然现阶段成绩不好,但是 OpenAI 却比较有信心,他们认为可以使用机器学习的方式提高 GPT-4 产出解释的能力。

比如通过反复产出解释,并根据激活情况修改解释;或者使用更大的模型作出解释;以及调整解释模型的结构等等。

OpenAI 还提到,这一方法目前还有很多局限性。

使用简短的自然语言进行解释,也许并不匹配神经元可能非常复杂的行为,不能简洁地进行描述。神经元可能会具备多个不同概念,也可能,会具备一个人类没有语言描述甚至无法理解的概念。

最终 OpenAI 希望能够自动化找到并解释能够实现复杂行为的整个神经回路,而目前的方法只解释了神经元的行为,并没有涉及下游影响。

解释了神经元的行为,但没有解释产生这种行为的机制。这意味着即使是拿了高分的解释,也只能描述相关性。

整个过程是计算密集型的。

在论文中,OpenAI 表示:“语言模型可能代表了人类无法用语言表达的陌生概念。这可能是因为语言模型关心不同的事情,比如统计结构对下一个token预测任务有用,或者因为模型已经发现了人类尚未发现的自然的抽象,例如在不同领域的类似概念家族。”

它把 LLM 的这种属性,称为 Alien Feature,在生物领域翻译为“异类特征”。

把对齐问题也交给 AI

“我们正试图开发预测‘AI 系统会出现什么问题’的方法,”OpenAI 可解释性团队负责人 William Saunders 对媒体说,“我们希望能够真正做到,让这些模型的行为和生产的回答是可以被信任的。”

Sam Altman 也转发博客文章称:GPT-4 对 GPT-2 做了一些可解释性工作。

可解释性(interpretability)是机器学习的研究子领域,指的是对模型的行为有清晰的理解和对模型结果的理解能力。

简单来说,目的就是解释机器学习模型“如何做到”(how)。

2019 年开始,可解释性成为机器学习的重要领域,相关研究有助于开发人员对模型进行优化和调整。针对当下 AI 模型大规模应用时,亟需解决的可信度(trust)、安全性(safety)和决策参考(decision making)等问题。

如果我们不知道 AI 是如何作出决策的,始终把它当作一个黑箱,那么就算 AI 在各种场景下表现得再完美,也无法解决部分人类的信任问题。

OpenAI 这次使用 GPT-4 来解决可解释性的问题,就是希望能够使用自动化的方式,让机器完成 AI 研究。

“这是我们对齐研究的第三支柱的一部分:我们希望自动化对齐研究。令人期待的是,这一方向能让它(对齐)与 AI 发展的步伐相匹配。”

在 2022 年夏天,OpenAI 曾发布文章《我们做对齐研究的方法》(Our approach to alignment research)。

文中提到,宏观来看,OpenAI 的对齐研究将由三大支柱支撑:

1. 利用人工反馈训练 AI;

2. 训练 AI 系统协助人类评估;

3. 训练 AI 系统进行对齐研究。

“语言模型非常适合自动化对齐研究,因为它们通过阅读互联网‘预装’了大量有关人类价值观的知识和信息。开箱即用,它们不是独立代理,因此不会在世界上追求自己的目标。”

太快了,连认知都范式革命了

虽然 OpenAI 本意很好,但是这样的研究成果着实吓坏了网友。

OpenAI 的推文下梗图横飞,有不少人在认真地建议 OpenAI 搞慢点。

“用我们不理解的东西,解释另一个我们不理解的东西,这合理吗?”

“护栏都被你撤了”

“这太迷人了,但也让我感到极度不适。”

“自然创造了人类来理解自然。我们创造了 GPT-4 来理解自己。”

“我们要怎么判断解释者是好的?这就像... 谁监督着监督者?”(who watches the watchers)

还有人看到了更深的一层:

“大模型很快就能比人类更好地解释他们自己的思维过程,我想知道我们未来要创造多少新的词汇,来描述那些 AI 发现的概念(概念本身也不准确)?我们还没有一个合适的词描述它们。或者,我们是否会觉得这些概念有意义?它们又能教会我们如何认识自己呢?”

另一网友回应道:“人类本身对自己行为的解释,大多是谎言、捏造、幻觉、错误的记忆、事后推理,就像 AI 一样。”

本文来自微信公众号:Founder Park (ID:Founder-Park),作者:Founder Park

相关推荐

OpenAI发布炸裂研究:让AI解释AI黑箱,人类无法理解

GPT之父Ilya最新斯坦福访谈全文:AI意识,开源和OpenAI商业化,AI研究的未来

让AI说中文,总共分几步?

当人类与AI相爱

GPT-4的黑箱运作方式,让他们怒了

谷歌让普通人读懂 AI

AI导致失业,人类是否应该得到补偿?

AI也有偏见,我们该如何信任它们?

将语言直接翻译成代码,OpenAI内测AI编码器Codex

AI 可能要变得更 “聪明” 了:全新增强学习算法让AI玩游戏可完胜人类

网址: OpenAI发布炸裂研究:让AI解释AI黑箱,人类无法理解 http://www.xishuta.com/newsview74340.html

推荐科技快讯

- 1问界商标转让释放信号:赛力斯 95228

- 2人类唯一的出路:变成人工智能 21183

- 3报告:抖音海外版下载量突破1 21148

- 4移动办公如何高效?谷歌研究了 20339

- 5人类唯一的出路: 变成人工智 20338

- 62023年起,银行存取款迎来 10336

- 7五一来了,大数据杀熟又想来, 8596

- 8网传比亚迪一员工泄露华为机密 8505

- 9滴滴出行被投诉价格操纵,网约 8215

- 10顶风作案?金山WPS被指套娃 7230