比AI灭绝人类更危险的,是愚蠢的AI接管世界

本文来自微信公众号:未尽研究 (ID:Weijin_Research),作者:未尽研究,原文标题:《为什么杨立昆又一次不签名? 担心人类被“不如狗”的AI接管》,题图来自:视觉中国(图为AI专家Yann LeCun)

在上一波人工智能热时,被热炒的一个概念,是人工智能将会替代人类工作,抢了人类的饭碗。一些政客甚至利用人工智能引发的焦虑,提出为每位国民提供“普惠基本收入(UBI)”,成为其竞选纲领。

在接下来的新冠疫情期间,世界各国经历了经济与社会的大停摆,城市遭遇封锁,百姓禁足在家。停止工作的人们,想起了人工智能,“当我们真正需要人工智能替我们工作时,它们在哪里?”

尤其是在公共卫生领域,人工智能被寄予厚望。人们建立模型,预测疫情的传播趋势;对海量的医学论文进行分析寻求灵丹妙药;分析医疗影像诊断患者,等等,当然最厉害的是附体跟踪每个人的行程码/健康码了。结果怎么样呢?

剑桥大学的研究人员搜集了相关科研成果,2020年1月至10月发表在arXiv等预印本论文平台的2212篇论文,符合“机器学习”与“X光/CT诊断”等关键词,剔除忽略数据源或模型信息不完整的,入选最终评审的有62篇。

这62篇论文,没有1篇具备潜在的临床价值。

“这次的疫情是一次对人工智能和医学的重大考验,不过我认为我们没有通过这个考验。”负责这项回溯研究的德里格斯(Derek Driggs)称。

今年初,在欧亚集团的2023年风险分析报告中,以ChatGPT 为代表的生成式人工智能,被排在风险的第三位,而且被称为大规模破坏性武器。“今年将是颠覆性技术在社会中发挥作用的转折点。”

所以,这些人工智能大佬们提出的,与那些政客和政治风险分析人士相比,有什么新鲜的东西吗?他们用来描述风险的两个词,一个是“extinction”, 一个是“existential”,其意义都是人类作为一个物种的生存或者毁灭的问题。

几个月前,马斯克资助的未来生活研究所,发起了一场公开信签名运动,呼吁先进大模型研究暂停6个月,其理由是人工智能的发展正在失控。但马斯克担心的,主要是他自己失去了对人工智能的控制,他一方面批评大模型发展太快,一方面自己到处吹嘘自动驾驶很快实现;其脑机接口技术,仓促研发中安全漏洞百出,实验申请一再被FDA打回,最近才通过。他还悄悄地注册了一家人工智能公司,并且开始囤积用于训练大模型的GPU芯片。

这一次发起签名的,是位于旧金山的人工智能安全中心(Center for AI Safety),发布了一份声明,总共22个单词,只有一句话:减缓人工智能的灭绝风险,应该与其他社会规模的风险(例如大流行病和核战争)一起成为全球优先事项。听起来像是这群通用人工智能的信仰者们,在向人类发出一条公关prompt(提示句)。

350位签名者,基本上都是人工智能专家。带头者有深度学习之父辛顿,与其一同获得图灵奖的本吉奥;还有深度学习最著名的三家初创公司创始人和CEO,DeepMind的哈萨比斯,OpenAI的奥特曼,以及Anthropic的阿莫迪。

三位中国AI科学家也参与了签名:清华大学的张亚勤和詹仙园,中国科学院的曾毅。

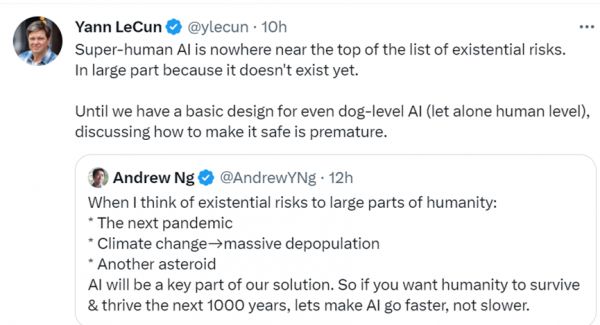

这一次,被称为深度学习三巨头之一、与辛顿和本吉奥共同获得图灵奖的杨立昆,再一次选择不签名,因为他认为现有的人工智能,还处于非常初级的阶段,距离人类智能的水平还很遥远。

“在人类最重要的生存问题清单上,根本排不上超越人类的人工智能。主要是因为它还不存在。直到我们能设计出起码达到狗狗水平的智能(更不用说人工智能了),再来谈安全问题也不迟。”

杨立昆转发了吴恩达的推文:“我想到的对人类形成的主要生存威胁:下一次大流行病;可能导致人口大量减少的气候变化;再来一次小行星撞地球。面对这些,AI将是我们解决问题的关键。所以,如果你们想让人类在未来1000年中生存并繁荣,应该让AI发展得更快,而不是更慢。”

两次活动,硅谷最知名的华人科学家/创业者李飞飞、吴恩达等,都没有签名。吴恩达旗帜鲜明地公开反对。

美国一些科技媒体尖锐地指出,如果OpenAI想更加负责的话,它应该对其用户更加透明,它应该更清楚地向公众说明自己的局限性,毕竟多数人都拿它当搜索来用,而媒体为博取流量的夸张标题,让许多吃瓜群众都以为ChatGPT是个一贯正确的通才、奇才。

尽管ChatGPT 在首页提醒了自己的局限:可能偶尔会产生不正确的信息;可能偶尔会产生有害的指令或有偏见的内容;对 2021 年后的世界和事件的了解有限;许多用户无法容忍的,是它在洋洋洒洒的文章和头头是道的叙事中,隐藏着事实性错误。

最近中国也在如火如荼地炼制大模型。中国已经拥有10亿参数以上大模型79个,而14个省市也在加大算力炼制,很快地,基于这些大模型开发的应用,也会出现所谓“寒武纪物种大爆发”。如果打开手机上的一个中文搜索引擎时,跳出来的文章,出自的自媒体号是一个化名,而那些读起来有拼凑感的文字,基本上可以据此断定是人工智能生成的文章。

新冠期间数千篇的人工智能+医疗健康的论文,最终被证明没有临床价值,这也提醒我们,每天一觉醒来那些未经审核的论文扑面而来,完全没有必要因为读不过来而感到焦虑。

当前用户和资本仍然处在兴奋期,对生成式人工智能技术存在缺陷尚能容忍,奥特曼们的当务之急,也许并不是去奢谈什么科幻式的“毁灭人类”,而是要趁着这个窗口期,让大模型的幻觉问题得到明显解决。否则的话,生成式人式智能的应用范围将很快发现它的边界。

所以,当下人们对AI最担心的应该是什么?也许机器学习领域的先驱人物 、《终极算法》作者多明戈斯(Pedro Domingos)的一句话,点明了我们当下最应该担忧的:

“人们担心计算机会变得过于聪明并接管世界,但真正的问题是计算机太愚蠢了,并且它们已经接管了世界。”

本文来自微信公众号:未尽研究 (ID:Weijin_Research),作者:未尽研究

相关推荐

比AI灭绝人类更危险的,是愚蠢的AI接管世界

超350位大佬联名发声:AI可能灭绝人类,堪比核战争

AI更智能,人类更愚蠢

人类灭绝是件糟糕的事情吗?

开发比人类更聪明的AGI会导致世界毁灭吗?

自动驾驶汽车真的比人类驾驶汽车更安全吗?

AI写作,人类不能视而不见

AI或改变世界战争,真能引发核武大战?

又一封“警惕AI、保卫人类”的公开信发出

新书《Human Compatible》书评:AI与我们的未来

网址: 比AI灭绝人类更危险的,是愚蠢的AI接管世界 http://www.xishuta.com/newsview77057.html

推荐科技快讯

- 1问界商标转让释放信号:赛力斯 94953

- 2人类唯一的出路:变成人工智能 19253

- 3报告:抖音海外版下载量突破1 18966

- 4移动办公如何高效?谷歌研究了 18490

- 5人类唯一的出路: 变成人工智 18351

- 62023年起,银行存取款迎来 10127

- 7网传比亚迪一员工泄露华为机密 8182

- 8顶风作案?金山WPS被指套娃 7096

- 9大数据杀熟往返套票比单程购买 7045

- 10五一来了,大数据杀熟又想来, 6865