大模型+机器人,发展到什么阶段了?

本文整理自险峰主题沙龙《AI浪潮下:机器人领域新机遇》,主持:邓卓兵,嘉宾:杨健勃、邵天兰、弭宝瞳、李宇浩、许华旸、曾祥永、谢思为、董豪,原文标题:《现实与梦想:聊聊AI与机器人》,头图来自:视觉中国

一、大模型+机器人发展到了什么阶段?如何看待未来的趋势?

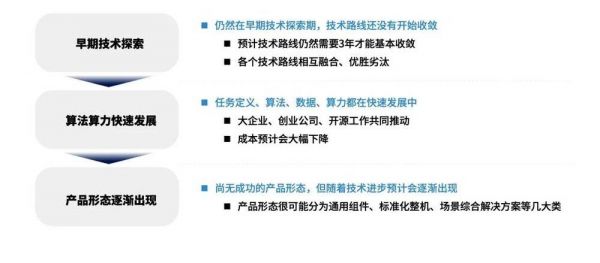

嘉宾A:首先,大模型+机器人还处于非常早的技术探索期,一个很明显的特征就是技术路线还没开始收敛。

比如深度学习,2012年它刚登场时,和今天大模型一样惊艳,直接把图像识别准确率提升到了90%多,2015年又出现了Alpha GO,直到2018、19年,深度学习才逐渐收敛,最直观的反映就是高引论文开始没那么多了。

因为早期大家还在尝试不同路线,到后面慢慢形成共识,彼此的东西越做越像,模型结构上也就不会再有大的质变。目前大模型还远没到这个阶段,微软谷歌英伟达,彼此之间甚至连任务定义还都不一样。

第二是算力算法的进步速度。举个例子,2012年时,你用电脑跑一个5亿参数的模型(在今天看起来都属于小模型),动辄也要跑半个小时;但现在你用最常见的因特尔CPU,跑5亿参数只需要零点几秒,甚至不需要挂AI芯片,也几乎没有成本。

所以,我们今天看大模型创业,需要多少个GPU,一算账要好多钱,就觉得这件事干不了,但10年之后再看,这些可能都不是问题。现在英伟达等巨头都在算力方面发力,对此我还是比较有信心的。

第三是大模型+机器人还远未形成固定的产品形态。

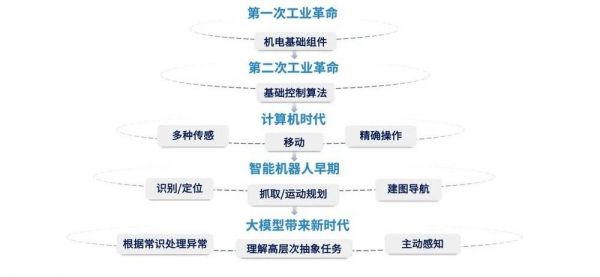

我们看人类历史,机械的进步=控制力的进步:比如第一次工业革命,诞生了气缸这样的基础组件;到第二次工业革命,有了基础控制和自动化,人类开始能够通过机械操控机械;到计算机革命时代,有了PLC(可编程控制器),开始用电脑控制机械,再后来,我们用3D视觉AI控制机械,到现在用大模型控制机械。

可以看到,每个时代之间不是替代关系,而是补充关系:不是说有了计算机,机械控制就没用了,而是通过计算机对机械控制赋能,让机械有了更强的能力,由此诞生出了更多的产品形态。

大模型也是一样,机器人进化和人类进化很类似:首先,机器人要能站得稳,能走直线,不会摔倒——对应到人脑,就是小脑部分要解决的问题;后来慢慢发展出了语音识别、图像识别,这时已经对应到了大脑中某个特定区域;到现在大模型出来之后,相当于进化到了前额叶的部分,AI也开始能具备一些“基本智力”。

所以,未来我们比较看好AI的三个方向:

1、根据常识处理异常:比如说自动驾驶,现在AI已经可以做到识别障碍物,但是如果路边有人举个牌,说前方桥断请绕行,AI能不能明白这些字的含义?再比如路上看到交警向你打手势,AI能不能根据常识,知道自己要靠边停车?

2、高层次抽象任务:比如说我和机器人说,“请把这个房间收拾一下”,再比如在仓库场景中说,“请按清单打包发货”,这些都属于高层次抽象任务——它不是一个单独的指令,而是要向下拆解成很多子任务和子指令。

3、主动感知:比如我让AI从冰箱里拿瓶水,打开冰箱后如果没看见水,机器就会停在这一步,但如果是人就知道再翻一下,看看水是不是放在最里面了?

以上种种这些,过去的AI还都做不到,但大模型很可能会实现。举个例子,现在微软使用GPT的技术,已经可以做到简单的抽象任务,比如你和机器人说“把饭热一下”,它知道要去找微波炉。

换句话说,现在已经可以通过语言模型,让机器人在热饭和微波炉之间建立联系——AI知道要找到微波炉,打开,把饭放进去。

包括谷歌、英伟达也都开始尝试,在大语言模型上加入跨模态和机器人操作,这方面网上的视频资料很多,也非常震撼,大家感兴趣可以找来看看。

二、大模型为机器人带来了哪些通用能力?有什么是值得我们憧憬的?

险峰:过去机器人更像一种专用设备,各种能力要依赖于工程师写代码,但大模型出现后,AI出现了泛化能力,GPT已经成功颠覆传统软件行业,那我们该如何憧憬大模型对机器人带来的影响?

嘉宾B:机器人虽然带了个“人”字,但它依然还是一个效率提升的工具,既然是工具就要分场景、分功能,比如天上用的和地下用的,室内用的和室外用的机器人肯定不一样。

所以,我认为很难出现一个可供所有机器人使用的统一大模型。更可能是不同专业公司,根据不同场景,搭建出一个个垂直大模型,再与机器人做深入的结合。

嘉宾C:我觉得带来的改变主要有三个方向:

第一是效率提升,比如高空擦玻璃,这个行业过去三五年最大的变化,是慢慢把高空工人替换成了机器人,因此效率提高了3-6倍,同时还收集了大量工艺参数,但这些参数还是要靠人做数据分析,如果可以通过大模型进行泛化,效率还会进一步提升。

第二是场景感知。举个例子,一块玻璃有没有洗干净,过去很难判断,因为户外场景下,光线环境非常复杂,不管是雷达、超声都不好使,只能靠人为判定,如果大模型可以让机器有了人的感知能力,自主判断一块玻璃是否达到了物业验收标准,就能进一步提效。

第三是产品设计。过去要做一款机器人产品,第一步先要访谈大量客户,梳理需求,形成产品洞见,一个产品成败50%取决于产品定义的方向选择,大家如果创过业应该都知道,写PRMID非常耗时,但现在可以借助大模型实现创新,比如把一部分工作交给GPT去解决。

嘉宾D:我们是做2C服务类机器人的,其实站在客户的视角,他不管你具体做的什么机器人,他的认知就你这东西能不能替代我一个人工?能不能够减员增效?但坦白讲现在的机器人很难实现1对1替代。

机器人拆开就四件事:感知、决策、控制、交互,现在这四件事机器都没办法做得像人,核心原因还是智能化水平不够。一年前我们还认为,没有任何方法能解决这些问题,但突然GPT出现了,现在我们也在尝试用它开发新的产品线。

但我认为至少5年内,还很难出现人形的大模型机器人,从我掌握的知识背景来看,挑战有点过大,如果大家对大模型机器人的憧憬是变形金刚或者高达,那可能还需要等很多年。

嘉宾E:大模型首先要有大数据,比如训练ChatGPT,用的是网上的文本文字,但是训练机器人,往往要用3D数据,网上没有现成的,只能靠人工采集,效率很低,所以之前我们看到一些机器人公司,采了半年的数据,训练的模型还是只能在局部环境里使用。

未来,大模型可能会不一样,比如可以在虚拟环境里训练AI,然后更高效地匹配真实世界;或者直接利用2D数据训练3D机器人,比如刚才主持人提到的,给机器人看人类搬东西的视频,慢慢机器人也学会了搬东西,这两种方法未来都有可能成功。

对于通用大模型机器人,我还是比较乐观的。我们说最简单的智能机器人其实是无人机,能跟随你拍照,但和周围环境还没有太多互动;后面出现了自动驾驶,AI开始和地面环境做交互;再后来有了机械臂,开始和真实世界直接物理接触。

整个过程中,难度其实是不断上升的,所以我觉得等自动驾驶完全成熟以后,通用型机器人就会慢慢出现,因为整条技术路线是相通的,可以慢慢迁移过去。

三、大模型给机器人交互方式带来哪些变化?

险峰:刚才大家谈了机器人如何感知、理解和执行任务,如果有一天大模型机器人具备了很超前的智力,在交互方式上会怎么变化?

嘉宾F:用户对于家用机器人可能会有期待,希望交互更顺畅、更智能,但我们做工业机器人的还没有迫切需求。工业场景中,语音交互一直也不是主流,大家还是更习惯用操作杆和遥控器;所以未来,VR+手势可能会是比较好的方向。

嘉宾G:我们做服务机器人的,交互方案已经很结构化了,就是给客户提供一个用起来很爽的pad——但我们也发现,客户仍然会不满足,因为服务行业普遍教育程度不是很高,他们不希望有任何学习成本,所以我认为,基于自然语言交互的服务型机器人一定会有需求。

嘉宾H:交互可以分成两类,一是机器与人的交互,二是机器与环境的交互。

人的交互,其实不只是和机器人,应该叫智能硬件+大模型,比如小爱或者小度,你告诉它把房间灯关了,有时不一定能真的关上,但有了大模型,它可以通过光线感知到灯到底有没有关。

另一个是多语言能力,比如之前只能和它用中文交流,现在可以多种语言切换,直接卖给海外客户,也不需要重建新的数据集。

还有就是陪伴和情感需求,特别是海外用户,比如英国一家做人形机器人的公司叫AMECA,大家可以搜搜它们的产品,已经有点恐怖谷效应了,未来机器人接入大模型后,对于需要情感陪伴的人可能是个好消息,尤其是老年人。

(图:AMECA机器人)

至于机器与环境的交互,我觉得核心竞争力还是要收集到每个细分场景的小模型。

举个例子,特斯拉要用人形机器人造车,就先要收集每个工艺环节的数据,比如把一块挡风玻璃安在车身上,机器人具体需要调动哪些“关节”和“肌肉”,如何判断安装的位置在哪,这是一整套非常专精的小模型。

现在国内也有公司在做类似的事情,用大模型底座调度生成自己的小模型,目前这条路看起来是走得通的。

嘉宾J:我认为人机交互方式越简单越好,以前我也用过很多智能家居,但是用到最后我宁愿不用,还是普通开关更方便。

其实最好的交互就是没有交互,比如我拿着一个大箱子往前走,机器人能知道要帮我开门,或者接过来帮我拿;我吃完饭走了,机器人知道应该要收拾餐具,类似于这些对人类意图的识别,如果大模型机器人具备了高级智力,或许更值得期待。

四、大模型能否解决机器人数据收集难、生成难的问题?

险峰:刚才很多嘉宾都提到,机器人训练数据“收集难、生成难”,大家如何看大模型对机器人数据的影响?会有哪些新的变化?

嘉宾K:目前我们的做法还是:前段靠仿真,中段靠真实作业效果,最后由人来做评估修正;我觉得不只是我们,现在很多工业场景里机器人的工作方式,在工艺层面已经和用人工完全不一样了,很难单纯地迁移过来,不是说看看人类的录像就能解决的。

嘉宾L:我觉得做通用人形机器人,收集数据可能没有那么难,我们内部讨论过,包括OpenAI的CTO也讲过类似的逻辑,就是人身上能收集到的数据密度其实挺高的,比如你给1万个人带上传感器,跑上一年所有数据都有了。

这件事本身不难,主要还是商业伦理的问题,但我觉得还是钱的问题,比如你给10万人装传感器,一人一年给10万美金,总会有人愿意,这个数据量也完全够用了。

嘉宾M:我展开讲讲数据收集,目前主要有三条技术路线:

一是收集动作库:它比较适合于生产流水线——每个工位上的动作不会有太大变化,但需要多次重复的任务;它的优点是只需要训练一次,后面机器人就不需要做大调整,但缺点是非常耗时。

比如PaLM-E,效果确实非常好,但为了训练它,谷歌用了13台机器人,收集了17个月数据,一共收集了5620亿个参数,而这还只是家用机器人,只需要一个底盘+一条机械臂+摄像头,如果是用在工业流水线上,采集的时间和数据量都是要翻倍的。

(图:谷歌的PaLM-E机器人)

第二条路线叫遥操作,也就是特斯拉正在做的:给人戴上VR和触觉传感器,把整套传感数据投射到机器人身上,直接告诉机器人如何像人一样运动。

比如腾讯做的四足机器狗,研究人员在一条金毛身上装了一套的动捕设备,再将收集到的数据抽象压缩到神经网络模型中;以前的机器狗动作极其僵硬,但用了金毛数据后的机器狗就变得非常灵活。

第三条路径叫模仿学习,就是人直接在机器人面前演示一遍,机器人就学会了。比如家政或者保洁工作,我打开洗衣机把东西放进去,只需要教一遍,不需要采集数据,也不需要动捕。

这个事情可能大家听起来比较科幻,但像CMU、MIT都已经发过不少论文,尽管还没有看到这个技术直接用在哪个场景上,但如果未来能实现,会是非常颠覆性的事情。

总之,目前每条技术路径上,都有很多公司或高校在尝试,最后很可能是几条路线混合在一起,发展出一套最适配的AI+机器人解决方案。所以这段时间,我们一直在密切关注各大科研机构的论文,还有特斯拉、DeepMind做了哪些新工作,有哪些是可以被国内公司借鉴学习的。

嘉宾N:讨论这个话题之前,我们首先要搞清楚,收集数据的目的是什么?比如让一只金毛跑来跑去,当然可以收集到数据,但这个数据只能让机械狗动作更自然,而不能让机械狗学会做某件事情。

如果要机器学习的话,那对数据质量的要求就高多了,这个时候又有一个大问题,就是数据采集的成本是很高的,但不同型号机器人之间的数据并不通用。

举个例子,你好不容易训练好一个型号的机器人,但你的硬件总要升级迭代,假设到下一个型号里,机器人要换一种新的电机,那之前的数据等于就全废了,所以我们最近也在跟斯坦福合作,研究怎么让收集的数据和机器人型号是无关的,无关就可以让数据永远有效。

此外,遥操作的另一个问题是ROI太低了,工厂场景+固定工位还可以,但要实现通用基本不可能。所以,现在行业里大部分人还是采用虚拟训练的策略,因为虚拟环境下,物体可以随便生成,成本也非常低。

举个例子,比如叠衣服,先让机器在虚拟环境里叠各种形状的衣服,成功率可以到90%,然后放到真实环境里叠,成功率可能直接就降到5%了,但这已经足够了。

因为有了5%的成功率,AI就可以自己采集成功的轨迹数据,只要有5%作为起步,明天就能到10%,后天50%,再过几天100%,这样采集的ROI就特别好,不用人去干预,所以本质上,数据是用算力换的,而不是用人工换的。

五、大模型+机器人会有哪些应用场景?创业门槛有多高?

嘉宾P:我个人比较看好工业实践中应用,我们说自动化做了这么多年,到今天还是冰山一角,还有非常大的发展空间,原因是过去自动化的非标程度太高了。

举个例子,假设你是个自动化专业的学生,大学4年出来,可能连每种导轨、电机的型号都还认不全,不是你学得不好,是种类实在太多了。而这么多硬件组合在一起,会导致一个问题,就是让自动化过于依赖规模生产和工艺稳定。

比如说薯片,这个品类的自动化水平非常高,因为这么多年来,薯片除了口味,从外观到包材几乎没有变化;在过去,也只有这种大规模+长时间的连续生产,才能诞生出高自动化水平的设备。

但问题是,绝大部分行业的迭代周期远没有薯片长。

比如说汽车,以前汽车是机器人大规模应用的代表,这个行业的特点就是高投入+长周期,一款车光调试产线就要一年半,然后可以持续卖10年;但现在行业越来越卷,生产周期越来越快,一款车一共可能只能卖一年半,就要推新产品上市。

过去中国机器人行业十年涨了十几倍,但这期间汽车行业一直是下行的,此消彼长,传统主机厂那套高投入的玩法注定是无法持续的,这就需要更高柔性的自动化。

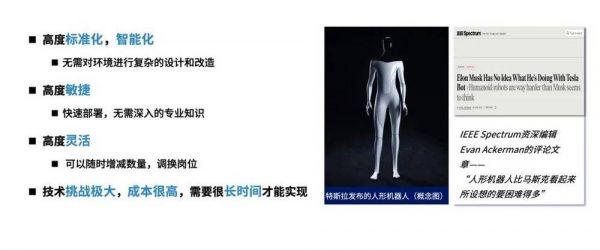

马斯克意识到了这点,所以他才认为人形机器人是终极解决方案——类似于把拧螺丝这种工作高度标准化、智能化,然后快速部署,这里用完了可以马上到别的地方用。

不过,开发人形机器人的难度也很大,并不是短时间内可以做出来的,但是这个过程中会产生很多技术,比如移动、抓取、视觉感知等等,结合大模型会有很多新技术的产出,由此也会诞生出新的产品,创造新的价值。

而当有一天,这些技术最终组合在一起,那时候人类可能就要担心一下了。

最后讲讲我对这件事的判断,首先大模型+机器人是非常重大的机会,如果你能做出很好的产品,后面的竞争者再进来会特别难受,产业形成闭环后门槛也会非常高。

但同时,这个行业对于人才、技术和资金的需求也非常恐怖,参与者要么是不差钱的科技巨头(比如谷歌微软),要么是头部的创业公司,当然还有传统工业巨头和高校研究所。

总之这个事情和以前的创业不太一样:互联网时代做个APP,可能几个人就够了,所以那时候我们能听到很多个人英雄主义的故事,但现在小公司可能电费都付不起。

从这个角度说,大模型+机器人是一个人类最高科技的集大成者,创业者要跑出来非常困难,当然,一旦成功,它能产生的价值也是非常巨大的,会把人类的自动化程度带到一个全新的高度。

六、大模型机器人距离落地还有哪些障碍?

险峰:刚才大家谈的都是大模型的积极影响,那么大模型会给机器人带来哪些额外问题?这件事距离最终落地还有哪些潜在的障碍?

嘉宾Q:首先大模型不可能部署在端侧,至少3-5年内绝无可能,所以现在大家都是端+云的模式,那对我们来说,第一个难点就是端+云的结构怎么搭?我觉得比较好的解决方案,是在端侧做一个动态的小模型,可以实现一些基础的现场交互,大模型的部分放在云端,当然这是个技术问题。

由此带来的第二个问题就是信号丢失,一旦没信号,机器人就只剩端侧智能了,我都接收不到信号我怎么控制它?只能保证最基础的让它不要撞到人;另外信号延迟也是问题,人机做交互延最怕延迟,所以我觉得,机器人通用大模型部署绝对不是一家公司的事,需要大家一起建设整个网络,这个模型我们自己肯定做不出来,但如果meta做出来我们马上会用。

嘉宾R:我觉得最大的障碍还是安全问题。把数据上传到云端大模型,相信每家企业都会有顾虑,这其中的知识产权和数据安全都要打问号,所以我们最近也在尝试,使用一些开源的小模型,叠加一些行业数据,打造一个垂直领域的专用模型。

这样的好处是,如果客户对数据安全要求特别高,我们可以直接把小模型部署在它指定的服务器上,只有如此,才能彻底消除客户对数据安全的顾虑。

另外就是算力的瓶颈,作为一家机器人公司,我们不可能投入那么多的显卡资源,我们最近也积极买卡,但要等好几个月才能交货。

嘉宾S:我觉得有三个问题,一是执行速度:比如谷歌的PaLM-E,可以从抽屉里拿东西,但那个视频是加了4倍速的,换言之,现实里机器人的动作只有视频速度的1/4,这个速度在大部分场景都还不能替代人。

第二是执行成功率:谷歌说他们用了大模型之后,把执行成功率从60%提升到75%,甚至80%,作为家庭机器人已经够用了,但要注意的是,这已经是当前大模型+机器人的最佳水平了,如果要用到更高精度的场景,比如半导体仪器的操作,或者给老人喂饭,要精确对准老人的嘴,后面还有很长的路要走。

第三是数据,谷歌PaLM-E主打家用场景,可以随便收集数据,特斯拉有自己的工厂,也是想收就收,但如果未来一家机器人公司,想要进入一家车厂收集数据,它可以收集到什么程度?工人会不会配合?这个事情现在是无解的。

以我的了解,目前这些数据很难被带出工厂,所以就看哪家机器人公司可以率先突破,比如和客户建立比较好的信任关系,但这又带来一个问题,就是A车厂的数据能不能拿给B车厂用?这些都是需要探索的。

嘉宾T:我也关注安全问题,但主要是指物理安全。开源的语言大模型,顶多是有偏见,它并不会伤害你,但如果大模型与机器人做结合,一些错误的理解可能会导致意外的连锁反应,比如你让机器人用烤箱做西餐,它却做了中餐,结果打开燃气意外失火等等。

现在很多人都在研究,如何在自然语言大模型中实现价值观的对齐,这是一个研究热点,但是在机器人领域还没有人研究,当然可能是技术还没发展到这个阶段,也可能是要出现风险后才会有人去研究。

七、机器人公司的壁垒会如何变化?

险峰:目前人形机器人距离我们还比较远,但从长远趋势看,机器人的智能化水平一直在稳步提升。

特别是大模型出现后,机器人的构建逻辑、交互逻辑全都变了,未来机器人公司的壁垒、评价标准会如何变化?各位怎么看?

嘉宾V:长远来看,一家大模型+机器人公司好不好,一个评估指标就是看它能不能突破新场景。

这么多年来,机器人要不是天上飞的,要不是地下跑的,已经被开发得差不多了,现在有了大模型,那一些以前机器人解决不了的场景,现在是不是可以被解决?另一方面,随着一些新行业崛起,比如光伏、锂电池这些产业链上,能否诞生机器人的新机会?这些是我们比较关注的。

此外,大模型可能带来一些机器人形态和硬件的改变,比如电子皮肤,也就是触觉传感器可能会是个方向;还有软体机器人,把机器人做成硅胶材质或者折纸结构的,可以自由伸缩,类似这样一些“人无我有”的技术,也会是很好的壁垒。

嘉宾W:过去大家讲SaaS,软件即服务,如果机器人能实现规模化应用,下一个就会迎来RaaS时代(机器人即服务)。机器人本身只是一个载体,核心是为客户提供服务,这里面就会有两个壁垒:

一是把机器人本体做得稳定、可靠,执行成功率要足够高,同时成本足够低;二是规模服务化的能力,比如有成千上万台机器人同时在跑,后面你每增加一台新机器,如何保证服务质量不下降?我觉得企业先要做到这两点,才能谈怎么与大模型做结合。

嘉宾X:机器人本质还是制造业,规模化生产和服务能力是必需的,除了这些基本功以外,大模型技术最颠覆的还是为发明创造提供一种新工具,比如现在很多高校老师都在借助GPT搞科研,简而言之,大模型是一种可以支撑发明的发明。

所以在机器人领域,大模型也可以帮助企业形成一些行业内的场景库、任务库、数据库和工艺库,这些会是企业构建垂直模型的核心壁垒,一旦你的产品体验比对手好3-5倍,客户就不会再给他们机会了。

嘉宾Y:现在人形机器人非常火,我本人也是马斯克的粉丝,但我坚决不认为人形机器人会成为主流。

为什么机器一定要做成人的样子?我自己就是产线工程师出身,从能耗角度讲,流水线是最好的方式,轮子的能量利用效率比用腿高10倍以上,你做了一个人形机器人,放弃了传送带,改用腿或者四足去搬东西,这是一种技术的倒退,非常可笑。

再比如你做个做饭机器人,它一定要长成人的样子,在灶台前拿个铲子炒菜吗?一家餐厅本来要招10个人,现在说不用了,咱们搞10个人形机器人吧,未来会是这样吗?一定不是,到时候餐厅一定是对整个后厨做全自动化改造,让人不用进入后厨,就可以完成出餐;这背后的核心,是你如何理解这个场景中的任务,以及怎样设计流程效率最高。

所以,最终绝大多数的机器人一定不是人形,对于某些工作,通用能力本身可能就是一种负担,因为客户付不起额外的成本——我只需要的一两种功能,你非要给我一个完整的人,那我为什么要为我用不到的功能买单?

嘉宾Z:人形确实是最难的机器人形态,双臂+双足+全身关节控制,要最后落地是个很长远的事情,但我觉得现在投资人看好人形的逻辑是:谁能做好人形,谁就有可能做好其他的机器人形态。

一家公司,只要团队足够优质,在它向着人形去努力的过程中,中间可能就有一些东西会跑出来,比如在中途突然发现一路岔路,沿着它最终做出一个好产品,这件事在互联网时代已经反复印证了。

另一个思路,也是马斯克的观点,就是世间有没有一种形态,是可以适应所有人类场景?完成所有人类工作的?

确实,现在很多很多标准化工序可以传送带解决,但要想实现通用性,可能最适应人类社会形态的还是人本身;所以,我还是比较笃信人形机器人的,未来能替代人的,最终还是一个长得像人的东西。

相关推荐

大模型+机器人,发展到什么阶段了?

阿里云正在实验将千问大模型接入工业机器人

大模型“涌现”的思维链,究竟是一种什么能力?

国产工业机器人突围之战:AI大模型加速装“脑”上机

变形机器人用上AI大模型!现场表演高难度瑜伽,能表现100+种情绪

亮相世界人工智能大会 “大模型”有哪些大本领?

大模型的智能,不是人类的智能

AI大模型只能沦为“锦上添花”吗?

大模型的未来在哪?

扫地机器人站上风口,下半场拼什么?

网址: 大模型+机器人,发展到什么阶段了? http://www.xishuta.com/newsview83292.html

推荐科技快讯

- 1问界商标转让释放信号:赛力斯 95228

- 2人类唯一的出路:变成人工智能 21183

- 3报告:抖音海外版下载量突破1 21148

- 4移动办公如何高效?谷歌研究了 20339

- 5人类唯一的出路: 变成人工智 20338

- 62023年起,银行存取款迎来 10336

- 7五一来了,大数据杀熟又想来, 8596

- 8网传比亚迪一员工泄露华为机密 8505

- 9滴滴出行被投诉价格操纵,网约 8215

- 10顶风作案?金山WPS被指套娃 7230