谷歌“AI周边”大放送:想做大模型时代的大平台?

谷歌云大会上,再次投注了生成式AI。

当地时间29日,谷歌举办了Google Cloud Next 2023大会,宣布了20多款产品更新。

继昨天Semianalysis爆料谷歌GPU算力至强后,谷歌发布了一款全新AI芯片Cloud TPU v5e,专为大模型训练推理所设计。同时,还推出了配备英伟达H100 GPU的A3虚拟机。

在面向开发者平台Vertex AI中,谷歌发布了全球首个能够识别水印的工具、以及接入Llama 2、Claude 2大模型接入平台。

此外,人工智能助理Duet AI也完成了在办公全家桶Workspace的更新。

这场人工智能大战,谷歌全力点火,试图通过不断创新给予微软致命的一击。

全新AI芯片:Cloud TPU v5e

在英伟达凭借H100在AI行业中出尽风头后,周一IBM推出了模拟人脑的AI芯片,通过更低的能耗更高的效率向英伟达的芯片霸权发起了冲锋。

谷歌也不甘示弱,在昨晚披露了公司新一代的AI芯片:Cloud TPU v5e。

Cloud TPU v5e专为提供大中型训练与推理所需的成本效益和性能而设计。

与Cloud TPU v4相比,TPU v5e可为大语言模型和生成式AI模型提供每美元花费中高达2倍的训练性能和2.5倍的推理性能。

Cloud TPU v5e的成本不到TPU v4的一半,但可以让更多企业训练和部署更大、更复杂的AI模型。

TPU v5e Pods能够平衡性能、灵活性和效率,允许多达256个芯片互连,聚合带宽超过400 Tb/s和100 petaOps的INT8性能。

并且支持八种不同的虚拟机(VM)配置,单片内的芯片数量从一个到250多个不等。

用户可以根据自身的需求选择合适的配置,Cloud TPU v5e可以为各种大语言模型和生成式AI模型提供服务。

根据速度基准测试,在Cloud TPU v5e上训练和运行人工智能模型的速度提高了5倍。

同时,推理指标的规模有了巨大提升:在一秒钟内,能实时处理1000秒的内部语音到文本和情感预测模型,比之前提升了6倍。

谷歌在GKE中全面推出了云TPU,这是当今业内最具可扩展性的领先Kubernetes服务。

用户可以利用GKE在云TPU v5e和云TPU v4上管理大规模AI工作负载编排,从而提高 AI 开发效率。

对于喜欢托管服务简单性的企业,Vertex AI也支持使用云TPU VM使用各种框架和库进行训练。

Cloud TPU v5e还为领先的AI框架(如 JAX、PyTorch 和 TensorFlow)提供内置支持。也包括流行的开源工具,如Hugging Face的Transformers and Accelerate、PyTorch Lightning和Ray等。

同时,谷歌宣布将在预览版中引入Multislice技术,该技术允许用户轻松地将 AI 模型扩展到物理 TPU Pod 边界之外——多达数万个Cloud TPU v5e或TPU v4芯片。

通过Cloud TPU v5e,用户能够更轻松地扩展自己的训练作业。

全球首个水印工具上线,Llama2、Claude2接入Vertex AI

Vertex AI是谷歌Cloud在2021年5月发布的机器学习(ML)平台。

它可以训练和部署机器学习模型和AI应用,并自定义大语言模型(LLM),从而在AI驱动的应用中。

Vertex AI结合了数据工程、数据科学和机器学习等工作流,能够让团队使用通用工具集进行协作,并通过Google Cloud的优势扩缩应用。

并提供AutoML、自定义训练、模型发现、生成式AI等选项,通过端到端MLOps工具实现自动化部署和扩展。支持多种界面,包括SDK、控制台、命令行和Terraform。

对于希望快速开始常见生成式人工智能(AI)用途(例如聊天机器人和定制搜索引擎)的开发人员,Vertex AI搜索和对话可以帮助没有任何AI经验的人快速上手开发,甚至在许多情况下,都无需编写任何代码。

全家桶式更新发布

半年前,谷歌宣布在Vertex AI提供生成式AI服务支持后,Vertex AI的用户数量比上季度增长了15倍以上。

面对如此强劲的用户需求,谷歌也在默默发力。在8月30日的Google Cloud Next大会上,谷歌发布了一系列扩展功能:

扩展模型生态系统。

在拥有超过100个大模型的Vertex AI“模型花园”中新增了来自Meta的Llama 2和Code Llama以及技术创新研究所(TII)的Falcon LLM。还有即将加入的Anthropic的Claude 2。Model Garden的多样性使企业能够将模型与其需求相匹配,为用户提供更多的选择。

调整升级谷歌自己的模型:PaLM 2、Codey和Imagen。

PaLM可支持38种语言、3.2万个token上下文窗口,Codey的代码生成质量提到了25%;Imagen改进了视觉吸引力,最近还添加了图像编辑、字幕以及视觉问题和答案等功能。

发布了全球首个水印识别工具SynthID,验证Imagen生成的图像。

利用扩展功能连接真实世界的数据并驱动真实世界的行动。VertexAI扩展是一组完全托管的扩展开发人员工具,可将模型到API以实现实时数据和实际操作。

全球首个水印识别工具:

此次在Google Cloud Next上,最引人注目的产品是能为AI生成的图像打上水印并进行检测和识别的SynthID。

在生成式AI爆发的浪潮中,识别AI生成的内容成为我们现在亟需解决的难关。

一方面,在大模型的训练中使用AI生成的内容会导致模型崩溃。另一方面,AI生成的假信息也大大扰乱了互联网中的信息生态。

之前的研究中,有人提出了为AI生成的内容添加水印,但在后续的实践中发现添加水印会干扰模型的内容生成。

SynthID的发布,预示解决识别AI生成内容的这一难题将会被解决。

SynthID的首次亮相是在开发者平台Vertex AI中。

Vertex AI与Google DeepMind合作,推出了SynthID。它能够为Imagen生成的图像加上数字水印,并且识别AI生成的图像。

SynthID可以帮助评估图像由Imagen创建的可能性

SynthID使用两个深度学习模型,分别用于水印和识别。

它们可以在一组不同的图像上一起训练。组合模型针对一系列目标进行了优化,包括正确识别带水印的内容,并通过直观地将水印与原始内容对齐来提高水印的隐蔽性。

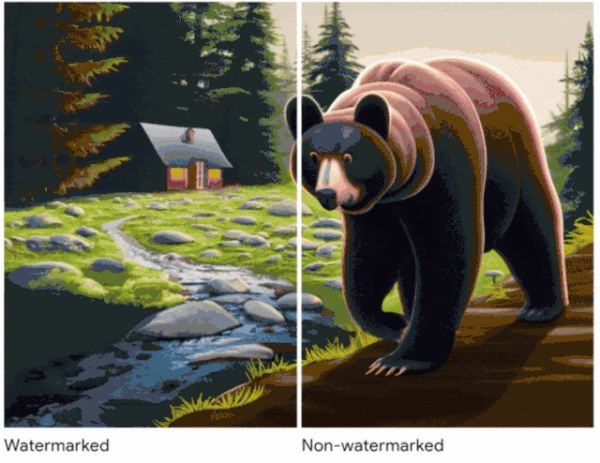

SynthID生成的数字水印是直接嵌入到图像的像素中的,人眼无法察觉。但SynthID可以检测并识别它们。

SynthID生成的水印即使在添加滤镜、更改颜色和使用各种有损压缩方案(最常用于JPEG)进行保存等修改后,也能够被识别出来,并且不会影响图像质量。

即使在添加滤镜、更改颜色和亮度等修改后,水印也可以检测到

元数据是最广泛使用的内容识别方法之一。它提供了创建者和创建时间等信息,这些信息与图像文件一起存储。

添加到元数据中的数字签名可以显示图像是否被更改过。当元数据信息完好无损时,用户可以很容易地识别图像。

然而,元数据可能会被手动删除,甚至在文件编辑时丢失。

但是,SynthID生成的水印嵌入了图像的像素,因此它与其他基于元数据的图像识别方法兼容,即使元数据丢失也能被检测到。

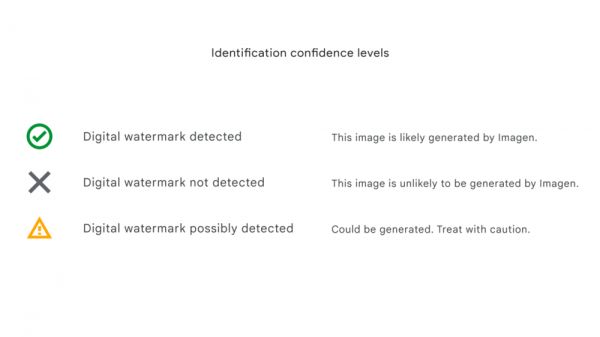

SynthID还提供了三个置信度,用于解释水印识别结果。

如果检测到数字水印,说明部分图像可能是由Imagen生成的。

腹泻式更新能让谷歌重回行业领航吗

谷歌在Google Cloud Next大会上的更新林林总总一大堆。

但就像OpenAI发布ChatGPT后,谷歌的产品发布总是慢了一步,像这次的AI芯片发布也被IBM抢了风头。

但谷歌依旧拥有无可比拟的优势:开发者平台Vertex AI。

谷歌有意将Vertex AI打造成一个巨大的AI开发生态圈,软件硬件全都做到现有的顶配,并提供开发AI的一站式服务。

如果说英伟达是AI淘金热里那个因为卖铲子而暴富的精明商人,那么谷歌这次是决心把自己打造成生成式AI的大平台。

一波一波的淘金者们来来往往,商人也可能因为时运不济而倒下,但平台会与AI行业的命运紧紧相连。

或许,这才是谷歌默默耕耘的最终目标。

参考资料:https://cloud.google.com/blog/products/ai-machine-learning/vertex-ai-next-2023-announcements

本文来自微信公众号:新智元 (ID:AI_era),编辑:Lumina

相关推荐

谷歌“AI周边”大放送:想做大模型时代的大平台?

微软、谷歌、亚马逊,正在打响大模型时代的云战争

焦虑的中国大客户,正“逼着”AI企业做大模型

AI大模型“太贵”,VC投钱望而生畏

对话李彦宏:真正AI时代,新的应用需要基于大模型的“新地基”

阿里进入大模型时代,核心是算力和生态

从谷歌看大模型如何深刻改变互联网广告?

AI大模型没有商业模式?

AI大模型之战,大厂为何都在“重复造轮子”?

朱啸虎VS傅盛,怼出了做大模型的两个共识

网址: 谷歌“AI周边”大放送:想做大模型时代的大平台? http://www.xishuta.com/newsview88814.html

推荐科技快讯

- 1问界商标转让释放信号:赛力斯 95228

- 2人类唯一的出路:变成人工智能 21183

- 3报告:抖音海外版下载量突破1 21148

- 4移动办公如何高效?谷歌研究了 20339

- 5人类唯一的出路: 变成人工智 20338

- 62023年起,银行存取款迎来 10336

- 7五一来了,大数据杀熟又想来, 8596

- 8网传比亚迪一员工泄露华为机密 8505

- 9滴滴出行被投诉价格操纵,网约 8215

- 10顶风作案?金山WPS被指套娃 7230