《英国医学杂志》:医疗AI能力被夸大,或对患者安全构成风险

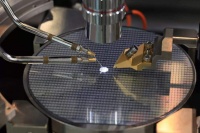

图片来源@视觉中国

文丨学术头条

社会的数字化意味着我们正在以前所未有的速度积累着数据,医疗方面也不例外。据IBM 估计,每个人一生中大约会积累 100 万兆字节的数据,全球医疗保健数据的总量每隔几年就会翻一番。

为了处理这些大数据,越来越多的临床医生与计算机科学家和其他相关学科合作,利用人工智能 (AI) 技术来帮助检测有噪音的信号。最近的一项预测显示,医疗人工智能市场的价值从 2018 年的 20 亿美元将增长到 2025 年的 36 亿美元,复合的年增长率将达到 50%。

AI 是一个创新和快速发展的领域,具有改善患者护理和减轻医疗服务沉重负担的潜力。深度学习是人工智能的一个分支,在医学成像领域表现出了特别的前景。随着越来越多的研究成果的发表,各界对医学成像等领域的深度学习研究兴趣日益浓厚。

AI超越医生了吗?

近一两年,我们常看到一些媒体新闻出现诸如“研究发现,谷歌人工智能比医生早一年发现肺癌” 以及 “人工智能比医生更擅长诊断皮肤癌” 这样的标题。

媒体的宣传极大增加了公众和商业对 AI+ 医疗的兴趣,也催化技术加快实施。但实际上,这些标题背后的研究方法和偏倚风险尚未得到详细的检验。

但《英国医学杂志》(BMJ) 的研究人员最近警告说,“许多研究和媒体声称人工智能在解释医学图像方面达到与人类专家一样的水平,甚至比专家还好,但实际上 AI 的质量很差,而且被夸大了,这对患者的安全构成了风险。”

为了进一步研究这个问题,伦敦帝国理工学院的研究人员回顾了过去 10 年发表的研究结果,系统地检查研究设计、报告标准、偏倚风险,并将深度学习算法在医学成像方面的表现与临床专家进行比较。

他们的数据来源于 Medline、Embase、Cochrane 中央对照试验注册簿和世界卫生组织 2010 年至 2019 年 6 月的试验注册簿,包括了 7334 份研究记录和 968 个试验注册。他们通过采用随机试验登记和非随机研究方法,以公认的报告标准为衡量,对深度学习算法在医学影像像中的表现与多个临床专家进行比较。

所谓的随机试验是对研究对象进行随机化分组,设置对照组,以及应用盲法,让研究者和受试者双方均无法知晓分组结果。而 CONSORT(临床试验报告统一标准)是随机对照试验的报告标准,包括了各组受试者例数、接受已分配治疗的例数等,有助于帮助医务人员了解试验背景、目的、干预措施、随机方法和统计分析。而非随机试验则是将研究对象的分组按照研究者或患者意愿进行分组,在本试验中采用 TRIPOD 作为报告标准。

在随机临床试验中,研究人员发现了仅有 10 项有关深度学习的记录,其中有 2 项已经发表,分别是眼科和放射科,其余 8 项正在或即将招募临床患者进行试验。

AI的表现被“夸大”

在第一项试验中,招募了 350 名在中国眼科诊所的儿科患者,这些患者分别在有无 AI 平台的情况下接受白内障评估诊断,得到治疗建议。研究人员发现 AI 诊断的准确率为 87%,而专家医生的准确率达到 99%,这些结果明显低于专家医生的诊断准确性,但是 AI 平台进行诊断的平均时间却比专家的诊断速度快。

第二项完成的试验招募了进行肠镜检查的患者,发现 AI 系统可以显著检测息肉,有较低的误差风险,高度遵守报告标准。

而在 81 个非随机临床试验中,他们发现只有 9 项研究具有前瞻性,其中只有 6 人在真实世界(real-world)的临床环境中进行了测试。在 81 项研究中的 77 项的摘要包含了有关 AI 与临床医生表现之间的比较,有 30% 的研究表示 AI 优于临床医生。为了对研究的结果进行独立审查,他们还对原始数据和代码进行访问时,却受到严重限制,仅有 1 项研究提供了原始标签数据和代码。

通过利用偏倚风险工具对研究进行评估,研究人员还发现有超过三分之二的研究被判定有较高的偏倚风险,遵守公认的报告标准的情况较差。有四分之三的研究声称人工智能的表现可与临床医生相提并论,甚至更优于临床医生,而只有 38% 的研究表明需要进一步的前瞻性研究或试验。

总而言之,在医学成像领域,很少有前瞻性的深度学习研究和随机试验。大多数非随机化试验不具有前瞻性,存在较高的偏倚风险,并偏离现有的报告标准。大多数研究缺乏数据和代码可用性,而且人类比较器组通常很小。

不过研究人员也指出此次评估研究中的一些局限性,比如遗漏研究的可能性,以及对深度学习医学成像研究的关注,因此研究结果可能不适用于其他类型的人工智能。

尽管如此,他们说道,“目前存在着许多关于与临床医生等价或优于临床医生的夸大说法,这在社会层面上对患者安全和人口健康构成了潜在风险。” 他们也警告道,“过分的承诺,会使研究容易被媒体和公众曲解,结果可能不符合患者的最佳利益,也无法最大限度地保障患者的安全,而最好的办法是确保我们有高质量和透明报告的证据基础。”

参考资料:

[1] https://www.eurekalert.org/emb_releases/2020-03/b-co032320.php

[2] https://www.bmj.com/content/368/bmj.m689

相关推荐

《英国医学杂志》:医疗AI能力被夸大,或对患者安全构成风险

AI比医生厉害?BMJ发文担忧AI的表现被 “夸大”

人类如果找不到新冠肺炎药物,那 AI 可以吗?

让患者完全信任AI,到底难在哪儿?

技术与伦理的博弈,医疗AI的B面隐忧如何解?

被唱衰的沃森和巨头云集下的 AI 医疗

借一份医生调查看医疗聊天机器人正途何在?

用AI大数据辅助风险管控,「洞悉网络」意在布局药械全周期安全服务平台

AI 对癌症治疗有什么帮助?

市场需求规模将突破2500亿,互联网医院服务体系的构成要素有哪些?

网址: 《英国医学杂志》:医疗AI能力被夸大,或对患者安全构成风险 http://www.xishuta.com/zhidaoview8046.html

推荐专业知识

- 136氪首发 | 瞄准企业“流 3926

- 2失联37天的私募大佬现身,但 3217

- 3是时候看到全球新商业版图了! 2808

- 436氪首发 | 「微脉」获1 2759

- 5流浪地球是大刘在电力系统上班 2706

- 6招商知识:商业市场前期调研及 2690

- 7Grab真开始做财富管理了 2609

- 8中国离硬科幻电影时代还有多远 2328

- 9创投周报 Vol.24 | 2183

- 10微医集团近日完成新一轮股权质 2180